tanh专题

深度学习-激活函数:饱和激活函数【Sigmoid、tanh】、非饱和激活函数【ReLU、Leaky ReLU、RReLU、PReLU、ELU、Maxout】

深度学习-激活函数:饱和激活函数【Sigmoid、tanh】、非饱和激活函数【ReLU、Leaky ReLU、RReLU、PReLU、ELU、Maxout】 一、激活函数的定义:二、激活函数的用途1、无激活函数的神经网络2、带激活函数的神经网络 三、饱和激活函数与非饱和激活函数1、饱和激活函数2、非饱和激活函数 四、激活函数的种类1、Sigmoid函数2、TanH函数3、ReLU(Recti

Caffe Prototxt 激活层系列:TanH Layer

TanH Layer 是DL中非线性激活的一种,在深层CNN中,中间层用得比较少,容易造成梯度消失(当然不是绝对不用);在GAN或一些网络的输出层常用到 首先我们先看一下 TanHParameter message TanHParameter {enum Engine {DEFAULT = 0;CAFFE = 1;CUDNN = 2;}optional Engine engine = 1 [d

个人笔记--python用tanh画圆形,正方形,长方形(epsilon界面宽度)

用tanh函数画图 圆形 import numpy as npimport matplotlib.pyplot as plt# 创建一个二维网格xx = np.linspace(-1, 1, 1000)yy = np.linspace(-1, 1, 1000)x_i, y_i = np.meshgrid(xx, yy)# 圆的半径和中心r = 0.4center_x, cent

ReLU Sigmoid and Tanh(2)

Sigmoid 它能够把输入的连续实值“压缩”到0和1之间。如果是非常大的负数,那么输出就是0;如果是非常大的正数,输出就是1. 缺点: 当输入非常大或者非常小的时候,这些神经元的梯度是接近于0的,从图中可以看出梯度的趋势。所以,需要尤其注意参数的初始值来尽量避免saturation的情况。如果你的初始值很大的话,大部分神经元可能都会处在saturation的状态而把gradientkill

ReLU Sigmoid and Tanh

ReLU 激活函数: ReLu使得网络可以自行引入稀疏性,在没做预训练情况下,以ReLu为激活的网络性能优于其它激活函数。 数学表达式: y=max(0,x) Sigmoid 激活函数: sigmoid 激活函数在神经网络学习方面,可以将重点特征推向中央区,将非重点特征推向两侧区。 数学表达式(正切函数): y=(1+exp(−x))−1 导数:f(z)' = f(z)(1

[机器学习] softmax,sigmoid,relu,tanh激活函数

参考: https://blog.csdn.net/weixin_43483381/article/details/105232610 参考 :https://blog.csdn.net/zhuiyuanzhongjia/article/details/80576779 参考: https://www.sohu.com/a/452666201_809317 softmax 与 sigmoid 结

【机器学习300问】65、为什么Sigmoid和Tanh激活函数会导致梯度消失?

一、梯度消失现象 当神经网络的输入值较大或较小时,其导数(梯度)都会接近于0。在反向传播过程中,这些微小的梯度经过多层网络逐层传递时,会不断被乘以权重矩阵(权重通常小于1),进一步导致梯度值缩小,直至几乎消失。这种现象称为“梯度消失”,它会使深度神经网络的学习过程变得极其缓慢,甚至无法有效训练深层网络。 二、Sigmoid激活函数 Sigmoid函数的公式为。

sigmoid、 tanh、 tanh、 tanh比较

由上篇文章,我们知道逻辑回归是怎么过渡到神经网络的了 总的来说就一句话——多个逻辑回归模型,前后堆积形成了神经网络! 我引用吴恩达中的一张图,稍微的回顾以下这个过程 对于这张图,它的过程是这样的: 输入1个样本(含3个特征),分别到4个逻辑回归中(中间那一列的4个圈圈)对于样本的输入,逻辑回归模型分别通过y = wx + b后将y值通过Sigmoid函数映射到01区间内,那么这里就有4个输

python绘制激活函数(sigmoid, Tanh, ReLU, Softmax)

import numpy as npimport matplotlib.pyplot as plt# matplotlib的负数显示设置 plt.rcParams['axes.unicode_minus'] = False # 显示负数# 输出高清图像%config InlineBackend.figure_format = 'retina'%matplotlib inline#

【DL经典回顾】激活函数大汇总(十一)(Tanh Shrink Threshold附代码和详细公式)

激活函数大汇总(十一)(Tanh Shrink & Threshold附代码和详细公式) 更多激活函数见激活函数大汇总列表 一、引言 欢迎来到我们深入探索神经网络核心组成部分——激活函数的系列博客。在人工智能的世界里,激活函数扮演着不可或缺的角色,它们决定着神经元的输出,并且影响着网络的学习能力与表现力。鉴于激活函数的重要性和多样性,我们将通过几篇文章的形式,本篇详细介绍两种激活函数,旨在帮

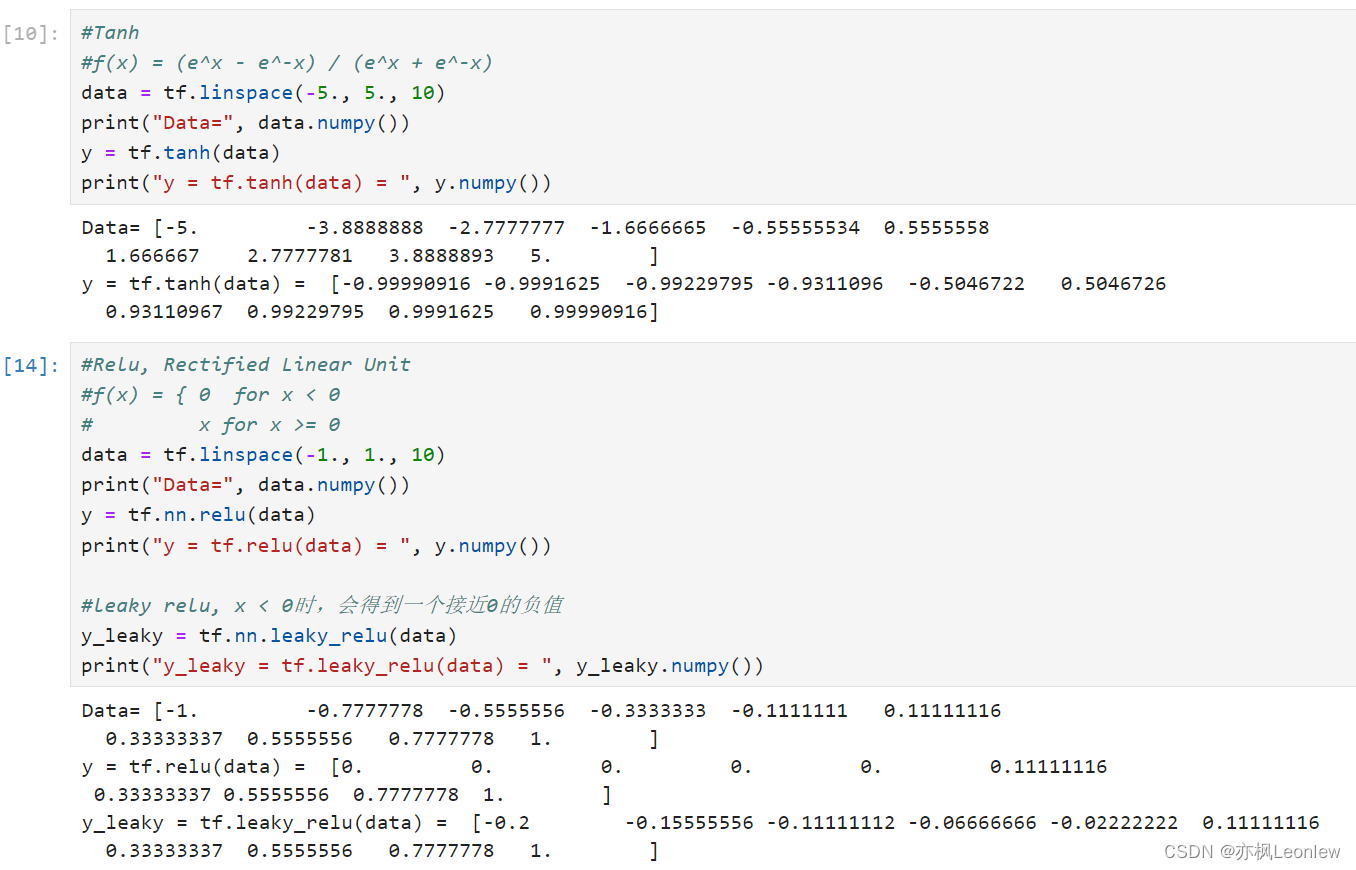

Tensorflow2.0笔记 - 常见激活函数sigmoid,tanh和relu

本笔记主要记录常见的三个激活函数sigmoid,tanh和relu,关于激活函数详细的描述,可以参考这里: 详解激活函数(Sigmoid/Tanh/ReLU/Leaky ReLu等) - 知乎 import tensorflow as tfimport numpy as nptf.__version__#详细的激活函数参考资料#https://zhuanla

神经网络之激活函数(sigmoid、tanh、ReLU)

神经网络之激活函数(Activation Function) 补充:不同激活函数(activation function)的神经网络的表达能力是否一致? 激活函数理论分析对比 转载:http://blog.csdn.net/cyh_24 :http://blog.csdn.net/cyh_24/article/details/50593400 日常 coding 中,我们会很自然

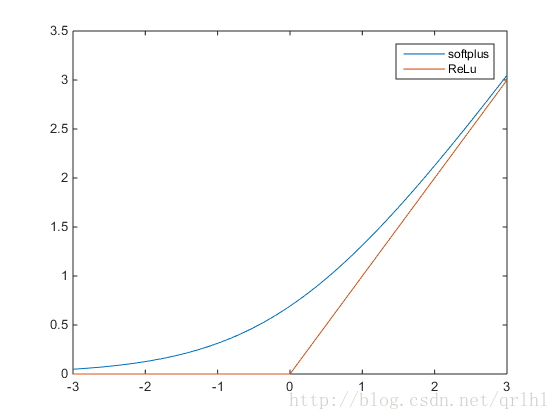

激活函数-Sigmoid,Tanh,ReLu,softplus,softmax

PS:在学习深度学习的搭建时,用到不同的激活函数,因此查阅了这些函数,转自:http://blog.csdn.net/qrlhl/article/details/60883604#t2,对其中我认为有误的地方进行了一点修正。 不管是传统的神经网络模型还是时下热门的深度学习,我们都可以在其中看到激活函数的影子。所谓激活函数,就是在神经网络的神经元上 运行的函数,负责将神经元的输入映射到输出

Tensorflow基础(四)--激活函数(Sigmoid、tanh);损失函数(二次代价函数、交叉熵代价函数、对数释然代价函数)

目录 1.激活函数1.1双曲正切函数与Sigmoid函数 2.损失函数(代价函数)2.1 L1范数损失函数2.2 L2范数损失函数2.3 二次代价函数2.4 交叉熵代价函数2.5 对数释然代价函数(log-likelihood cost) 3.演示代码 1.激活函数 激活函数的想法来自对人脑中神经元工作机理的分析。神经元在某个阈值(也称活化电位)之上会被激活。大多数情况下,激活函

激活函数介绍Sigmoid,tanh,Relu,softmax。

什么是激活函数? 在神经元中,输入的 inputs 通过加权,求和后,还被作用了一个函数,这个函数就是激活函数 Activation Function。 2.为什么引入非线性激励函数? 若不使用激励函数,每一层的输出都是上层输入的线性函数,无论神经网络有多少层,输出都是输入的线性组合,与没有隐藏层效果相当,这种情况就是最原始的感知机(perceptron)。 非线性函数作为激励函数,这样深层

2023-简单点-机器学习中常用的特殊函数,激活函数[sigmoid tanh ]

机器学习中的特殊函数 Sigmoidsoftplus函数tanhReLu(x)Leaky-ReluELUSiLu/ SwishMish伽玛函数beta函数Ref Sigmoid 值域: 【0,1】 定义域:【负无穷,正无穷】 特殊点记忆: 经过 [0 , 0.5] 关键点[0,0.5]处的导数是 0.025 相关导数: softplus函数 值域: (0,无穷

机器学习——sigmoid、tanh、relu等激活函数总结

一、什么是激活函数? 一个神经元会同时接收多个信号,然后将这些信号乘以一定权重求和,再用函数处理后再输出新的信号。对神经元的输入进行处理,以获得输出的函数称为激活函数。 二、为什么要用激活函数? 激活函数对模型学习、理解非常复杂和非线性的函数具有重要作用。激活函数可以引入非线性因素。如果不使用激活函数,则输出信号仅是一个简单的线性函数。线性函数一个一级多项式,线性方程的复杂度有限,从数据中学

强化学习小笔记 —— 从 Normal 正态分布的对数概率密度到 tanh-Normal的对数概率密度

在学习 SAC 算法用于连续动作的代码时,遇到了一个不懂的地方,如下代码所示: # pytorchclass PolicyNetContinuous(torch.nn.Module):def __init__(self, state_dim, hidden_dim, action_dim, action_bound):super(PolicyNetContinuous, self).__ini

深度学习中常用的激活函数有sigmoid、tanh、ReLU、LeakyReLU、PReLU、GELU等。

深度学习中常用的激活函数 1. Sigmoid函数2. Tanh函数3. ReLU函数4. LeakyReLU函数5. PReLU函数6. ELU函数:7. GELU函数: 深度学习中常用的激活函数有sigmoid、tanh、ReLU、LeakyReLU、PReLU等。 1. Sigmoid函数 Sigmoid函数公式为 f ( x ) = 1 1 + e − x f(x)=

Tanh-sinh quadrature(The Double Exponential Formulas)

Tanh-sinh quadrature(The Double Exponential Formulas for Numerical Integration) 见维基百科 https://en.m.wikipedia.org/wiki/Tanh-sinh_quadrature 见Tanh-sinh quadrature numerical integration metho

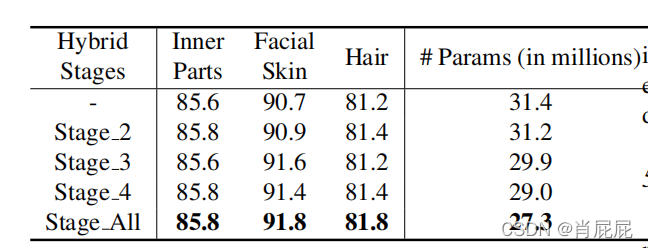

RoI Tanh-polar Transformer Network for Face Parsing in the Wild野外人脸解析的RoI(感兴趣区域) Tanh-polar Transf

RoI Tanh-polar Transformer Network for Face Parsing in the Wild 野外人脸解析的RoI(感兴趣区域) Tanh-polar Transformer网络 摘要 人脸解析人脸解析的目的是预测图像中目标人脸的面部成分的像素级标签,现有的方法通常根据预处理(人脸检测模型:MTCNN (TensorFlow)SSD Face (Caff

![[机器学习] softmax,sigmoid,relu,tanh激活函数](https://img-blog.csdnimg.cn/img_convert/25145fe35a0055a899553c9c5dad10e8.png)

![2023-简单点-机器学习中常用的特殊函数,激活函数[sigmoid tanh ]](https://img-blog.csdnimg.cn/cf2756c94616431bb6c1e7aef3ae82f1.png)