本文主要是介绍[机器学习] softmax,sigmoid,relu,tanh激活函数,希望对大家解决编程问题提供一定的参考价值,需要的开发者们随着小编来一起学习吧!

参考: https://blog.csdn.net/weixin_43483381/article/details/105232610

参考 :https://blog.csdn.net/zhuiyuanzhongjia/article/details/80576779

参考: https://www.sohu.com/a/452666201_809317

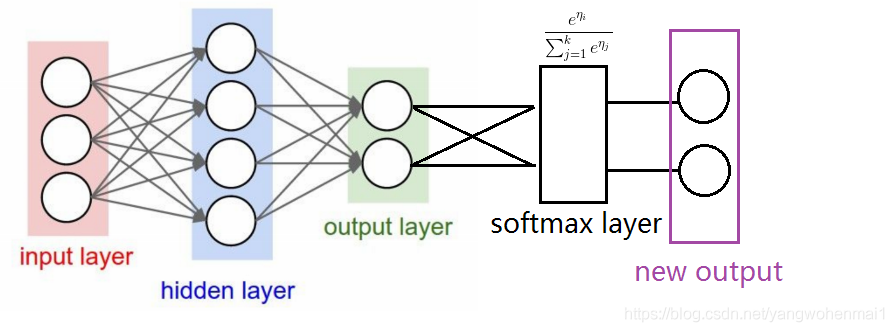

softmax 与 sigmoid 结构上的区别:

可以看出最大的区别在于softmax的计算的是一个比重,而sigmoid只是对每一个输出值进行非线性化。

这篇关于[机器学习] softmax,sigmoid,relu,tanh激活函数的文章就介绍到这儿,希望我们推荐的文章对编程师们有所帮助!