recurrent专题

NLP-文本匹配-2016:SiamseNet【Learning text similarity with siamese recurrent networks】

NLP-文本匹配-2016:SiamseNet【Learning text similarity with siamese recurrent networks】

构建RNN(Recurrent Neural Network)

目前RNN网络可以在深度学习框架下通过调用函数实现(比如:tf.nn.rnn_cell),但为了掌握更多RNN的细节,我们还是需要使用numpy来逐步实现。 由于RNN网络具有“记忆力”,因此非常适合NLP和序列任务。RNN网络每次读取一个输入X(t),输入信息从当前时间步传到下一步的过程中,网络隐含层的激活函数会“记住”一些信息或上下文内容。这种机制允许单向RNN从前面的输入中获取信息以处理后

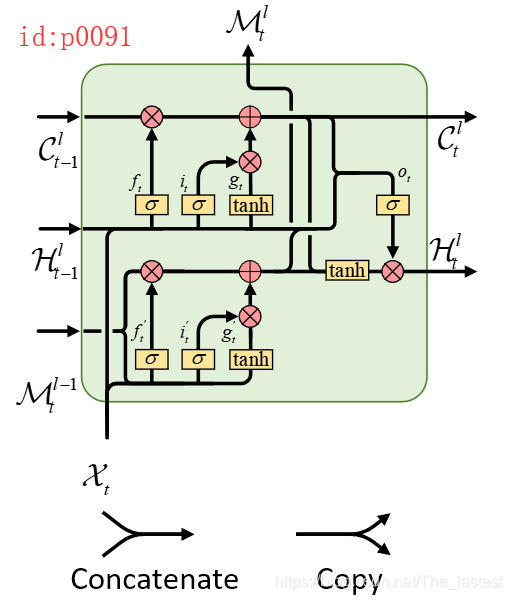

PredRNN: Recurrent Neural Networks for Predictive Learning using Spatiotemporal LSTMs

这是一篇2017年发表在顶级期刊NIPS上的文章,作者通过发现传统RNN/LSTM网络的不足,提出了一种新的网络结构PredRNN,并且为这一网络结构设计了一种新的RNN单元(ST-LSTM)。由于博主能力有限,通过阅读原文短时间能只是领悟到PredRNN这一网络结构的思想,而并未对ST-LSTM的设计灵感有更深的体会。 下面这篇博文主要是来介绍一下什么是PredRNN,以及通过作者的设

2020-ASRM: A Semantic and Attention Spatio-temporal Recurrent Model for Next Location Prediction

[1] Zhang X, Li B, Song C, et al. SASRM: A Semantic and Attention Spatio-temporal Recurrent Model for Next Location Prediction[C]//2020 International Joint Conference on Neural Networks (IJCNN). IEEE

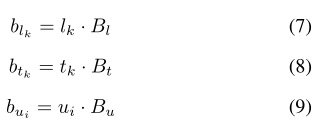

RNN(Recurrent Neural Networks)循环神经网络

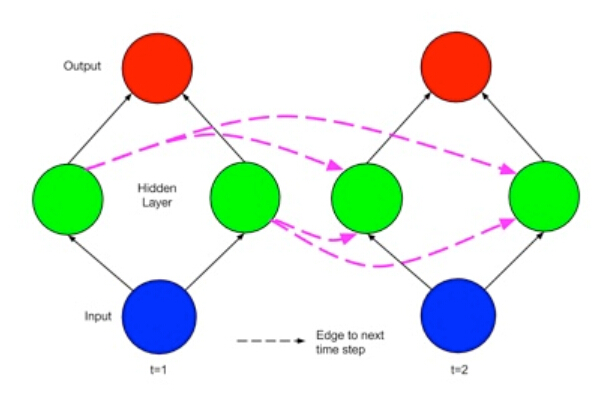

循环神经网络(Recurrent Neural Network,简称RNN)是一种处理序列数据的神经网络结构,它具有记忆能力,能够捕捉序列中的时序信息。RNN在自然语言处理、时间序列预测等方面有着很多的应用。 一、RNN 的基本结构 RNN的包括输入层、隐藏层和输出层。其中,隐藏层的状态会随时间步更新,并作为下一时间步的输入之一。这种循环连接使得RNN具有记忆能力,能够捕捉序列中的长距离依赖关

【深度学习笔记】6_2 循环神经网络RNN(recurrent neural network)

注:本文为《动手学深度学习》开源内容,部分标注了个人理解,仅为个人学习记录,无抄袭搬运意图 6.2 循环神经网络 上一节介绍的 n n n元语法中,时间步 t t t的词 w t w_t wt基于前面所有词的条件概率只考虑了最近时间步的 n − 1 n-1 n−1个词。如果要考虑比 t − ( n − 1 ) t-(n-1) t−(n−1)更早时间步的词对 w t w_t wt的可能

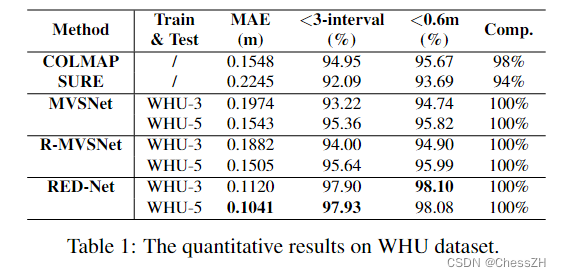

【论文阅读笔记】A Novel Recurrent Encoder-Decoder Structure for Large-Scale Multi-view Stereo Reconstruction

A Novel Recurrent Encoder-Decoder Structure for Large-Scale Multi-view Stereo Reconstruction from An Open Aerial Dataset 目录 主要贡献摘要RED-Net细节二维特征提取cost map递归编解码器正则化loss计算 实验结果 主要贡献 摘要 近年来的大量

[论文翻译]A Novel Recurrent Encoder-Decoder Structure for Large-Scale Mulit-view Stereo Reconstruction

A Novel Recurrent Encoder-Decoder Structure for Large-Scale Multi-view Stereo Reconstruction from An Open Aerial Dataset 摘要1.Introduction2.相关工作2.1数据集2.2网络 3.WHU 数据集3.1 数据源3.2合成航空数据集3.3用于深度学习的子数据集 4

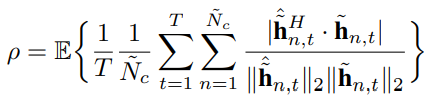

Mino Channel Infomation Feedback Using Deep Recurrent Network简记

Mino Channel Infomation Feedback Using Deep Recurrent Network简记 原文18年的文章,引入了LSTM作为压缩和解压模块 具体的结构如下所示,可以发现,压缩解压模块分为两部分,上侧是线性模块FCN,下侧是LSTM,引入LSTM的主要考量是考虑CSI中的延时信息,在这里CNN就显得不那么合适。为了减少计算量,在文章后面有提出将FCN设计出串

Spatio-Temporal Representation With Deep Neural Recurrent Network in MIMO CSI Feedback简记

Spatio-Temporal Representation With Deep Neural Recurrent Network in MIMO CSI Feedback简记 文章目录 Spatio-Temporal Representation With Deep Neural Recurrent Network in MIMO CSI Feedback简记参考简记LSTM结构深度可分

Recurrent Feature Reasoning for Image Inpainting-image inpainting 实践

Image inpainting 论文总结: https://github.com/geekyutao/Image-Inpainting Recurrent Feature Reasoning for Image Inpainting github: https://github.com/jingyuanli001/RFR-Inpainting 环境:Ubuntu16.04, python

论文阅读笔记(1)——Recurrent Convolutional Neural Networks for Text Classification(用于文本分类的循环卷积神经网络)

摘要(Abstract)介绍(Introduction)相关工作(Related Work)文本分类(Text Classification)深度神经网络(Deep neural networks) 模型(Model)词表示学习(Word Representation Learning)文本表示学习(Text Representation Learning) 训练(Training)训练

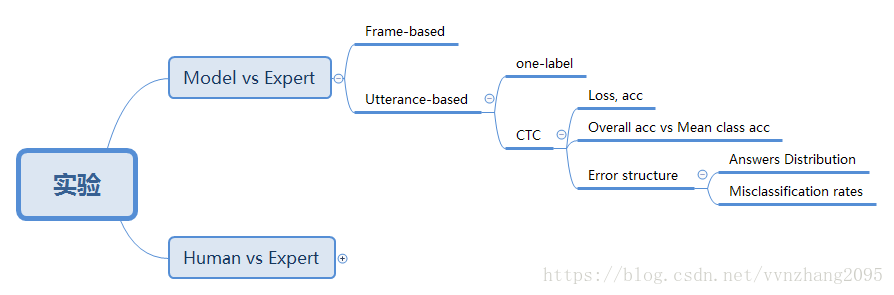

文章:Emotion Recognition From Speech With Recurrent Neural Networks

https://blog.csdn.net/vvnzhang2095/article/details/79993058 代码部分:https://github.com/vladimir-chernykh/emotion_recognition 1. 背景与简介 1.1. 现状 计算机只能识别“说了什么”,无法识别“谁说的”、“怎样说”。 1.2. 目标 关注“怎样说”,

视频超分:BRCN(Video Super-Resolution via Bidirectional Recurrent Convolutional Networks)

论文:应用双向循环卷积网络的视频超分辨率方法 代码:https://github.com/linan142857/BRCN 文章检索出处:IEEE TPAMI 2017 看点 考虑到RNN可以很好地模拟视频序列的长期时间依赖性,本文提出了一种双向循环卷积网络(BRCN)。主要贡献如下: 1)提出了一种适用于多帧SR的双向循环卷积网络,其中时间依赖性可以通过循环卷积和三维前馈卷积有效地建模

[机器学习入门] 李宏毅机器学习笔记-34 (Recurrent Neural Network part 3;循环神经网络 part 3)

[机器学习入门] 李宏毅机器学习笔记-34 (Recurrent Neural Network part 3;循环神经网络 part 3) PDFVIDEO 上接part 2 RNN Beyond Sequence 那么这种sequence to sequence 的方法还可以用于Syntactic parsing 句法分析上,得到树桩结构。 而它表达的方

[机器学习入门] 李宏毅机器学习笔记-33 (Recurrent Neural Network part 2;循环神经网络 part 2)

[机器学习入门] 李宏毅机器学习笔记-33 (Recurrent Neural Network part 2;循环神经网络 part 2) PDFVIDEO RNN Learning Target cost就是每一个时间点的output与reference的cross entropy的合,就是minimize的对象。 有了这个lost后,training要怎么做呢?

循环神经网络(Recurrent Neural Network)原理推导

RNN(Recurrent Neural Network)是一类用于处理序列数据的神经网络。首先我们要明确什么是序列数据,摘取百度百科词条:时间序列数据是指在不同时间点上收集到的数据,这类数据反映了某一事物、现象等随时间的变化状态或程度。这是时间序列数据的定义,当然这里也可以不是时间,比如文字序列,但总归序列数据有一个特点——后面的数据跟前面的数据有关系。 RNN的结构及变

ACL 2020 MART: Memory-Augmented Recurrent Transformer for Coherent Video Paragraph Captioning

动机 本文目标是生成一个段落(多个句子),条件是输入具有几个预定义的事件片段的视频。为视频生成多句子描述是最具挑战性的任务之一,因为它不仅要求视频的视觉相关性,而且要求段落中句子之间基于语篇的连贯性。最近,Transformer已被证明比RNN更有效,在许多顺序建模任务中展示了卓越的性能。之前将transformer模型引入视频段落captioning任务的方法,Transformer操作在分离

Theano-Deep Learning Tutorials 笔记:Recurrent Neural Networks with Word Embeddings

教程地址:http://deeplearning.net/tutorial/rnnslu.html 相关论文:Grégoire Mesnil, Xiaodong He, Li Deng and Yoshua Bengio - Investigation of Recurrent Neural Network Architectures and Learning Methods for Spoke

【阅读笔记】《ReNet: A Recurrent Neural Network Based Alternative to Convolutional Networks》

本文记录了博主阅读论文《ReNet: A Recurrent Neural Network Based Alternative to Convolutional Networks》的笔记,代码,更新于2019.05.23。 后续论文笔记:【阅读笔记】《ReSeg: A Recurrent Neural Network-based Model for Semantic Segmentation》

TricorNet: A Hybrid Temporal Convolutional and Recurrent Network for Video Action Segmentation 翻译

本博文是对论文的翻译,如有不准确,请在评论中指出 TricorNet: A Hybrid Temporal Convolutional and Recurrent Network for Video Action Segmentation 一种用于视频动作分割的时间卷积和递归混合网络 关键词:hybrid temporal convolutional and recurrent net

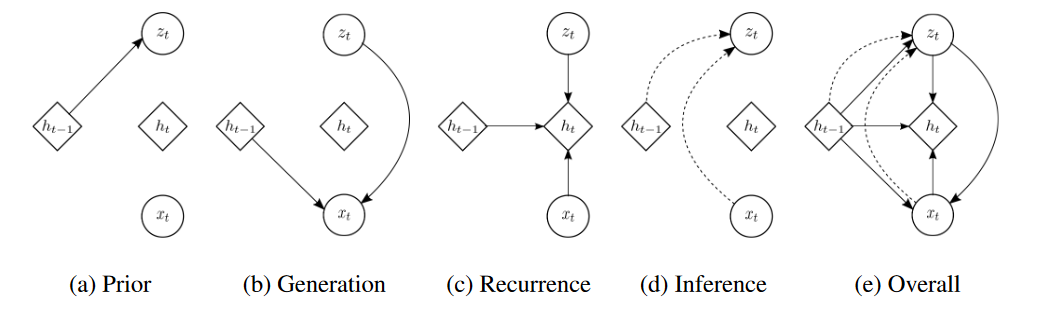

论文《A recurrent latent variable model for sequential data》笔记:详解VRNN

A recurrent latent variable model for sequential data 背景 1 通过循环神经网络的序列建模 循环神经网络(RNN)可以接收一个可变长度的序列 x = ( x 1 , x 2 , . . . , x T ) x = (x_1, x_2, ..., x_T) x=(x1,x2,...,xT)作为输入,并通过递归地处理每个符号同时维持其内

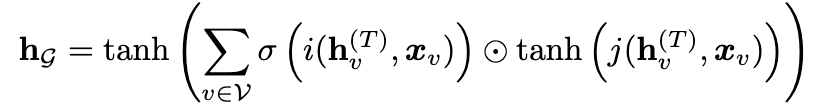

【Graph Neural Network 图神经网络】1.Recurrent Graph Neural Network 循环图神经网络

图神经网络概述 神经网络的成功推动了模式识别和数据挖掘的研究,产生了若干种端到端的深度学习方法:卷积神经网络CNN、循环神经网络RNN、自动编码器。其中卷积神经网络CNN能够利用图像数据的平移不变、局部连通和可组合,提取与整个数据集共享的局部有意义的特征,以进行各种图像分析任务。 但是在应用场景中依然有大量的数据以图Graph的形式表示,例如电子商务中的用户与产品的交互、化学中的分子结构、引文网

论文阅读《RAFT-Stereo: Multilevel Recurrent Field Transforms for Stereo Matching》

论文地址:https://arxiv.org/abs/2109.07547 源码地址:https://github.com/princeton-vl/RAFT-Stereo 概述 本文提出了一种适用于双目立体匹配的模型架构,基于光流估计网络RAFT,通过使用多级卷积GRU模块来在图像传播全局信息,并取得了不错的实验结果; 模型架构 对于给定的输入图像对 I L 、 I

DeepAR:Probabilistic forecasting with autoregressive recurrent network

DeepAR:Probabilistic forecasting with autoregressive recurrent network 一般的时间序列预测方法是做点预测,即预测未来某个时间点的具体值。但对于一些具体业务比如预测销量来说预测一个概率区间更加易于决策。DeepAR是一个做概率预测的方法,同时也可以做点预测。 首先简单介绍一下时间序列和常见的处理方法 一、方法介绍 Deep

![[论文翻译]A Novel Recurrent Encoder-Decoder Structure for Large-Scale Mulit-view Stereo Reconstruction](https://img-blog.csdnimg.cn/20210323103814825.png?x-oss-process=image/watermark,type_ZmFuZ3poZW5naGVpdGk,shadow_10,text_aHR0cHM6Ly9ibG9nLmNzZG4ubmV0L3dlaXhpbl80NDE4OTYxMA==,size_16,color_FFFFFF,t_70#pic_center)

![[机器学习入门] 李宏毅机器学习笔记-34 (Recurrent Neural Network part 3;循环神经网络 part 3)](https://img-blog.csdn.net/20170730191812098?watermark/2/text/aHR0cDovL2Jsb2cuY3Nkbi5uZXQvc291bG1lZXRsaWFuZw==/font/5a6L5L2T/fontsize/400/fill/I0JBQkFCMA==/dissolve/70/gravity/SouthEast)

![[机器学习入门] 李宏毅机器学习笔记-33 (Recurrent Neural Network part 2;循环神经网络 part 2)](https://img-blog.csdn.net/20170730134021925?watermark/2/text/aHR0cDovL2Jsb2cuY3Nkbi5uZXQvc291bG1lZXRsaWFuZw==/font/5a6L5L2T/fontsize/400/fill/I0JBQkFCMA==/dissolve/70/gravity/SouthEast)