prompting专题

VCTP(Visual Chain-of-Thought Prompting for Knowledge-Based Visual Reasoning)论文

目录 摘要介绍相关工作方法总体模型细节 实验 摘要 知识型视觉推理仍然是一个艰巨的任务,因为它不仅要求机器从视觉场景中解释概念和关系,而且还需要将它们与外部世界知识联系起来,对开放世界问题进行推理链。然而,以前的工作将视觉感知和基于语言的推理视为两个独立的模块,在推理的所有阶段都没有同时关注这两个模块。为此,我们提出了一种知识型推理的视觉思维链提示(VCTP),它涉及视觉内容与自

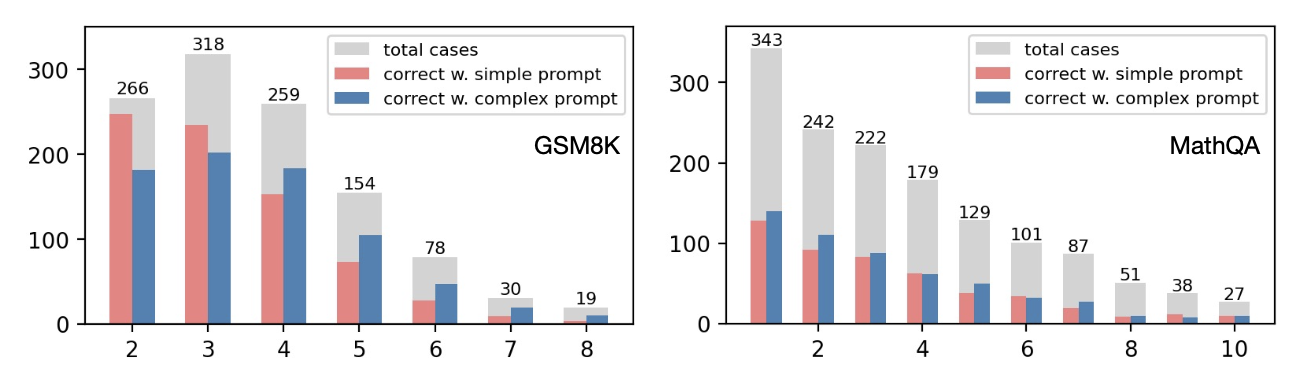

越复杂的CoT越有效吗?Complexity-Based Prompting for Multi-step Reasoning

Complexity-Based Prompting for Multi-step Reasoning 论文:https://openreview.net/pdf?id=yf1icZHC-l9 Github:https://github.com/FranxYao/chain-of-thought-hub 发表位置:ICLR 2023 Complexity-Based Prompting for

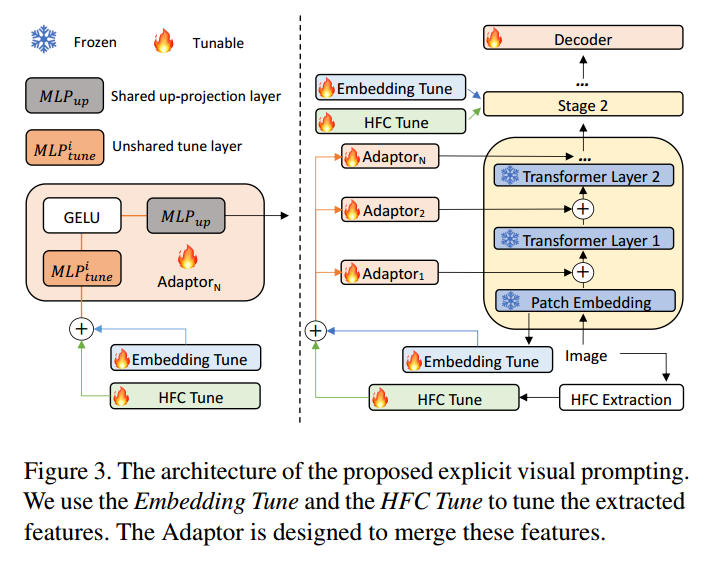

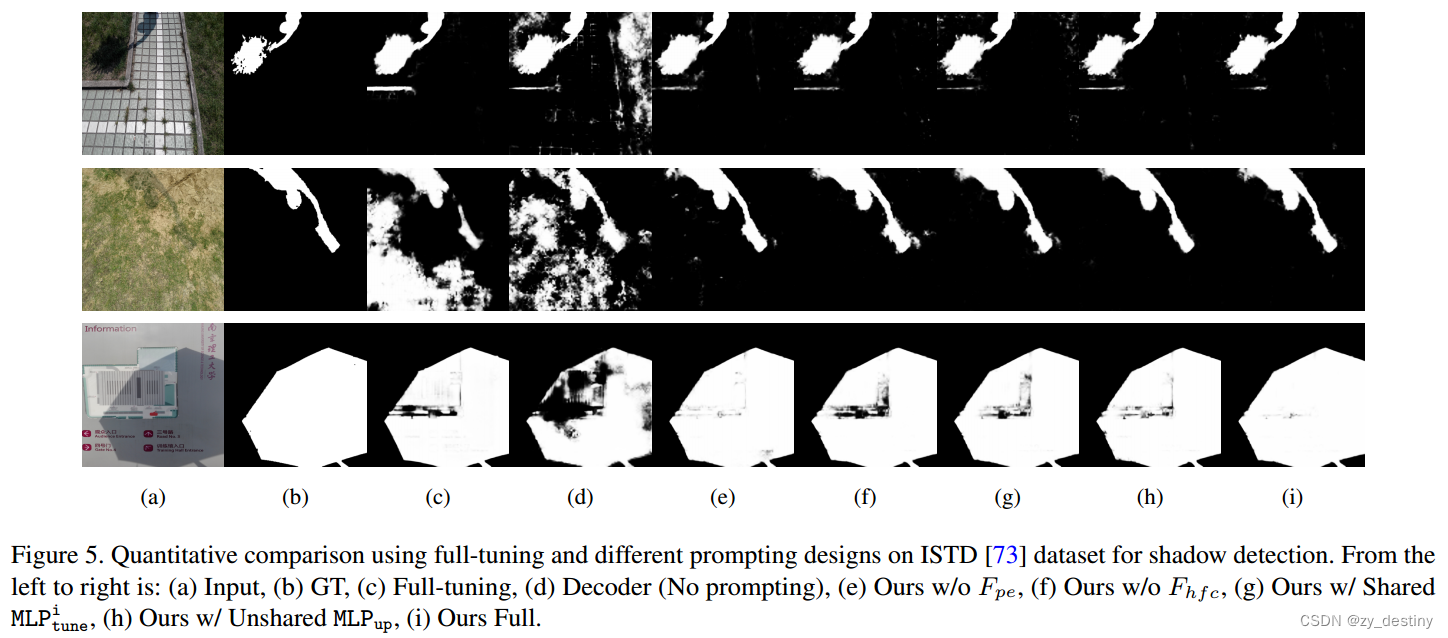

论文笔记 Explicit Visual Prompting for Low-Level Structure Segmentations

通俗地解释视觉中的prompt 在视觉中的“prompt”(提示)可以用一种比较通俗的方式来理解: 什么是视觉中的提示? 想象一下,你有一个已经接受过大量训练的超级助手(类似于预训练的模型),这个助手已经学习了大量关于图像的知识,但现在你需要让它快速适应并执行一些特定的任务,比如识别模糊区域、找到阴影、检测伪造的图像部分或者发现伪装的物体。 提示的作用 提示就像是给这个超级助手提供的一些

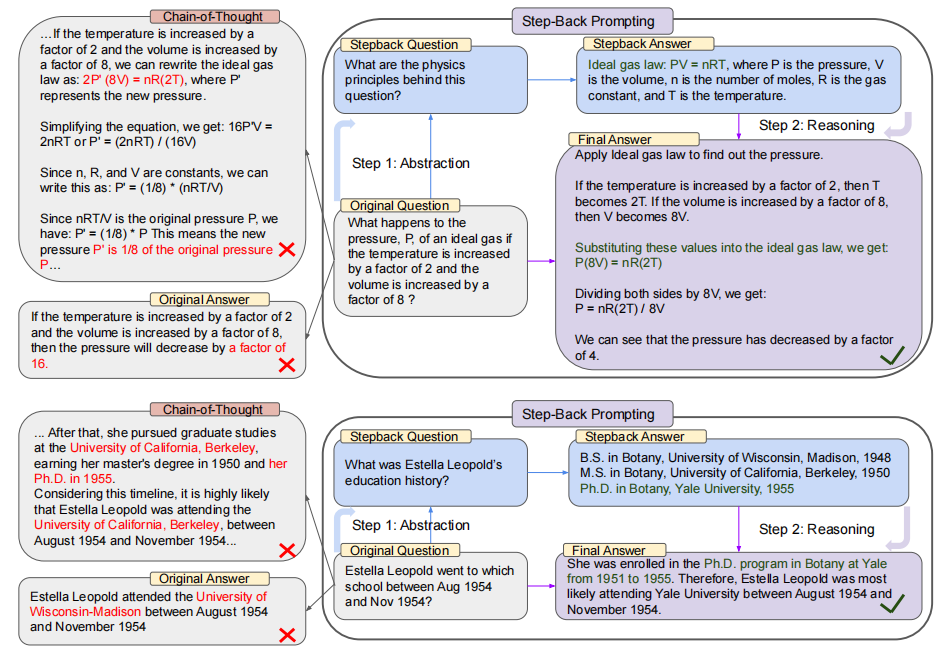

【LLM 论文】Step-Back Prompting:先解决更高层次的问题来提高 LLM 推理能力

论文:Take a Step Back: Evoking Reasoning via Abstraction in Large Language Models ⭐⭐⭐⭐ Google DeepMind, ICLR 2024, arXiv:2310.06117 论文速读 该论文受到的启发是:人类再解决一个包含很多细节的具体问题时,先站在更高的层次上解决一些更加抽象的问题,可以拓展一个更宽阔

transformer上手(12)—— Prompting 情感分析

运用 Transformers 库来完成情感分析任务,并且使用当前流行的 Prompting 方法。Prompting 方法的核心思想就是借助模板将问题转换为与预训练任务类似的形式来处理。 例如要判断标题“American Duo Wins Opening Beach Volleyball Match”的新闻类别,就可以应用模板“This is a [MASK] News: x” 将其转换为 “

【提示学习论文】PMF:Efficient Multimodal Fusion via Interactive Prompting论文原理

Efficient Multimodal Fusion via Interactive Prompting(CVPR2023) 基于交互式提示的高效多模态融合方法减少针对下游任务微调模型的计算成本提出模块化多模态融合架构,促进不同模态之间的相互交互将普通提示分为三种类型,仅在单模态transformer深层添加提示向量,显著减少训练内存的使用 1 Introduction 提示微调方法采用顺

Finetuning vs. Prompting:大语言模型两种使用方式

目录 前言1. 对于大型语言模型的两种不同期待2. Finetune(专才)3. Prompt(通才)3.1 In-context Learning3.2 Instruction-tuning3.3 Chain of Thought(COT) Prompting3.4 用机器来找Prompt 总结参考 前言 这里和大家分享下关于大语言模型的两种使用方式,一种是 Finetun

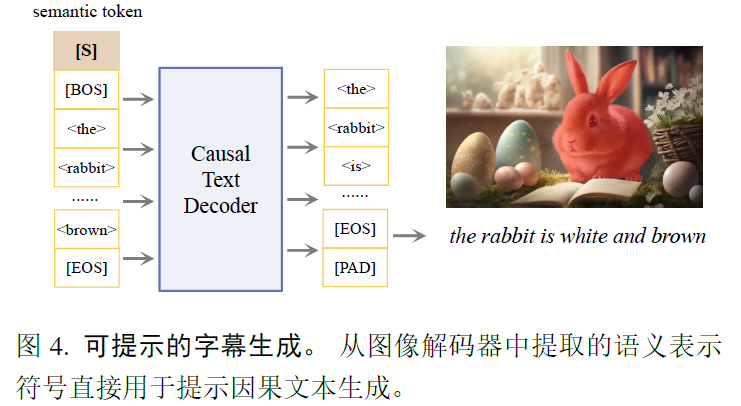

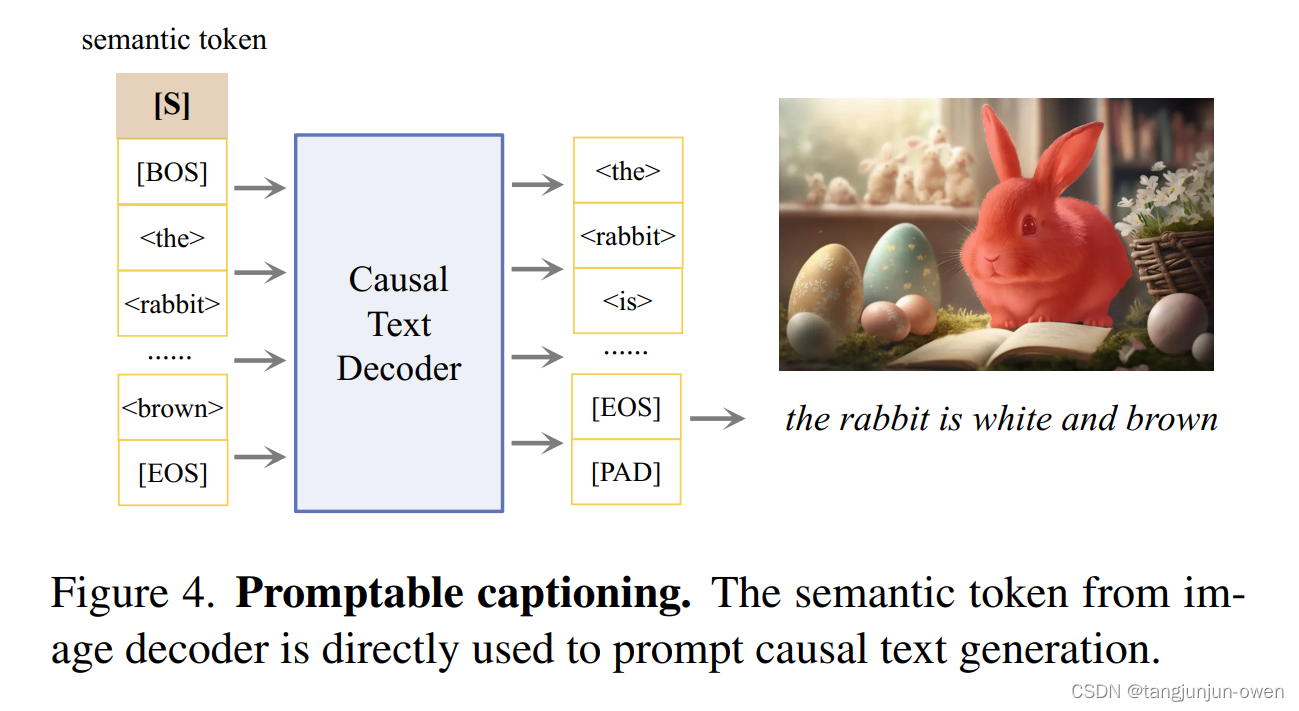

Tokenize Anything via Prompting

SAM的延续,把SAM输出的token序列用来进行分类,分割和一个自然语言的decoder处理,但其实现在多模态的图像的tokenizer也几乎都是用VIT来实现的。一开始认为这篇文章可能是关于tokenize的,tokenize还是很重要的,后来看完,整体思路大概就是一般来做带类别的sam,目前是grounding dino+sam的思路,先用一个开放词汇检测的目标检测算法通过text将区域框出

Automatic Update prompting to download KB890859 again and again?

原文:http://windowsxp.mvps.org/890859.htm 当你通过Web方式的Windows Updates或者Windows自动更新安装完KB890859补丁后,系统依然不断提示此更新未安装,不断弹出安装对话框,可能的原因是一个或者多个主要的Windows文件未能成功地被此Hotfix更新或者覆盖导致,需要校验此更新是否成功,打开%WINDIR%/system32目

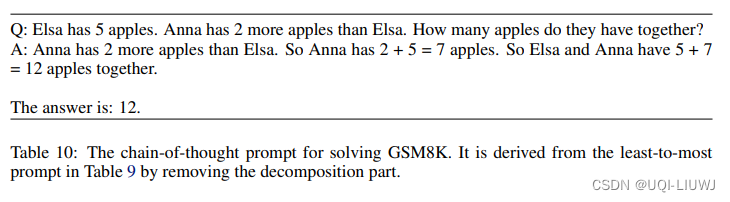

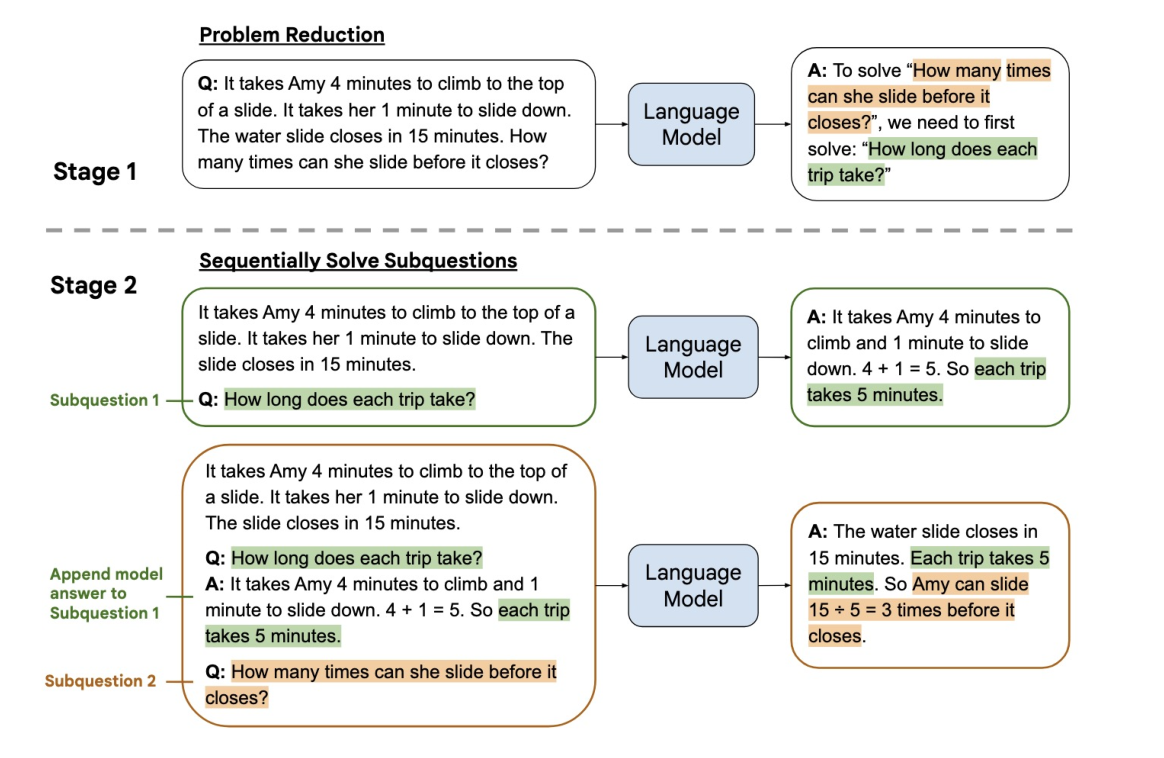

大模型笔记:最少到最多提示过程 (Least to Most prompting, LtM)

LEAST-TO-MOST PROMPTING ENABLES COMPLEX REASONING IN LARGE LANGUAGE MODELS 2023 ICLR 1 概述 进一步发展维链提示过程 (CoT prompting) 分为两个阶段: 第一阶段:向语言模型提出查询,将问题分解成子问题。第二阶段:再次向语言模型提出查询,逐个解决这些子问题。 解决第二个子问题的答案建立在第一个子

Tokenize Anything via Prompting论文解读

文章目录 前言一、摘要二、引言三、模型结构图解读四、相关研究1、Vision Foundation Models2、Open-Vocabulary Segmentation3、Zero-shot Region Understanding 五、模型方法解读1、Promptable TokenizationPre-processingPromptable segmentationConcept

大模型提示学习、Prompting微调知识

为什么需要提示学习? 提示学习是一种在自然语言处理任务中引入人类编写的提示或示例来辅助模型生成更准确和有意义的输出的技术。以下是一些使用提示学习的原因: 解决模糊性:在某些任务中,输入可能存在歧义或模糊性,通过提供明确的提示,可以帮助模型更好地理解任务的要求,避免产生错误或不确定的输出。 控制生成:在生成式任务中,使用提示可以指导模型生成特定类型的输出。例如,在生成新闻标题的任务中,通过提

【EVP】Explicit Visual Prompting for Low-Level Structure Segmentations

目录 🍇🍇0.简介 🌷🌷1.研究动机 🍋🍋2.主要贡献 🍓🍓3.网络结构 🍭3.1整体结构 🍭3.2高频分量计算 🍭3.3显示视觉提示EVP 🍂🍂4.实验 🏆4.1四种任务结果对比 🏆4.2不同可训练参数量结果对比 🏆4.3四种任务可视化结果 🏆4.4消融实验 🏆4.5参数选择对比结果 🏆4.6在四个不同任务上与其他微调方法对比

OpenAI、斯坦福大学提出Meta-Prompting,有效提升语言模型的性能

为了研究如何提高语言模型的性能,使其更充分有效地输出对于提问的回答,来自斯坦福和 OpenAI 的学者强强联手,通过提出一种名为元提示(meta-prompting)的方法来深入探索。元提示通过让单个语言模型(如 GPT-4)充当中央控制器和多种专家角色,以实现对各种任务的准确和可靠回复。该方法结合了多个独立专家模型的优势和多样性,以便更好地解决复杂的任务和问题。 元提示的显著特点之一是其将复杂

如何提升大模型的推理和规划能力:思维链 CoT + 由少至多提示 Least-to-Most Prompting

如何提升大模型的推理和规划能力 思维链 - CoT思维链改进:Auto-CoT、小冰链(X-CoTA) 由少至多提示 - Least-to-Most Prompting 思维链 - CoT 最初的语言模型都是基于经验的,只能根据词汇之间的相关性输出答案,根本没有思考能力…… 但是从使用思维链后,大模型已经是有思考能力的。能进行一定的推理。 2021年,OpenAI在训练神经

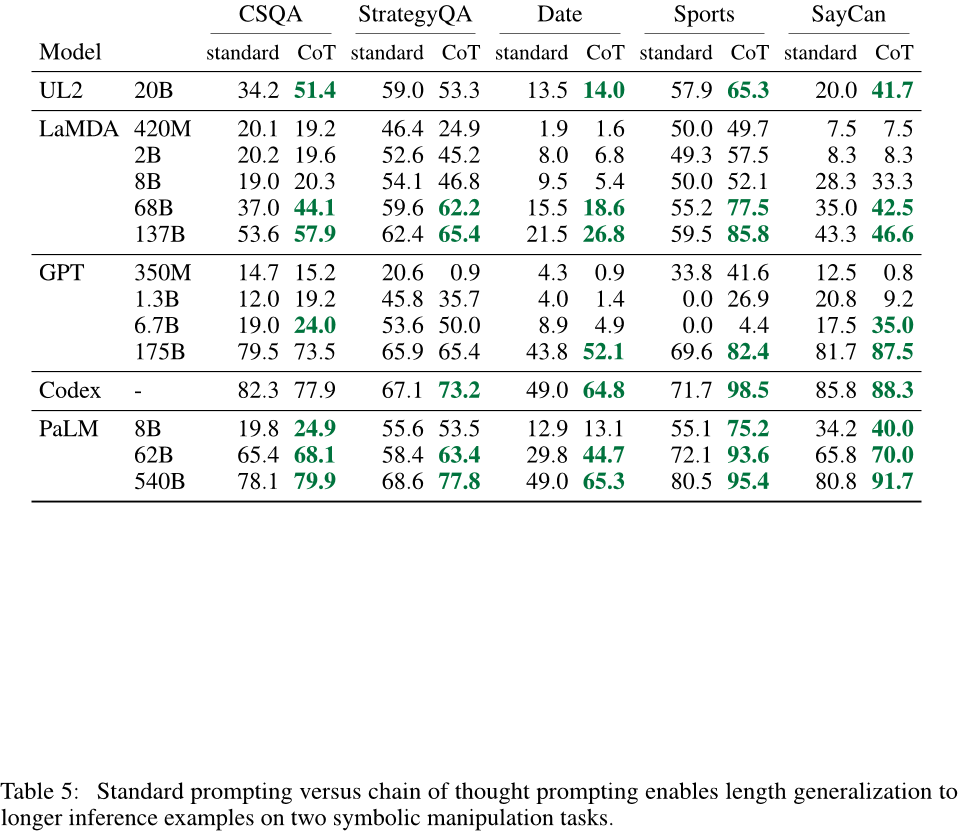

Chain-of-Thought Prompting Elicits Reasoning in Large Language Models导读

通过生成一系列中间推理步骤(即“思维链”)显著提高大型语言模型进行复杂推理的能力 这篇论文探讨了如何通过生成一系列中间推理步骤(即“思维链”)显著提高大型语言模型进行复杂推理的能力。研究人员使用一种简单的方法——思维链提示法——提供一些思维链示例作为提示,发现这种方法可以使足够大的语言模型自然地获得这种推理能力。实验结果表明,在三个大型语言模型上进行测试时,思维链提示法可以显著提高在算术、常识和

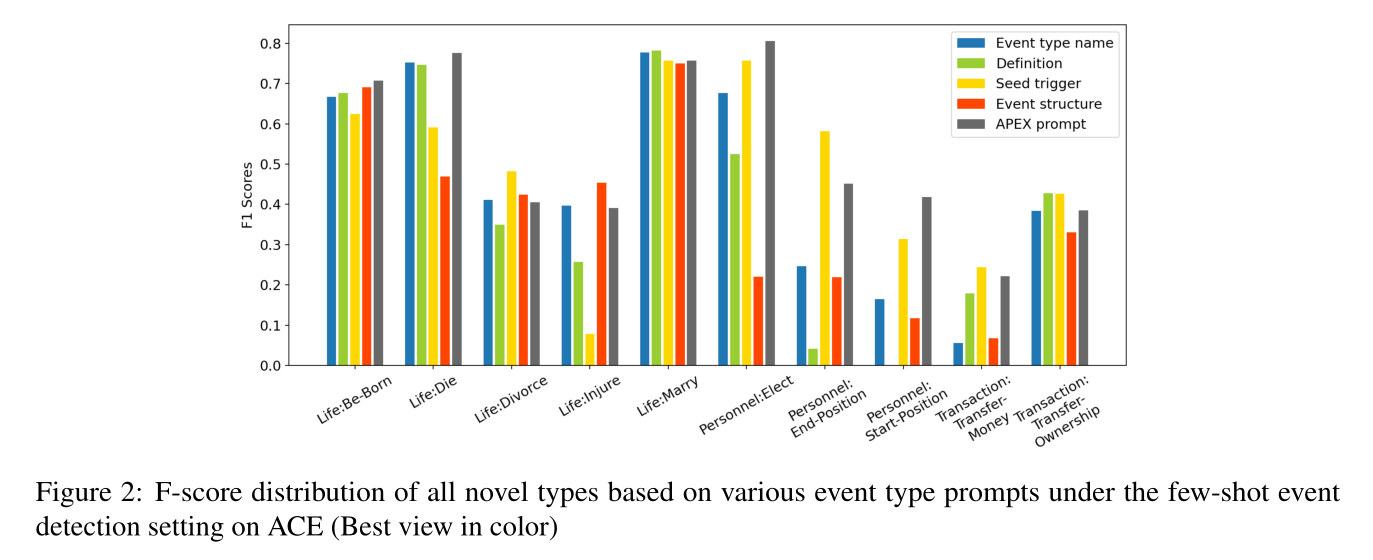

【ACL 2023】 The Art of Prompting Event Detection based on Type Specific Prompts

【ACL 2023】 The Art of Prompting: Event Detection based on Type Specific Prompts 论文:https://aclanthology.org/2023.acl-short.111/ 代码:https://github.com/VT-NLP/Event_APEX Abstract 我们比较了各种形式的提示来表示事件

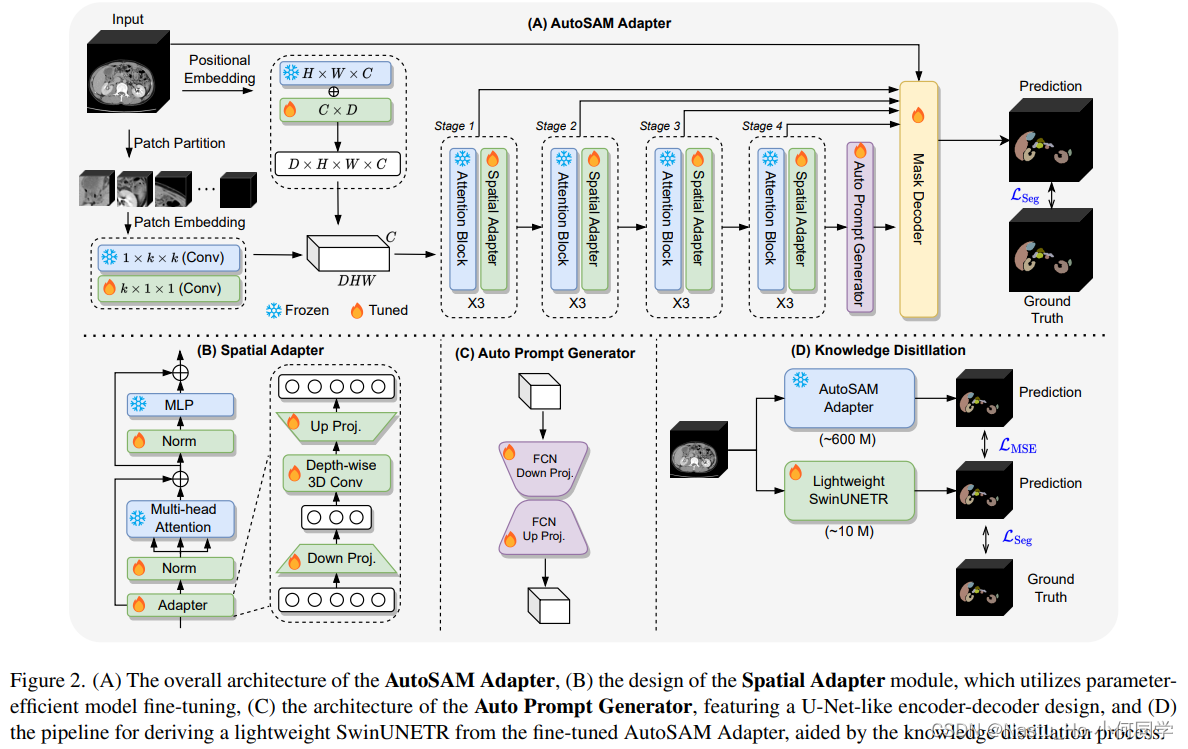

【SAM系列】Auto-Prompting SAM for Mobile Friendly 3D Medical Image Segmentation

论文链接:https://arxiv.org/pdf/2308.14936.pdf 核心: finetune SAM,为了不依赖外部prompt,通过将深层的特征经过一个编-解码器来得到prompt embedding;finetune完之后做蒸馏

ICLR 2024 高分论文 | Step-Back Prompting 使大语言模型通过抽象进行推理

文章目录 一、前言二、主要内容三、总结 🍉 CSDN 叶庭云:https://yetingyun.blog.csdn.net/ 一、前言 ICLR 2024 高分论文:《Step-Back Prompting Enables Reasoning Via Abstraction in Large Language Models》 论文地址:https://openre

【提示工程】Chain-of-Thought Prompting Elicits Reasoning in Large Language Models

解决问题 探索大语言模型解决推理问题的能力。从头训练或微调模型,需要创建大量的高质量含中间步骤的数据集,成本过大。 相关工作 1、使用中间步骤来解决推理问题 (1)使用自然语言通过一系列中间步骤解决数学应用题 (2)通过创建更大的数据集微调语言模型,而不是从头训练 (3)使用语言模型一行一行的预测中间结果预测最终输出 2、采用提示方式 (1)少样本提示 (2)自动学习提示 (3)描述任务的

【提示工程】Chain-of-Thought Prompting Elicits Reasoning in Large Language Models

解决问题 探索大语言模型解决推理问题的能力。从头训练或微调模型,需要创建大量的高质量含中间步骤的数据集,成本过大。 相关工作 1、使用中间步骤来解决推理问题 (1)使用自然语言通过一系列中间步骤解决数学应用题 (2)通过创建更大的数据集微调语言模型,而不是从头训练 (3)使用语言模型一行一行的预测中间结果预测最终输出 2、采用提示方式 (1)少样本提示 (2)自动学习提示 (3)描述任务的

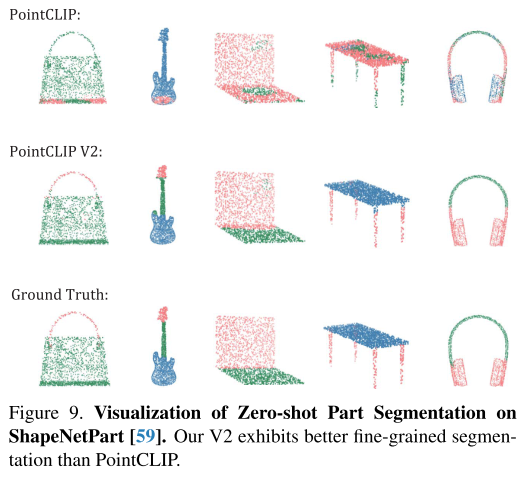

论文阅读:PointCLIP V2: Prompting CLIP and GPT for Powerful3D Open-world Learning

https://arxiv.org/abs/2211.11682 0 Abstract 大规模的预训练模型在视觉和语言任务的开放世界中都表现出了良好的表现。然而,它们在三维点云上的传输能力仍然有限,仅局限于分类任务。在本文中,我们首先协作CLIP和GPT成为一个统一的3D开放世界学习器,命名为PointCLIP V2,它充分释放了它们在零弹3D分类、分割和检测方面的潜力。为了更好地将3D数据与

论文阅读:PointCLIP V2: Prompting CLIP and GPT for Powerful3D Open-world Learning

https://arxiv.org/abs/2211.11682 0 Abstract 大规模的预训练模型在视觉和语言任务的开放世界中都表现出了良好的表现。然而,它们在三维点云上的传输能力仍然有限,仅局限于分类任务。在本文中,我们首先协作CLIP和GPT成为一个统一的3D开放世界学习器,命名为PointCLIP V2,它充分释放了它们在零弹3D分类、分割和检测方面的潜力。为了更好地将3D数据与

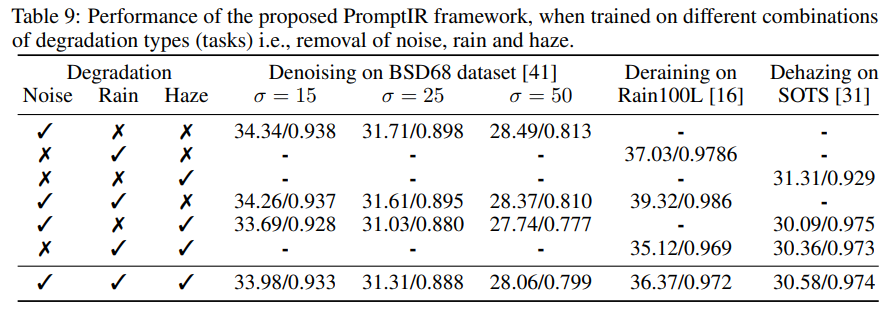

【NeurIPS 2023】PromptIR: Prompting for All-in-One Blind Image Restoration

PromptIR: Prompting for All-in-One Blind Image Restoration, NeurIPS 2023 论文:https://arxiv.org/abs/2306.13090 代码:https://github.com/va1shn9v/promptir 解读:即插即用系列 | PromptIR:MBZUAI提出一种基于Prompt的全能图像恢复网络

Reasoning with Language Model Prompting: A Survey

本文是LLM系列的文章,针对《Reasoning with Language Model Prompting: A Survey》的翻译。 语言模型提示推理:综述 摘要1 引言2 前言3 方法分类4 比较和讨论5 基准与资源6 未来方向7 结论与视角 摘要 推理作为解决复杂问题的基本能力,可以为各种现实应用提供后端支持,如医疗诊断、协商等。本文对语言模型提示推理的前沿研究进行了综

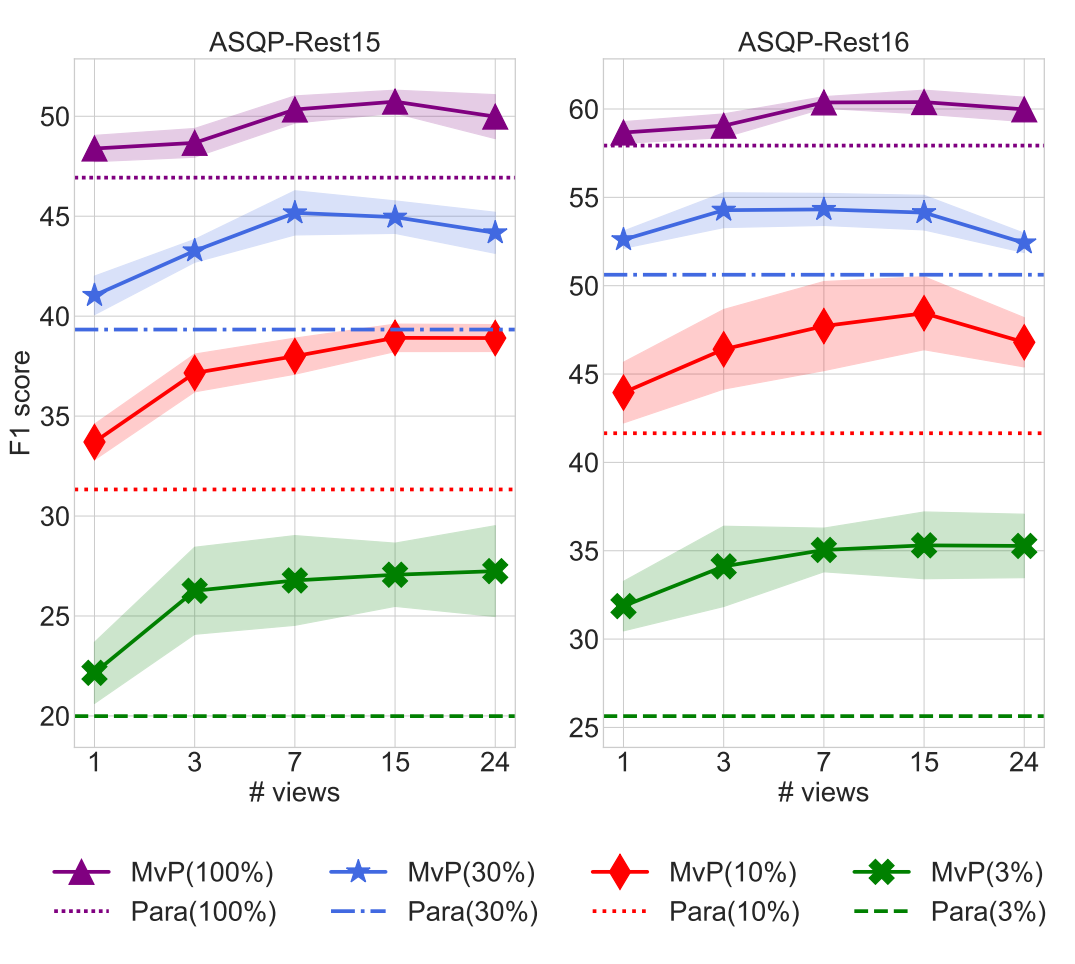

MVP: Multi-view Prompting Improves Aspect Sentiment Tuple Prediction

MVP: Multi-view Prompting Improves Aspect Sentiment Tuple Prediction 论文地址: https://arxiv.org/pdf/2305.12627.pdf 论文代码: https://github.com/ZubinGou/multi-view-prompting 个人阅读笔记, 如有错误欢迎指正交流 1. 介绍 Mul