mmdetection专题

mmdetection中的stages相关配置

⭐️ backbone.num_stages Number of stages of the backbone. 在深度学习中,“Number of stages of the backbone” 指的是模型主干网络(backbone)中分层的不同阶段或模块的数量。这通常与 卷积神经网络(CNN) 相关联,用于图像分类、目标检测、语义分割等任务。 具体解释 在深度学习模型中,backbon

手把手教你如何使用MMDetection训练自己的数据集

文章目录 一、配置环境1. 创建一个名为mmdetection的虚拟环境2. 安装GPU版本的PyTorch3. 安装mmdetection所需的包 二、下载源码并安装配置文件1. 下载 GitHub 上的mmdetection源码到本地2. 安装源码中的配置文件3. 配置成功 三、测试是否成功安装1. 下载配置文件和模型权重文件。2. 推理验证 四、数据集准备1. 准备好coco格式的数据

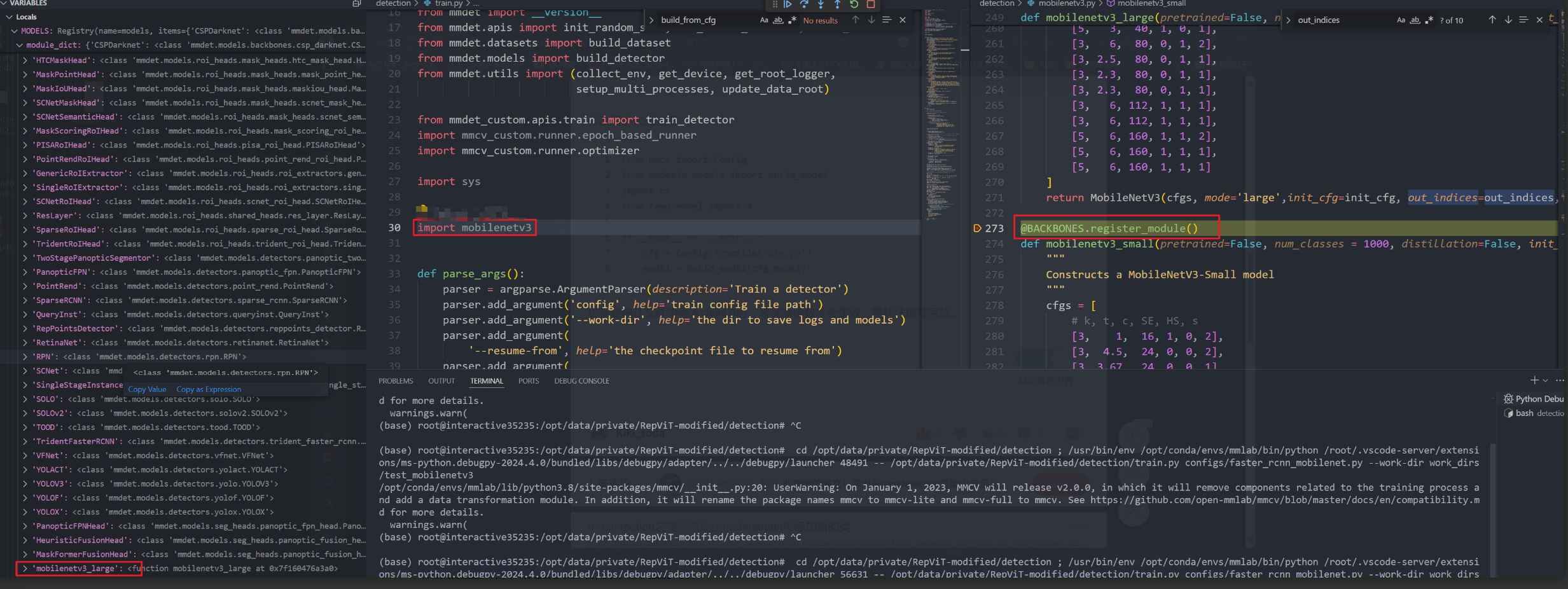

mmdetection使用未定义backbone训练

首先找到你需要用到的 backbone,一般有名的backbone 都会在github有相应的代码开源和预训练权重提供 本文以mobilenetv3 + fastercnn 作为举例,在mmdetection中并未提供 mobilenetv3,提供的仅有 mobilenetv2; 在github上找到 mobilenetv3 实现和权重,下载到本地;本文使用参考为:https://github.c

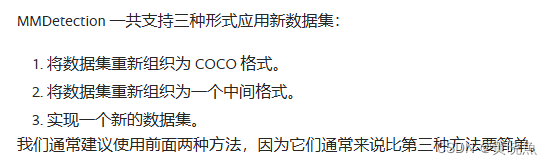

【MMdetection】2.自定义数据训练

1.废话 因为MMdetection里面提供了非常多的模型和配置文件供我们选择,这样做对比实验非常方便。 在标准数据集上训练预定义的模型 — MMDetection 3.3.0 文档 官方文档在此。 openMMlab提供了各种经典网络和配置文件系统使得MMdetection的上手难度有一点,不熟悉官方常规操作的小伙伴可能被各种各样的配置文件弄晕,这里总结网上一些优秀博主的博客和视频教程,

手把手教你MMDetection实战

论文下载地址:点击这里 本页提供有关MMDetection用法的基本教程。有关安装说明,请参阅INSTALL.md。 目录 预训练模型的推论训练模型有用的工具如何 预训练模型的推论 我们提供测试脚本以评估整个数据集(COCO,PASCAL VOC等),还提供一些高级api,以便更轻松地集成到其他项目。 名词解析 ${CONFIG_FILE}:代表着 config/里面文件的位置,比

场景文本检测识别学习 day10(MMdetection)

配置文件(config) 由于在大型项目中,一种模型需要分:tiny、small、big等很多种,而它们的区别主要在网络结构,数据的加载,训练策略等,且差别很多都很小,所以如果每个模型都手动从头写一份,很麻烦,为了方便,现在都是直接采用配置文件的形式来定义如yaml文件、py文件等 MMdetection的配置文件构成 在MMdection的配置文件中,我们根据字段来定义模型训练的各部分

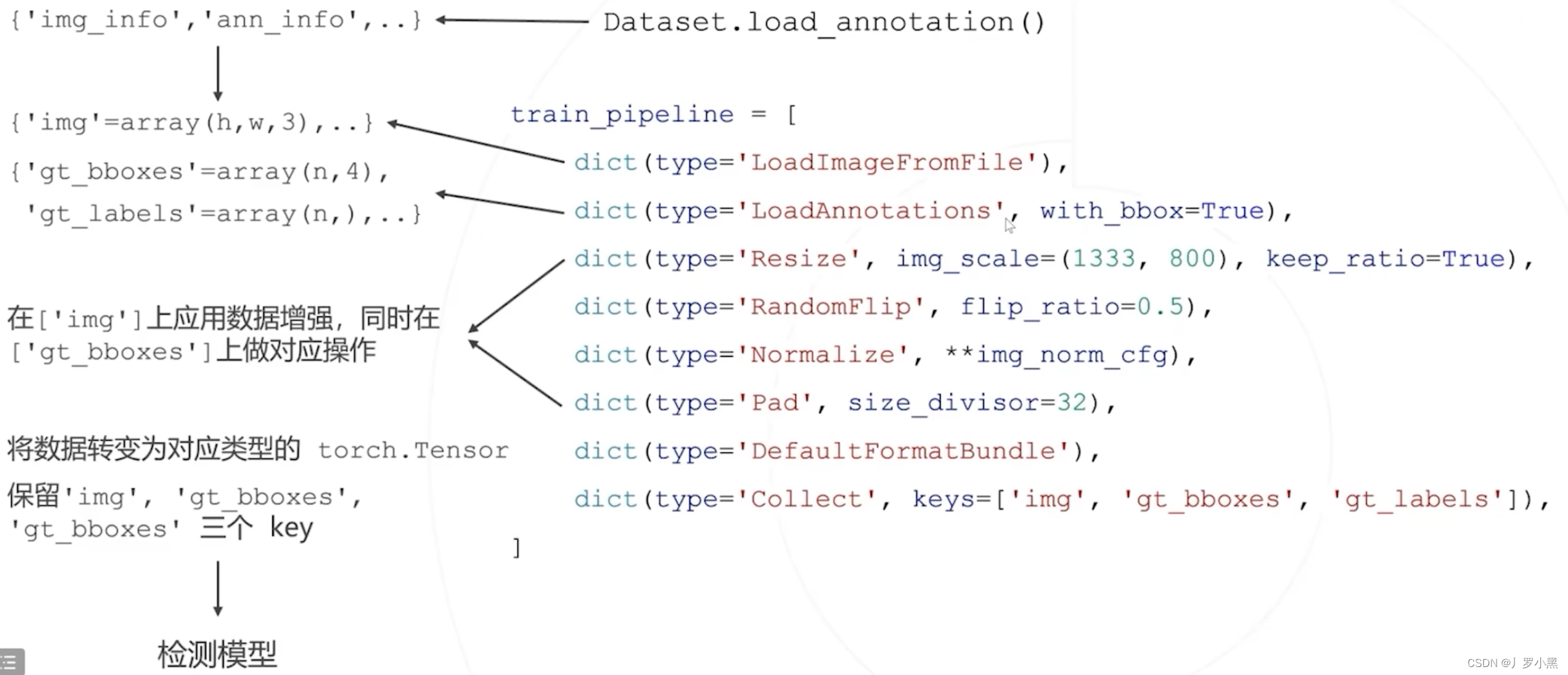

利用MMDetection进行模型微调和权重初始化

目录 模型微调修改第一处:更少的训练回合Epoch修改第二处:更小的学习率Learning Rate修改第三处:使用预训练模型 权重初始化init_cfg 的使用配置初始化器 本文基于 MMDetection官方文档,对模型微调和权重初始化进行第三方讲解。 模型微调 在 COCO 数据集上预训练的检测器可以作为其他数据集优质的预训练模型。 微调超参数与默认的训练策略不

MMdetection在Featurize服务器运行时相关问题

写点闲话: 之前因为毕业,想写代码再也没有稳定的机子跑了,自己电脑有时候也带不动,所以开始使用Featurize,这里可以租一些显卡来用,价格总体来说对我们这种偶尔有大规模算力需求的打工人非常友好。使用方法也很简单,就是和使用linux一样。 因为Featurize的显卡环境相对固定,不存在每个人机子不一样的问题,配置环境这一步大家就可以放心抄作业了!(特别适用于只是为了拿这个做毕设的非计算机专

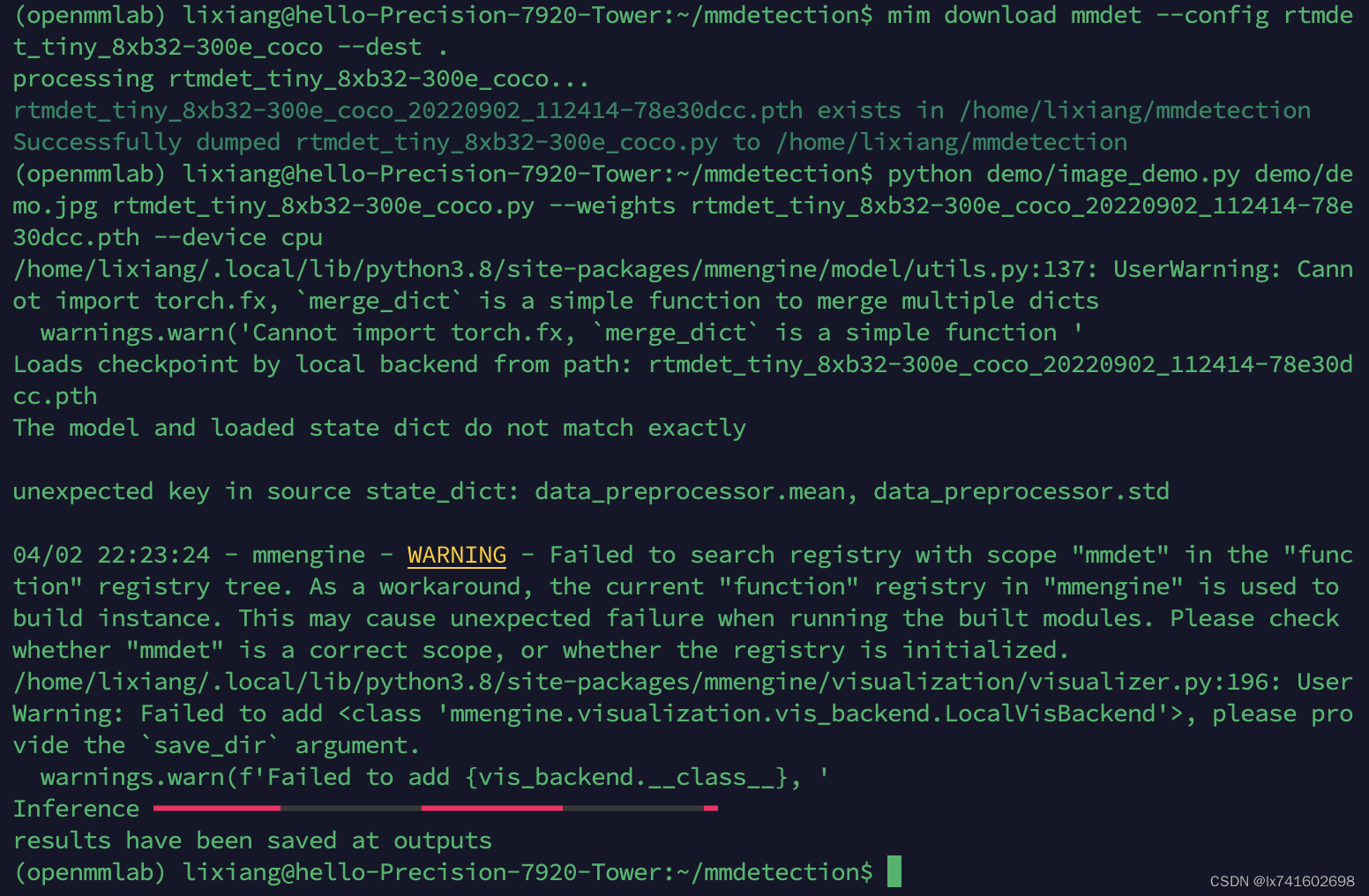

MMDetection目标检测框架推理与参数量计算

模型推理 在使用MMDetection框架完成训练后便可以使用训练所得的权重文件进行推理了,具体可以使用MMDetection文件下的demo文件夹的image_demo.py文件。 from argparse import ArgumentParserfrom mmengine.logging import print_logfrom mmdet.apis import DetInfer

【mmdetection安装】在线安装和离线安装

mmdetection安装 安装版本在线安装版离线安装版参考 记录mmdetection安装过程,网络环境好久就选择在线安装,记录离线安装是因为超算网络环境太恶劣… 安装版本 版本python3.10pytorch2.1.0(cuda11.8)mmcv2.1.0mmdetectiongit下载安装即可 在线安装版 虚拟环境: conda create -n mmdet

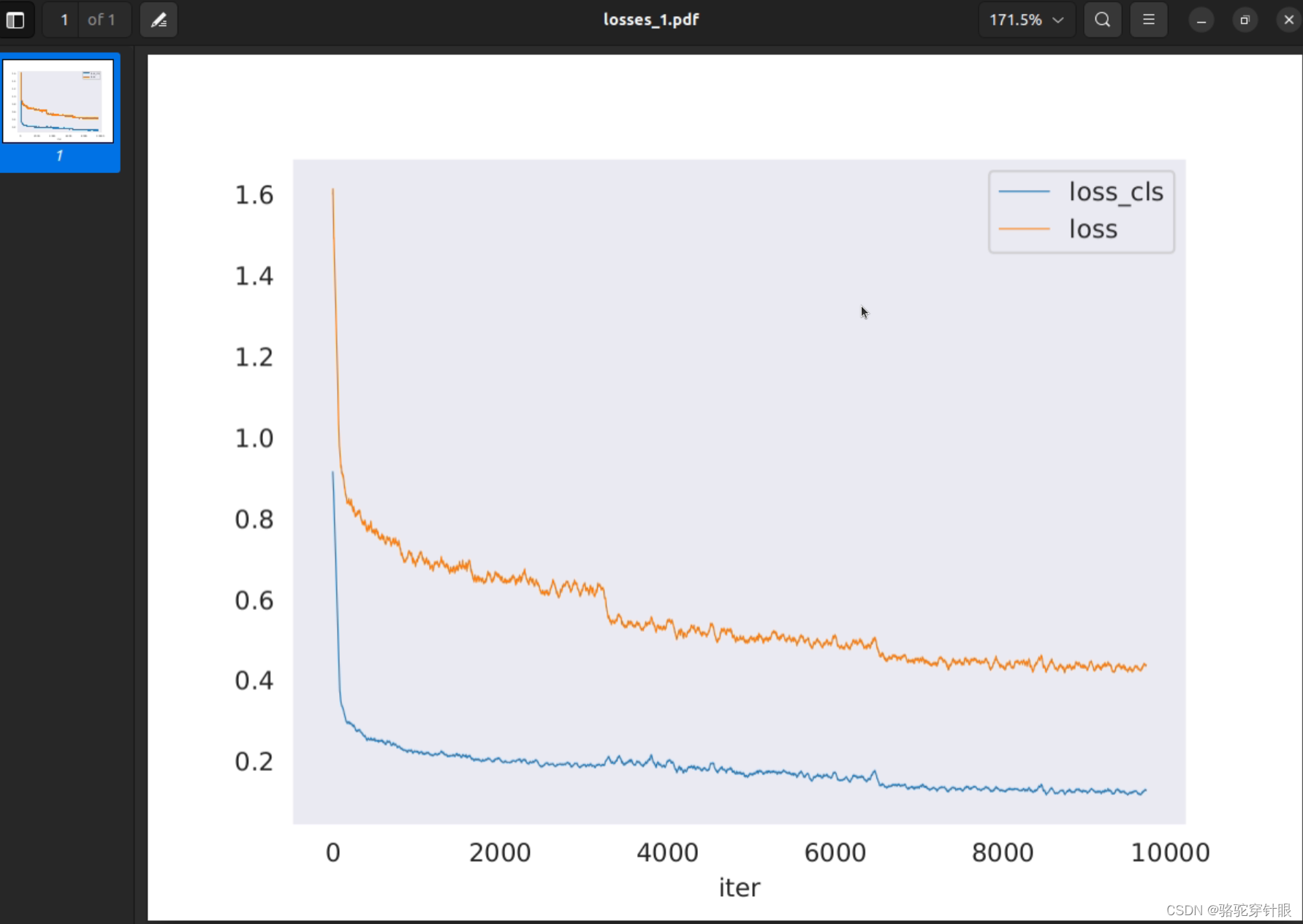

使用mmdetection来训练自己的数据集(visdrone)(四)结果分析

测试 python tools/test.py <your-config-file> <your-model-weights-file> --out <save-pickle-path> 关于test.py 的命令行 parser.add_argument('--out',type=str,help='dump predictions to a pickle file for o

使用mmdetection来训练自己的数据集(visdrone)(二)数据集

数据集下载 https://github.com/VisDrone/VisDrone-Dataset 数据集大小: trainset (1.44 GB):valset (0.07 GB):testset-dev (0.28 GB): VisDrone2019-DET-train.zip (下载到D:/ultralytics/ultralytics/datasets/VisDrone目录下

mmdetection - anchor-based方法训练流程解析

训练流程图 最终会创建一个runner,然后调用runner.run时,实际会根据workflow中是train还是val,调用runner.py下的train和val函数。 batch_processor def batch_processor(model, data, train_mode):# 这里的train_mode实际没用到losses = model(**data)loss, l

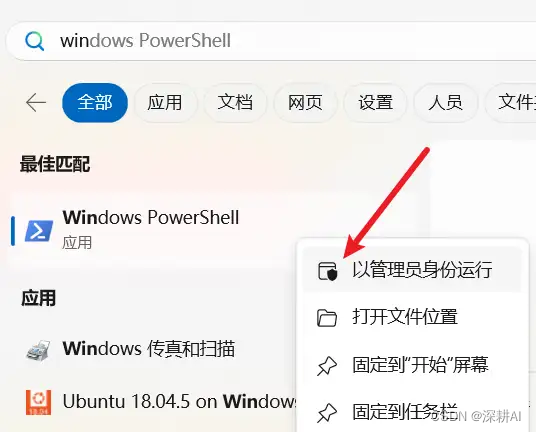

mmdetection模型使用mmdeploy部署在windows上的c++部署流程【详细全面版】

0. 前置说明: 该文档适用于:已经使用mmdetection训练好了模型,并且完成了模型转换。要进行模型部署了。 1. 概述 MMDeploy 定义的模型部署流程,如下图所示: 模型转换【待撰写,敬请期待…】 主要功能是:把输入的模型格式,转换为目标设备的推理引擎所要求的模型格式。 目前,MMDeploy 可以实现:① 把PyTorch模型,转换为 ONNX、TorchScrip

配mmdetection

总流程: 1. 安装conda 参考链接后面补上 列出可用的conda环境 conda env list 删除指定环境 conda remove --name myenv --all 创建并激活指定环境 conda create --name openmmlab python=3.8 -yconda activate openmmlab 2. 装pytorch,版本别

mmdetection源码解读-0:什么是mmdetection

mmdetection商汤科技和香港中文大学最近开源了一个基于Pytorch实现的深度学习目标检测工具箱mmdetection,支持Faster-RCNN,Mask-RCNN,Fast-RCNN等主流的目标检测框架,后续会加入Cascade-RCNN以及其他一系列目标检测框架。选择学习这个框架,是应为它支持的目标检测的网络模型比较多。想详细了解可以阅读github的工程和arxiv的文档 《MMD

安装mmdetection及组件

OS: ubuntu20.04 # CUDA: 11.8, python: 3.8, PyTorch: 2.0.1pip3 install torch==2.0.1 torchvision==0.15.2 --index-url https://download.pytorch.org/whl/cu118# 安装mmcvpip3 install mmenginepip3 install mm

mmdetection中yolo配置文件的注释

配置文件的地址在.\configs\yolo\yolov3_d53_mstrain-608_273e_coco.py有些没有注释的和我猜测的地方请朋友们不吝赐教 在MMDetection中,模型组件基本上分为4种类型。 骨干网:通常是FCN网络,用于提取特征图,例如ResNet。 颈部:骨干和头部之间的部分,例如FPN,ASPP。 头部:用于特定任务的部分,例如bbox预测和蒙版预测。 ro

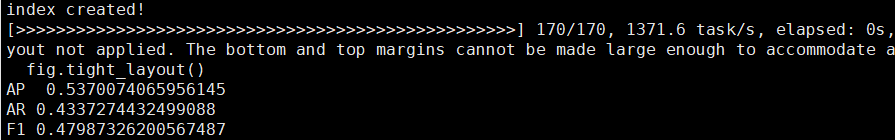

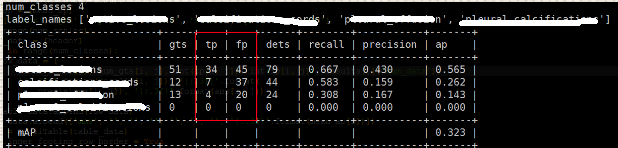

mmdetection如何计算准确率、召回率、F1值

1、训练 python tools/train.py configs/fcos/fcosrdweed3.py 2、测试 这一步要加–out=result.pkl,才能计算准确率和召回率 python tools/test.py configs/fcos/fcosrddweed3.py work_dirs/fcosrddweed3/epoch_300.pth --out=resultfc

win11配置mmdetection--SOLOV2实例

官方安装步骤:Prerequisites — MMDetection 2.17.0 documentation 训练营学习记录:OpenMMLab 实战营打卡 - 第 五 课 MMDetection_mmdetection可以干什么-CSDN博客 MMDetection是商汤和港中文大学针对目标检测任务推出的一个开源项目,它基于Pytorch实现了大量的目标检测算法,把数据集构建、模型搭建

MMDetection 教程(一)

1、安装配置MMDetection #新建conda环境!conda env list # conda environments:#/home/snnu/anaconda3/home/snnu/anaconda3/envs/jxl/home/snnu/anaconda3/envs/torch18/home/snnu/anaconda3/envs/ztbase

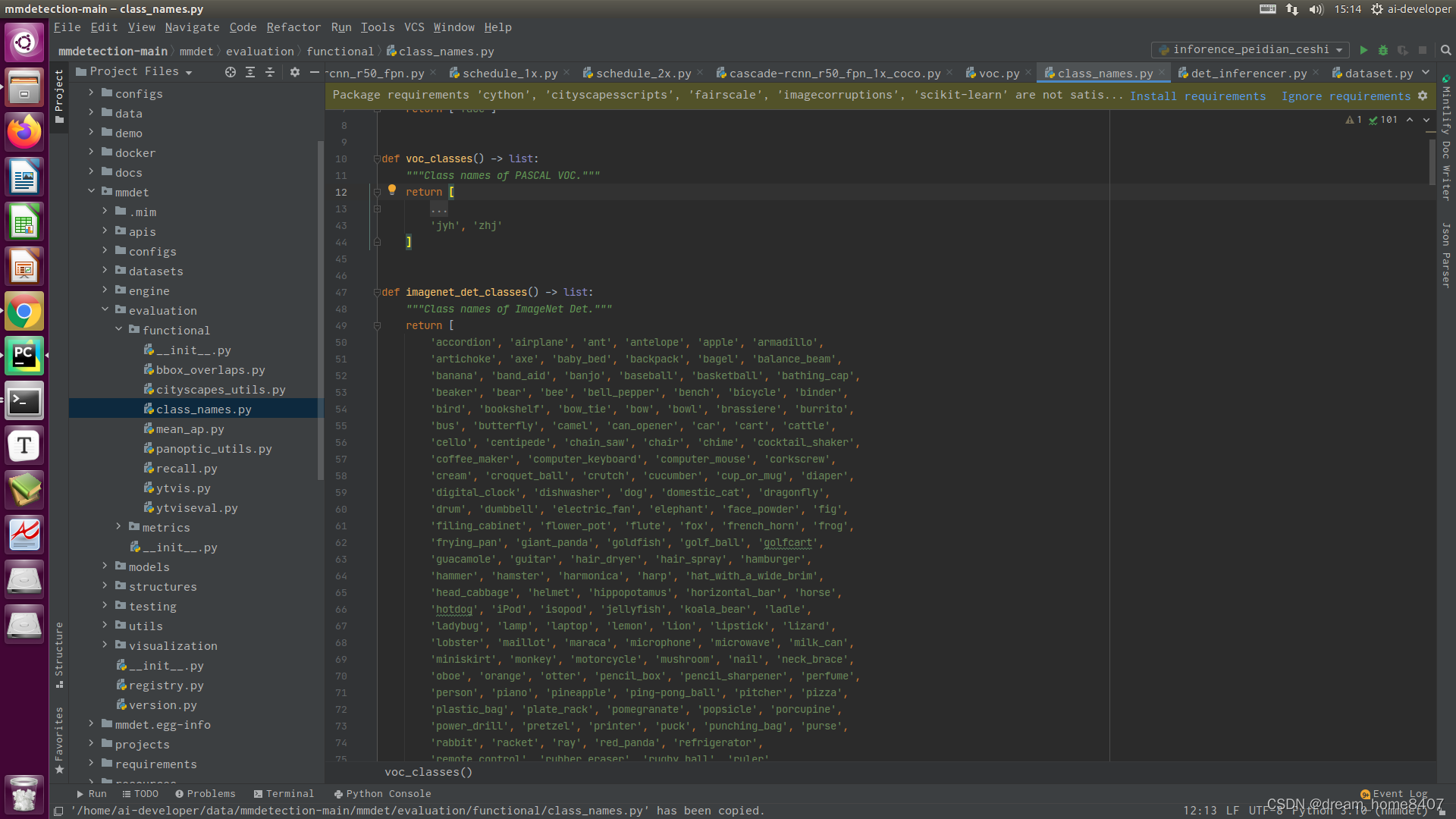

mmdetection使用自己的voc数据集训练模型实战

一.自己数据集整理 将labelimg格式数据集进行整理 1.1. 更换图片后缀为jpg import osimport shutilroot_path='/media/ai-developer/img'file=os.listdir(root_path)for img in file:if img.endswith('jpeg') or img.endswith('JPG') or img.

mmdetection模型转onnx和tensorrt实战

一,说明 1.本次实战使用的是mmdetection算法框架中的Cascase-Rcnn训练的模型; 2.模型转换时,运行环境中各种工具的版本要保持一致; 3.TensorRT我一直装不上,我用的是镜像环境. 参考链接:link 二,使用Docker镜像 1.0,镜像基础环境构建 export TAG=openmmlab/mmdeploy:ubuntu20.04-cuda11.8-m

MMdetection训练时报错KeyError: “Duplicate key is not allowed among bases.

MMdetection在训练时报错如下: 这是由于配置文件中继承文件出现重复导致,比如: 其实第一个继承文件里面已经包含了后面三个文件,所以删除后面3个即可

Detectron2和MMDetection的学习笔记(legacy)

1 Detectron2和MMDetection的对比 1.3 从对PyTorch的理解上来看,我觉得Detectron2会好一些 从对PyTorch的理解上来看,我觉得Detectron2会好一些,因为它们都是Facebook推出的产品; 1.4 从架构的感觉上看,还是Detectron2会好一些 今天在学习MMDetection的时候,发现有一点很奇怪,类别数竟然需要自己手动指定,而不

mmdetection-虚拟环境的搭建与代码调试

1、mmdetection---虚拟环境配置 官方要求: 初始环境: python==3.6.8CUDA==9.0Pytorch==1.0.0GCC==4.8.4mmcv>=0.2.6 遇到的问题: ①、Segmentation fault(core dumped)-段错误 使用‘‘gdb’’追踪错误: 错误原因:gcc和系统版本太低,需要升级系统和gcc版本; 参考网址: