mamba专题

kaggle竞赛宝典 | Mamba模型综述!

本文来源公众号“kaggle竞赛宝典”,仅用于学术分享,侵权删,干货满满。 原文链接:Mamba模型综述! 型语言模型(LLMs),成为深度学习的基石。尽管取得了令人瞩目的成就,Transformers仍面临固有的局限性,尤其是在推理时,由于注意力计算的平方复杂度,导致推理过程耗时较长。 最近,一种名为Mamba的新型架构应运而生,其灵感源自经典的状态空间模型,成为构建基础模型的有力替代方案

widows安装配置mamba_ssm环境

由于现在mamba大火,所以将mamba_ssm在windows中的环境配置进行介绍,如果你想在windows中进行开发,那么这是你最好的选择!! 安装步骤 1.anaconda下载 官网下载:https://www.anaconda.com/download 下载好后: 接下来点击进行安装,对于anaconda的安装,网上教程很多,请自行安装 下载CUDA 1.win+r打开cmd

3天把Llama训成Mamba,性能不降,推理更快!

近日,Mamba方面又搞出了有意思的研究:来自康奈尔、普林斯顿等机构的研究人员成功将Llama提炼成了Mamba模型,并且设计了新的推测解码算法,加速了模型的推理。\ 先来看一张其乐融融的图片(一眼AI): 右边的小羊驼代表Llama,而左边的蛇(Mamba)也是我们的老熟人了。 至于到底能不能其乐融融,咱就不管了,之所以有此场景,是因为Mamba方面又搞出了有意思的研究: ——如何把

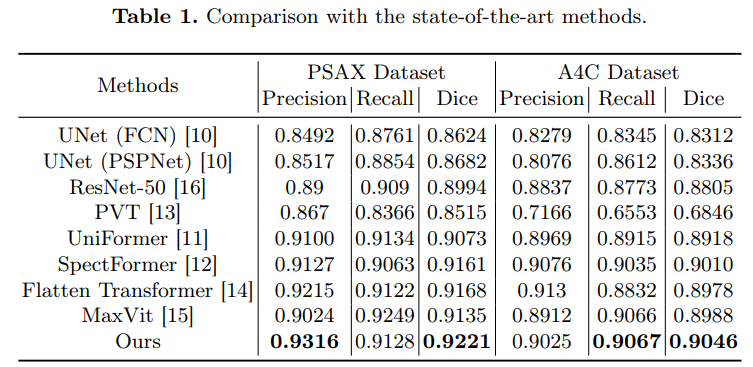

【计算机视觉前沿研究 热点 顶会】ECCV 2024中Mamba有关的论文

MambaIR:状态空间模型图像恢复的简单基线 近年来,图像恢复技术取得了长足的进步,这在很大程度上归功于现代深度神经网络的发展,如 CNN 和 Transformers。然而,现有的修复骨干往往面临全局接受域和高效计算之间的两难困境,阻碍了它们在实践中的应用。最近,选择性结构化状态空间模型,特别是改进的 Mamba 模型,在线性复杂度的长程依赖建模方面显示出了巨大的潜力,为解决上述困境提供了一

机器之心 | 五倍吞吐量,性能全面包围Transformer:新架构Mamba引爆AI圈

本文来源公众号“机器之心”,仅用于学术分享,侵权删,干货满满。 原文链接:五倍吞吐量,性能全面包围Transformer:新架构Mamba引爆AI圈 屹立不倒的 Transformer 迎来了一个强劲竞争者。 在别的领域,如果你想形容一个东西非常重要,你可能将其形容为「撑起了某领域的半壁江山」。但在 AI 大模型领域,Transformer 架构不能这么形容,因为它几乎撑起了「整个江山

Mamba 2的发布是否可以撼动Transformer模型的AI大一统的江湖地位

Transformer模型 Transformer模型是深度学习领域的一种神经网络架构,特别适用于自然语言处理(NLP)任务。它由Vaswani等人在2017年的论文《Attention is All You Need》中提出。Transformer模型的关键创新在于其使用注意力机制,而不是传统的递归神经网络(RNN)或卷积神经网络(CNN)来处理序列数据。正是由于Transformer模型强大

论文浅读之Mamba: Linear-Time Sequence Modeling with Selective State Spaces

介绍 这篇论文提出了一种新型的"选择性状态空间模型"(Selective State Space Model, S6)来解决之前结构化状态空间模型(SSM)在离散且信息密集的数据(如文本)上效果较差的问题。 Mamba 在语言处理、基因组学和音频分析等领域的应用中表现出色。其创新的模型采用了线性时间序列建模架构,结合了选择性状态空间,能够在语言、音频和基因组学等不同模式中提供卓越的性能。这种突破

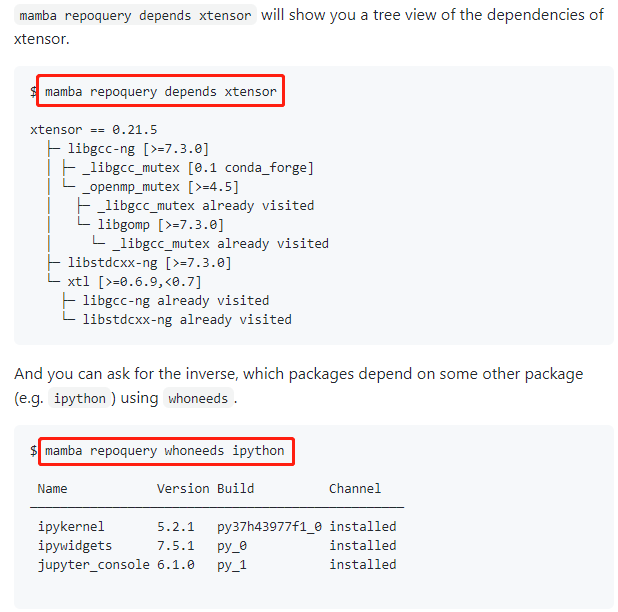

python包管理器--- pip、conda、mamba的比较

1 pip 1.1 简介 pip是一个 Python 的包(Package)管理工具,用于从 PyPI 安装和管理 Python 标准库之外的其他包(第三方包)。从 Python 3.4 起,pip 已经成为 Python 安装程序的一部分,也是官方标准的 Python 包管理器,由 PyPA 组织更新维护。 1.2 常用命令 这里,我同时补充下关于p

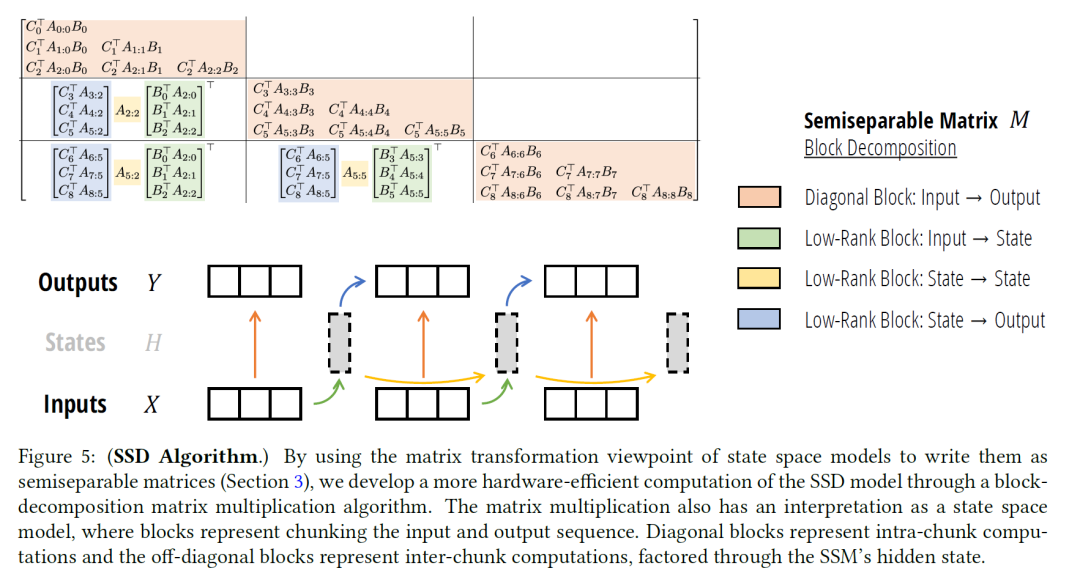

Mamba v2诞生:2 那些烧脑的矩阵们

大模型技术论文不断,每个月总会新增上千篇。本专栏精选论文重点解读,主题还是围绕着行业实践和工程量产。若在某个环节出现卡点,可以回到大模型必备腔调或者LLM背后的基础模型新阅读。而最新科技(Mamba,xLSTM,KAN)则提供了大模型领域最新技术跟踪。若对于具身智能感兴趣的请移步具身智能专栏。技术宅麻烦死磕AI架构设计。 Mamba的出现为带来了全新的思路和可能性,通过对结构化半可分离矩阵的各种

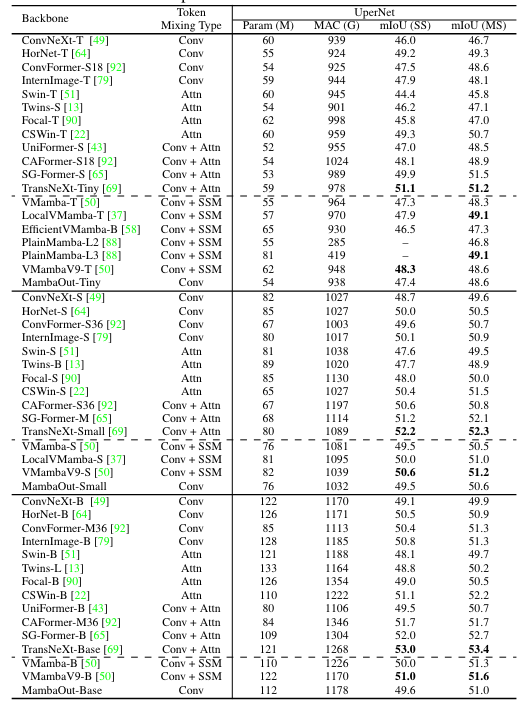

【模型架构】学习最火热的Mamba、Vision Mamba、MambaOut模型

一、Mamba 论文链接:Mamba: Linear-Time Sequence Modeling with Selective State Spaces 代码链接:https://github.com/state-spaces/mamba 作者:Albert Gu,Tri Dao 发表单位:卡内基梅隆大学、普林斯顿大学 会议/期刊:暂无 Mamba的提出起源于RNN和Transfor

[论文阅读笔记31]Mamba (Selective Structured State Space Model) 及其应用

最近想学一下Mamba模型,奈何看了很多视频还是感觉一知半解,因此做一篇笔记,顺便介绍一下Mamba结构作为CV backbone和时间序列预测领域的应用。 论文1. Mamba: Linear-Time Sequence Modeling with Selective State Spaces 0. Abstract 现有的基础模型都是以Transformer结构作为核心组建的。然

ICML 2024 Mamba 论文总结

2024ICML(International Conference on Machine Learning,国际机器学习会议)在2024年7月21日-27日在奥地利维也纳举行 🌟【紧跟前沿】“时空探索之旅”与你一起探索时空奥秘!🚀 欢迎大家关注时空探索之旅 Mamba进行了自我更新迭代变为了Mamba2接收了(Gu和Dao换了一下作者顺序) Transformers are SSMs:

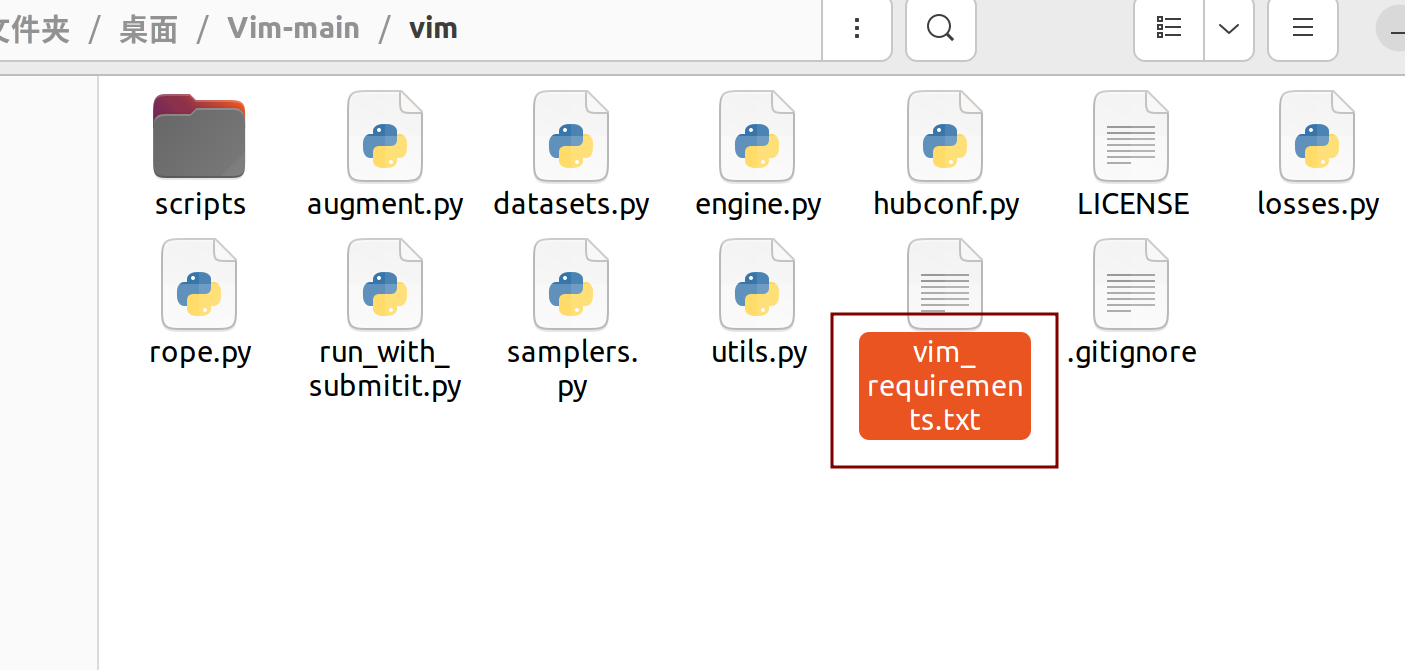

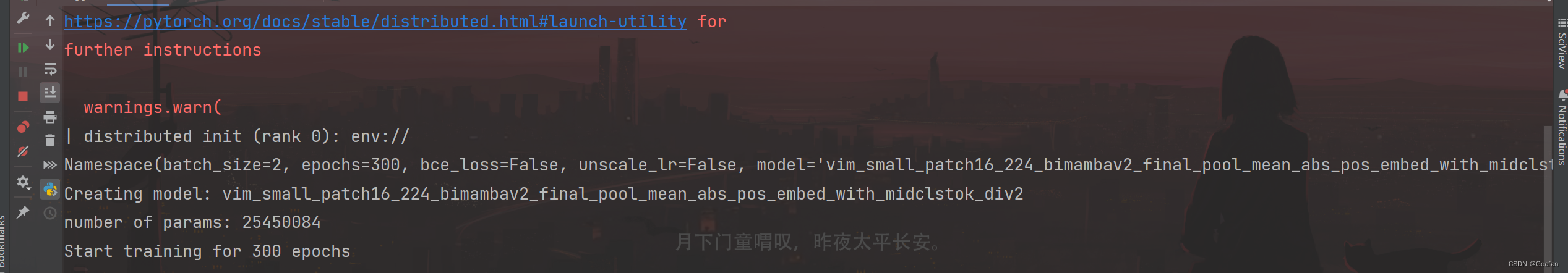

Vision Mamba 代码调试---Pycharm+AutoDL

《AutoDL使用手册》 1. 服务器租用与配置 先上项目链接: GitHub - hustvl/Vim: Vision Mamba: Efficient Visual Representation Learning with Bidirectional State Space Model 1.1 服务器租用与配置 根据环境要求,去租一个服务器:AutoDL算力云 | 弹性

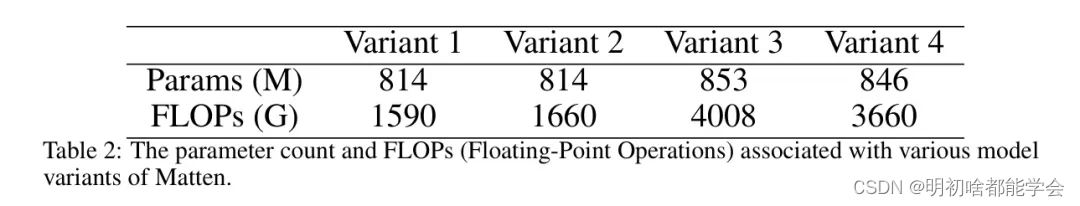

Matten:视频生成与Mamba-Attention

Matten:视频生成与Mamba-Attention 摘要IntroductionRelated WorkMethodology Matten: Video Generation with Mamba-Attention 摘要 在本文中,作者介绍了Matten,一种具有Mamba-Attention架构的尖端潜在扩散模型,用于视频生成。在极小的计算成本下,Matten利用空

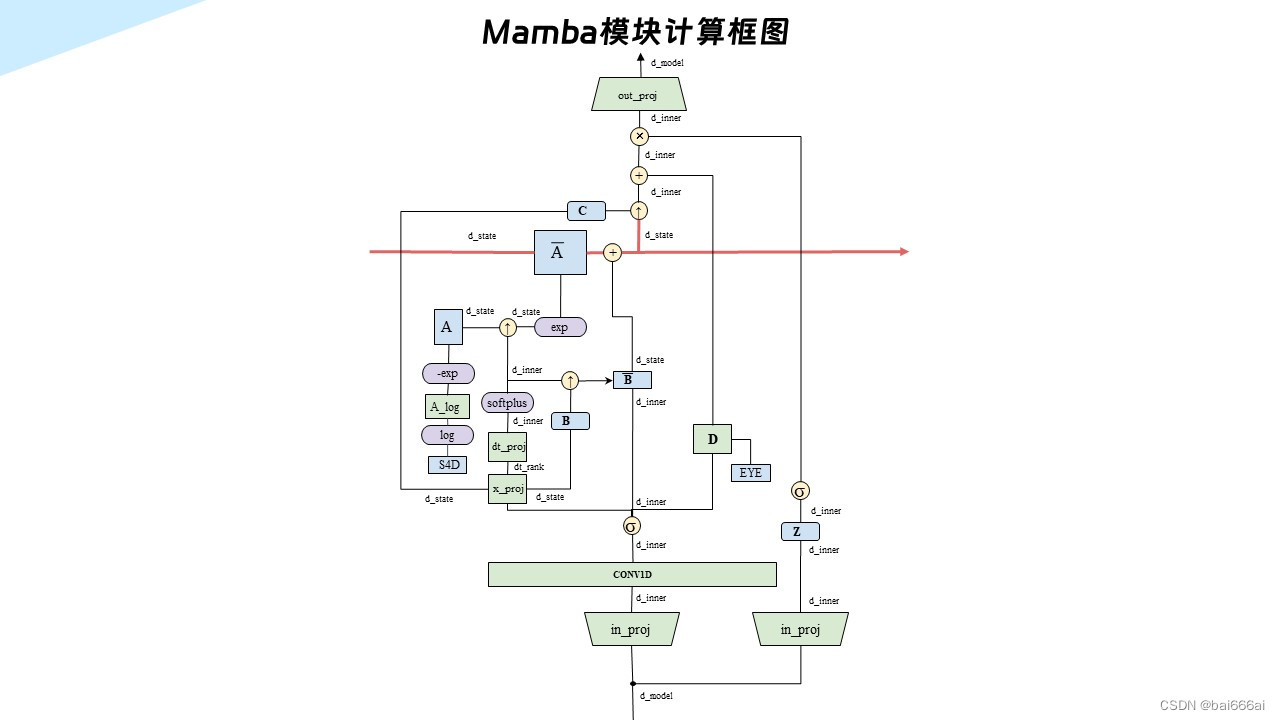

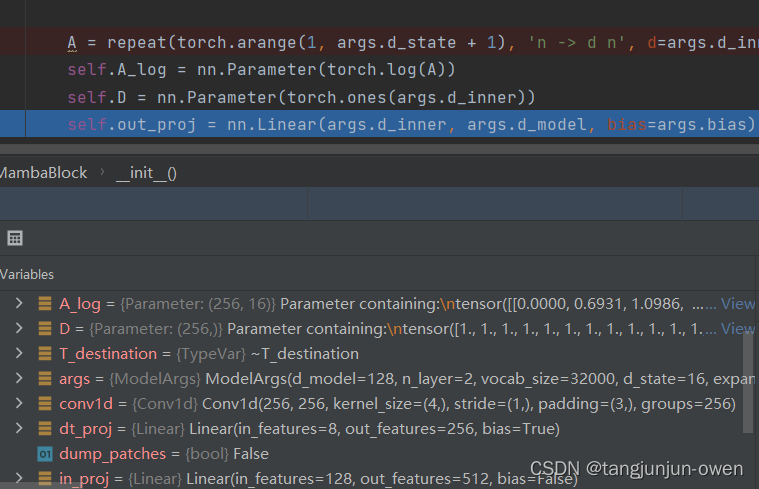

Mamba结构的Demo源码解读

文章目录 前言一、mamba结构构建辅助函数解读1、@dataclass方法解读2、Norm归一化LayerNormRMSNormRMSNorm源码 3、nn.Parameter方法解读 二、mamba原理二、mamba模型构建1、主函数入口源码解读2、Mamba类源码解读 三、ResidualBlock的mamba结构源码解读四、MambaBlock构成ResidualBlock模块源码解

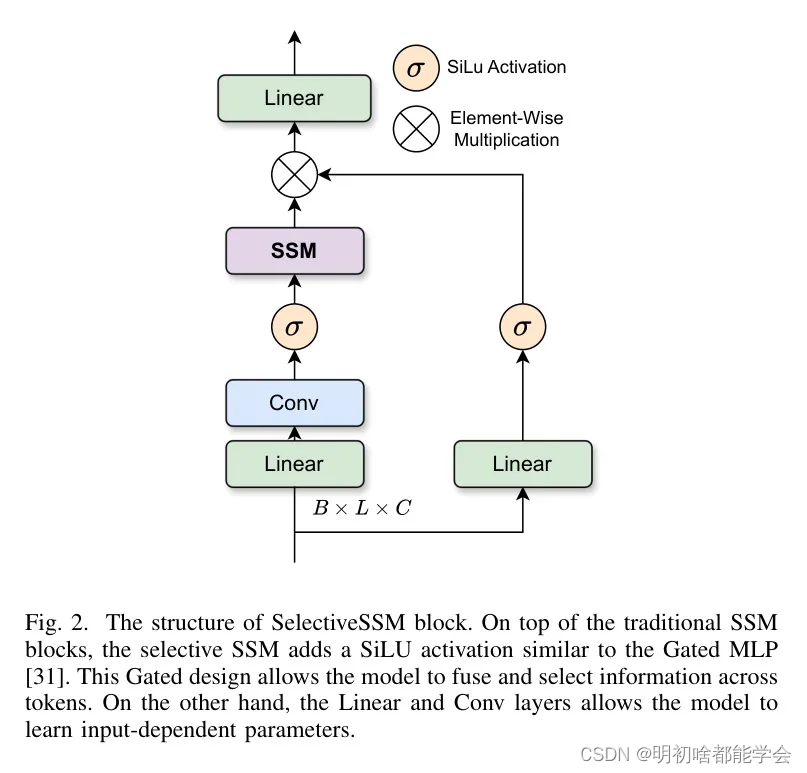

fero - yolo - mamba:基于选择性状态空间的面部表情检测与分类

fero - yolo - mamba:基于选择性状态空间的面部表情检测与分类 摘要IntroductionRelated work FER-YOLO-Mamba: Facial Expression Detection and Classification Based on Selective State Space 摘要 面部表情识别(FER)在理解人类情绪线索方面起着关

《Video Mamba Suite》论文笔记(1)Mamba在时序建模中的作用

原文链接 https://arxiv.org/abs/2403.09626https://arxiv.org/abs/2403.09626 原文代码 https://github.com/OpenGVLab/video-mamba-suitehttps://github.com/OpenGVLab/video-mamba-suite 原文笔记 What 《Video Mamba Sui

[每日AI·0501]GitHub 版 Devin,Transformer的强力挑战者 Mamba,Sora 制作细节与踩坑,OpenAI 记忆功能

AI 资讯 国资委:加快人工智能等新技术与制造全过程、全要素深度融合GitHub版 Devin 上线,会打字就能开发应用,微软 CEO:重新定义 IDE在12个视频理解任务中,Mamba 先打败了 TransformerSora 会颠覆电影制作吗?3 人团队使用 Sora 制作短片完整技术细节&踩坑分享小红书让智能体们吵起来了!联合复旦推出大模型专属群聊工具OpenAI:记忆功能现已对所有Cha

深入浅出一文图解Vision Mamba(ViM)

文章目录 引言:Mamba第一章:环境安装1.1安装教程1.2问题总结1.3安装总结 第二章:即插即用模块2.1模块一:Mamba Vision代码:models_mamba.py运行结果 2.2模块二:MambaIR代码:MambaIR运行结果 第三章:经典文献阅读与追踪经典论文Mamba系列论文追踪 第四章:Mamba理论与分析第五章:总结和展望 引言:Mamba 2

CU-Mamba:具有通道学习功能的选择性状态空间模型用于图像恢复

CU-Mamba:具有通道学习功能的选择性状态空间模型用于图像恢复 摘要IntroductionRelated WorkMethod CU-Mamba: Selective State Space Models with Channel Learning for Image Restoration 摘要 重建退化图像是图像处理中的关键任务。尽管基于卷积神经网络(CNN)和Tr

Mamba模型原理与代码精讲

课程链接:Mamba模型原理与代码精讲_在线视频教程-CSDN程序员研修院 Mamba模型是最近提出的可匹敌甚至超越Transformer的前沿序列模型。 Mamba引入了选择性状态空间模型(SSM), 允许SSM参数成为输入的函数,使得模型能够根据输入token沿着序列长度维度选择性地传播或遗忘信息。 通过设计面向硬件的并行扫描算法, 可高效地计算,达到了线性时间复杂度。与Transfor

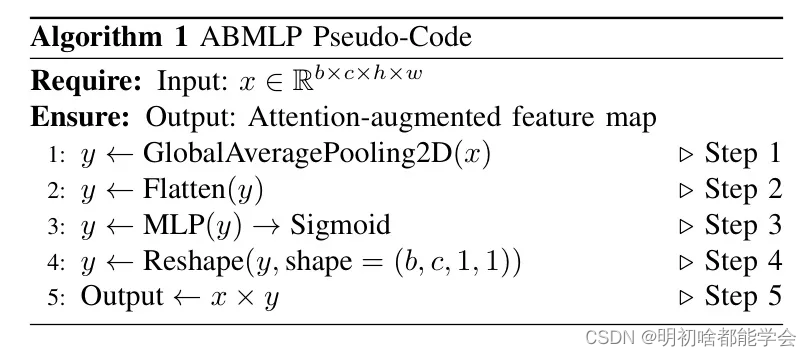

YoloV8改进策略:注意力改进|Neck改进|自研全新的Mamba注意力|即插即用,简单易懂:附结构图|检测、分割、关键点均适用(独家原创,全世界首发)

摘要 无Mamba不狂欢,本文打造基于Mamba的注意力机制。全世界首发基于Mamba的注意力啊!对Mamba感兴趣的朋友一定不要错过啊! 本文使用Mamba改进YoloV8的Block和BackBone实现涨点。 环境 系统:ubuntu22.04 CUDA:12.1 python:3.11 显卡驱动:545 安装过程 系统、CUDA和python的安装过程忽略,这些都能找到。

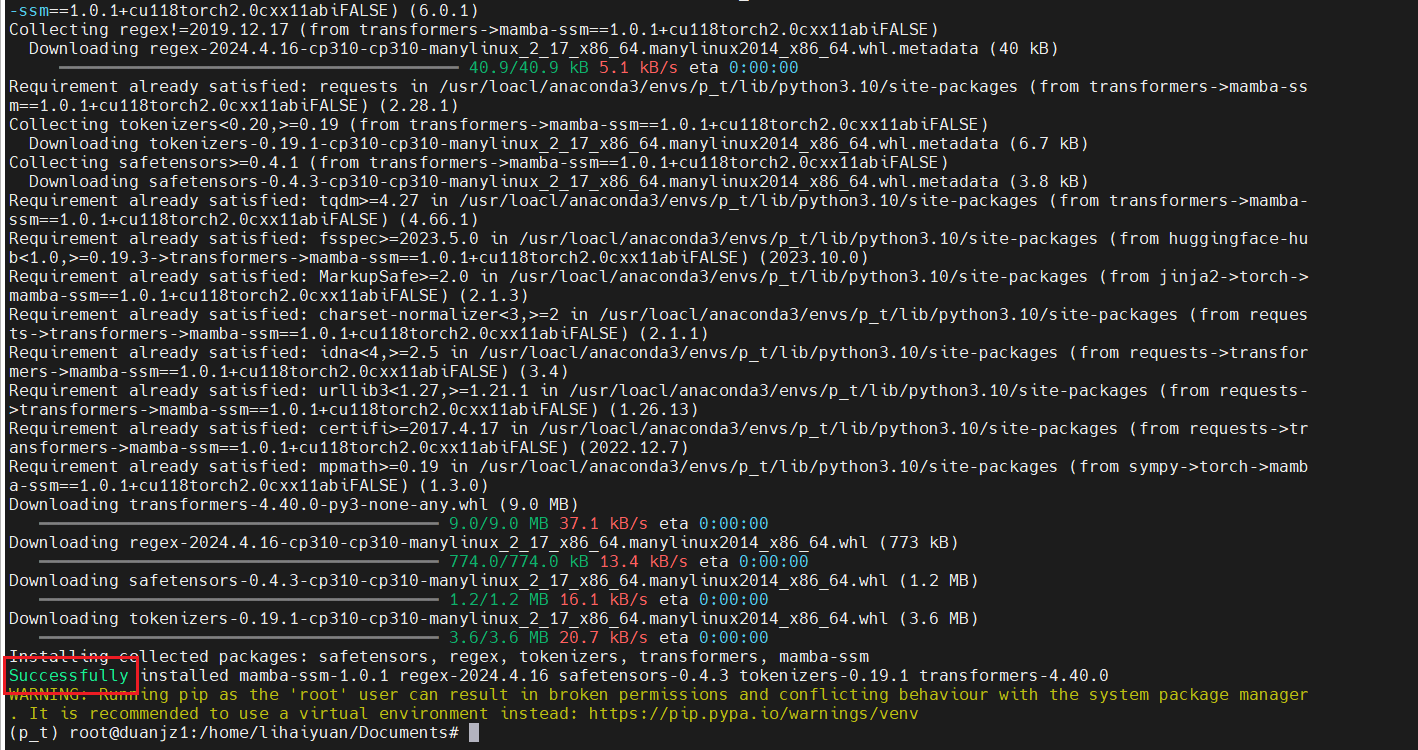

mamba_ssm和causal-conv1d安装教程

一、前言 最近爆火的mamba模型,号称是可以取代transformer模型的存在,这个能不能取代,时间会告诉我们的。由于mamba模型比较新,所以在安装其环境的时候,还是有点麻烦的。mamba_ssm和causal-conv1d这两个包似乎不能在windows下安装,但是我没有尝试过(github也没有windows系统的离线包),看到其他博主这样说的,身边能有linux的还是在linux下安

一举颠覆Transformer!最新Mamba结合方案刷新多个SOTA,单张GPU即可处理140k

还记得前段时间爆火的Jamba吗? Jamba是世界上第一个生产级的Mamba大模型,它将基于结构化状态空间模型 (SSM) 的 Mamba 模型与 transformer 架构相结合,取两种架构之长,达到模型质量和效率兼得的效果。 在吞吐量和效率等关键衡量指标上,Jamba处理128k长上下文时吞吐量是 Mixtral 8x7B的3倍;在成本上,Jamba一共支持256k上下文,单张

学习记录——Mamba 草记

Mamba 学习记录 RNN 循环神经网络,每一个时刻的隐藏状态 h t h_t ht都是基于当前的输入 x t x_t xt和前一个时刻的隐藏状态 h t − 1 h_{t-1} ht

Vision Mamba 环境安装 运行笔记

环境描述 ubuntupytorch 2.1 和配套的torchvision torchaudiocuda 12.1python 3.10 安装causal-conv1d 参考复现U-Mamba。下载whl包,安装causal_conv1d==1.1.0。具体而言, git clone http://github.com/Dao-AILab/causal-conv1d.gitgit c

![[论文阅读笔记31]Mamba (Selective Structured State Space Model) 及其应用](https://img-blog.csdnimg.cn/direct/b270c0fb2e0148e09188c58e74ebc44a.png)

![[每日AI·0501]GitHub 版 Devin,Transformer的强力挑战者 Mamba,Sora 制作细节与踩坑,OpenAI 记忆功能](https://img-blog.csdnimg.cn/img_convert/185ea0ff328394d2d377a1344a6078d1.png)