latent专题

DIFFUSION 系列笔记| Latent Diffusion Model、Stable Diffusion基础概念、数学原理、代码分析、案例展示

目录 Latent Diffusion Model LDM 主要思想 LDM使用示例 LDM Pipeline LDM 中的 UNET 准备时间步 time steps 预处理阶段 pre-process 下采样过程 down sampling 中间处理 mid processing 上采样 upsampling 后处理 post-process LDM Super

High-variance latent spaces

“High-variance latent spaces” 这个术语通常出现在机器学习和人工智能领域,特别是在涉及到生成模型、表示学习和特征学习的时候。在这个上下文中,“latent space” 指的是一个多维空间,其中每个点代表输入数据的一个潜在表示或特征向量。这个空间是“潜在”的,因为它不是直接观察到的数据,而是通过某种学习算法从原始数据中提取出来的。 “High-variance” 描述

【R语言篇】潜在类别分析(Latent Class Analysis, LCA)及其在R语言中的实现

1. 潜在类别分析简介 潜在类别分析(LCA)是一种用于识别样本中潜在子群的统计方法。这种方法基于观察到的数据来估计个体属于不同潜在类别的概率。LCA广泛应用于社会科学、市场研究、生物医学等领域,尤其适用于处理分类数据。 2. LCA的核心思想 LCA的核心在于假设数据中存在若干未观测到的、互斥的类别,每个类别代表了一种特定的群体特征。通过分析,我们可以估计出每个个体属于各个潜在类别的概率,进而

LDA(Latent Dirichlet Allocation)相关论文阅读小结

关于主题挖掘,LDA(Latent Dirichlet Allocation)已经得到了充分的应用。本文是我对自己读过的相关文章的总结。 1. 《LDA数学八卦》http://pan.baidu.com/s/18KUBG 把标准LDA的由来讲解得通俗易懂,细致入微。真的是了解LDA的最佳入门读物。 Gamma函数: 通过分部积分可以推导其具有递归性质 ,因此Gamma函数可以当成是阶乘在实

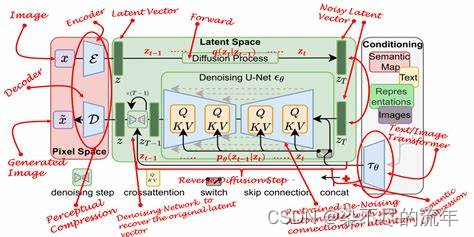

Latent Diffusion Models

Latent Diffusion Models(潜在扩散模型,LDMs)是一种生成模型,它结合了扩散模型和变分自动编码器(VAES)的优势,从文本或其他输入模式生成高质量图像。近年来,这些模型受到了相当大的关注,因为它们能够在保持对发电过程的控制的同时产生高度现实和多样化的产出。 Latent Diffusion Models(潜在扩散模型,LDMs)是一种基于潜在扩散过程的生成模型,它主要应用

Latent Diffusion Transformer for Probabilistic Time Series Forecasting

Latent Diffusion Transformer for Probabilistic Time Series Forecasting 摘要:多元时间序列的概率预测是一项极具挑战性但又实用的任务。本研究提出将高维多元时间序列预测浓缩为潜在空间时间序列生成问题,以提高每个时间戳的表达能力并使预测更易于管理。为了解决现有工作难以扩展到高维多元时间序列的问题,我们提出了一种称为潜在扩散变换器(L

Collapsed Gibbs Sampling for Latent Dirichlet Allocation on Spark

摘要 本文针对Spark上广泛使用的潜在Dirichlet分配(LDA)模型,实现了一种折叠Gibbs抽样方法。 Spark是一款面向大规模数据处理的快速内存集群计算框架,成为大数据小镇的领域话题已经有一段时间了。 适用于迭代和交互算法。 该方法将数据集分割成P∗P个分区,使用规则将这些分区洗牌并重组成P个子数据集,避免采样冲突,其中每个P个子数据集只包含P个分区,然后逐个并行处理每个子数

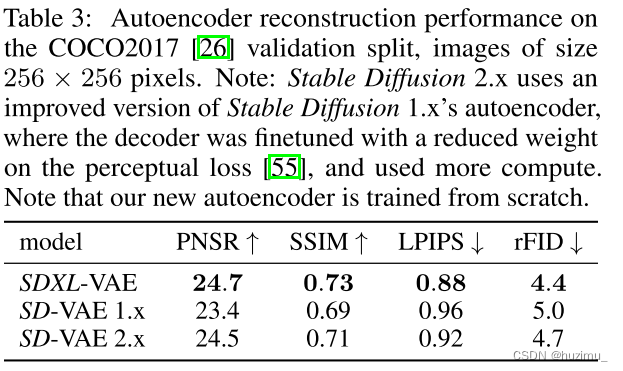

论文阅读:SDXL Improving Latent Diffusion Models for High-Resolution Image Synthesis

SDXL Improving Latent Diffusion Models for High-Resolution Image Synthesis 论文链接 代码链接 介绍 背景:Stable Diffusion在合成高分辨率图片方面表现出色,但是仍然需要提高本文提出了SD XL,使用了更大的UNet网络,以及增加了一个Refinement Model,以进一步提高图片质量。 提高SD的

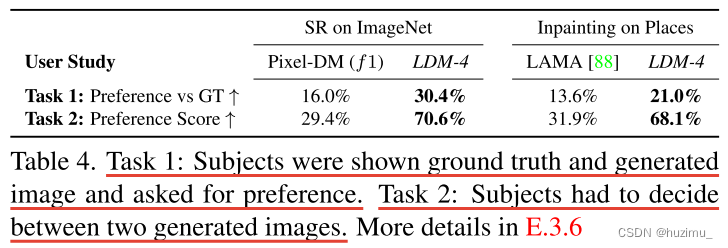

【论文阅读】High-Resolution Image Synthesis with Latent Diffusion Model

High-Resolution Image Synthesis with Latent Diffusion Model 引用: Rombach R, Blattmann A, Lorenz D, et al. High-resolution image synthesis with latent diffusion models[C]//Proceedings of the IEEE/CVF c

论文阅读:《High-Resolution Image Synthesis with Latent Diffusion Models》

High-Resolution Image Synthesis with Latent Diffusion Models 论文链接 代码链接 What’s the problem addressed in the paper?(这篇文章究竟讲了什么问题?比方说一个算法,它的 input 和 output 是什么?问题的条件是什么) 这篇文章提出了一种合成高分辨率图片的潜在空间扩散模型(LDM

深度学习中隐变量(latent variable)理解

假如有 x , y x,y x,y服从如下分布关系: 看起来像是3元混合高斯分布,比较复杂。 如果我们再引入隐变量 z z z,使得 z = z 1 z = z_1 z=z1时, x , y ∼ N ( μ 1 , Σ 1 ) x, y \sim N(\mu_1, \Sigma_1) x,y∼N(μ1,Σ1); z = z 2 z = z_2 z=z2时, x , y ∼ N ( μ 2

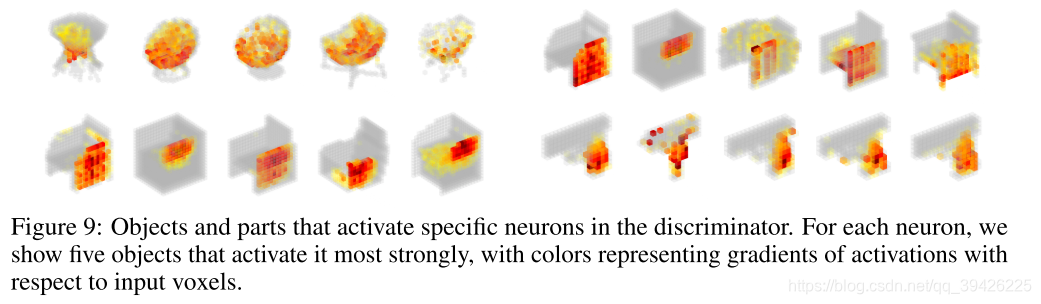

3D GAN:Learning a Probabilistic Latent Space of Object Shapes via 3D Generative-Adversarial Modeling

论文地址 一.Abstract 1.提出了一个新的框架,即3D生成对抗网络(3D- gan),它利用体卷积网络和生成对抗网络的最新进展,从概率空间生成三维对象. 2.首先,使用对抗准则代替传统的启发式准则,使生成器能够隐式地捕获对象结构,并同步大小相同的高质量3D对象. 3.生成器G建立了一个从低维概率空间到三维对象空间的映射,使我们可以在没有参考图像或CAD模型的情况下对对象进行采样,并探索

《Style Transformer: Unpaired Text Style Transfer without Disentangled Latent Representation》浅析

文章目录 摘要发展模型问题描述步骤模型训练机制 代码解析效果 摘要 传统的文本样式转换通常是通过分解隐空间中的内容和风格的方式。这种方式存在如下两种问题: 很难从句子的语义中完全剥离样式信息基于编解码器模式的RNN难以保持长程依赖,导致内容保真度有损 本文提出一种不用隐空间假设,基于注意力机制的模型——Style Transformer,能够较好的保持文本内容,同时很好的转

Constrained Graphic Layout Generation via Latent Optimization(2021)

[Paper] Constrained Graphic Layout Generation via Latent Optimization [Code] ktrk115/const_layout 通过潜在优化生成约束图形布局 摘要 在平面设计中,人类根据设计意图和语义在视觉上排列各种元素是很常见的。例如,标题文本几乎总是出现在文档中其他元素的顶部。在这项工作中,我们生成的图形布局可以灵活地

深入浅出 diffusion(5):理解 Latent Diffusion Models(LDMs)

如果你了解 diffusion 原理的话,那么理解 Latent Diffusion Models 的原理就比较容易。论文High-Resolution Image Synthesis with Latent Diffusion Models(Latent Diffusion Models)发表于CVPR2022,第一作者是Robin Rombach(慕尼黑大学)。 1. LDM

无监督学习 - 聚类的潜在语义分析(Latent Semantic Analysis,LSA)

什么是机器学习 潜在语义分析(Latent Semantic Analysis,LSA)是一种无监督学习方法,用于在文本数据中发现潜在的语义结构。LSA 的主要应用之一是进行文本文档的主题建模和信息检索。 以下是一个使用 Python 中的 scikit-learn 库来实现潜在语义分析(LSA)的简单教程。 步骤1: 导入库 import numpy as npfrom sklearn

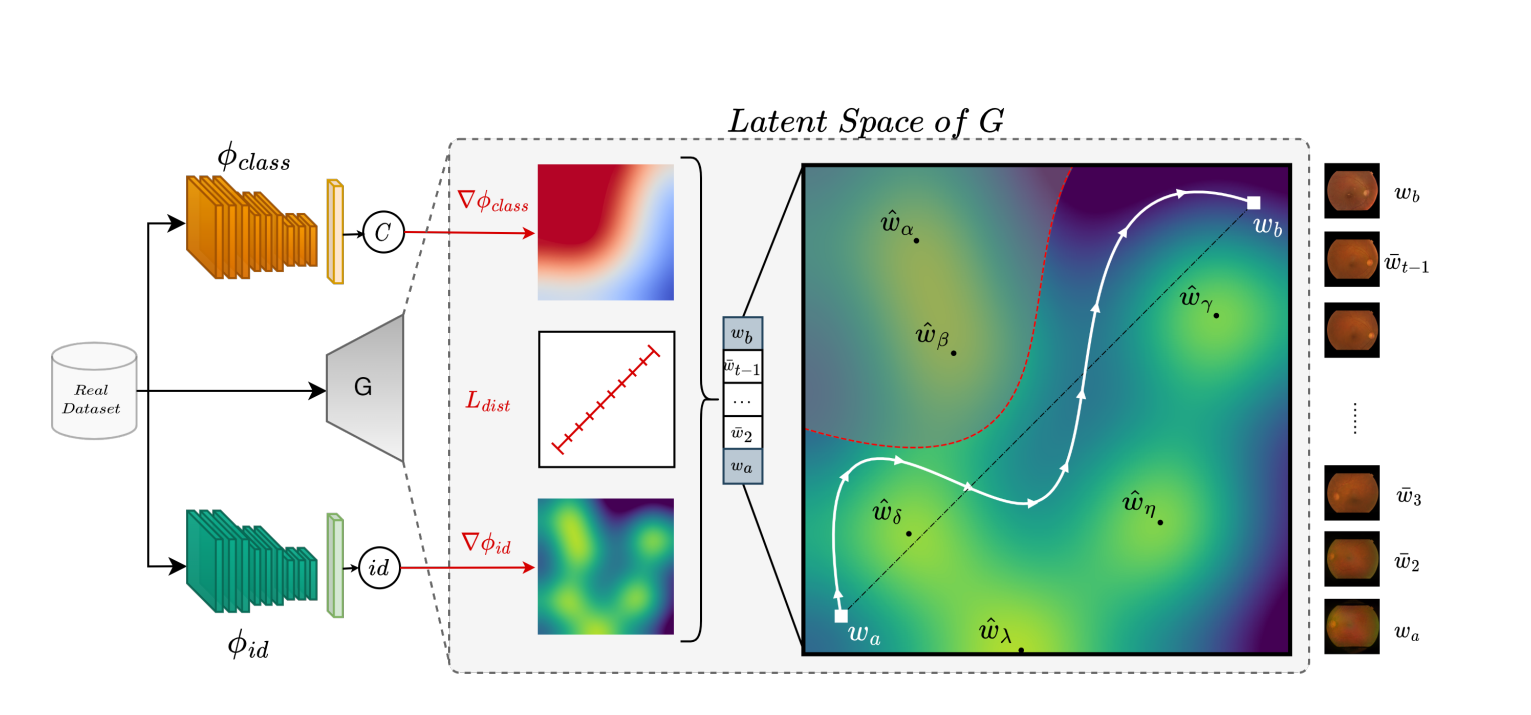

PLAN方法:解决 GAN 生成医学图像 Latent 空间中的隐私保护方法

PLAN方法:解决 GAN 生成医学图像 Latent 空间中的隐私保护方法 PLAN 原理StyleGAN 生成视网膜图k-SALSA 生成视网膜图PLAN方法 生成视网膜图 总结 PLAN 原理 论文:https://arxiv.org/abs/2307.02984 代码:https://github.com/perceivelab/PLAN 生成对抗网

Meta-Learning with Latent Embedding Optimization (LEO)论文阅读

1. 论文阅读 Meta-Learning with Latent Embedding Optimization该文是DeepMind提出的一种meta-learning算法,该算法是基于Chelsea Finn的MAML方法建立的,主要思想是:直接在低维的表示 z z z上执行MAML而不是在网络高维参数 θ \theta θ上执行MAML。 2. 模型及算法 如图所示,假设执行N-w

【论文阅读】Latent Consistency Models (LDMs)、LCM-LoRa

文章目录 IntroductionPreliminariesDiffusion ModelsConsistency Models Latent Consistency ModelsConsistency Distillation in the Latent SpaceOne-Stage Guided Distillation by Solving Augmented PF-ODEAccele

UNIFYING DIFFUSION MODELS’ LATENT SPACE, WITHAPPLICATIONS TO CYCLEDIFFUSION AND GUIDANCE [ICCV 2023]

论文链接https://arxiv.org/abs/2210.05559github链接https://github.com/ChenWu98/cycle-diffusion Abstract Diffusion models have achieved unprecedented performance in generative modeling. The commonly-adopted

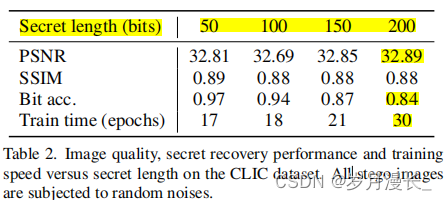

【论文阅读】RoSteALS: Robust Steganography using Autoencoder Latent Space-2023-CVPR

摘要 RoSteALS使用一个轻量级的秘密编码器将秘密信息映射到图像的潜空间中,并通过对潜空间进行微小的偏移来嵌入秘密信息。 该方法使用预训练的自编码器作为基础模型,不需要学习图像分布,因此训练过程简单且效果良好。 方法 架构图:训练期间只更新秘密编码器和秘密解码器,图像的编码器和解码器是锁定的 说明 使用自编码器VQGAN 利用编码器将秘密信息映射到图像的潜在层中, 使用Res50作

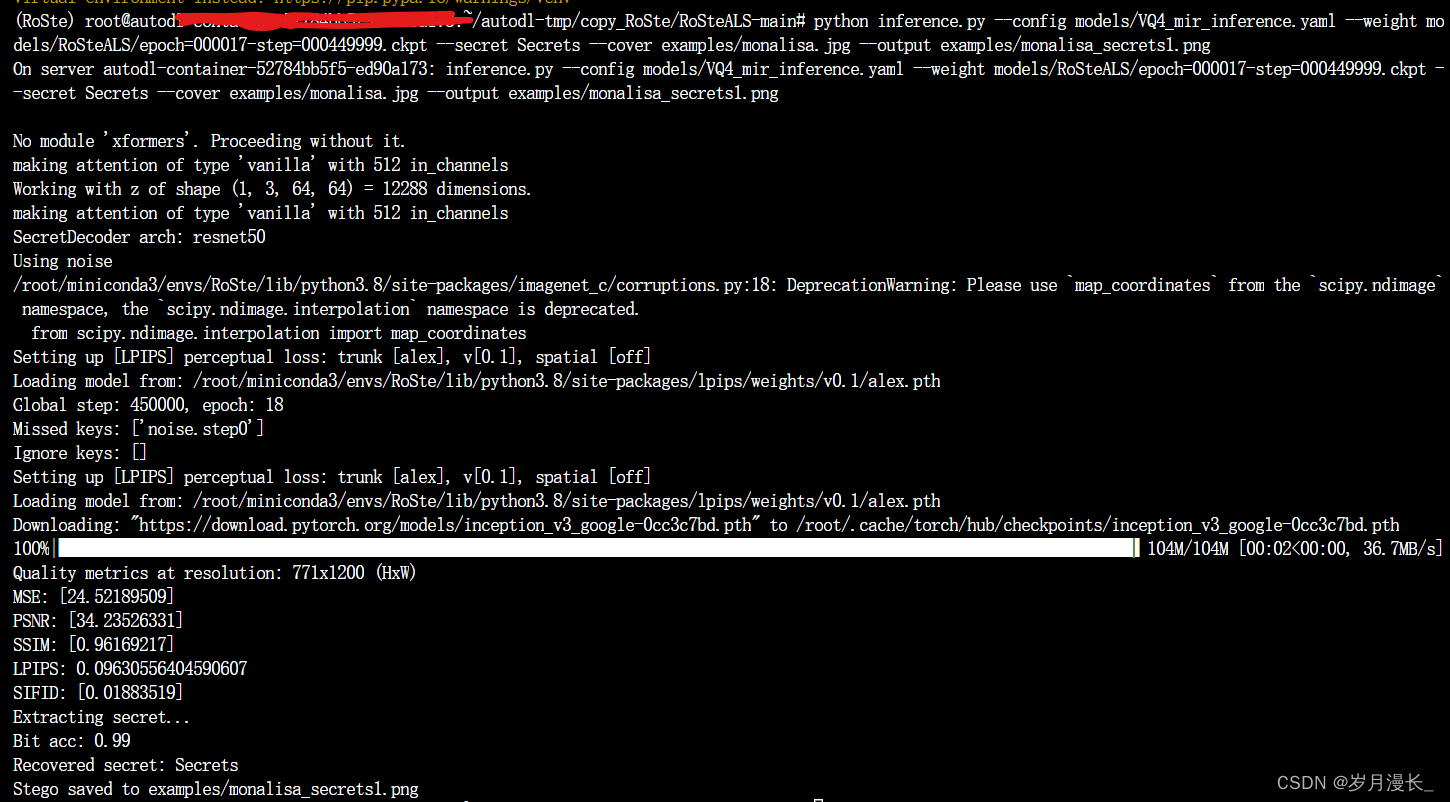

【论文复现】RoSteALS: Robust Steganography using Autoencoder Latent Space-2023-CVPR

代码链接:https://github.com/TuBui/RoSteALS 一定要按照dockerfile,requirements.txt和requirements2.txt配置环境 需要补充的库: pip安装:omegaconf slack slackclient bchlib (0.14.0版本) einops imagenet-c conda安装:scikit-image,matpl

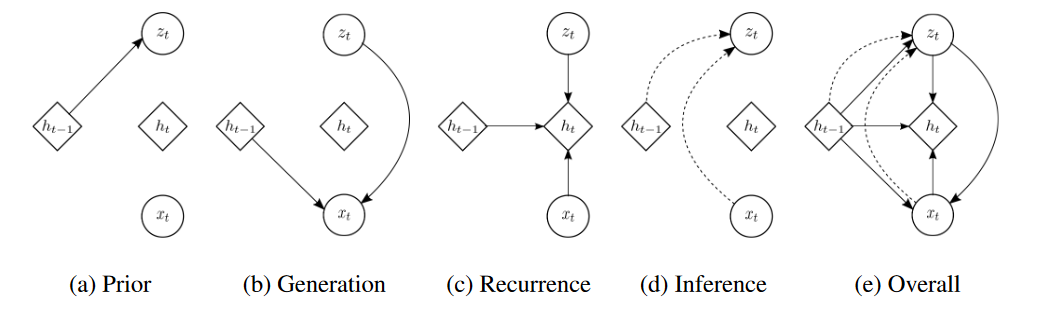

论文《A recurrent latent variable model for sequential data》笔记:详解VRNN

A recurrent latent variable model for sequential data 背景 1 通过循环神经网络的序列建模 循环神经网络(RNN)可以接收一个可变长度的序列 x = ( x 1 , x 2 , . . . , x T ) x = (x_1, x_2, ..., x_T) x=(x1,x2,...,xT)作为输入,并通过递归地处理每个符号同时维持其内

多视角-4-Latent Multi-view Subspace Clustering

Latent Multi-view Subspace Clustering Abstract1 Introduction2 Proposed Approach3 Optimization1. P-subproblem2. H-subproblem3. Z-subproblem4. E-subproblem5. J-subproblem6. Updating Multipliers 5 个人整

CVPR 2023 | 统一框架MAGE:表征学习超MAE,无监督图像生成超越Latent Diffusion

©作者 | 机器之心编辑部 来源 | 机器之心 在一篇 CVPR 2023 论文中,来自 MIT 和谷歌的研究人员提出了一种全新的框架 MAGE,同时在图像识别和生成两大任务上实现了 SOTA。 识别和生成是人工智能领域中的两大核心任务,如果能将二者合并到一个统一的系统中,这两个任务应该能实现互补。事实上,在自然语言处理中,像 BERT [1] 这样的模型不仅能够生成高质量的文本,还能够提取文

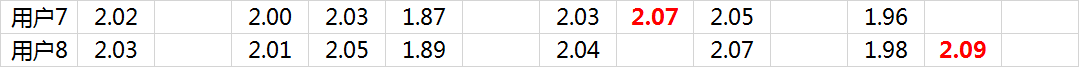

推荐算法之潜在因子(Latent Factor)算法

本文转自http://blog.163.com/l_greatsea/blog/static/204986044201531792747661/,所有权力归原作者所有。 本算法整理自知乎上的回答@nick lee 应用领域:“网易云音乐歌单个性化推荐”、“豆瓣电台音乐推荐”等。 这种算法是在NetFlix(没错,就是用大数据捧火《纸牌屋》的那家公司)的推荐算法竞赛中获奖的算法,最

![UNIFYING DIFFUSION MODELS’ LATENT SPACE, WITHAPPLICATIONS TO CYCLEDIFFUSION AND GUIDANCE [ICCV 2023]](https://img-blog.csdnimg.cn/daf073d0da914379bb1fbe5f7ab0986f.png)