focal专题

SPP/SPPF/Focal Module

一、在图像的分类任务重,卷积神经网络(CNN)一般含有5层: 输入层卷积层激活层池化层全连接层 · 全连接层通常要求输入为一维向量。在CNN中,卷积层和池化层的输出特征图会被展平(flatten)为一维向量,然后作为全连接层的输入。因此,全连接层对输入的尺寸有严格要求。 · 第一个全连接层的输入维度必须与前一层展平后的特征向量的长度一致,这就要求前面的卷积和池化层的输出特征图尺寸必须经过

Focal Loss实现

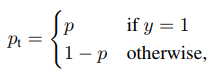

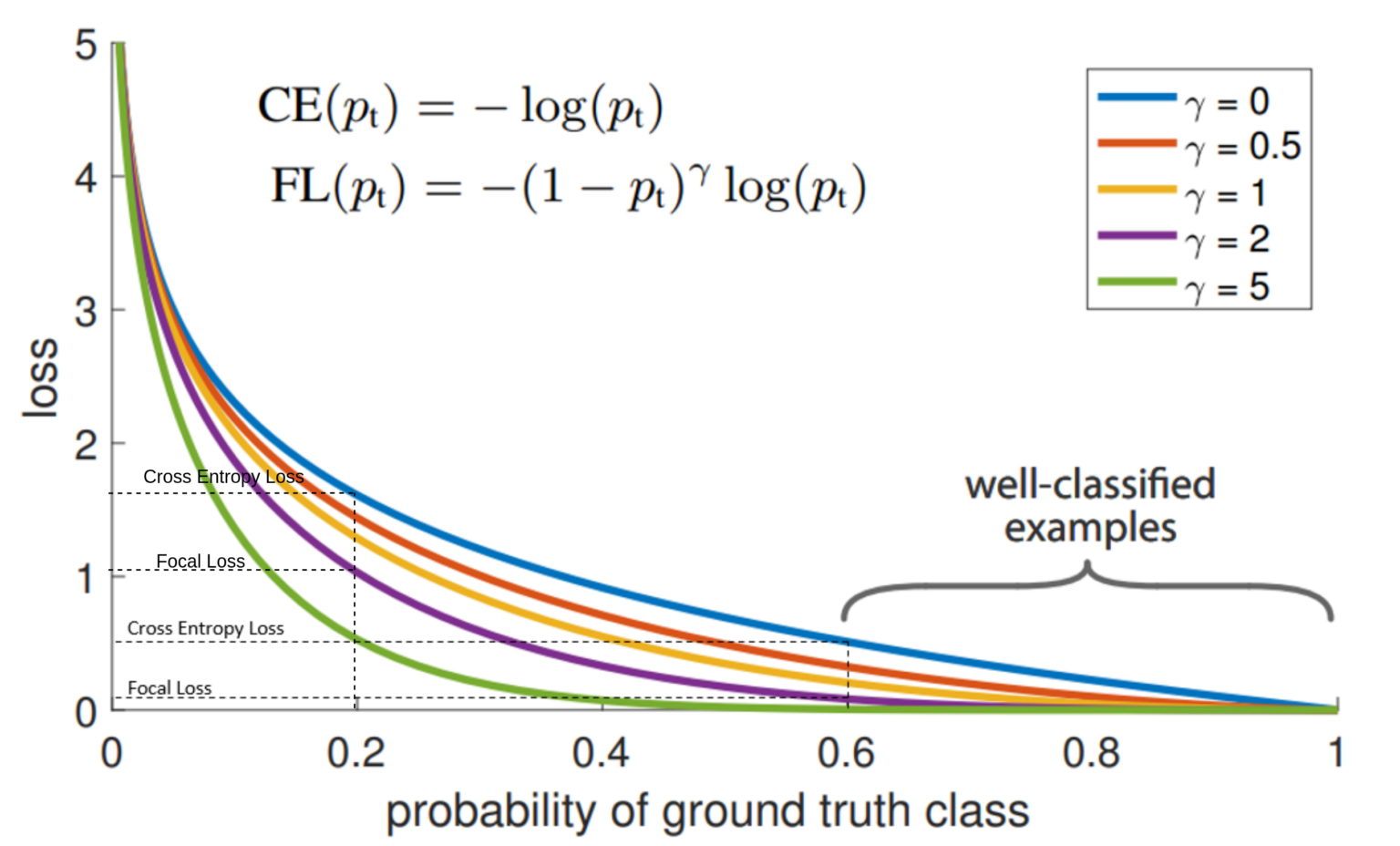

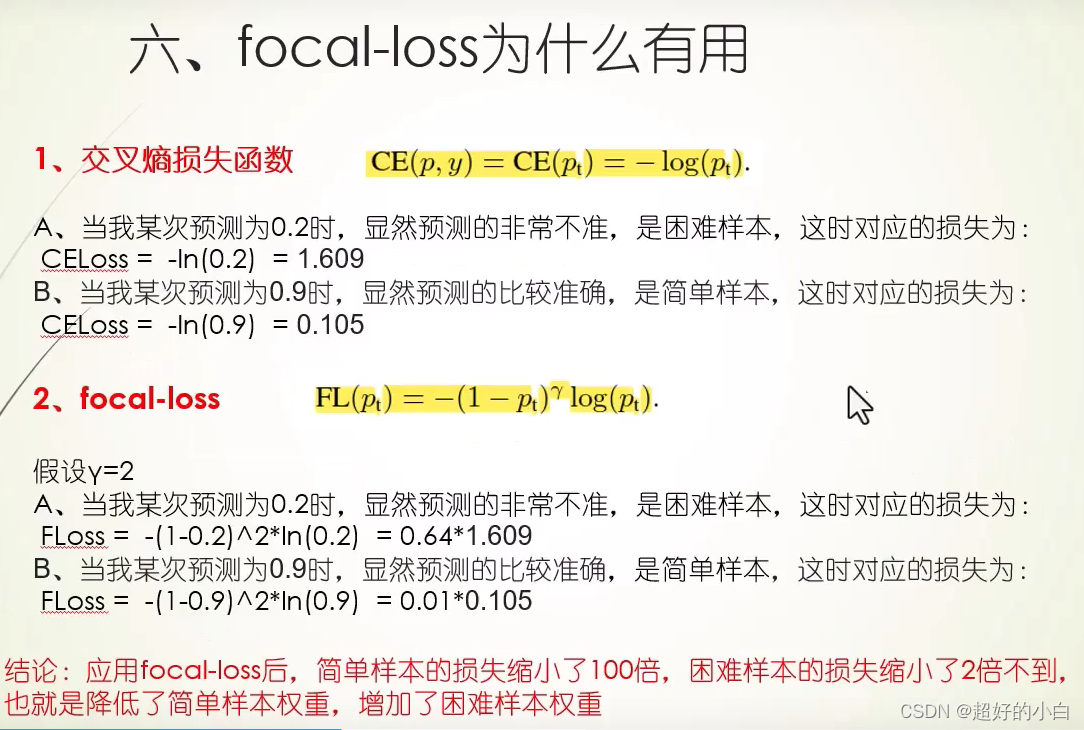

一、序言 Focal Loss是分类常用到的损失函数,面试中也经常容易考,所以这里记录一下。 二、公式和代码 公式: Focal Loss = -alpha*(1-pt)**gamma*log(pt) 其中alpha用来调节类别间的平衡,gamma用来平衡难例和简单例的平衡。 代码: import tor

CTC Loss和Focal CTC Loss

最近一直在做手写体识别的工作,其中有个很重要的loss那就是ctc loss,之前在文档识别与分析课程中学习过,但是时间久远,早已忘得一干二净,现在重新整理记录下 本文大量引用了- CTC Algorithm Explained Part 1:Training the Network(CTC算法详解之训练篇),只是用自己的语言理解了一下,原论文:Connectionist Temporal

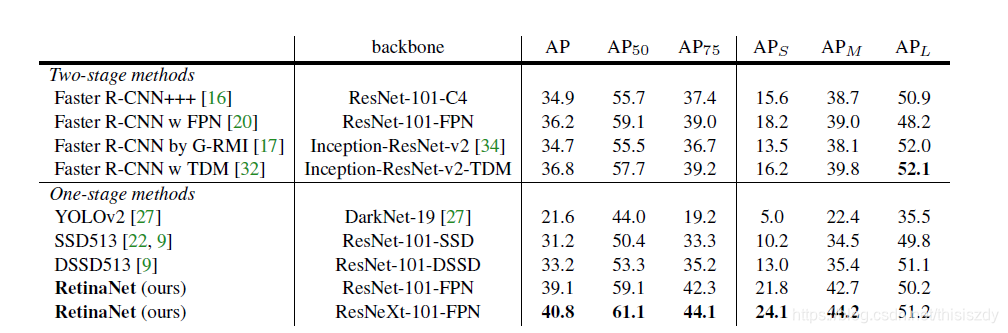

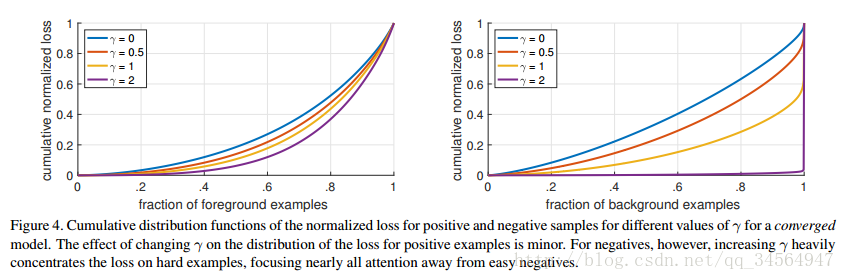

CV-笔记-RetinaNet和Focal Loss

目录 1 Focal Loss1.1 之前目标检测中解决样本不平衡的方法1.2 Focal loss1.2.1 普通的加权方式1.2.2 focal loss 2 RetinaNet2.1 FPN2.2 anchor2.3 打label2.4 分类分支2.5 回归分支2.6 推理阶段 Inference阶段 也就是预测阶段2.5 训练阶段2.5.1 参数初始化 网络训练细节 结果引用

【深度学习】Focal Loss 损失函数

Focal Loss 损失函数 1. Focal Loss 介绍2. 背景3. Focal Loss 定义(1) 交叉熵损失(2) 平衡因子 α t \alpha_t αt(3) 焦点因子 γ \gamma γ 4. 使用场景5. Focal Loss代码实现(Pytorch)6. 总结 1. Focal Loss 介绍 Focal Loss 是一种专门设计用于处理类别不平衡

Generalized Focal Loss:Focal loss魔改以及预测框概率分布,保涨点 | NeurIPS 2020

为了高效地学习准确的预测框及其分布,论文对Focal loss进行拓展,提出了能够优化连续值目标的Generalized Focal loss,包含Quality Focal loss和Distribution Focal loss两种具体形式。QFL用于学习更好的分类分数和定位质量的联合表示,DFL通过对预测框位置进行general分布建模来提供更多的信息以及准确的预测。从实验结果来看,GF

focal loss的几种实现版本(Keras/Tensorflow)

起源于在工作中使用focal loss遇到的一个bug,我仔细的学习多个靠谱的focal loss讲解及实现版本 通过测试,我发现了这样一个奇怪的现象,几乎每个版本的focal loss实现对同样的输入计算出的loss都是不同的。 通过仔细的比对和思考,我总结了三种我认为正确的focal loss实现方法,并将代码分享出来。 完整的代码我整理到了我的github代码库AI-Toolbox中,

torchvision笔记 torchvision.ops.sigmoid_focal_loss

理论部分:机器学习笔记:focal loss-CSDN博客 torchvision.ops.sigmoid_focal_loss(inputs: Tensor, targets: Tensor, alpha: float = 0.25, gamma: float = 2, reduction: str = 'none') inputs每个样本的预测值targets 与 inputs 形状相同

YOLO损失函数——SIoU和Focal Lossr损失函数解析

1. 概述 YOLO(You Only Look Once) 系列模型以其实时目标检测能力而闻名,其有效性在很大程度上归功于其专门设计的损失函数。在本文中,这里将深入探讨YOLO演进中不可或缺的各种YOLO损失函数,并重点介绍它们在PyTorch中的实现。 通过探索这些函数背后的代码,读者可以为自己的深度学习项目获得实用的见解,增强开发高级目标检测模型的能力。具体来说,这里将回顾在YOLOv

The Focal Easy Guide to Adobe Audition 2.0 (Focal Easy Guide)

版权声明:原创作品,允许转载,转载时请务必以超链接形式标明文章原始出版、作者信息和本声明。否则将追究法律责任。 http://blog.csdn.net/topmvp - topmvp Software packages are complex. Shouldn't software books make it easier? Simplify your life with the Foc

基于 parallels ubuntu 20.04 LTS (focal) 的ros+px4+gazebo 安装

系统环境: 主机环境macos 14.2.1 (23C71)、M1芯片Paralles商业版 19.1.0 (54729)ubuntuubuntu 20.04 LTS (focal)PX4v1.14.0ROS2foxy 虚拟机安装 1. 下载安装 parallels,参考评论; 2. 下载 ubuntu 镜像,使用 ubuntu 20.04 LTS (focal) arm 版本: ubu

目标检测之RetinaNet(Focal Loss)

一、目标检测之RetinaNet(Focal Loss) Focal Loss for Dense Object Detection 论文链接:https://arxiv.org/abs/1708.02002论文翻译:https://blog.csdn.net/PPLLO_o/article/details/88952923论文详解:https://blog.csdn.net/JNingWei

目标检测---IOU计算详细解读(IoU、GIoU、DIoU、CIoU、EIOU、Focal-EIOU、SIOU、WIOU)

常见IoU解读与代码实现 一、✒️IoU(Intersection over Union)1.1 🔥IoU原理☀️ 优点⚡️缺点 1.2 🔥IoU计算1.3 📌IoU代码实现 二、✒️GIoU(Generalized IoU)2.1 GIoU原理☀️优点⚡️缺点 2.2 🔥GIoU计算2.3 📌GIoU代码实现 三、✒️DIoU(Distance-IoU)3.1 DIoU原理☀

基于PaddlePaddle实现多分类的Focal Loss

论文:Focal Loss for Dense Object Detection 论文链接:https://arxiv.org/abs/1708.02002 在网上找了一下,有一位博主尝试写了一个,但是没有实现类别平衡。于是我继续了这位博主的工作,添加了类别平衡。在我的数据集上表现的很好。 这几天做一个图像分类的项目,每个标签的训练集数量差别很大,分类难易程度差别也很大,于是想用Focal

目标检测---IOU计算详细解读(IoU、GIoU、DIoU、CIoU、EIOU、Focal-EIOU、WIOU)

常见IoU解读与代码实现 一、✒️IoU(Intersection over Union)1.1 🔥IoU原理☀️ 优点⚡️缺点 1.2 🔥IoU计算1.3 📌IoU代码实现 二、✒️GIoU(Generalized IoU)2.1 GIoU原理☀️优点⚡️缺点 2.2 🔥GIoU计算2.3 📌GIoU代码实现 三、✒️DIoU(Distance-IoU)3.1 DIoU原理☀

Focal Modulation Networks聚焦调制网络

摘要 我们提出了 焦点调制网络 (简称 FocalNets) ,其中 自注意( SA )被 Focal Modulation 替换,这种机制 包括三个组件:( 1 )通过 depth-wise Conv 提取分级的上下文信息,同时编码短期和长期依赖;( 2 ) 门控聚合,基于每个 token 的内容选择性的聚集视觉上下文;( 3 )通过点乘或者仿射变换将汇集的信息 注入 query 。大量实验

Is desktop virtualization the next focal point?(桌面的虚拟化将是下一个关注点?)

Is desktop virtualization the next focal point? I’m still getting my feet under me after my travel to New England, New York and New Jersey this week. So, I’m going to post a few things conc

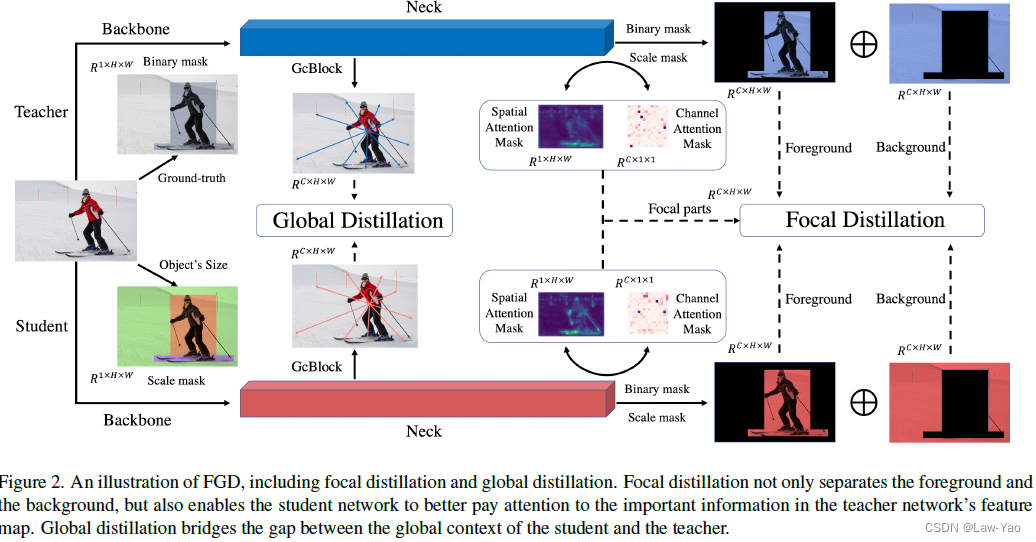

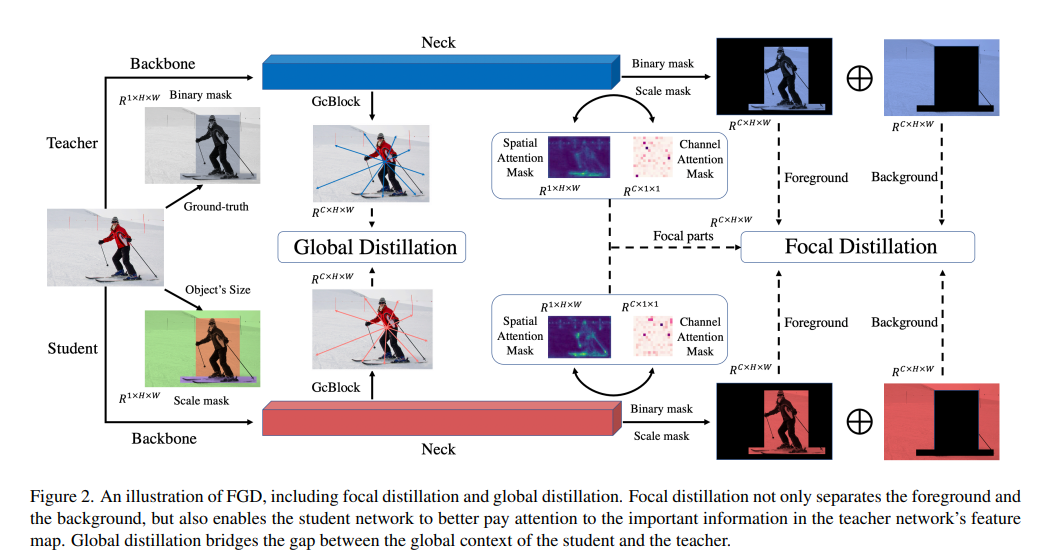

Focal and Global Knowledge Distillation——目标检测网络的知识蒸馏

Paper地址:https://arxiv.org/abs/2111.11837 GitHub链接:https://github.com/yzd-v/FGD 方法 FGKD(Focal and Global Knowledge Distillation)通过Focal distillation与Global distillation的结合,兼顾了Instance-level信息、Sp

Featured Based知识蒸馏及代码(3): Focal and Global Knowledge (FGD)

文章目录 1. 摘要2. Focal and Global 蒸馏的原理2.1 常规的feature based蒸馏算法2.2 Focal Distillation2.3 Global Distillation2.4 total loss 3. 实验完整代码 论文: htt

Focal Loss学习笔记

转自:https://blog.csdn.net/qq_34564947/article/details/77200104 Focal Loss for Dense Object Detection 引入问题 目前目标检测的框架一般分为两种:基于候选区域的two-stage的检测框架(比如fast r-cnn系列),基于回归的one-stage的检测框架(yolo,ssd这种),two-

【学习】focal loss 损失函数

focal loss用于解决正负样本的不均衡情况 通常我们需要预测的正样本要少于负样本,正负样本分布不均衡会带来什么影响?主要是两个方面。 样本不均衡的话,训练是低效不充分的。因为困难的正样本数量较少,大部分时间都在学习没有用的负样本。简单的负样本可能会压倒训练,导致训练退化。比如10000个人里面只有10个人为正义发声,其余的人都为邪恶发声,那么正义的声音就会被邪恶的声音淹没。 比如假如一张

视觉分类任务中处理不平衡问题的loss比较(OHEM、Focal Loss等介绍的非常好)

各类损失函数的优缺点介绍; 写的很好很赞; https://blog.csdn.net/weixin_35653315/article/details/78327408 侵删;

Generalized Focal Loss V1论文解读

摘要 单级检测器基本上将物体检测表述为密集分类和定位(即边界框回归)。分类通常通过Focal Loss进行优化,而边界框的定位通常根据Dirac delta分布进行学习。单级检测器的最新趋势是引入一个单独的预测分支来估计定位质量,预测质量有助于分类,从而提高检测性能。本文深入探讨了上述三个基本要素:质量估计、分类和定位的表示方法。在现有实践中发现了两个问题,包括:(1) 质量估计和分类在训练和推

Ubuntu 20.04 (Focal Fossa) 上安装RabbitMQ和Erlang,并配置管理员,并且修改数据目录

本脚本适用于在Ubuntu 20.04 (Focal Fossa) 上在线快速安装RabbitMQ和Erlang。 快速安装脚本: #!/bin/shsudo apt-get install curl gnupg apt-transport-https -y## Team RabbitMQ's main signing keycurl -1sLf "https://keys.openpgp.

Featured Based知识蒸馏及代码(3): Focal and Global Knowledge (FGD)

文章目录 1. 摘要2. Focal and Global 蒸馏的原理2.1 常规的feature based蒸馏算法2.2 Focal Distillation2.3 Global Distillation2.4 total loss 3. 实验完整代码 论文: htt

Featured Based知识蒸馏及代码(3): Focal and Global Knowledge (FGD)

文章目录 1. 摘要2. Focal and Global 蒸馏的原理2.1 常规的feature based蒸馏算法2.2 Focal Distillation2.3 Global Distillation2.4 total loss 3. 实验完整代码 论文: htt