本文主要是介绍基于PaddlePaddle实现多分类的Focal Loss,希望对大家解决编程问题提供一定的参考价值,需要的开发者们随着小编来一起学习吧!

论文:Focal Loss for Dense Object Detection

论文链接:https://arxiv.org/abs/1708.02002

在网上找了一下,有一位博主尝试写了一个,但是没有实现类别平衡。于是我继续了这位博主的工作,添加了类别平衡。在我的数据集上表现的很好。

这几天做一个图像分类的项目,每个标签的训练集数量差别很大,分类难易程度差别也很大,于是想用Focal Loss试一下,但是PaddlePaddle的函数库没有实现这个损失函数。

Focal Loss的理解可以看这一篇文章。

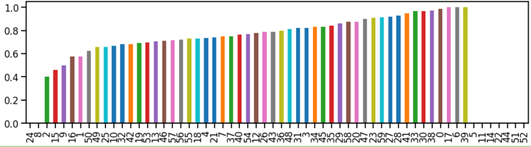

首先看一下使用Focal Loss之前的模型训练效果,分类很不平衡。

PaddlePaddle实现Focal Loss可以使用现有的op组合,也可以自己写一个op,后者难度较大,今天先使用现有的op,以后有时间再写op吧。

def focal_loss(pred, label, gama, alpha):one_hot = paddle.fluid.layers.one_hot(label, train_parameters['class_dim'])cross_entropy = one_hot * fluid.layers.log(pred)cross_entropy = fluid.layers.reduce_sum(cross_entropy, dim=-1)weight = -1.0 * one_hot * paddle.fluid.layers.pow((1.0 - pred), gama)weight = fluid.layers.reduce_sum(weight, dim=-1)ax = alpha * one_hotalph = fluid.layers.reduce_sum(ax, dim=-1)return alph * weight * cross_entropy

gama参数一般取2;

alpha参数的实现:

定义占位符

img = fluid.data(name='img', shape=[-1] + train_parameters['input_size'], dtype='float32')

label = fluid.data(name='label', shape=[-1, 1], dtype='int64')

falpha = fluid.data(name='falpha', shape=[-1,train_parameters['class_dim']], dtype='float32')

feeder = fluid.DataFeeder(feed_list=[img, label, falpha], place=place)

构建falpha参数

def get_focal_alpha():alpha = []value_count = train_parameters["label_img_count"] # 每个标签的训练集图片数量image_count = train_parameters["image_count"] # 训练集图片总数量for i in range(value_count.shape[0]):alpha.append(((image_count-value_count[i])/image_count*1000-997)/3)return alpha

focal_alpha = np.array(get_focal_alpha(),dtype=np.float32)

在训练模型的每一个batch,将原来的feed数据添加falpha之后feed进去

# 这里的data是batch_reader()得到的数据

new_data = []

for i in range(len(data)):new_item = data[0] + (focal_alpha,)new_data.append(new_item)del data[0]loss, acc1, pred = exe.run(main_program,feed=feeder.feed(new_data),fetch_list=train_fetch_list)

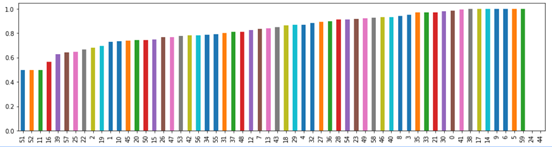

使用Focal Loss之后的分类结果

参考文章:

理解Focal Loss

实现不带类别平衡的Focal Loss

这篇关于基于PaddlePaddle实现多分类的Focal Loss的文章就介绍到这儿,希望我们推荐的文章对编程师们有所帮助!