conv2d专题

Tensorflow 中train和test的batchsize不同时, 如何设置: tf.nn.conv2d_transpose

大家可能都知道, 在tensorflow中, 如果想实现测试时的batchsize大小随意设置, 那么在训练时, 输入的placeholder的shape应该设置为[None, H, W, C]. 具体代码如下所示: # Placeholders for input data and the targetsx_input = tf.placeholder(dtype=tf.float32, s

AI学习记录 - 怎么理解 torch 的 nn.Conv2d

有用就点个赞 怎么理解 nn.Conv2d 参数 conv_layer = nn.Conv2d(in_channels=1, out_channels= 10 // 2, kernel_size=3, stride=2, padding=0, bias=False) in_channels in_channels 可以设置成1,2,3,4等等都可以,一般来说做图像识别的时候,先使用图片解析

解决:RuntimeError: “slow_conv2d_cpu“ not implemented for ‘Half‘的方法之一

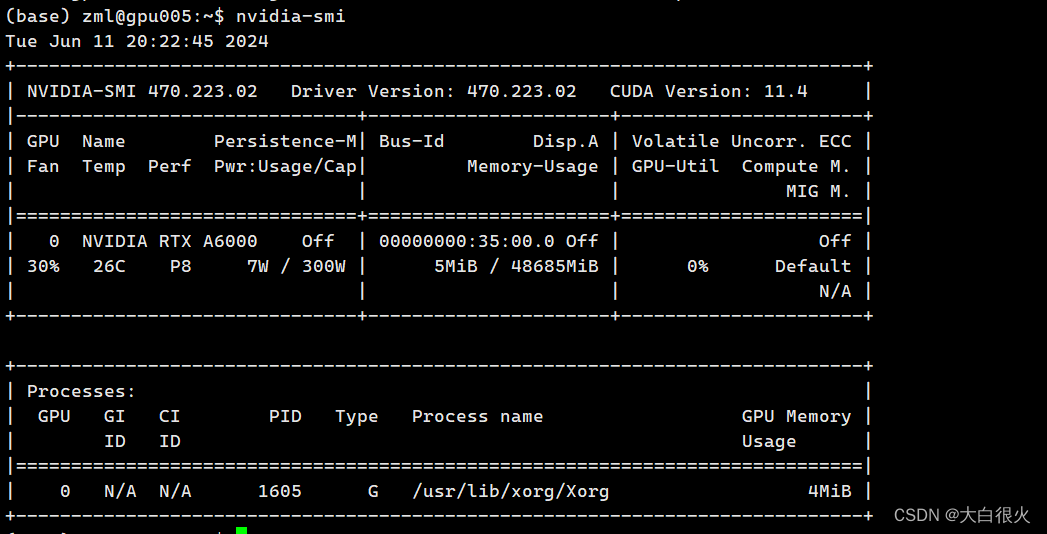

1. 问题描述 今天跑实验的时候,代码报错: RuntimeError: "slow_conv2d_cpu" not implemented for 'Half' 感觉有点莫名奇妙,经检索,发现将fp16改为fp32可以解决我的问题,但是运行速度太慢了。后来发现,是系统内核自动升级,导致显卡驱动与内核驱动不匹配。验证是否是该问题,可在命令行输入nvidia-smi来验证,若出现: NVI

Pytorch_nn.Conv2d

Conv2d torch.nn.Conv2d(in_channels, out_channels, kernel_size, stride=1, padding=0, dilation=1, groups=1, bias=True, padding_mode='zeros') in_channels 输入数据通道数out_channels 输出数据通道数kennel_size 卷积核大小,i

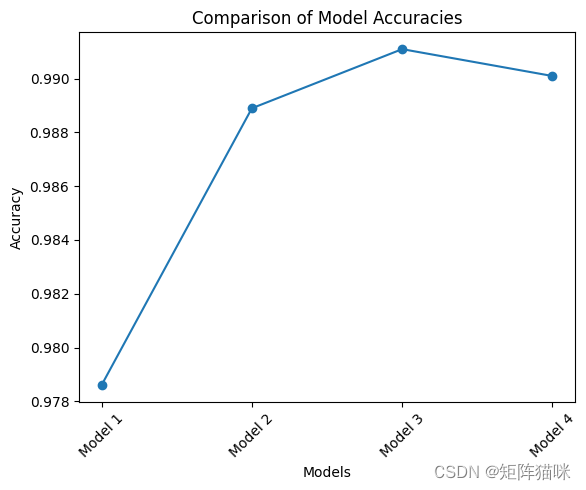

基于卷积神经网络CNN,使用二维卷积Conv2D实现MNIST数字识别的四种方法

前言 系列专栏:机器学习:高级应用与实践【项目实战100+】【2024】✨︎ 在本专栏中不仅包含一些适合初学者的最新机器学习项目,每个项目都处理一组不同的问题,包括监督和无监督学习、分类、回归和聚类,而且涉及创建深度学习模型、处理非结构化数据以及指导复杂的模型,如卷积神经网络、门控循环单元、大型语言模型和强化学习模型 使用 MNIST 数据集进行手写数字识别是一个借助神经网络完成的重

Tensorflow常用函数-tensorflow.nn.conv2d

tf.nn.conv2d(input=None, filters=None, strides=None, padding=None, use_cudnn_on_gpu=True, data_format=None, name=None) input:需要计算卷积的图像数据 [batch,height,width,channels] filters:卷积核 [height,width,chann

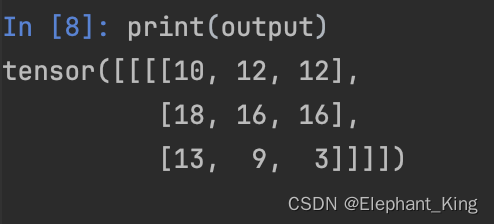

【Pytorch】6.torch.nn.functional.conv2d的使用

阅读之前应该先了解基础的CNN网络的逻辑 conv2d的作用 是PyTorch中用于执行二维卷积操作的函数。它的作用是对输入数据进行二维卷积操作,通常用于图像处理和深度学习中的卷积神经网络(CNN)模型。 conv2d的使用 我们先查看一下官方文档 input用于存放输入weight用于存放卷积核bias为偏置stride用于记录步长,默认为1,代表每次卷积计算后移动的步数

yolov3 代码中@wraps(Conv2D)的作用

标题yolov3 代码中@wraps(Conv2D)的作用 参考文献:https://blog.csdn.net/ltfdsy/article/details/81357280 在 keras-yolo3-master\yolo3\model.py 中,有如下代码: @wraps(Conv2D) def DarknetConv2D(*args, **kwargs): “”“Wrapper to

超平实版Pytorch CNN Conv2d

torch.nn.Conv2d 基本参数 in_channels (int) 输入的通道数量。比如一个2D的图片,由R、G、B三个通道的2D数据叠加。 out_channels (int) 输出的通道数量。 kernel_size (int or tuple) kernel(也就是卷积核,也可以称为filter)的形状 bias (bool

tf.nn.conv2d 你真的会用么

问题背景: 假如我现在有一个矩阵为image,卷积核为weight,卷积时不填充,则卷积后的结果为conv image =[[[[ 1. 2. 3. 4. 5.][ 6. 7. 8. 9. 10.][11. 12. 13. 14. 15.][16. 17. 18. 19. 20.][21. 22. 23. 24. 25.]][[26. 27. 28. 29. 30.][31.

torch.nn.Conv2d()与slim.conv2d()函数参数详解

目录 1. tf.nn.conv2d()函数1.1 input:1.2 filter:1.3 strides:1.4 padding: 2.tf.contrib.slim.conv2d()函数3. torch.nn.Conv2d()函数3.1 官方例子: 1. tf.nn.conv2d()函数 tensorflow构建网络模型时常用的卷积函数了,定义如下; conv2d(in

Pytorch——Conv2d、conv2d

Conv2d、conv2d是pytorch中进行卷积操作的2个类,虽然只是首字母大小写不同,使用起来方法也不一样,一个是类,一个是函数。 1 Conv2d Conv2d是torch.nn中的类 1.1 初始化 CLASStorch.nn.Conv2d(in_channels, out_channels, kernel_size, stride=1, padding=0, dilation

nn.Conv2d()中的groups分组参数

1.参考文章: 【Pytorch】搞懂nn.Conv2d的groups参数的作用 - 知乎 (zhihu.com) 2.理解: (1)只要你 明白了 多通道的卷积是如何实现的(可以看我的1X1卷积文章),那么这里的分组进行卷积就非常好理解了 核心:其实,虽然我们知道nn.Conv2d(in_fea,out_fea)就是从in_fea个channels 变成 out_fe

Keras 提示找不到该层ValueError: No such layer: conv2d_589

最近又用keras做了个迁移学习的任务,在设置输出层的时候出现了如题所示错误,明明我是根据打印出来的各层的name确定的输出层,怎么会没有该层呢,后来发现,每运行一次,layer.name值都会改变。建议以后用各层的index来替代各层的name: outputs=base_model.layers[22].output

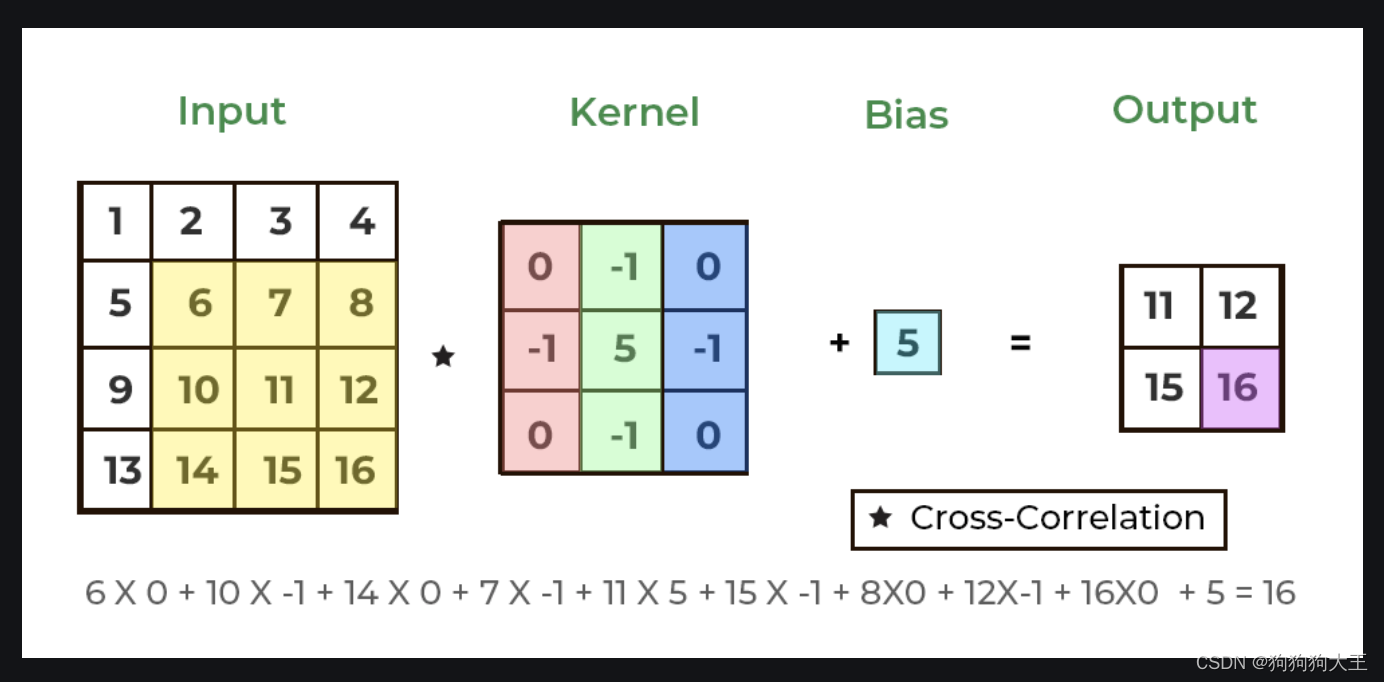

用猫狗分类的代码解释Conv2d()参数的应用

用猫狗分类的代码解释Conv2d()参数的应用 举个小例子先,由易到难,后面我会用猫狗分类的实例进一步讲解。(谢谢群里的fser和lk) 上面这个小案例转自https://www.cnblogs.com/expttt/p/12397330.html 让大家对Conv2d的参数有了初步的认识。进一步用语言描述一下: 输入的batch_size是2,通道数是1,图片的HW=73 使

tf.nn.conv2d函数讲解

因为又要用到conv2d函数,决定把每个参数都弄明白。转自:http://blog.csdn.net/mao_xiao_feng/article/details/53444333 tf.nn.conv2d是TensorFlow里面实现卷积的函数,参考文档对它的介绍并不是很详细,实际上这是搭建卷积神经网络比较核心的一个方法,非常重要 tf.nn.conv2d(input, f

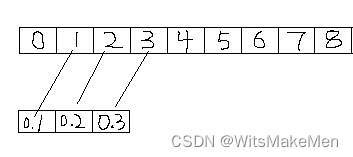

Pytorch卷积层原理和示例 nn.Conv1d卷积 nn.Conv2d卷积

内容列表 一,前提 二,卷积层原理 1.概念 2.作用 3. 卷积过程 三,nn.conv1d 1,函数定义: 2, 参数说明: 3,代码: 4, 分析计算过程 四,nn.conv2d 1, 函数定义 2, 参数: 3, 代码 4, 分析计算过程 一,前提 在开始前,要使用pytorch实现以下内容,需要掌握tensor和的用法 二,卷积层原理 1.概念 卷积层是用一个固定大小的矩形区

keras.layers.Conv2D() 函数参数

tf.keras.layers.Conv2D() 函数 Conv2D (二维卷积层) 这一层创建了一个卷积核,它与这一层的输入卷积以产生一个输出张量 当使用此层作为模型的第一层时,提供关键字参数 input_shape (整数元组,不包括样本轴,不需要写batch_size) def __init__(self, filters,kernel_size,strides=(1, 1),pad

PyTorch 中的nn.Conv2d 类

nn.Conv2d 是 PyTorch 中的一个类,代表二维卷积层(2D Convolution Layer)。这个类广泛用于构建卷积神经网络(CNN),特别是在处理图像数据时。 基本概念 卷积: 在神经网络的上下文中,卷积是一种特殊的操作,它通过一个卷积核(或滤波器)在输入数据(如图像)上滑动,计算卷积核与其覆盖的局部区域的点乘和。这个过程产生了一个特征图(Feature Map),捕捉了

AttributeError: 'Conv2d' object has no attribute 'padding_mode'问题解决

在一个预训练模型加载过程中,发现碰到这样的一个错误:AttributeError: 'Conv2d' object has no attribute 'padding_mode'。 找了相关资料,发现其问题为pytorch版本的问题,即原来的预训练模型为pytorch 1.0版本环境下训练编译的,而现在的开发环境为pytorch 1.1版本。 网上很多办法都是直接退回到pytorch1.0版本

关于CNN卷积神经网络与Conv2D标准卷积的重要概念

温故而知新,可以为师矣! 一、参考资料 深入解读卷积网络的工作原理(附实现代码) 深入解读反卷积网络(附实现代码) Wavelet U-net进行微光图像处理 卷积知识点 CNN网络的设计论:NAS vs Handcraft 二、卷积神经网络(CNN)相关介绍 1. CNN网络简介 1.1 CNN特征提取 学习输入到输出的映射,并对映射关系加以训练,训练好的模型也具备了这种映射能力。浅

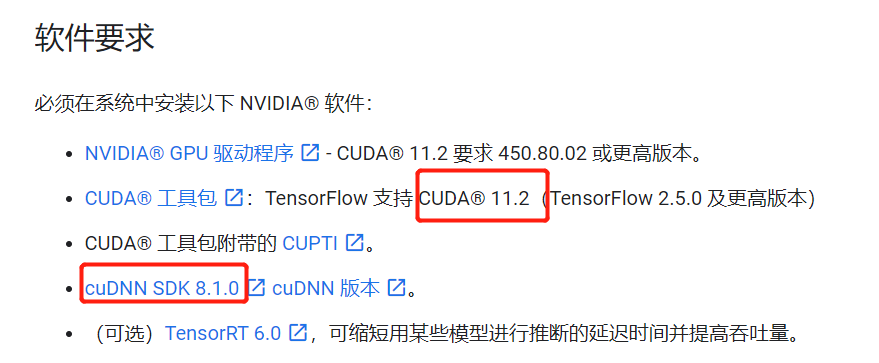

NotFoundError: No algorithm worked! when using Conv2D

NotFoundError: No algorithm worked! when using Conv2D 文章目录 NotFoundError: No algorithm worked! when using Conv2D报错信息系统及环境信息代码解决方案分析原因参考及引用 报错信息 2021-07-27 15:40:41.637309: W tensorflow/c

Node: ‘conv2d_transpose_1/conv2d_transpose/Conv2DBackpropFilter‘No algorithm worked Error messages

情况说明 用tensorflow在GPU上跑一个fit,模型里用到了两个卷积函数layers.Conv2D和layers.Conv2DTranspose epoch时出错,具体错误日志见下文,一开始Conv2D位置报错 解决过程 (1)搜索到一个类似的:No algorithm worked!,即代码开头加上以下设置 from tensorflow.config.experimental

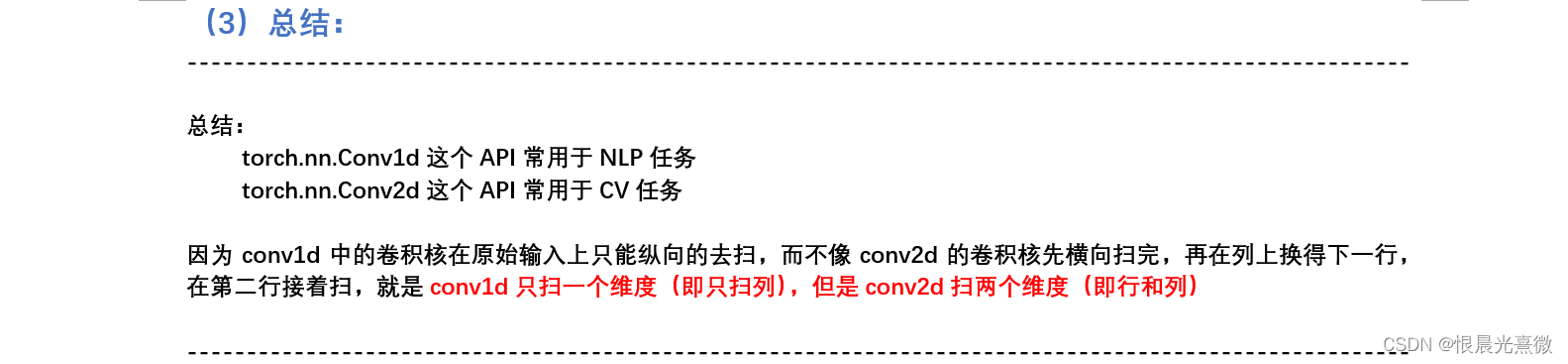

笔记69:Conv1d 和 Conv2d 之间的区别

笔记地址:D:\work_file\(4)DeepLearning_Learning\03_个人笔记\4. Transformer 网络变体 a a a a a a a a a a a