本文主要是介绍PyTorch 中的nn.Conv2d 类,希望对大家解决编程问题提供一定的参考价值,需要的开发者们随着小编来一起学习吧!

nn.Conv2d 是 PyTorch 中的一个类,代表二维卷积层(2D Convolution Layer)。这个类广泛用于构建卷积神经网络(CNN),特别是在处理图像数据时。

基本概念

-

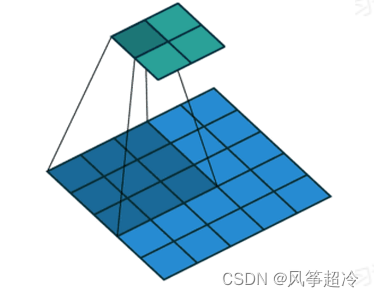

卷积: 在神经网络的上下文中,卷积是一种特殊的操作,它通过一个卷积核(或滤波器)在输入数据(如图像)上滑动,计算卷积核与其覆盖的局部区域的点乘和。这个过程产生了一个特征图(Feature Map),捕捉了输入数据的局部特征。

-

二维卷积: 图像是一个二维数组(对于彩色图像,有三个这样的数组,分别对应RGB通道),卷积核在这个数组上水平和垂直移动。

nn.Conv2d 的参数

nn.Conv2d 类接收几个重要的参数,下面是其中一些主要的:

-

in_channels (int): 输入数据的通道数。对于黑白图像通常是1,对于RGB图像是3。

-

out_channels (int): 输出的通道数,也就是卷积核的数量。每个卷积核提取输入数据的不同特征。

-

kernel_size (int 或 tuple): 卷积核的大小。可以是一个整数(对于正方形卷积核)或一个

(height, width)元组。 -

stride (int 或 tuple, 可选): 卷积核移动的步长。较大的步长会导致特征图的尺寸减小。

-

padding (int 或 tuple, 可选): 输入数据周围填充的零的数量。通常用于控制特征图的尺寸。

-

bias (bool, 可选): 是否添加偏置项。默认是

True。

使用 nn.Conv2d

当在PyTorch中创建一个 nn.Conv2d 实例时,它定义了一个可以应用于输入数据的卷积层。在神经网络中,这个层会自动学习卷积核的权重(和偏置项,如果有的话),这些权重决定了网络如何从输入数据中提取特征。

示例

import torch.nn as nn# 创建一个卷积层

# 输入通道数为3(RGB图像),输出通道数为32,卷积核大小为3x3

conv_layer = nn.Conv2d(in_channels=3, out_channels=32, kernel_size=3, stride=1, padding=1)

这个例子中创建的 conv_layer 可以在一个CNN中用于提取输入图像的特征。

这篇关于PyTorch 中的nn.Conv2d 类的文章就介绍到这儿,希望我们推荐的文章对编程师们有所帮助!