nn专题

pytorch之torch.flatten()和torch.nn.Flatten()的用法

《pytorch之torch.flatten()和torch.nn.Flatten()的用法》:本文主要介绍pytorch之torch.flatten()和torch.nn.Flatten()的用... 目录torch.flatten()和torch.nn.Flatten()的用法下面举例说明总结torch

Nn criterions don’t compute the gradient w.r.t. targets error「pytorch」 (debug笔记)

Nn criterions don’t compute the gradient w.r.t. targets error「pytorch」 ##一、 缘由及解决方法 把这个pytorch-ddpg|github搬到jupyter notebook上运行时,出现错误Nn criterions don’t compute the gradient w.r.t. targets error。注:我用

pytorch torch.nn.functional.one_hot函数介绍

torch.nn.functional.one_hot 是 PyTorch 中用于生成独热编码(one-hot encoding)张量的函数。独热编码是一种常用的编码方式,特别适用于分类任务或对离散的类别标签进行处理。该函数将整数张量的每个元素转换为一个独热向量。 函数签名 torch.nn.functional.one_hot(tensor, num_classes=-1) 参数 t

torch.nn 与 torch.nn.functional的区别?

区别 PyTorch中torch.nn与torch.nn.functional的区别是:1.继承方式不同;2.可训练参数不同;3.实现方式不同;4.调用方式不同。 1.继承方式不同 torch.nn 中的模块大多数是通过继承torch.nn.Module 类来实现的,这些模块都是Python 类,需要进行实例化才能使用。而torch.nn.functional 中的函数是直接调用的,无需

力士乐驱动主板CSB01.1N-SE-ENS-NNN-NN-S-N-FW

力士乐驱动主板CSB01.1N-SE-ENS-NNN-NN-S-N-FW 力士乐驱动器的使用说明主要涉及软件安装、参数配置、PID调节等方面。 软件安装:安装过程涉及多个步骤,首先需要打开安装文件夹中的CD1,双击setup.exe进行安装。在安装过程中,需要选择语言、接受许可协议、输入安装名称、选择安装目录等。整个安装过程可能需要10多分钟,取决于电脑性能。安装完成后,需要重启计算

Tensorflow 中train和test的batchsize不同时, 如何设置: tf.nn.conv2d_transpose

大家可能都知道, 在tensorflow中, 如果想实现测试时的batchsize大小随意设置, 那么在训练时, 输入的placeholder的shape应该设置为[None, H, W, C]. 具体代码如下所示: # Placeholders for input data and the targetsx_input = tf.placeholder(dtype=tf.float32, s

每天五分钟玩转深度学习PyTorch:nn.Module中封装好的神经网络层

本文重点 PyTorch实现了神经网络中绝大多数的layer,这些layer都继承于nn.Module,封装了可学习参数parameter,并实现了forward函数,且很多都专门针对GPU运算进行了CuDNN优化,其速度和性能都十分优异。本文介绍pytorch中已经封装好的神经网络层,我们可以直接通过nn.的方式来调用。本文主要学习第2步(模型搭建)。 全连接层 nn.Linear(i

深度学习-用神经网络NN实现足球大小球数据分析软件

文章目录 前言一、 数据收集1.1特征数据收集代码实例 二、数据预处理清洗数据特征工程: 三、特征提取四、模型构建五、模型训练与评估总结 前言 预测足球比赛走地大小球(即比赛过程中进球总数是否超过某个预设值)的深度学习模型是一个复杂但有趣的项目。这里,我将概述一个基本的实现流程,包括数据收集、特征提取、模型构建、训练和评估。由于直接编写完整的代码在这里不太现实,我将提供关键

tf.nn.embedding_lookup()用法

embedding_lookup( )的用法 关于tensorflow中embedding_lookup( )的用法,在Udacity的word2vec会涉及到,本文将通俗的进行解释。 首先看一段网上的简单代码: #!/usr/bin/env/python# coding=utf-8import tensorflow as tfimport numpy as npinput_ids =

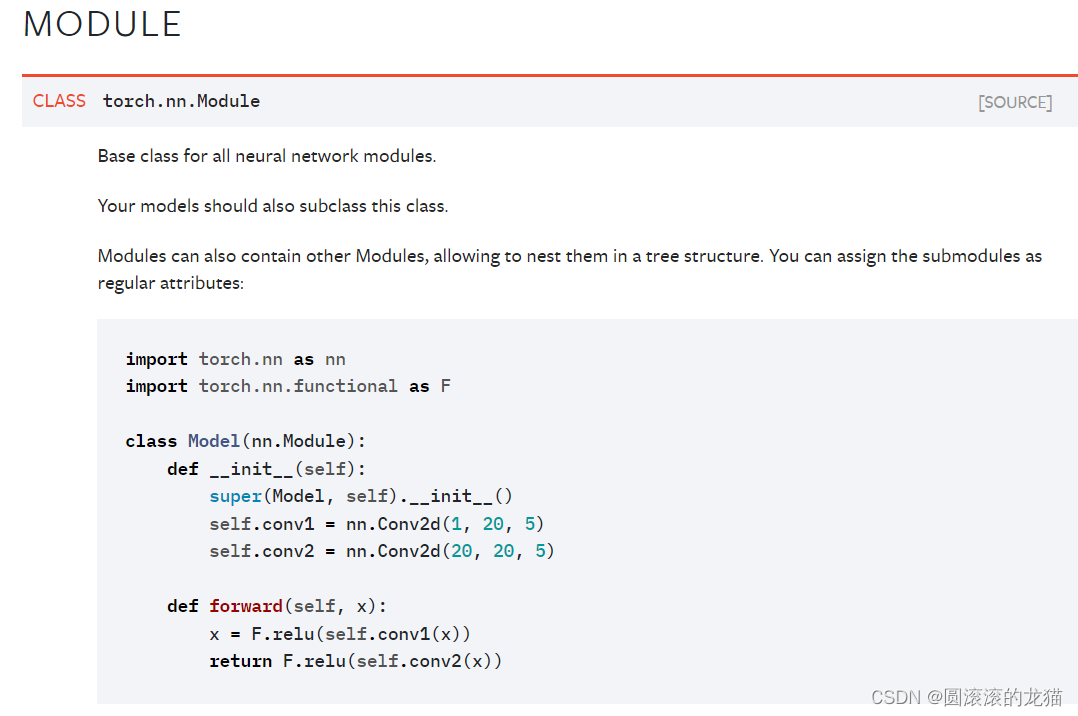

14.神经网络的基本骨架 - nn.Module 的使用

神经网络的基本骨架 - nn.Module 的使用 Pytorch官网左侧:Python API(相当于package,提供了一些不同的工具) 关于神经网络的工具主要在torch.nn里 网站地址:torch.nn — PyTorch 1.8.1 documentation Containers Containers 包含6个模块: ModuleSequentialModuleLi

PyTorch库学习之torch.nn.functional.interpolate(函数)

PyTorch库学习之torch.nn.functional.interpolate(函数) 一、简介 torch.nn.functional.interpolate 是 PyTorch 中用于对张量进行上采样或下采样的函数。它支持多种插值方法,例如双线性插值、最近邻插值等,广泛用于图像处理、特征图缩放等场景。 二、语法和参数 语法 torch.nn.functional.inte

【Pytorch】torch.nn.functional.normalize

目录 本质 官方参考 实例 本质 torch.nn.functional.normalize(input, p=2, dim=1, eps=1e-12, out=None) 本质上就是按照某个维度计算范数,p表示计算p范数(等于2就是2范数),dim计算范数的维度(这里为1,一般就是通道数那个维度) 官方参考 官方api:https://pytorch.org/doc

TORCH.NN.INIT权值初始化

https://pytorch.org/docs/stable/nn.init.html?highlight=orthogonal_#torch.nn.init.orthogonal_

Pythob PyTorch利用Torch.nn构建卷积神经网络

PyTorch利用Torch.nn构建卷积神经网络 一、概要 一、概要 1.需要声明的是构建卷积神经网络需要有一定的面向对象基础,因为所有建立的模型结构都是继承自nn.Module这个基类所完成的,面向对象的基础知识可以参考我之前的博客 面向对象基础 python 2.我们需要新建一个子类,并且构造函数和前向传播等方法需要被重写才能实现自己编写的网络 前向传播和反向传播原理 p

AI学习记录 - 怎么理解 torch 的 nn.Conv2d

有用就点个赞 怎么理解 nn.Conv2d 参数 conv_layer = nn.Conv2d(in_channels=1, out_channels= 10 // 2, kernel_size=3, stride=2, padding=0, bias=False) in_channels in_channels 可以设置成1,2,3,4等等都可以,一般来说做图像识别的时候,先使用图片解析

PyTorch nn.MSELoss() 均方误差损失函数详解和要点提醒

文章目录 nn.MSELoss() 均方误差损失函数参数数学公式元素版本 要点附录 参考链接 nn.MSELoss() 均方误差损失函数 torch.nn.MSELoss(size_average=None, reduce=None, reduction='mean') Creates a criterion that measures the mean squared err

PyTorch nn.CrossEntropyLoss() 交叉熵损失函数详解和要点提醒

文章目录 前置知识nn.CrossEntropyLoss() 交叉熵损失参数数学公式带权重的公式(weight)标签平滑(label_smoothing) 要点 附录参考链接 前置知识 深度学习:关于损失函数的一些前置知识(PyTorch Loss) nn.CrossEntropyLoss() 交叉熵损失 torch.nn.CrossEntropyLoss(weight=N

001 NN(Neural Network)起源

广义上说,NN(Neural Network)确实可以认为包含了CNN,RNN这些具体的变种形式。在实际应用中,所谓的深度神经网络DNN,往往融合了多种已知的结构,包含卷积层或是LSTM单元。 从起源理解NN: 20世纪五六十年代,叫做感知机(perceptron),拥有输入层,输出层和一个隐含层。输入的特征向量通过隐含层变换到达输出层,在输出层得到分类结果。但是会引发一些很严重问题,对

Python 求解级数$\sum_{n=1}^{\infty}\cfrac{\left(-1\right)^nx^n}{nn!}$的值

看这篇之前,推荐先看Python 计算(-1)^n * x^n / (n * n!)的值 这里我们求解一下如下级数的值: ∑ n = 1 ∞ ( − 1 ) n x n n

神经网络学习1—nn.Module

nn.module 为所有神经网络提供了一个模板 import torch.nn as nnimport torch.nn.functional as Fclass Model(nn.Module):def __init__(self):super(Model, self).__init__()self.conv1 = nn.Conv2d(1, 20, 5)self.conv2 = nn.C

【lightgbm/xgboost/nn代码整理三】keras做二分类,多分类以及回

【lightgbm/xgboost/nn代码整理三】keras做二分类,多分类以及回归任务 浏览更多内容,可访问:http://www.growai.cn 1.简介 该部分是比较基础的深度网络部分,是基于keras实现的多层感知机网络(mlp),使用nn个人感觉最大的一个好处就是目标函数自定义很方便,下面将从数据处理、网络搭建和模型训练三个部分介绍。如果只是想要阅读代码,可直接移步到尾部链接

【lightgbm, xgboost, nn代码整理一】lightgbm做二分类,多分类以及回归任务(含python源码)

lightgbm做二分类,多分类以及回归任务(含python源码) 浏览更多内容,可访问:http://www.growai.cn 1. 简介 内心一直想把自己前一段时间写的代码整理一下,梳理一下知识点,方便以后查看,同时也方便和大家交流。希望我的分享能帮助到一些小白用户快速前进,也希望大家看到不足之处慷慨的指出,相互学习,快速成长。我将从三个部分介绍数据挖掘类比赛中常用的一些方法,分别是l