本文主要是介绍斯坦福发布端侧AI模型Octopus V2:推理比GPT-4快168%,准确率超Llama7B,希望对大家解决编程问题提供一定的参考价值,需要的开发者们随着小编来一起学习吧!

斯坦福大学科研团队近期发布的Octopus V2端侧AI大模型犹如一颗璀璨的新星冉冉升起,凭借其卓越的性能和高效的推理能力,在业界引起了巨大轰动。

这款拥有20亿参数的端侧强大语言模型一亮相,便在开发者社群内迅速蹿红,首夜下载量即突破两千次大关,展现出前所未有的魅力。

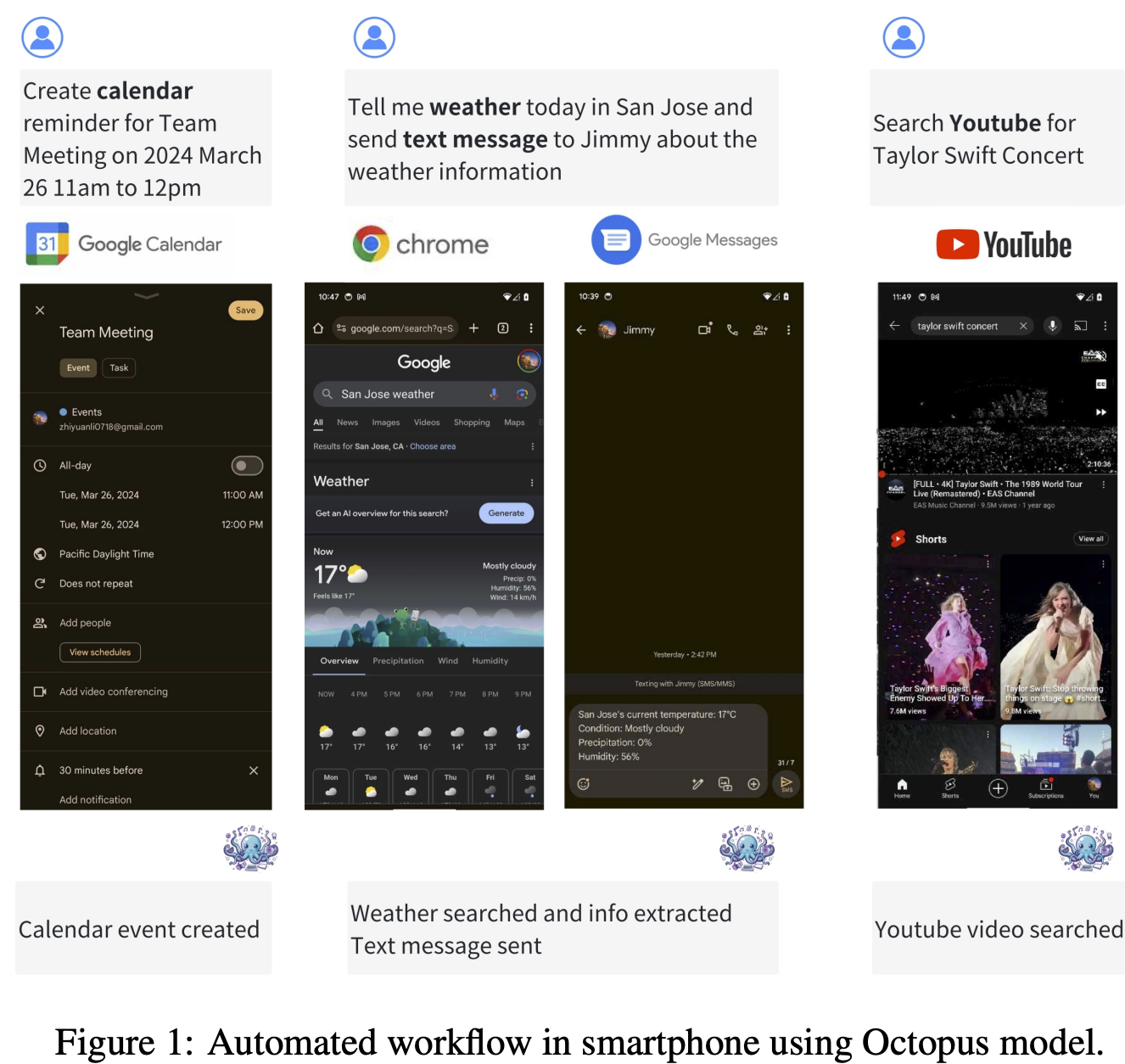

Octopus V2的独特之处在于其能在智能手机、汽车和个人电脑等多种终端设备上流畅运行,尤其在涉及自动化工作流的任务中,它能够灵活调用函数,堪称构建AI智能体的核心要素。

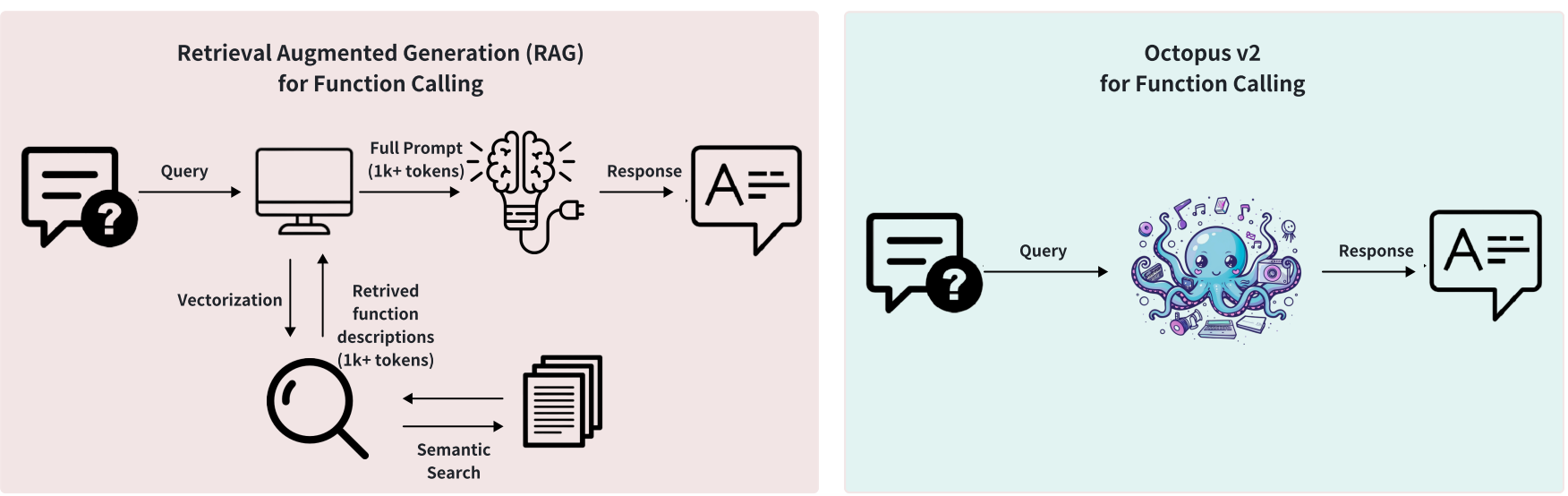

在性能层面上,Octopus V2在准确率和延迟上双双超越了炙手可热的GPT-4模型,而且大幅度缩减了上下文处理的长度,最高可达95%的压缩比例,大大提升了资源利用率。

相较于基于RAG函数调用机制的Llama7B模型,Octopus V2在响应速度上更是取得了惊人的飞跃,较之提升了36倍。这一卓越表现预示着一个崭新的设备端AI智能体时代已经来临。

相关链接

论文链接:https://arxiv.org/abs/2404.01744

体验链接:https://huggingface.co/NexaAIDev/Octopus-v2

论文阅读

语言模型已在各种软件应用程序中显示出有效性, 特别是与自动工作流程相关的任务。这些模型拥有 调用函数的关键能力,这对于创建人工智能代理至关重要。尽管云环境下大规模语言模型拥有高性能,它们是通常与对隐私和成本的担忧相关。当前设备上的型号函数调用面临延迟和准确性问题。

我们的研究提出了一个新的使具有20亿个参数的设备上模型能够超越GPT-4在准确性和延迟方面的性能,并减少上下文长度增加95%。与基于RAG的函数调用的Llama-7B机制相比,我们的方法将延迟提高了35倍。该方法减少了延迟达到适合在各种边缘设备上部署的水平生产环境,与现实世界应用程序的性能要求保持一致。

上图展示了使用Octopus模型的智能手机中的自动化工作流。

方法介绍

为了更好地适应移动设备的需求,研究团队专为Android系统打造了Octopus-V2-2B版本,力求在Android设备上实现无缝对接,应用场景涵盖了从系统管理到多设备协同工作的广泛领域。

Octopus-V2-2B展现出了在复杂场景下生成独立、嵌套和并行函数调用的能力,充分体现了模型的高度灵活性和实用性。

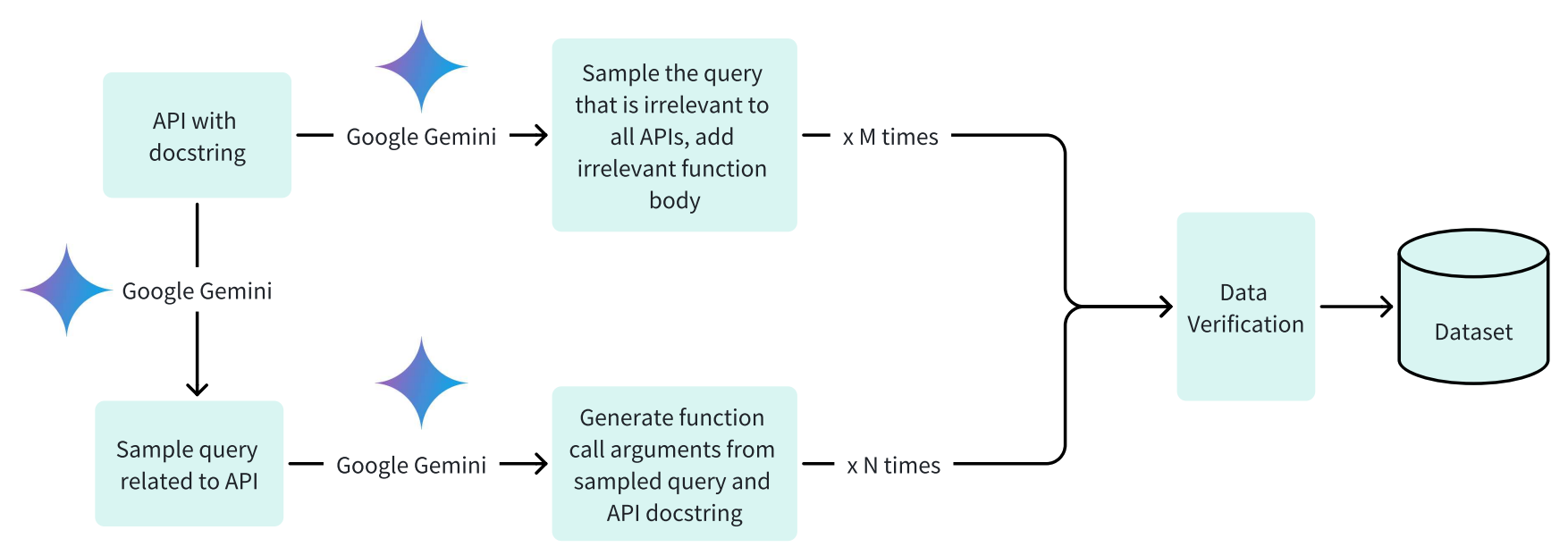

在模型训练与数据集构建方面,Octopus-V2-2B独树一帜地引入了功能Token策略,并将其贯穿于训练和推理全过程。研究团队通过精心设计的三步走策略构造高质量数据集:

-

首先生成与任务相关的查询及相应函数调用参数;

-

其次,利用适当函数组件生成无关查询以提高模型的区分能力;

-

最后,依托Google Gemini保障数据准确性和完整性。

实验期间,团队特意针对Android API进行深入研究,并以20个详尽描述为蓝本训练模型,其中一个实例便是用于根据分类、地理位置和语言筛选实时新闻。

模型细节

在模型开发和训练上,Octopus-V2-2B选用Google Gemma-2B作为预训练模型基础,并探索了完整模型训练和LoRA模型训练两种方式。两者均采用AdamW优化器,并精细调整学习率、warm-up步骤以及线性学习率调度器。特别是LoRA模型训练,还包括了特定模块和参数的定制化设置,以解决传统RAG方法中可能存在的大量函数参数输入问题。

实验对比

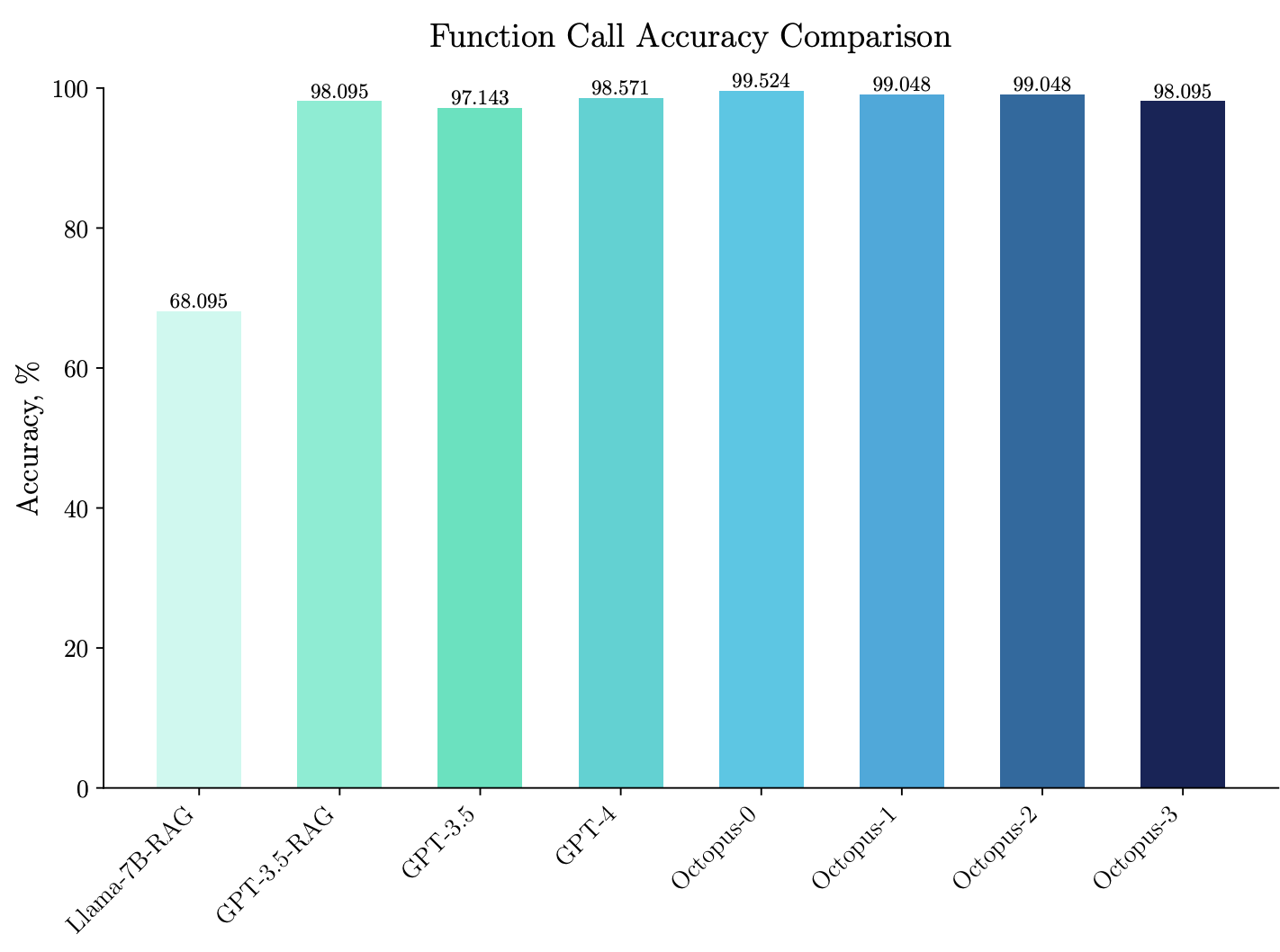

上图展示了基准精度分析包括使用RAG的lama-7b,使用RAG的GPT-3.5, GPT-3.5, GPT-4和Octopus系列为Octopus-0, Octopus-1, Octopus2和Octopus-3。

Octopus模型之间的区别来自于数据集的大小和训练方法。最初的Octopus-0模型是使用1K数据的全模型方法进行训练的每个API的点数。Octopus-1虽然每个API也使用1K个数据点,但使用LoRA进行训练。Octopus-1,Octopus-2遵循完整的模型训练,但减少了数据点分别是500和100。

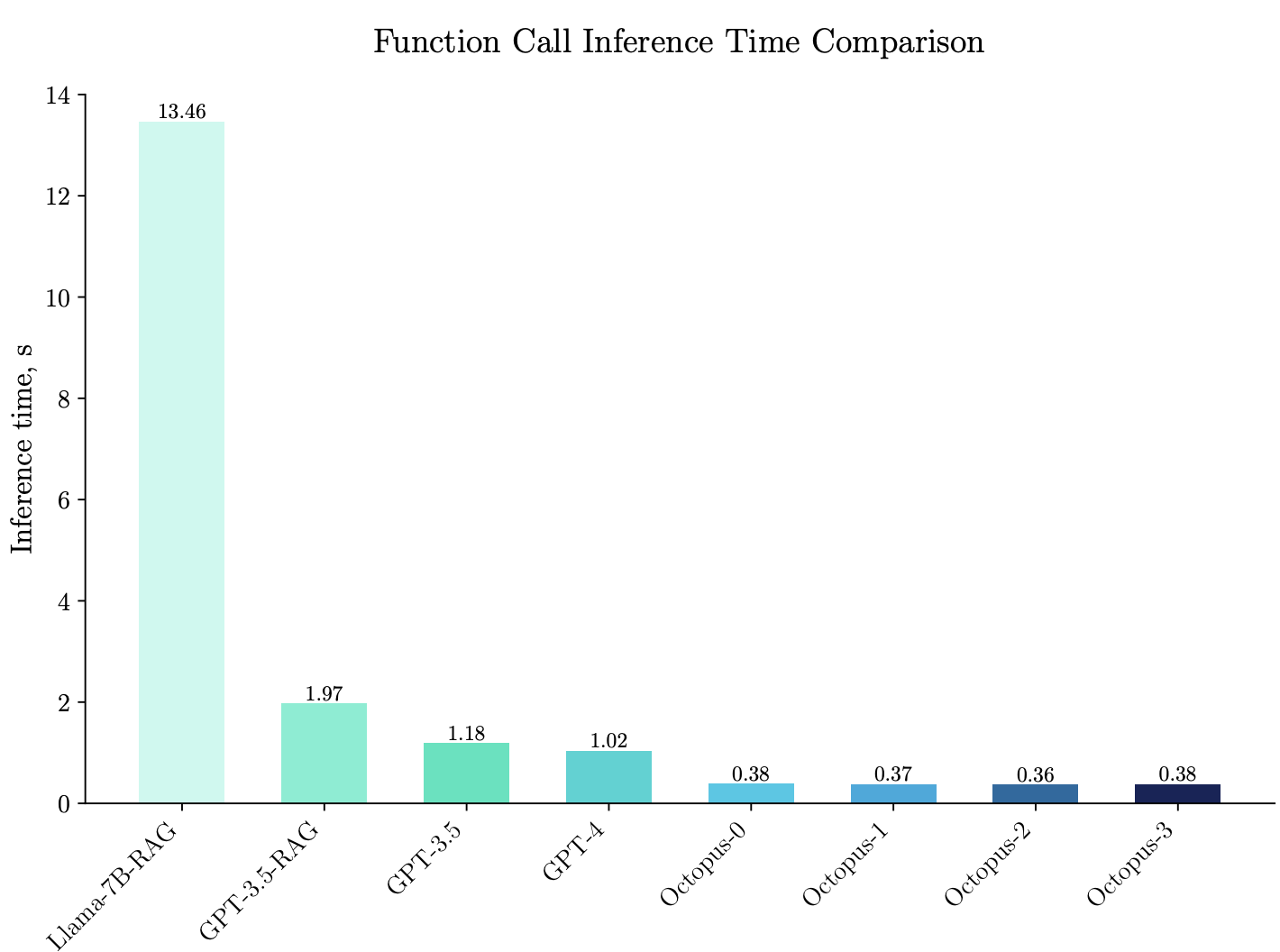

上图为基准模型的延迟分析包括带有RAG的Llama-7B和GPT-3.5, GPT-3.5, GPT-4,Octopus系列型号,标记为Octopus-0,Octopus-1, Octopus2号和Octopus3号。Octopus模型之间的区别来自于数据集大小和训练方法。原始的Octopus-0模型是使用完整模型方法进行训练的,每个API 1K数据点。Octopus-1在每个API也使用1K个数据点的同时,使用LoRA方法。Octopus-2和Octopus-3遵循完整的模型训练,但减少了数据 分别为500分和100。

总结

Octopus V2端侧AI模型的诞生无疑是人工智能技术发展的一大里程碑,其在保证高精度的同时大幅提升了推理速度,为移动端智能应用带来了无限可能性。通过深入洞察与技术创新,斯坦福大学的研究团队成功推动了端侧AI模型的发展,有力促进了人工智能技术在更多终端设备上的广泛应用,也为企业和个人提供了更为普惠、高效的人工智能解决方案。

这篇关于斯坦福发布端侧AI模型Octopus V2:推理比GPT-4快168%,准确率超Llama7B的文章就介绍到这儿,希望我们推荐的文章对编程师们有所帮助!