推理专题

PyInstaller问题解决 onnxruntime-gpu 使用GPU和CUDA加速模型推理

前言 在模型推理时,需要使用GPU加速,相关的CUDA和CUDNN安装好后,通过onnxruntime-gpu实现。 直接运行python程序是正常使用GPU的,如果使用PyInstaller将.py文件打包为.exe,发现只能使用CPU推理了。 本文分析这个问题和提供解决方案,供大家参考。 问题分析——找不到ONNX Runtime GPU 动态库 首先直接运行python程序

【有啥问啥】大模型应用中的哈希链推理任务

大模型应用中的哈希链推理任务 随着人工智能技术的快速发展,尤其是大模型(如GPT、BERT、Vision Transformer等)的广泛应用,确保数据处理和模型推理的透明性与安全性变得愈发重要。哈希链推理任务作为一种技术手段,能够在大模型应用中保障数据的完整性和推理过程的可信性。本文将深入探讨哈希链推理任务的数学基础、技术细节、应用场景,并展望未来发展趋势。 一、哈希链与哈希链推理任务

yolov8-obb旋转目标检测onnxruntime和tensorrt推理

onnxruntime推理 导出onnx模型: from ultralytics import YOLOmodel = YOLO("yolov8n-obb.pt") model.export(format="onnx") onnx模型结构如下: python推理代码: import cv2import mathimport numpy as npimport onnxr

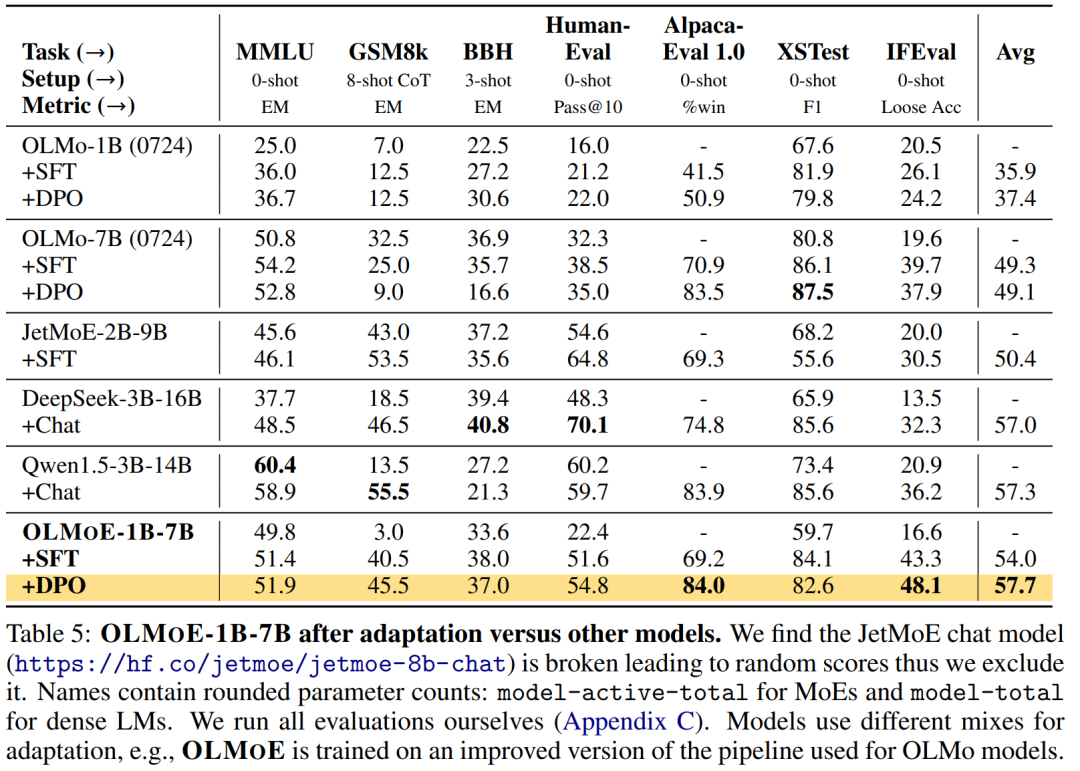

第一个100%开源的MoE大模型,7B的参数,1B的推理成本

尽管大语言模型 (LM) 在各种任务上取得了重大进展,但在训练和推理方面,性能和成本之间仍然需要权衡。 对于许多学者和开发人员来说,高性能的 LM 是无法访问的,因为它们的构建和部署成本过高。改善成本 - 性能的一种方法是使用稀疏激活混合专家 (MoE)。MoE 在每一层都有几个专家,每次只激活其中的一个子集(参见图 2)。这使得 MoE 比具有相似参数量的密集模型更有效,因为密集模型为每个

3天把Llama训成Mamba,性能不降,推理更快!

近日,Mamba方面又搞出了有意思的研究:来自康奈尔、普林斯顿等机构的研究人员成功将Llama提炼成了Mamba模型,并且设计了新的推测解码算法,加速了模型的推理。\ 先来看一张其乐融融的图片(一眼AI): 右边的小羊驼代表Llama,而左边的蛇(Mamba)也是我们的老熟人了。 至于到底能不能其乐融融,咱就不管了,之所以有此场景,是因为Mamba方面又搞出了有意思的研究: ——如何把

深度学习|模型推理:端到端任务处理

引言 深度学习的崛起推动了人工智能领域的诸多技术突破,尤其是在处理复杂数据与任务的能力方面。模型推理作为深度学习的核心环节,决定了模型在真实应用场景中的表现。而端到端任务处理(End-to-End Task Processing)作为深度学习的一种重要范式,通过从输入到输出的直接映射,显著提升了任务处理的效率和精度。在传统机器学习中,特征提取、数据清理、模型选择等步骤需要独立处理,过程繁琐且

pytorch pyro 贝叶斯神经网络 bnn beyesean neure network svi 定制SVI目标和培训循环,变更推理

定制SVI目标和培训循环¶ Pyro支持各种基于优化的贝叶斯推理方法,包括Trace_ELBO作为SVI(随机变分推理)的基本实现。参见文件(documents的简写)有关各种SVI实现和SVI教程的更多信息I, 二,以及罗马数字3了解SVI的背景。 在本教程中,我们将展示高级用户如何修改和/或增加变分目标(或者:损失函数)以及由Pyro提供的训练步骤实现,以支持特殊的用例。 基本SVI用

论文速读|ROS-LLM:具有任务反馈和结构化推理的具身智能ROS 框架

论文地址:https://arxiv.org/pdf/2406.19741 ROS-LLM 框架旨在通过集成大型语言模型(LLM)和机器人操作系统(ROS),实现对机器人的直观编程。该框架支持通过聊天界面接收自然语言提示,并能够根据 ROS 环境中的传感器读数自动提取和执行行为。框架支持三种行为模式:序列、行为树和状态机。此外,通过模仿学习,用户可以向系统添加新的机器人动作。该研究通过实验

vllm源码解析(一):整体架构与推理代码

vlllm官方代码更新频发,每个版本都有极大变动, 很难说哪个版本好用. 第一次阅读vllm源码是0.4.0版本,对这版圈复杂度极高的调度代码印象深刻 0.4.1对调度逻辑进行重构,完全大变样, 读代码速度快赶不上迭代的速度了。 现在已经更新到0.5.4, 经过长时间观察,发现主要的调度逻辑基本也稳定了下来, 应该可以作为一个固话的版本去阅读。 本文解读依据vllm 0.5.4版本. 没有修改任

Qwen-7B-Chat大模型安装训练推理-helloworld

初始大模型之helloworld编写 开发环境:modelscope GPU版本上测试的,GPU免费36小时 ps:可以不用conda直接用环境自带的python环境使用 魔搭社区 安装conda wget https://repo.anaconda.com/miniconda/Miniconda3-latest-Linux-x86_64.sh 1.2 bash Minicond

使用docker部署tensorrtllm推理大模型baichuan2-7b

简介 大模型的推理框架,我之前用过vllm和mindie。近期有项目要用tensorrtllm,这里将摸索的过程记录下,特别是遇到的问题。 我的环境是Linux+rt3090 准备docker环境 本次使用docker镜像部署,需要从网上拉取: docker pull nvcr.io/nvidia/tritonserver:24.08-trtllm-python-py3 The Tri

【Python机器学习】词向量推理——词向量

目录 面向向量的推理 使用词向量的更多原因 如何计算Word2vec表示 skip-gram方法 什么是softmax 神经网络如何学习向量表示 用线性代数检索词向量 连续词袋方法 skip-gram和CBOW:什么时候用哪种方法 word2vec计算技巧 高频2-gram 高频词条降采样 负采样 如何使用gensim.word2vec模块 生成定制化词向量表示 预

YOLOV----- ONNX 推理过程、可视化图片、保存检测到的目标

一、代码 import osimport cv2import numpy as npimport onnxruntimeimport timeCLASSES = ['person'] # coco80类别class YOLOV5():def __init__(self, onnxpath):self.onnx_session = onnxruntime.InferenceSession

Transformer直接预测完整数学表达式,推理速度提高多个数量级

前言 来自 Mata AI、法国索邦大学、巴黎高师的研究者成功让 Transformer 直接预测出完整的数学表达式。 转载自丨机器之心 符号回归,即根据观察函数值来预测函数数学表达式的任务,通常涉及两步过程:预测表达式的「主干」并选择数值常数,然后通过优化非凸损失函数来拟合常数。其中用到的方法主要是遗传编程,通过多次迭代子程序实现算法进化。神经网络最近曾在一次尝试中预测出正确的表达式主干,

理解大模型中的Cursor技术:优化长文本推理的前沿方案

理解大模型中的Cursor技术:优化长文本推理的前沿方案 随着自然语言处理(NLP)领域的快速发展,大型语言模型(如GPT系列)已广泛应用于文本生成、对话系统和复杂推理任务。然而,随着文本长度的增加,模型在处理长文本时面临的挑战也日益凸显。本文将详细探讨大模型中的Cursor技术,并分析其在长文本推理中的优势和应用。 背景:长文本处理中的挑战 Transformer架构是目前主流的大型语

使用ROCm和AMD GPU进行机器学习基准测试:复现我们的MLPerf推理提交

Benchmarking Machine Learning using ROCm and AMD GPUs: Reproducing Our MLPerf Inference Submission — ROCm Blogs 简介 衡量新技术的性能是自古以来的一种实验,常常引人入胜(例如,我们仍然用马力来比较新电动汽车电机的性能)。在迅速发展的机器学习(ML)领域,MLPerf在2018年5月2

对话系统概述:问答型(直接根据用户的问题给出精准的答案,更接近一个信息检索的过程;单轮;上下文无关)、任务型(多轮对话、针对特定场景)、闲聊型(不解决问题;自然交互;多轮对话)、图谱型(基于图谱推理)

参考资料: 【笔记1-1】基于对话的问答系统CoQA (Conversational Question Answering) 了解人机对话—聊天、问答、多轮对话和推荐 幽澜资讯:如何区分智能机器人对话系统的单轮和多轮对话? NLP领域中对话系统(Dialogue)和问答系统(question answer)做法有哪些异同点? GitHub:基

Elasticsearch 开放推理 API 增加了对 Anthropic 的 Claude 的支持

作者:来自 Elastic Jonathan Buttner 我们很高兴地宣布 Elasticsearch Open Inference API 的最新功能:集成 Anthropic 的 Claude。这项功能使 Elastic 用户能够直接连接到 Anthropic 平台,并使用 Claude 3.5 Sonnet 等大型语言模型来构建 GenAI 应用程序,并实现问答等用例。以前,客户可

昇思AI框架实践2:基于T5的SQL语句生成模型推理

MindSpore 基于T5的SQL语句生成项目实施 基于T5的SQL语句生成项目介绍 本项目旨在开发一个基于T5-small模型的自然语言转SQL语句生成器。该生成器能够将用户以自然语言形式提出的查询请求转换为对应的SQL查询语句,从而使得即使是不熟悉SQL语言的用户也能够轻松地从数据库中检索所需信息。本项目使用HuggingFace中经过大量英文语料预训练的T5-small模型并对其模型

怎样快速推理GRE填空题答案

GRE句子填空题目,一般是信息量充足型的(相对来说,阅读是信息量过剩型的,而类反是信息量缺乏型的,而数学是信息量不对称型的,题目作者挖掉的空和他留下的词汇实际上就体现了他的思路,他挖掉的空,是体现出他想考察的点,留下的词汇和这些词汇组成的一个逻辑的和语意的线索,体现了他的思维过程,(当然,有的时候线索也可能留在选项中出题人认为通过他留下的线索,我们是一定能推出空格的答案的。 我们

推理GRE填空的逻辑结构

由于改革后的新gre填空题更多的考察单词的用法和精确含义,也加深了对阅读理解能力的考察,新gre填空逻辑结构更为复杂,需要推导的层次也更多,希望广大考生认真备考。下面是有关否定之否定(双重否定即为肯定解析方法: 人类在用语言作出某一陈述或判断时,可采用正面陈述和反面陈述两种方式。所谓正面陈述,即是以一肯定句式作出的表述,如\"He is a good person\"。所谓反面陈述,即是

本地部署Xinference实现智能体推理工作流(一)

提示:没有安装Docker的需要先提前安装好Docker 第一篇章 使用AutoDL平台快速部署xinference 备注:若使用AutoDL平台,以下过程使用无卡模型开机即可(省钱) 1. 下载Dify源码 Github下载Dify:https://github.com/langgenius/dify 2. 快速启动 启动 Dify 服务器的最简单方法是运行我们的 [docke

反事实推理(Counterfactual Reasoning):探索未知与决策的桥梁

反事实推理(Counterfactual Reasoning):探索未知与决策的桥梁 反事实推理(Counterfactual Reasoning)是一种思维方式,它试图回答“如果……会怎样?”的问题。简单来说,反事实推理是在已有事实的基础上,通过假设条件发生改变,来推测可能的结果。我们可以通过这个过程更好地理解因果关系,并帮助我们在未来做出更好的决策。 1. 反事实推理的基本原理 反事

identYwaf:一款基于盲推理识别技术的WAF检测工具

关于identYwaf identYwaf是一款功能强大的Web应用防火墙识别与检测工具,该工具基于盲推理识别技术实现其功能,可以帮助广大研究人员迅速识别目标Web应用程序所使用的保护防火墙类型。 功能介绍 identYwaf所实现的盲推理通过检查一组预定义的测试性(非破坏性)Payload触发的响应来完成,这些响应仅用于触发中间的 Web 保护系统,例如“http://<ho

AI嵌入式RK3588人工智能开发 --- 【2】RKNPU软件推理框架

一、RKNPU推理软件框架 1.1 推理软件框架 (1)RKNPU 硬件层 关于 RKNPU 硬件层在上个博文【AI嵌入式人工智能开发 --- 【1】初始RKNPU-CSDN博客】已经进行了了解,这里就不再进行过多的赘述。(2)RKNPU 驱动层 RKNPU 的驱动层是连接上层应用和 RKNPU 硬件的桥梁。驱动层的主要作用是将应用程序需要推理的内容提交给 RKNPU 进行计算,

NumPyro入门API和开发人员参考 pyro分布推理效果处理程序贡献代码更改日志入门教程使用NumPyro的贝叶斯回归贝叶斯分层线性回归例

NumPyro文档¶ NumPyro入门 API和开发人员参考 烟火元素分布推理效果处理程序贡献代码更改日志 入门教程 使用NumPyro的贝叶斯回归 贝叶斯分层线性回归 例如:棒球击球率 示例:变型自动编码器 例子:尼尔的漏斗 例子:随机波动 例如:亚麻和俳句 可变推断参数化 NumPyro模型的自动绘制