本文主要是介绍自然语言处理实战项目28-RoBERTa模型在BERT的基础上的改进与架构说明,RoBERTa模型的搭建,希望对大家解决编程问题提供一定的参考价值,需要的开发者们随着小编来一起学习吧!

大家好,我是微学AI,今天给大家介绍下自然语言处理实战项目28-RoBERTa模型在BERT的基础上的改进与架构说明,RoBERTa模型的搭建。在BERT的基础上,RoBERTa进行了深度优化和改进,使其在多项NLP任务中取得了卓越的成绩。接下来,我们将详细了解RoBERTa的原理、架构以及它在BERT基础上的改进之处,并通过实战项目来演示如何搭建RoBERTa模型。让我们开始学习-RoBERTa模型吧!

文章目录

- 一、RoBERTa模型的介绍

- BERT模型的两个任务

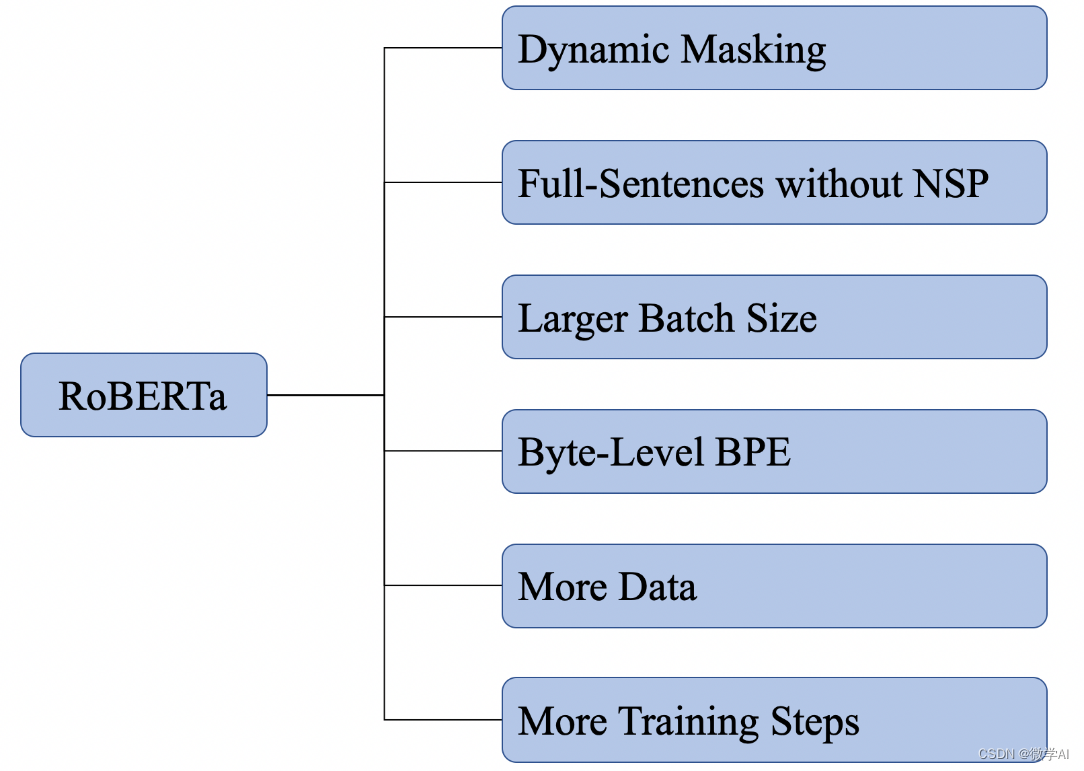

- RoBERTa模型的改进

- 二、RoBERTa模型的特点

- 更大的数据集和更多的计算资源

- 无NSP任务

- 动态掩码策略

- 更大的批量大小和序列长度

- 字节级BPE编码

这篇关于自然语言处理实战项目28-RoBERTa模型在BERT的基础上的改进与架构说明,RoBERTa模型的搭建的文章就介绍到这儿,希望我们推荐的文章对编程师们有所帮助!