本文主要是介绍【深度学习】Pytorch 系列教程(三):PyTorch数据结构:2、张量的数学运算(1):向量运算(加减乘除、数乘、内积、外积、范数、广播机制),希望对大家解决编程问题提供一定的参考价值,需要的开发者们随着小编来一起学习吧!

文章目录

- 一、前言

- 二、实验环境

- 三、PyTorch数据结构

- 0、分类

- 1、Tensor(张量)

- 1. 维度(Dimensions)

- 2. 数据类型(Data Types)

- 3. GPU加速(GPU Acceleration)

- 2、张量的数学运算

- 1. 向量运算

- a. 简单运算

- b. 广播操作

- c. 运算函数

- 加法add

- 乘法mul

- 内积(点积)dot

- 外积(叉积)cross

- 范数norm

一、前言

本文将介绍PyTorch中张量的数学运算之向量运算,包括加减乘除、数乘、内积、外积、范数、广播机制等

二、实验环境

本系列实验使用如下环境

conda create -n DL python==3.11

conda activate DL

conda install pytorch torchvision torchaudio pytorch-cuda=12.1 -c pytorch -c nvidia

三、PyTorch数据结构

0、分类

- Tensor(张量):Tensor是PyTorch中最基本的数据结构,类似于多维数组。它可以表示标量、向量、矩阵或任意维度的数组。

- Tensor的操作:PyTorch提供了丰富的操作函数,用于对Tensor进行各种操作,如数学运算、统计计算、张量变形、索引和切片等。这些操作函数能够高效地利用GPU进行并行计算,加速模型训练过程。

- Variable(变量):Variable是对Tensor的封装,用于自动求导。在PyTorch中,Variable会自动跟踪和记录对其进行的操作,从而构建计算图并支持自动求导。在PyTorch 0.4.0及以后的版本中,Variable被废弃,可以直接使用Tensor来进行自动求导。

- Dataset(数据集):Dataset是一个抽象类,用于表示数据集。通过继承Dataset类,可以自定义数据集,并实现数据加载、预处理和获取样本等功能。PyTorch还提供了一些内置的数据集类,如MNIST、CIFAR-10等,用于方便地加载常用的数据集。

- DataLoader(数据加载器):DataLoader用于将Dataset中的数据按批次加载,并提供多线程和多进程的数据预读功能。它可以高效地加载大规模的数据集,并支持数据的随机打乱、并行加载和数据增强等操作。

- Module(模块):Module是PyTorch中用于构建模型的基类。通过继承Module类,可以定义自己的模型,并实现前向传播和反向传播等方法。Module提供了参数管理、模型保存和加载等功能,方便模型的训练和部署。

1、Tensor(张量)

Tensor(张量)是PyTorch中用于表示多维数据的主要数据结构,类似于多维数组,可以存储和操作数字数据。

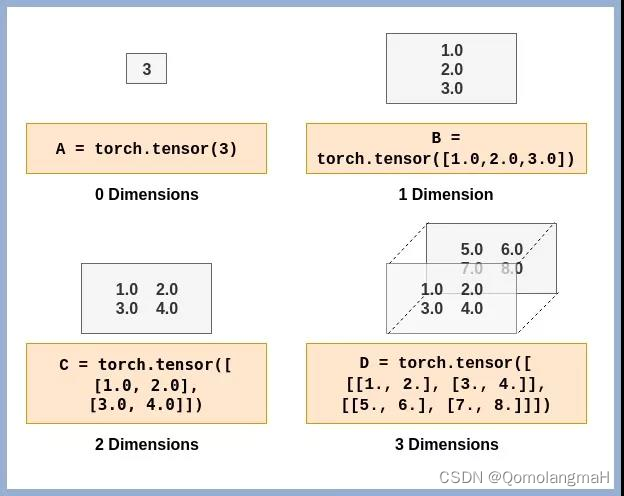

1. 维度(Dimensions)

Tensor(张量)的维度(Dimensions)是指张量的轴数或阶数。在PyTorch中,可以使用size()方法获取张量的维度信息,使用dim()方法获取张量的轴数。

2. 数据类型(Data Types)

PyTorch中的张量可以具有不同的数据类型:

- torch.float32或torch.float:32位浮点数张量。

- torch.float64或torch.double:64位浮点数张量。

- torch.float16或torch.half:16位浮点数张量。

- torch.int8:8位整数张量。

- torch.int16或torch.short:16位整数张量。

- torch.int32或torch.int:32位整数张量。

- torch.int64或torch.long:64位整数张量。

- torch.bool:布尔张量,存储True或False。

【深度学习】Pytorch 系列教程(一):PyTorch数据结构:1、Tensor(张量)及其维度(Dimensions)、数据类型(Data Types)

3. GPU加速(GPU Acceleration)

【深度学习】Pytorch 系列教程(二):PyTorch数据结构:1、Tensor(张量): GPU加速(GPU Acceleration)

2、张量的数学运算

PyTorch提供了丰富的操作函数,用于对Tensor进行各种操作,如数学运算、统计计算、张量变形、索引和切片等。这些操作函数能够高效地利用GPU进行并行计算,加速模型训练过程。

1. 向量运算

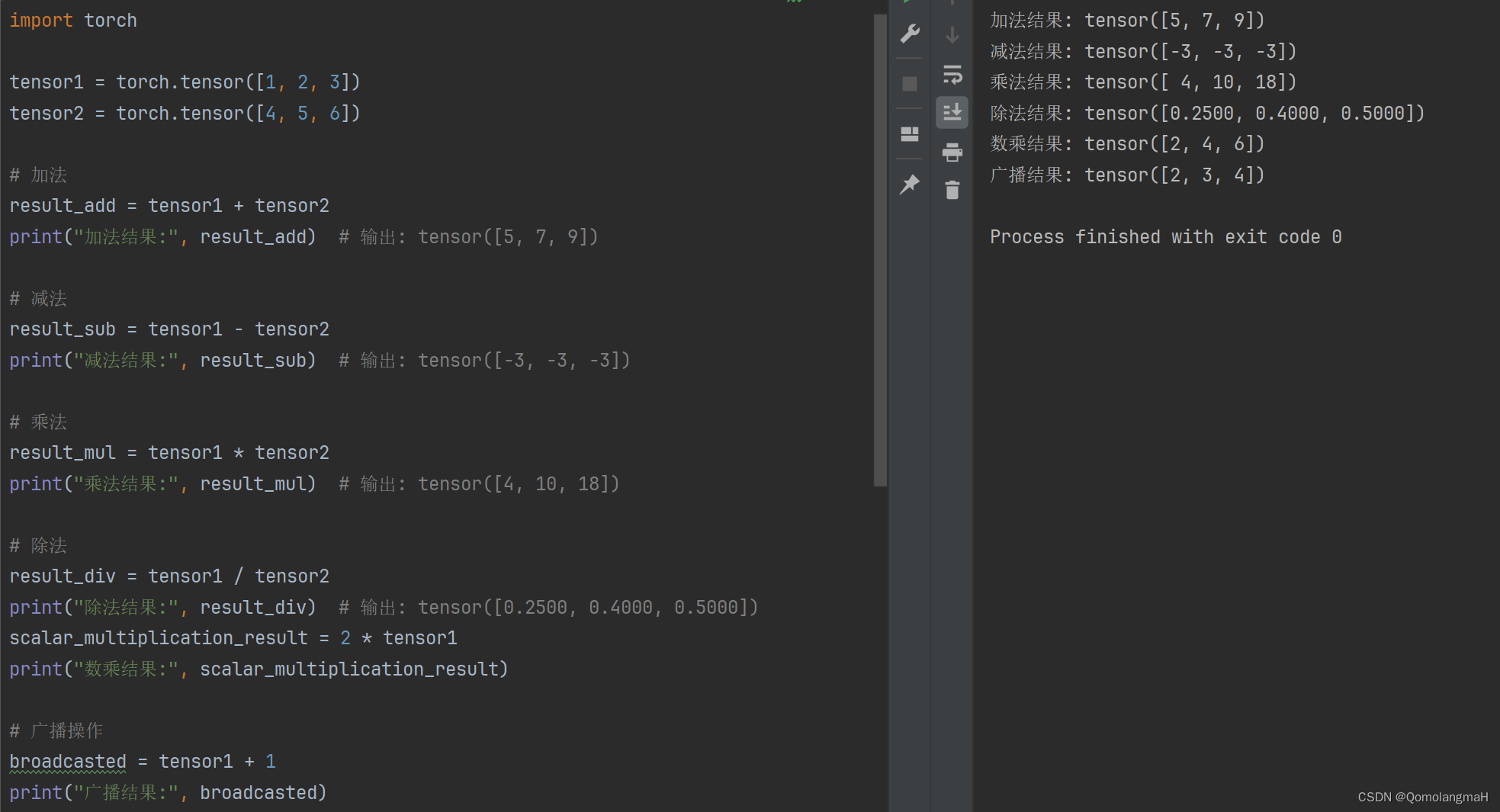

a. 简单运算

import torchtensor1 = torch.tensor([1, 2, 3])

tensor2 = torch.tensor([4, 5, 6])

# 加法

result_add = tensor1 + tensor2

print("加法结果:", result_add)

- 输出: tensor([5, 7, 9])

# 减法

result_sub = tensor1 - tensor2

print("减法结果:", result_sub)

- 输出: tensor([-3, -3, -3])

# 乘法

result_mul = tensor1 * tensor2

print("乘法结果:", result_mul)

- 输出: tensor([4, 10, 18])

# 除法

result_div = tensor1 / tensor2

print("除法结果:", result_div)

- 输出: tensor([0.2500, 0.4000, 0.5000])

scalar_multiplication_result = 2 * tensor1

print("数乘结果:", scalar_multiplication_result)

- 数乘结果: tensor([2, 4, 6])

b. 广播操作

可以对不同维度的向量进行运算,利用广播机制进行自动扩展和对齐。

# 广播操作

broadcasted = tensor1 + 1

print("广播结果:", broadcasted)

Broadcasted result: tensor([2, 3, 4])

- 广播结果: tensor([2, 3, 4])

c. 运算函数

加法add

import torchvector1 = torch.tensor([1, 2, 3])

vector2 = torch.tensor([4, 5, 6])# 向量相加

result = torch.add(vector1, vector2)print(result)

- 输出: tensor([5, 7, 9])

乘法mul

import torchvector1 = torch.tensor([1, 2, 3])

vector2 = torch.tensor([4, 5, 6])# 向量相乘

result = torch.mul(vector1, vector2)print(result)

- 输出: tensor([4, 10, 18])

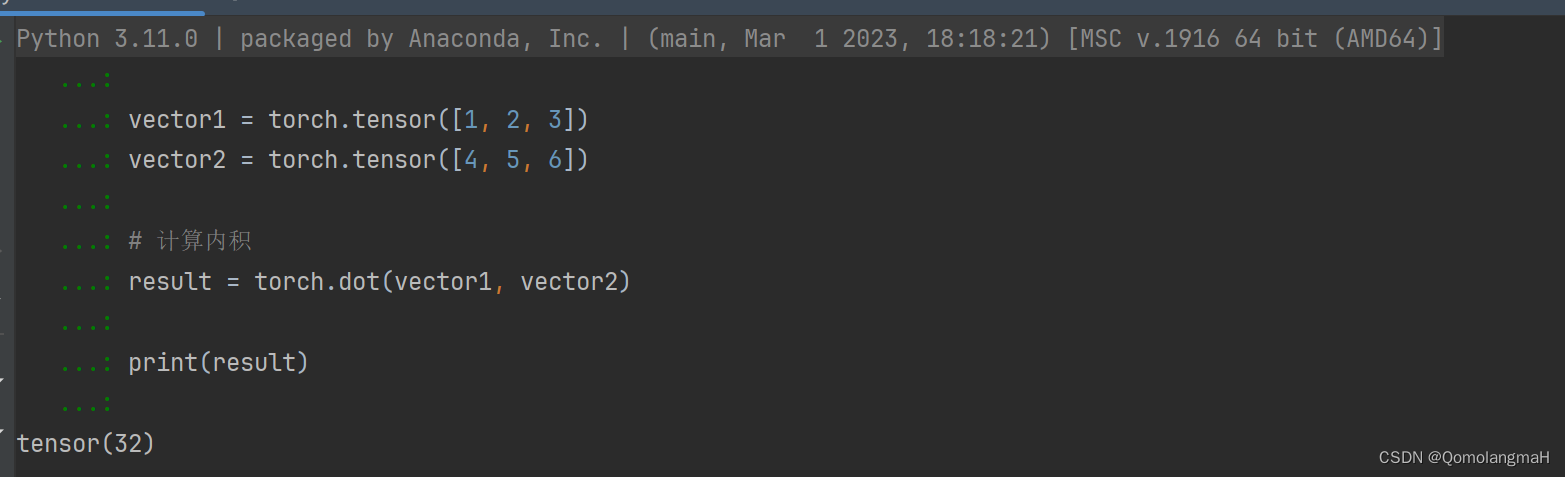

内积(点积)dot

import torchvector1 = torch.tensor([1, 2, 3])

vector2 = torch.tensor([4, 5, 6])# 计算内积

result = torch.dot(vector1, vector2)print(result)

- 输出: tensor(32)

32 = 1 ∗ 4 + 2 ∗ 5 + 3 ∗ 6 32 = 1*4 +2 * 5+3*6 32=1∗4+2∗5+3∗6

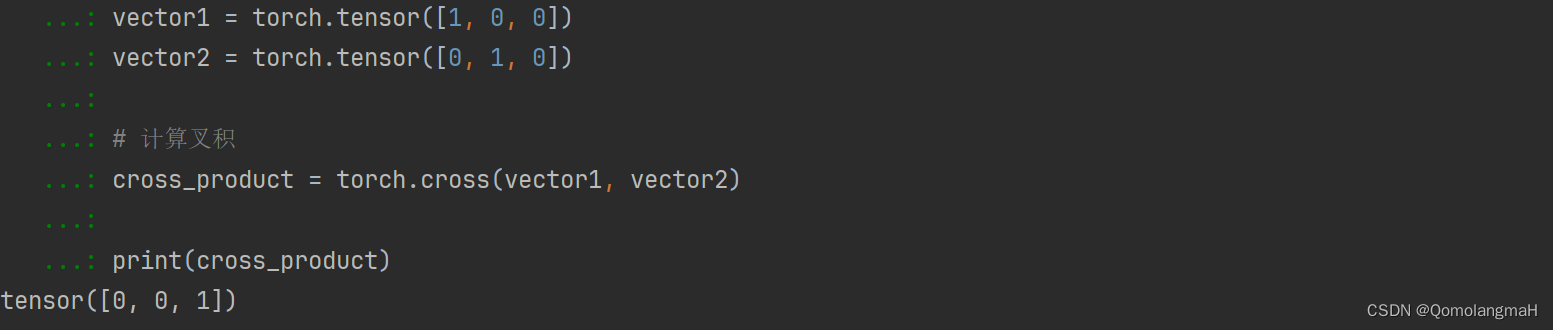

外积(叉积)cross

叉积是两个三维向量的向量积,结果是一个新的向量,垂直于原始向量所在平面。

import torchvector1 = torch.tensor([1, 0, 0])

vector2 = torch.tensor([0, 1, 0])# 计算叉积

cross_product = torch.cross(vector1, vector2)print(cross_product)

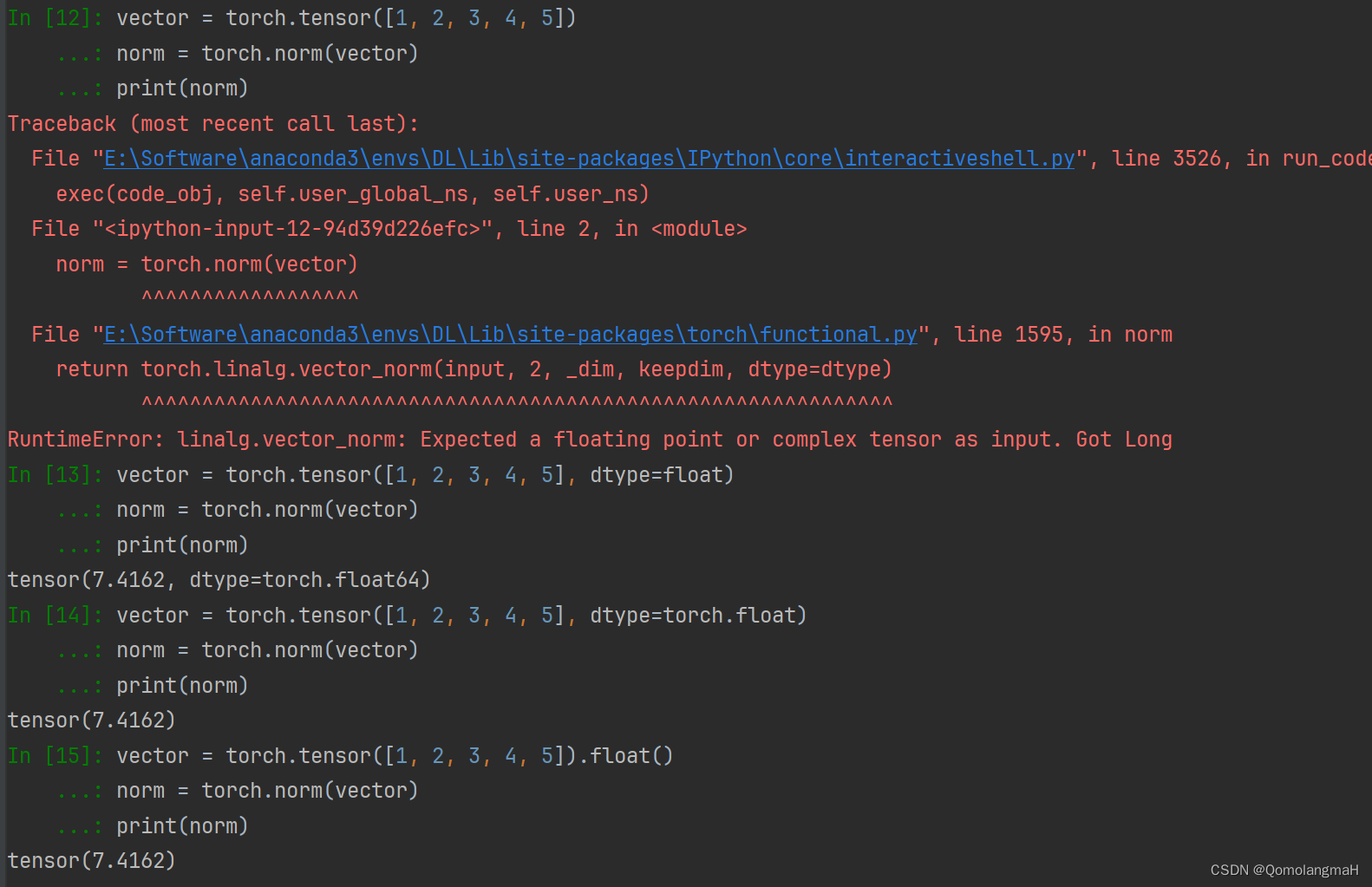

范数norm

范数是衡量向量大小的指标,norm默认计算L2范数。

import torchvector = torch.tensor([1, 2, 3, 4, 5], dtype=torch.float)# 计算范数

norm = torch.norm(vector)print(norm)

- 输出: tensor(7.4162)

7.4162 = 1 2 + 2 2 + 3 2 + 4 2 + 5 2 7.4162=\sqrt{1^2+2^2+3^2+4^2+5^2} 7.4162=12+22+32+42+52

注意数据类型转换

RuntimeError: linalg.vector_norm: Expected a floating point or complex tensor as input. Got Long

对比:

这篇关于【深度学习】Pytorch 系列教程(三):PyTorch数据结构:2、张量的数学运算(1):向量运算(加减乘除、数乘、内积、外积、范数、广播机制)的文章就介绍到这儿,希望我们推荐的文章对编程师们有所帮助!