张量专题

【DL--03】深度学习基本概念—张量

张量 TensorFlow中的中心数据单位是张量。张量由一组成形为任意数量的数组的原始值组成。张量的等级是其维数。以下是张量的一些例子: 3 # a rank 0 tensor; this is a scalar with shape [][1. ,2., 3.] # a rank 1 tensor; this is a vector with shape [3][[1., 2., 3.]

【AI】张量的秩(阶)与矩阵的秩和阶的区别

在阅读MindSpore文档时,笔者对这段话不太理解,遂求助ChatGPT. 矩阵的秩是矩阵中线性无关的行或者列,矩阵的阶就是矩阵中的行数和列数。 而张量的秩和阶是一个概念,指的是张量的维度(是1维的,二维的还是高维的)

Mindspore 初学教程 - 3. Tensor 张量

张量(Tensor)是一个可用来表示在一些矢量、标量和其他张量之间的线性关系的多线性函数,这些线性关系的基本例子有内积、外积、线性映射以及笛卡儿积。其坐标在 n n n 维空间内,有 n r n^{r} nr 个分量的一种量,其中每个分量都是坐标的函数,而在坐标变换时,这些分量也依照某些规则作线性变换。 r r r 称为该张量的秩或阶(与矩阵的秩和阶均无关系)。 张量是一种特殊的数据结构,

【PyTorch常用库函数】torch.add():张量的加法操作

🎬 鸽芷咕:个人主页 🔥 个人专栏: 《C++干货基地》《粉丝福利》 ⛺️生活的理想,就是为了理想的生活! 文章目录 前言一 、torch.add()函数的基本用法二、示例演示示例1:两个相同形状的一维张量相加示例2:两个不同形状的一维张量相加(错误示例)示例3:使用alpha参数进行加权加法 结尾 前言 PyTorch作为一

tensorflow:超简单易懂 tensor list的使用 张量数组的使用 扩增 建立 append

构造张量数组: 最简单的方式: tensor_list=[tensor1,tensor2] 常用的方式(这个方式可以用于for循环) tensor_list=[]tensor_list.append(tensor1)tensor_list.append(tensor2) 张量数组的使用 批量处理张量数组里面的张量,之后将其存储到一个新的张量数组中 new_tensor_list

Tensorflow之张量和会话

1.张量的概念 Tensorflow的名字表明了张量的含义。在tensorflow中,所有数据通过张量形式表示。张量可以理解为多维数组。零阶张量表示标量,也就是一个数;一阶张量为向量,一维数组;n阶张量可以理解为n维数组。 tensorflow中,张量并没有保存数字,只是表示数字的计算过程,是对tensorflow中运算结果的引用。 import tensorflow as

【PyTorch常用库函数】一文教你快速上手torch.abs()函数:获取张量的绝对值

🎬 鸽芷咕:个人主页 🔥 个人专栏: 《C++干货基地》《粉丝福利》 ⛺️生活的理想,就是为了理想的生活! 引言 在深度学习领域,PyTorch是一个非常受欢迎的框架,它提供了丰富的库函数来支持各种复杂的计算任务。今天,我们将深入探讨PyTorch中的一个基础但非常重要的函数:torch.abs()。这个函数用于计算张量(Tensor)中每

pytorch初始化张量并填充随机整数值

在 PyTorch 中,你可以使用 torch.randint 或 torch.empty 加上 random_ 方法来初始化张量并填充随机整数值。以下是两种常用的方法: 1. 使用 torch.randint torch.randint 直接生成一个指定形状的张量 ,并填充在给定范围内的随机整数。 示例代码: import torch# 生成一个 3x3 的张量,填充 0 到 9 之间

Pytorch中高维度张量理解

Pytorch中高维度张量理解 创建一个tensor获取第一个维度的第0个元素:获取第二个维度的第0个元素:获取第三个维度的第0个元素:获取第四个维度的第0个元素:其他情况 创建一个tensor tensor = torch.rand(3,5,3,2) 结果如下: ```pythontensor([[[[0.3844, 0.9532],[0.0787, 0.4187]

Pytorch:torch.diag()创建对角线张量方式例子解析

在PyTorch中,torch.diag函数可以用于创建对角线张量或提取给定矩阵的对角线元素。以下是一些详细的使用例子: 创建对角矩阵:如果输入是一个向量(1D张量),torch.diag将返回一个2D方阵,其中输入向量的元素作为对角线元素。例如: a = torch.randn(3)print(a)# 输出:tensor([ 0.5950,-0.0872, 2.3298])print

libtorch学习历程(二):张量

libtorch(pytorch c++)的大多数api和pytorch保持一致。 使用之前要导入torch #include <torch/torch.h>#include <torch/script.h> 1. 张量初始化 1.1 固定的值与尺寸 在C++中,使用{}来表示尺寸 zeros() zeros()产生值全为0的张量。 // 得到一个三维的全0auto x=t

02 TensorFlow 2.0:前向传播之张量实战

你是前世未止的心跳 你是来生胸前的记号 未见分晓 怎么把你忘掉 《千年》 内容覆盖: convert to tensorreshape

数组与张量中[]和[][]怎么区分含义

要区分张量(Tensor)和数组(Array)中单层索引(例如 `[]`)与多层索引(例如 `[[]]`)的使用,可以类比到生活中的一些例子来更直观地理解。我们将从基本概念开始,然后结合生活中的例子详细解释这些区别和用法。 ### 基本概念 - **单层索引 `[]`**:用于在一个维度上进行索引。 - **多层索引 `[[]]`**:用于在多个维度上进行索引。 ### 生活中的类比:书架和

张量的拼接和numpy拼接区别

拼接式张量的下扩展,表现为两个张量尺寸的和 框架不同: NumPy 是 Python 科学计算的基础库,主要用于处理多维数组和矩阵。PyTorch 是深度学习框架,主要用于处理张量,支持 GPU 加速。 函数名称和参数: NumPy 使用 concatenate 和 stack 函数。PyTorch 使用 cat 和 stack 函数。 维度参数: NumPy 使用 axis 参数指定沿哪个维

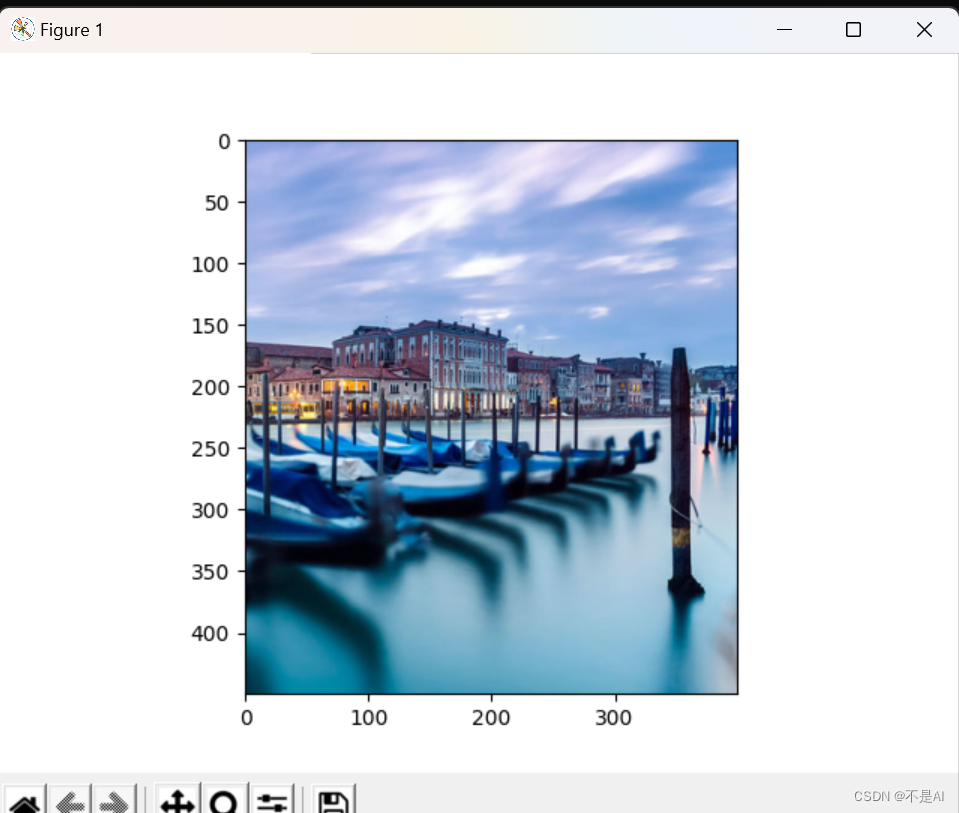

【PyTorch】【机器学习】图片张量、通道分解合成和裁剪

一、导入所需库 from PIL import Imageimport torchimport numpy as npimport matplotlib.pyplot as plt 二、读取图片 pic = np.array(Image.open('venice-boat.jpg')) 上述代码解释:先用Image.open()方法读取jpg格式图片,再用np.array()方法

维度/标量/张量/一维/二维/三维/shape/size/索引/view理解

维度是对不类型的描述,有几个不同的类型就有几个不同的维度. 张量是用来描述维度更宽泛的概念 标量是一个数. 一维是一组数据. 二维是两个不同特征组合的数据. 三维是三个不同的特征组合的数据.[] 只是用来表示区间范围套更多的[]是为了表示不同的维度,要理解维度 含义而不是只看[]. 生活例子 假设我们有一个书架,书架有很多层,每层放着书: 索引 (Index):就像书架上书的位置,比

跟着AI学AI_07张量、数组、矩阵

说明这三个概念不是一个范畴的东西,但是很容易混淆,因此放到一起进行说明。 张量(Tensor) 张量是一个多维数组的通用概念,用于表示具有任意维度的数值数据。在数学和计算机科学中,张量是广泛用于表示数据的基础结构,尤其在深度学习和科学计算领域。下面通过对比数组和矩阵来详细解释张量。 数组(Array) 数组是一种线性数据结构,用于存储一组具有相同数据类型的元素。数组有不同的维度: 一

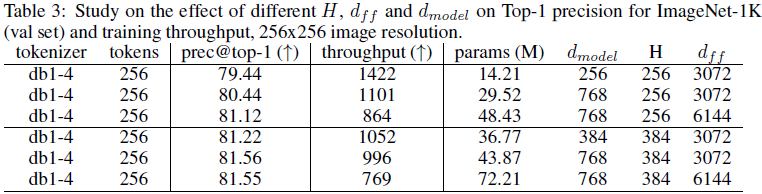

(2024,ViT,小波变换,图像标记器,稀疏张量)基于小波的 ViT 图像标记器

Wavelet-Based Image Tokenizer for Vision Transformers 公和众和号:EDPJ(进 Q 交流群:922230617 或加 VX:CV_EDPJ 进 V 交流群) 目录 0 摘要 1 引言 3 基于小波的图像压缩简介 4 图像标记器 4.1 像素空间标记嵌入 4.2 语义标记嵌入 4.3 Transformer 层的操作计数

算法金 | 这次终于能把张量(Tensor)搞清楚了!

大侠幸会,在下全网同名[算法金] 0 基础转 AI 上岸,多个算法赛 Top [日更万日,让更多人享受智能乐趣] 1. 张量(Tensor)基础概念 1.1 张量的定义与重要性 张量是深度学习中用于表示数据的核心结构,它可以视为多维数组的泛化形式。在机器学习模型中,张量用于存储和变换数据,是实现复杂算法的基石。本文基于 Pytorch 1.2 张量与向量、矩阵的关系

PyTorch学习(12):PyTorch的张量相乘(torch.matmul)

PyTorch学习(1):torch.meshgrid的使用-CSDN博客 PyTorch学习(2):torch.device-CSDN博客 PyTorch学习(9):torch.topk-CSDN博客 PyTorch学习(10):torch.where-CSDN博客 PyTorch学习(11):PyTorch的形状变换(view, reshape)与维度变换(transpose, per

Pytorch常用函数用法归纳:Tensor张量之间的计算

1.torch.add() (1)函数原型: torch.add(input, other, alpha, out) (2)参数说明: 参数名称参数类型参数说明inputtorch.Tensor表示参与运算的第一个输入Tensor张量othertorch.Tensor或者Number表示参与运算的第二个输入Tensor张量或标量alphaNumber, optional一个可选的缩放因子,

每天五分钟深度学习PyTorch:Tensor张量的索引和切片

本文重点 有时候当我们拥有一个Tensor张量的时候,我们可能需要获取它某一维度的信息,那么此时我们就需要索引和切片的技术,它们可以帮助我们解决这些问题。 切片操作 a是四维的,然后默认是从第一维开始取,逗号表示取不同的维度 a[:2]表示第一维取0,1,后面三维取所有 a[:2,:2]表示第一维取0,1,第二维取0,1,后面两维取所有 前两维取所有,第三维和第四维间隔取样,0

深度学习 - 张量的广播机制和复杂运算

张量的广播机制(Broadcasting)是一种处理不同形状张量进行数学运算的方式。通过广播机制,PyTorch可以自动扩展较小的张量,使其与较大的张量形状兼容,从而进行元素级的运算。广播机制遵循以下规则: 如果张量维度不相同,在较小张量的形状前面加上1,直到两个张量的维度相同。如果两个张量在某个维度的长度不相同,但其中一个张量在该维度的长度为1,那么在该维度上,较小长度的张量会被扩展为较大长度

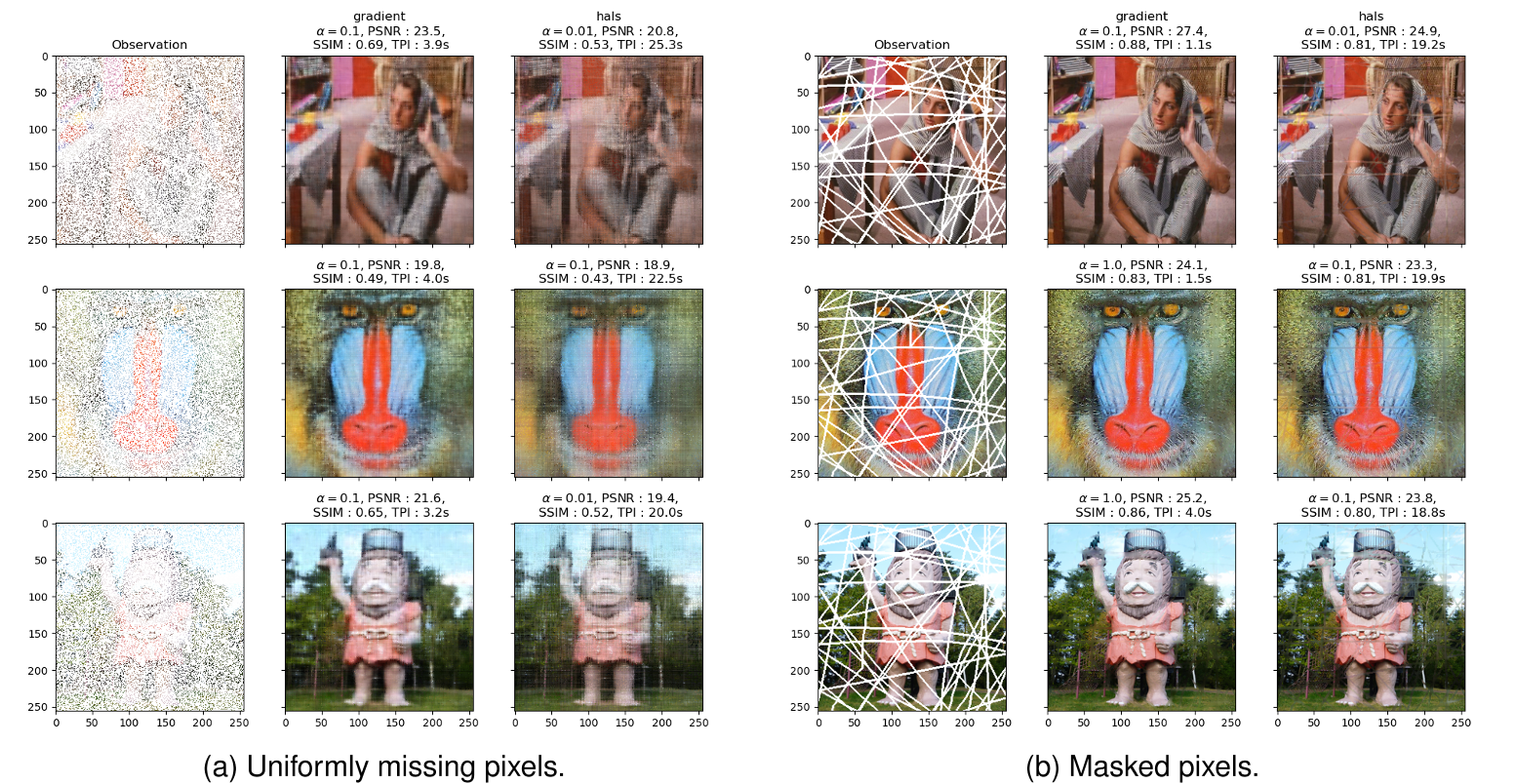

最新张量补全论文收集【8篇】

目录 1、利用张量子空间先验:增强张量补全的核范数最小化和 2、基于可学习空间光谱变换的张量核范数多维视觉数据恢复 3、用于图像补全的增强型低秩和稀疏 Tucker 分解 4、多模态核心张量分解及其在低秩张量补全中的应用 5、 低秩张量环的噪声张量补全 6、 视觉数据鲁棒张量补全的粗到精两阶段方法 7、 张量-序列格式下三阶张量补全的秩估计 8、具有缺失条目的平滑非负张量因子分解的