本文主要是介绍AI智能客服系列1-python基于Keras实现翻译系统/聊天机器人Seq2Seq模型+attention(理论篇-图文详解)智能对话系统专辑《一》,希望对大家解决编程问题提供一定的参考价值,需要的开发者们随着小编来一起学习吧!

对话机器人是最近一个热门话题,许多公司都在开发自己的智能客服系统,笔者将围绕智能对话、智能翻译系统整理出核心技术模型的原理和实战代码详解,撰写【智能聊天机器人技术专辑篇】。

此篇是:【智能客服对话系统专辑:《一、理论篇-核心技术模型原理图文分解》】

下面我们先来看下聊天机器人的神仙组合模型Seq2Seq+attention起源:

Seq2Seq 于 2013年、2014 年被多位学者共同提出,在机器翻译任务中取得了非常显著的效果,随后提出的 attention 模型更是将 Seq2Seq推上了神坛,Seq2Seq+attention 的组合横扫了非常多的任务,只需要给定足够数量的 input-output pairs,通过设计两端的 sequence 模型和 attention 模型,就可以训练出一个不错的模型。除了应用在机器翻译任务中,其他很多的文本生成任务都可以基于 Seq2Seq 模型来做,比如:文本摘要生成、对话生成等。

一、seq2seq模型原理:

seq2seq简单来说就是编码+解码器,把一个语言序列翻译成另一种语言序列,整个处理过程主要使用深度神经网络( LSTM (长短记忆网络)。脑补小时候看抗日大片地道战时,一边是编码发送情报,一边是接收情报用特定的模型进行解码,保证信息不被截胡,不过基本最后都会被我党机智神勇侦破。所以我们最重要的就是理解清楚,这背后的核心原理和模型。

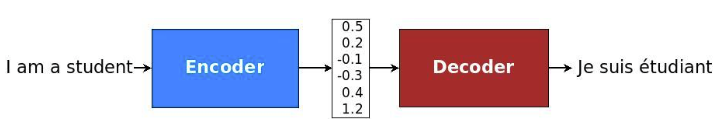

接收输入序列"A B C EOS ( EOS=End of Sentence,句末标记)", 在这个过程中每一个时间点接收一个词或者字,并在读取的EOS时终止接受输入,最后输出一个向量作为输入序列的语义表示向量,这一过程也被称为编码(Encoder)过程,而第二个神经网络接收到第一个神经网络产生的输出向量后输出相应的输出语义向量,并且在这个时候每一个时刻输出词的概率都与前一个时刻的输出有关系,模型会将这些序列一次映射为"W X Y Z EOS",这一过程也被称为解码 (Decoder)过程,这样就实现了句子的翻译过程。整个过程的结构就像下图一样:

1.输入文本处理-词向量化:word embedding (输入文本词向量表达,这里有多种方法,TFIDF、Word2vec、GPT、ELMO、当然了目前ebedding中横扫各个大奖的还应当是BERT,至于BERT为什么夺冠,原理和实战代码,请访问之前写的文章里有详细介绍和代码实战,直通车BERT原理与实战代码。)

2.编码解码处理模型-LSTM:

如果此处你想不起来LSTM原理,下面附加简单介绍,帮你复习下:

2.1RNN弊端与LSTM高明之处

2.1.1先从理解

这篇关于AI智能客服系列1-python基于Keras实现翻译系统/聊天机器人Seq2Seq模型+attention(理论篇-图文详解)智能对话系统专辑《一》的文章就介绍到这儿,希望我们推荐的文章对编程师们有所帮助!