本文主要是介绍根据豆瓣对《流浪地球》的短评数据进行文本分析和挖掘,希望对大家解决编程问题提供一定的参考价值,需要的开发者们随着小编来一起学习吧!

1背景

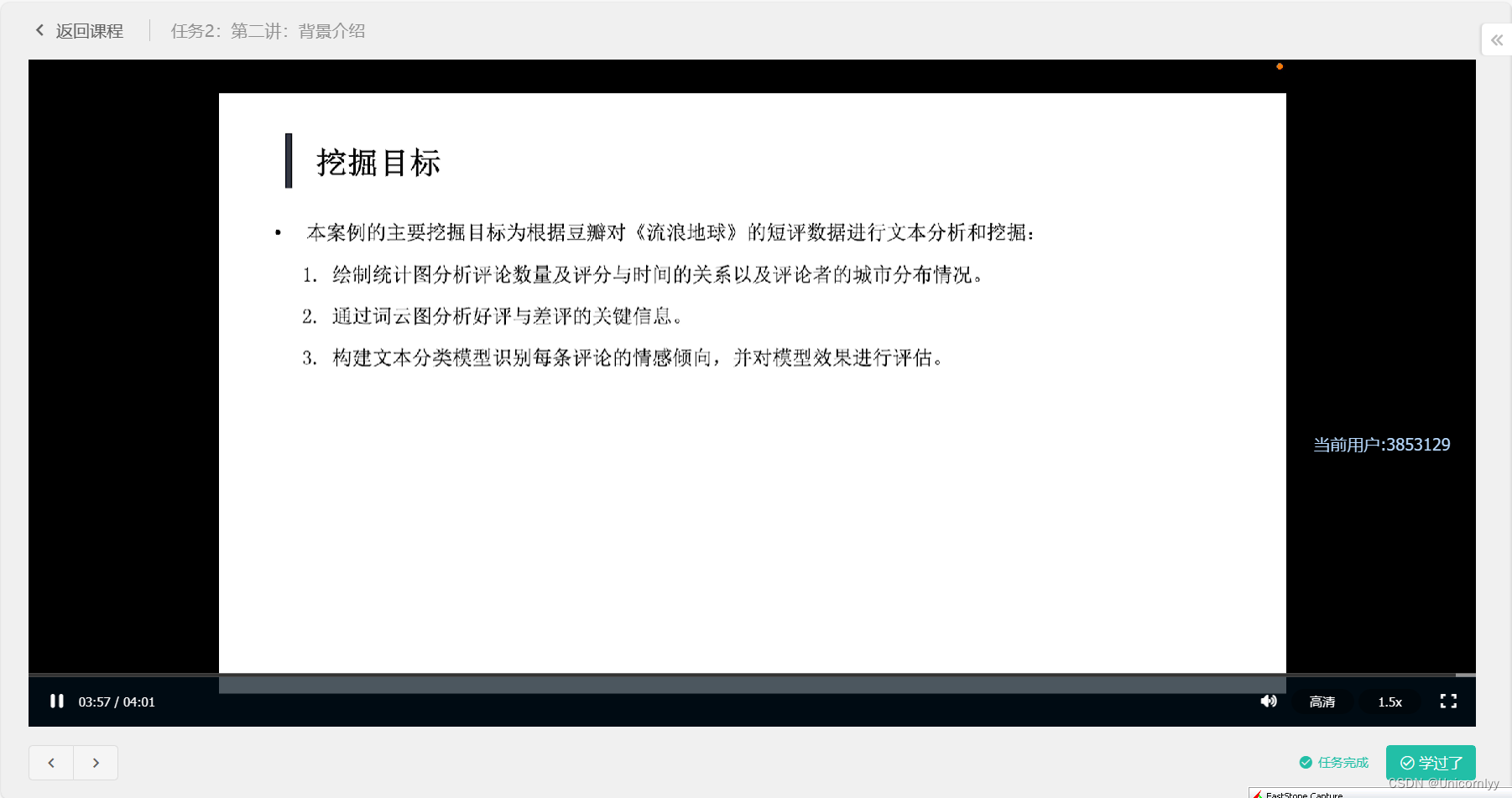

2019年2月5日电影《流浪地球》正式在中国内地上映。该电影在举行首映的时候,口德好得出奇,所有去看片的业界大咖都发出了画样赞叹,文化学者能锦说:“中国科幻电影元年开启了。"导演徐峰则说,“里程碑式的电影,绝对是世界级别的”。可是公映之后,《流浪地球》的豆评分却从8.4一路跌到了7.9。影片页面排在第一位的,是一篇一星评《流浪地球,不及格》。文末有2.8万人点了“有用”,3.6万人点了“没用”。关于《流浪地球》的观影评价,已经变成了场逐渐失控的舆论混战,如"枪稿“作者灰狼所说,"关于它的舆论,已经演化成、政治正确、水军横行、自来水灭差评、道德绑架、战狼精神”。为了对《流浪地球》的观影评价有个全面的了解,对《流浪地球》的豆影评数据进行分析和挖掘

。

(1) 给制统计图分析评论数量及评分与时间的关系以及评论者的城市分布情况。

2) 通过词云图分析好评与差评的关键信息。

(3)构建文本分类模型识别每条评论的情感倾向,并对模型效果进行评估

2数据获取

读取数据

import pandas as pd

data=pd.read_csv()

data

查看数据形状

data.shape

读取前五行

data.head()

描述性统计

data.describe()

count:查看数据的数量、unique:有多少个不同的值相当于有多少种,top:出现最多的值,freq:出现的频次

data.describe(include='object')

3数据预处理

查看数据city列的第一个值

data['citys'][0]

借助正则表达式提取城市信息即需要去掉[‘’],保留北京

import re

re.findall("[^''\[\]]+",x)

发现当城市为空时会出现报错(超出范围),因此我们利用apply函数进行操作

data['citys']=data['citys'].apply[lambda x:re.findall("[^''\[\]]+",x)[0] if len(re.findall("[^''\[\]]+",x))!=0 else None]

对于scores也可以参照这个来处理

分词与去除停用词

分词是文本信息处理的基础环节,是将句子切分成一个个词的过程。准确的分词处理可以极大的提高计算机对文本信息的识别理解能力。相反,不准确的分词处理会产生大量的噪声,严重干扰计算机的识别理解能力,并对后续的处理工作产生较人的影响。营见停用词例如:的、了、都、你、我、么等等,这些词通常在文本中大量出现,会带来大量的噪音数据.因此需要将这些停用词进行过滤。

4分词与去除停用词

data['content']

把除了中文字符之外的字符过滤掉,把不是中文字符的用空代替

x=data['content'][0]

x

re.sub('[^\u4E00-\u9FD5]+','',x)

data['content']=data['content'].apply(lambda x:re.sub('[^\u4E00-\u9FD5]+','',x))

#分词

import jieba

data_cut=data['content'.apply(jieba.lcut)]

data_cut

#去除停用词

#载入和加入停用词

with open('../data/stoplist.txt','r',encoding='utf-8') as f:stop=f.read()

stop=stop.split()

stop=['','\n','这部']+stop

stop

判断是否在停用词内

'的' in stop

data_after=data_cut.apply(lambda x:[for i in x if i not in stop])

data_after

4划分数据集

评分小于30为差评,标记为0:反之则为好评,标记为1。将原始数据划分为训练集和测试集,划分比例为4;1.

data_after=pd.DataFrame(data_after)

data_after['score']=data['scores']

data_after.shape

data_after['score'].apply[lambda x:re.findall("[0-9]+",x)[0] if len(re.findall("[0-9]+",x))!=0 else None]

data_after

把列表转成字符串

data_after['content']=data_after['content'].apply(lambda x :' '.join(x))

新建一列label存储

data_after['label'].apply(lambda x:1 if x>=30 else 0)

data_new=data_after[['content','label']]

划分数据集

from sklearn.model_selection import train_test_split

src_training,src_testing=train_test_split(data_new,test_size=0.2,stratify=data_after[label],random_state=123)

src_training

connents_train,connents_test=src_training['content']

.values,src——testing['content'].values

y_train,y_test=src_training['label'],src_testing['label']

src_training['content'].values

5文本的向量化

for i in range(len(comments_train)):if len(comments_train[i])==0:print(i)

ind=[i for i in range(len(comments_train)) if i not in [89,205]]

comments_train=comments_train[ind]

y_train=y_train.values[ind]

from sklearn.feature_extraction.text import CountVectorizer

from sklearn.feature_extraction.text import TfidfTransformercount_vectorizer=CountVectorizer()

tfidf_trainformer=TfidfTransformer()word_count_train=count_vectorizer.fit_transform(comments_train)

tfodf_train=tfidf_transformer.transform(word_count_test)print(tfidf_train.shape)

print(tfidf_test.shape)

6模型构建与评估

from sklearn.neighbors import KNeighborsClassifiermodel=KNeighborsClassifier(n_neighbors=8,weights='distance')#模型构建

model.fit(tfidf_train,y_train)#模型训练

model

模型评估

pre=model.predict(tfidf_test)

pre#计算正确率

from sklearn.metrics import accuracy_score

accuracy_score(y_test,pre)

y_test

有一说一这个不太行

这个看起来不错

加这个

完美

这篇关于根据豆瓣对《流浪地球》的短评数据进行文本分析和挖掘的文章就介绍到这儿,希望我们推荐的文章对编程师们有所帮助!