本文主要是介绍ACL2020 Heterogeneous Graph Neural Networks for Extractive Document Summarization,希望对大家解决编程问题提供一定的参考价值,需要的开发者们随着小编来一起学习吧!

Heterogeneous Graph Neural Networks for Extractive Document Summarization

- 异构图神经网络提取文档摘要

- 摘要

- 1 引言

- 2 相关工作

- 3 Methodology

- 3.1 Document as a Heterogeneous Graph

- 3.2 Graph Initializers

- 3.3 Heterogeneous Graph Layer

- 3.4 Sentence Selector

- 3.5 Multi-document Summarization

- 4 Experiment

- 4.2 Settings and Hyper-parameters

- 4.3 Models for Comparison

- 5 Results and Analysis

- 5.1 Single-document Summarization

论文地址:https://www.aclweb.org/anthology/2020.acl-main.553.pdf

【文本摘要】抽取式摘要最新进展 复旦大学ACL2020

video:https://www.bilibili.com/video/av200402243/

异构图神经网络提取文档摘要

摘要

交叉句关系的学习作为提取文档摘要的关键步骤,已经被各种方法所探索。一种直观的方法是将它们放入基于图形的神经网络中,该网络具有更复杂的结构来捕捉句子间的关系。在本文中,我们提出了一个基于异构图的提取摘要神经网络,它包含了除句子之外的不同粒度级别的语义节点。这些附加节点充当句子之间的中介,丰富了交叉句关系。此外,通过引入文档节点,我们的图结构可以灵活地从单文档扩展到多文档。据我们所知,我们是第一个将不同类型的节点引入到基于图的神经网络中,用于提取文档摘要,并对其进行全面的定性分析,以研究其优点。代码将在Github1上发布。

1 引言

提取文档摘要就是从原始文档中提取出相关的句子,重新组织成摘要。近年来,深度神经网络在这项任务中的应用取得了巨大成功(Cheng and Lapata,2016; Narayan et al., 2018; Arumae and Liu, 2018;Zhong et al., 2019a; Liu and Lapata, 2019b)。现有的这些模型主要遵循编码-解码器框架,每句话都由不同形式的神经网络组件编码。

为了有效地从文档中可以成为摘要的句子,一个核心的方法就是找出两个句子的coss关系。目前大多数模型使用递归神经网络(RNNs)来捕捉跨句关系(Cheng and Lapata, 2016;Nallapati et al., 2017; Zhou et al., 2018)。然而,基于RNNs的模型通常很难捕获句子级的长距离依赖关系,特别是在长文档或多文档的情况下。一种更直观的方法是使用图形结构来建模句子之间的关系。然而,要找到一种有效的图结构来进行摘要是很有挑战性的。一些研究通过多种方式进行了努力。早期的传统工作是利用句子间余弦相似度建立连通图,如:LexRank(Erkan and Radev, 2004) and TextRank (Mihalcea and Tarau, 2004). 近年来,一些研究在构建摘要图时考虑了话语间的句子关系, 例如带有句子个性化特征的近似语篇图(ADG)(Yasunaga et al., 2017) and 修辞结构理论(RST)图 Rhetorical Structure Theory (RST) graph (Xu et al.,2019). 但是,它们通常依赖于外部工具,并且需要考虑错误传播问题。更直接的方法是创建一个句子级完全连接图。在某种程度上,the Transformer encoder(Vaswani et al.,2017) used in recent work(Zhong et al., 2019a;Liu and Lapata, 2019b),学习成对句子之间的相互作用,形式化的定义为分类任务。尽管它们取得了成功,但是如何构造有效的图结构来进行总结仍然是一个悬而未决的问题。

在本文中,我们提出了一个用于提取摘要的异构图网络。代替在句子级节点上构建图,我们在图中引入更多的语义单位作为附加节点来丰富句子之间的关系。这些附加的节点充当连接句子的中介,也就是说,每一个附加的节点都可以看作是包含它的句子之间的一种特殊关系。在信息传递到异构图的过程中,这些额外的节点和句子节点将被迭代地更新。

虽然可以使用更高级的特性(例如,实体或主题),为简单起见,本文以词语作为语义单位。每个句子都与其所包含的单词相连。所有的句子对和单词对都没有直接的边。构建的word-sentence异构图具有以下优点:(a)考虑到明确的词语重叠信息,不同的句子可以相互作用。(b)单词节点还可以从句子中聚合信息并得到更新。与我们的模型不同,现有的模型通常将单词作为嵌入层保持不变。©不同粒度的信息可以通过多个消息传递过程得到充分利用。我们的异构图网络可以扩展到更多类型的节点。例如,我们可以为多文档摘要引入文档节点。

我们强调我们的贡献如下:

(1)据我们所知,我们是第一个构建提取文档摘要异构图网络来建模句子之间的关系,它不仅包含句子节点,还包含其他语义单位。虽然在本文中我们只使用单词节点,但可以加入更优越的语义单位(例如实体)。

(2)我们提出的框架在扩展方面非常灵活,可以很容易地从单一文档调整到多文档摘要任务。

(3)我们的模型可以在三个基准数据集上胜过所有现有的竞争对手,而无需预先训练语言模型。消融研究和定性分析表明了我们的模型的有效性。

2 相关工作

提取文本摘要

随着神经网络技术的发展,文献文摘的提取已经取得了很大的进展。其中大部分集中在编码器解码器框架和使用递归神经网络(Cheng and Lapata, 2016; Nallapati et al.,2017; Zhou et al., 2018)或是 Transformer encoders 对句子进行编码 (Zhong et al., 2019b; Wang et al., 2019a)。最近,预训练语言模型也被应用于语境词表征的摘要(Zhong et al., 2019a;Liu and Lapata, 2019b; Xu et al., 2019; Zhong et al., 2020).

另一种直观的提取摘要结构是图表,它可以更好地利用句子之间的统计或语言信息。早期的研究集中在用句子之间的内容相似性构造文档图,如LexRank(Erkan and Radev, 2004)and TextRank (Mihalcea and Tarau, 2004).一些最近的工作旨在通过图形神经网络(GNNs)将关系先验合并到编码器中(Yasunaga et al., 2017; Xu et al., 2019).。在方法上,这些工作只使用一种类型的节点,它们将每个文档表示为同构图。

为了进行总结,Wei(2012)提出了由主题、单词和句子节点组成的异构图,并使用马尔可夫链模型进行迭代更新。Wang等(2019b) 修改用关键词和句子对其图进行TextRank,从而提出了异序排列。受异构图形神经网络在其他NLP任务上成功的启发,我们将其引入提取文本摘要以学习更好的节点表示。

Heterogeneous Graph for NLP

图神经网络及其相关的学习方法(即消息传递(Gilmer et al., 2017)、self-attention(Velickovic et al., 2017))最初是针对整个图共享同一类型节点的同构图设计的。但是,实际应用程序中的图通常带有多种类型的节点(Shi et al.,2016),即异构图。为了建立这些结构的模型,最近的工作做了初步的探索.Tu et al. (2019) 引入了一种异构图神经网络,将文档、实体和候选对象一起编码,用于多跳阅读理解. Linmei et al. (2019)专注于半监督短文本分类,构建了一个主题实体异构神经图。

给定一个文档 D = ( s 1 , . . . , s n ) D =(s_1,...,s_n) D=(s1,...,sn), n n n 是句子,我们可以将提取摘要表述为序列标记任务(Narayan et al., 2018;Liu and Lapata, 2019b). 我们的目标是预测一系列标签 y 1 , . . . , y n ( y i ∈ { 0 , 1 } ) y_1,...,y_n (yi ∈\{0,1\}) y1,...,yn(yi∈{0,1}), 对于句子, y i = 1 y_i = 1 yi=1表示第i个句子应该包含在总结中。ground truth标签,我们称之为ORACLE,是使用Nallapati et al. (2016)引入的贪婪方法和自动度量ROUGE来提取的。

一般来说,我们的异构摘要图由两类节点组成:作为中继节点的基本语义节点(如单词、概念等)和作为超节点的其他话语单位(如短语、句子、文档等)。每个超节点与包含在其中的基本节点连接,并将这种关系的重要性作为其边缘特征。因此,高层超节点可以通过基本节点建立彼此之间的关系。

在本文中,为了简单起见,我们使用单词作为基本语义节点。章节3.1中的异构摘要图是一个特例,它只包含一种用于分类的超节点(句子),而异构摘要图在Section中3.5使用两种(文档和句子),在我们的框架中其他类型的超节点(如段落)也可以引入,唯一的区别在于图的结构。

3 Methodology

3.1 Document as a Heterogeneous Graph

给定一个图G ={V , E}, V代表节点集,E代表节点之间的边. 我们的无向异构图可以正式定义为 V = V w ∪ V s V = V_w ∪ V_s V=Vw∪Vs , E = { e 11 , … . . , e m n } E =\{e_{11},…..,e_{mn}\} E={e11,…..,emn}, 其中, V w = { w 1 , … . w m } V_w=\{w_1,….w_m\} Vw={w1,….wm}, 表示文档的 m m m个唯一单词, V s = { s 1 , … . s n } Vs=\{s_1,….s_n\} Vs={s1,….sn}对应于文档中的n个句子. E是一个实值边权矩阵, e i j ≠ 0 { i ∈ { 1 , … , m } , j ∈ { 1 , … , n } } e_{ij}≠0 \quad \{i ∈\{1,…,m\}, j∈\{1,…,n\}\} eij=0{i∈{1,…,m},j∈{1,…,n}} 表示第 j j j个句子包含第 i i i个单词.

图1给出了我们模型的概述,它主要由三个部分组成:节点和边的图初始化器、异构图层和句子选择器。初始化器首先为文档图创建节点和边,并对它们进行编码。然后,异构图通过图注意网络(GAT) (Velickovic et al., 2017) 在单词和句子节点之间迭代传递消息来更新节点表示。最后,提取句子节点的表示形式,用于预测摘要标签.

3.2 Graph Initializers

设 x w ∈ R m × d w x_w∈R^{m\times d_w} xw∈Rm×dw 和 x s ∈ R n × d s x_s∈R^{n\times d_s} xs∈Rn×ds 分别表示单词节点和句子节点的输入特征矩阵, d w d_w dw是单词嵌入的维数, d s d_s ds是每个句子表示向量的维数. 具体来说,我们首先使用不同核大小的卷积神经网络(CNN) (LeCun et al., 1998)捕捉每个句子lj的the local n-gram feature,然后使用双向长短期记忆(BiLSTM) (Hochreiter and Schmidhuber,1997)层得到句子级特征gj。使用CNN局部特征与BiLSTM全局特征的连接作为句子节点特征 X s j = { l j ; g j } X_{sj}=\{l_j; g_j\} Xsj={lj;gj}。

为了进一步包含关于单词和句子节点之间关系的重要性的信息,我们在边缘权重中注入TF-IDF值。词频(TF)是 w i w_i wi在 s j s_j sj中出现的次数,取文档逆频率(IDF)作为wi出度的逆函数。

3.3 Heterogeneous Graph Layer

给定一个具有节点特征 X w ∪ X s X_w\cup X_s Xw∪Xs和边特征E的已经构造好了的图 G G G,我们使用图形注意网络(Velickovic et al., 2017) 更新语义节点的表示。

我们指定 h i ∈ R d h h_i\in R_{dh} hi∈Rdh, i ∈ { 1 , … , ( m + n ) } i∈\{1,…,(m+n)\} i∈{1,…,(m+n)} 作为输入节点的隐藏状态,其图注意层设计如下:

式中, W a , W q , W k , W v W_a,W_q,W_k,W_v Wa,Wq,Wk,Wv为可训练权重; a i j a_{ij} aij是 h i h_i hi和 h j h_j hj之间的 a t t e n t i o n attention attention权重,若是多头 a t t e n t i o n attention attention则可以表示为:

另外,为了避免多次迭代后梯度消失,我们还添加了一个残差连接。因此,最终输出可以表示为:

我们进一步修改了GAT层,以注入标量边权eij,映射到多维嵌入空间 e i j ∈ R m n × d e e_{ij} ∈R^{mn \times de} eij∈Rmn×de。因此,对等式1进行如下修改:

在每个图注意层之后,我们引入了一个由两个线性变换组成的带 p o s i t i o n − w i s e position-wise position−wise前馈层,就像transformer 一样(Vaswani at al.,2017)

Iterative updating

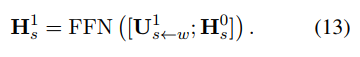

为了在单词节点和句子节点之间传递消息,我们将信息传播定义为如图2所示。具体来说,在初始化之后,我们更新为与其相邻的词节点通过上面的GAT和FFN层:

然后,我们使用更新的句子节点获取单词节点的新表示,并进一步迭代地更新句子节点。每次迭代都包含一个句子到单词和一个单词到句子的更新过程。第t次迭代过程可以表示为:

如图2所示,word节点可以从句子中聚合文档级信息。例如,单词节点的high degree表示该单词出现在许多句子中,可能是文档的关键字。对于句子节点,往往带有更多以上那些重要词的句子更可能被选择出来作为摘要。

3.4 Sentence Selector

最后,我们需要从异构图中提取摘要中包含的句子节点。因此,我们对句子进行节点分类,并以交叉熵损失作为整个系统的训练目标。

根据Paulus等人(2017)和Liu和Lapata (2019b)的研究,我们使用了Trigram Blocking,这是一种简单但功能强大的Maximal Marginal Relevance (Carbonell and Goldstein, 1998)。具体地说,我们根据句子的分数来排序,并丢弃那些与之前的句子有三字母重叠的句子

3.5 Multi-document Summarization

对于多文档摘要,document-level关系对于更好地理解这个集群的核心主题和最重要的内容至关重要。然而,大多数现有的神经模型忽略了这种层次结构,将文档连接到一个单一的平面序列(Liu et al., 2018; Fabbri et al., 2019)。另一些人则尝试利用基于注意的全连通图或相似关系或话语关系来建模这种关系(Liu and Lapata, 2019a).。我们的框架可以通过为文档添加超节点(如图3所示),以与语句级相同的方式建立文档级关系,这意味着可以很容易地从单文档摘要调整为多文档摘要。将异构图扩展为三种节点: V = V w ∪ V s ∪ V d V = Vw∪Vs∪Vd V=Vw∪Vs∪Vd,并且 V d = { d 1 , … , d l } Vd =\{d_1,…,d_l\} Vd={d1,…,dl} 其中 l l l是源文档的数量。我们称之为 H E T E R D O C − S U M G R A P H HETERDOC-SUMGRAPH HETERDOC−SUMGRAPH

如图3所示,单词节点成为句子和文档之间的桥梁。包含相同单词的句子无论在文档之间的距离有多远都可以相互连接,而文档则是根据它们相似的内容建立关系。

文档节点可以看作是一种特殊类型的句子节点:文档节点连接包含的单词节点,使用TF-IDF值作为边的权重。此外,文档节点与句子节点的更新过程相同。不同之处在于初始化,文档节点将其句子节点特征的均值池作为初始状态。在句子选择过程中,将句子节点与相应的文档表示连接起来,得到多文档摘要的最终得分。

4 Experiment

我们在单文档总结任务和多文档总结任务上评估我们的模型。下面,我们从数据集的描述开始我们的实验

CNN/DailyMail问答数据集(Hermann et al., 2015; Nallapati et al., 2016)是单文档摘要中使用最广泛的基准数据集。标准数据集分割包含287,227/13 ,368/11, 490个用于训练、验证和测试的示例。对于数据的优先化,我们按着Liu和Lapata (2019b)获得ground-truth标签,使用的是the nonanonymized version See et al. (2017)

NYT50 也是一个单文档摘要数据集,来自于New York Times Annotated Corpus(Sandhaus, 2008) 被Durrett et al. (2016).预处理(2016)。它包含110540篇文章和摘要,并被分为100,834和9706训练和测试。参照 Durrett et al.(2016),我们使用训练集中的最后4000个样本作为验证和筛选测试样本到3452个。

Multi-News 是Fabbri等人(2019)引入的大规模多文档摘要。它包含56,216对articles-summary,每个示例由2-10个源文档和一个人工编写的摘要组成。按照他们的实验设置,我们将数据集分割为44,972/5,622/5,622,用于训练、验证和测试示例,并将输入文章截断为500个tokens。

4.2 Settings and Hyper-parameters

对于单文档和多文档摘要,我们将词汇表限制在50,000个,并使用300维GloVe embeddings(Pennington et al., 2014)初始化 tokens. 在创建单词时,我们过滤停止词和标点符号,将输入文档截断为50个句子的最大长度。为了去除噪声常见词,我们进一步删除了整个数据集上10%的TF-IDF值较低的词汇。我们用ds = 128初始化句子节点,以de = 50初始化GAT_e中的边缘特征eij。每个GAT层为8个heads,隐藏大小dh = 64, FFN层的内部隐层大小为512。

在训练期间,我们使用批量大小为32,并应用Adam optimizer (Kingma and Ba, 2014),学习率为5e-4。当有效损耗连续三个epoch不下降时,执行早期停止。我们根据验证集的性能选择迭代次数 t = 1。对于解码,我们根据人写摘要的平均长度选择top-3 sentence 从 CNN/DailyMail和NYT50 数据集中和 top-9 sentence For Multi-New数据集中。

4.3 Models for Comparison

Ext-BiLSTM

用BiLSTM编码器的摘要提取模型通过将文档看作一系列句子来学习交叉句子的关系。为了简化,我们直接取出句子节点的初始化进行分类,其中包含一个用于词级的CNN编码器和用于句子级的2层BiLSTM。该模型也可以看作是对我们的异构图在句子节点更新方面的消融研究。

Ext-Transformer

以完全连接方式的纯数据驱动方式学习句子之间的交互关系(Vaswani等人,2017)。按着文献(Liu和Lapata, 2019b)的方式,我们实现了一个基于transformer的提取器作为基线,它包含用于构建单词embedding的相同编码器,以及用于句子的12个Transformer编码器层。Ext-Transformer可以看作是句子级全连通图。

HETERSUMGRAPH

我们的异构摘要图基于句子之间的常用词来建立句子之间的关系,可以表示为句-词-句之间的关系。

HETERSUMGRAPH通过节点分类直接选择语句进行总结,而trigram blocking HETERSUMGRAPH进一步利用n-gram block来减少冗余。

5 Results and Analysis

5.1 Single-document Summarization

我们在CNN/DailyMail和NYT50上评估了我们的单文档模型,and report the unigram, bigram and longest common subsequence overlap with reference summaries by R-1, R-2 and R-L.

由于计算资源有限,我们没有将预先训练好的上下文化编码器(即BERT (Devlin et al., 2018))应用到我们的模型中,我们将把这作为我们未来的工作。因此,为了公平起见,这里仅与不含BERT的模型进行比较。

Results on CNN/DailyMail

表1显示了CNN/DailyMail的结果。The first part is the LEAD-3 baseline and ORACLE upper bound, while the second part includes other summarization models.

我们将在第三部分中展示我们的模型(在4.3节中描述)。与ExtBiLSTM相比,我们的异构图在R-1、R-2和R-L上的改进超过0.6/0.51/0.7,说明我们的句子-词-句子结构学习到的跨句关系比顺序结构更强。

此外,我们的模型也优于基于完全连接关系的ExtTransformer。这说明我们的图结构有效地删除了句子之间不必要的连接,从而提高了句子节点分类的性能。

与图1的第二部分相比,我们观察到异构图优于所有以前的非non-BERT系统,而trigram blocking导致了all ROUGE metrics 有了很大的改进。其中,HER (Luo et al., 2019)是我们的异构图的竞争对手,它将提取摘要任务(extractive - summarization task)制定为一个contextual-bandit问题,并用强化学习来解决。

由于强化学习和我们的trigram block在将句子重组为摘要方面起到了类似的作用(Zhong et al., 2019a),因此我们在不使用policy gradient的情况下使用HETERSUMGRAPH对其进行了比较。

在没有句子评分策略的情况下,我们的异和图在R-1上比她提高了0.61,而在经过重组的总结中,使用trigram blocking的异构图比她提高了0.65。

Results on NYT50 结果见表2。请注意,我们使用Durrett等人(2016)的有限长度ROUGE recall,其中选择的句子被截断为人类书面总结的长度,并且使用召回分数而不是F1。前两行是Durrett等人(2016)给出的基线,接下来的两行是我们提取摘要的基线。第二部分和第三部分分别报告了其他non-BERT结果和我们的模型的表现。

同样,我们观察到我们的交叉句关系建模比BiLSTM和Transformer表现得更好。在NYT50上,我们的模型与其他non-BERT的方法相比也具有强大的优势。同时,我们发现trigram block并没有在CNN/DailyMail上显示的那么好,我们将原因归结为CNN/DailyMail数据集的摘要的特殊形成。

Ablation on CNN/DailyMail

为了更好地理解不同模块对性能的贡献,我们使用我们提出的异构图模型对CNN/DailyMail数据集进行消融研究。首先,我们分别去掉了低TF-IDF词和边缘权值的过滤机制。我们还删除了GAT层之间的剩余连接。作为补偿,我们在等式8的附近词节点更新后连接初始句子特征:

使迭代次数t = 0,删除词语更新,使用句子表示进行分类。最后,我们在句子节点初始化时去掉了BiLSTM层。

如表3所示,去除低TF-IDF单词会导致R-1和R-L升高,而R-2下降。我们怀疑过滤噪声词可以使模型更好地关注有用的词节点,但代价是丢失一些双字符信息。剩余连接在原始表示和来自另一类型节点的更新消息的组合中起着重要作用,它不能被连接替换。此外,边缘特征的引入、单词的更新和句子的BiLSTM初始化也显示了它们的有效性。

这篇关于ACL2020 Heterogeneous Graph Neural Networks for Extractive Document Summarization的文章就介绍到这儿,希望我们推荐的文章对编程师们有所帮助!