summarization专题

【人工智能】Transformers之Pipeline(十五):总结(summarization)

目录 一、引言 二、总结(summarization) 2.1 概述 2.2 BERT与GPT的结合—BART 2.3 应用场景 2.4 pipeline参数 2.4.1 pipeline对象实例化参数 2.4.2 pipeline对象使用参数 2.4.3 pipeline返回参数 2.5 pipe

论文笔记 _ Discourse-Aware Neural Extractive Text Summarization

作者:韩 单位:燕山大学 论文地址:https://www.aclweb.org/anthology/2020.acl-main.451/ 代码地址:https://github.com/jiacheng-xu/DiscoBERT 目录 一、文本摘要(Text Summarization )任务1.1 任务概述1.2 抽取式方法1.3 生成式方法1.3 ROUGE评分标准

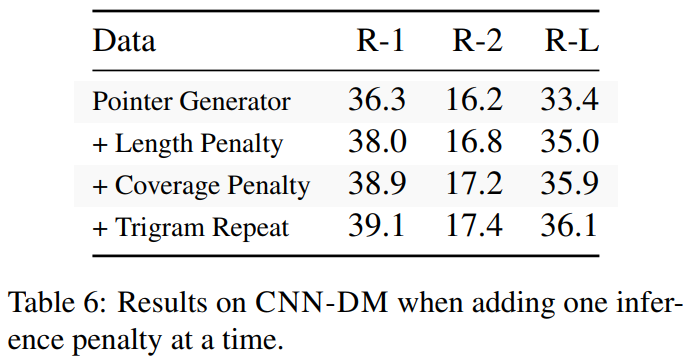

Re66:读论文 Bottom-Up Abstractive Summarization

诸神缄默不语-个人CSDN博文目录 诸神缄默不语的论文阅读笔记和分类 论文全名:Bottom-Up Abstractive Summarization EMNLP官方论文下载地址:https://aclanthology.org/D18-1443/ 模型可以简称为BottomUp 官方GitHub项目:sebastianGehrmann/bottom-up-summary 本文是2018年

论文笔记 _ Discourse-Aware Neural Extractive Text Summarization

作者:韩 单位:燕山大学 论文地址:https://www.aclweb.org/anthology/2020.acl-main.451/ 代码地址:https://github.com/jiacheng-xu/DiscoBERT 目录 一、文本摘要(Text Summarization )任务1.1 任务概述1.2 抽取式方法1.3 生成式方法1.3 ROUGE评分标准

【论文阅读】Multiplex Graph Neural Network for Extractive Text Summarization

【论文阅读】Multiplex Graph Neural Network for Extractive Text Summarization 用于提取文本总结的多路复用图神经网络 Proceedings of the 2021 Conference on Empirical Methods in Natural Language Processing 摘要 提取文本摘要旨在从给定文档中提取最

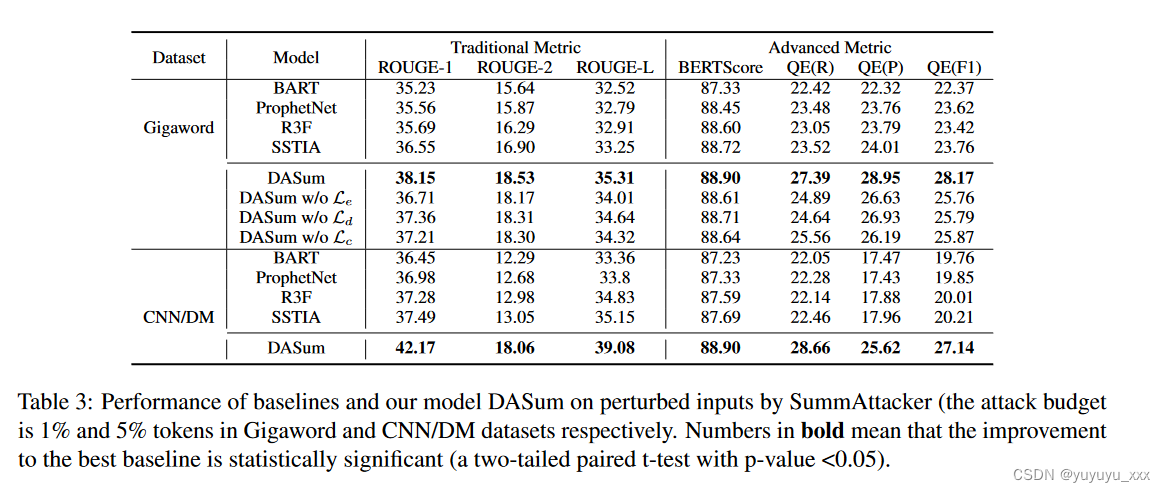

NLP论文阅读记录-ACL 2023 | Improving the Robustness of Summarization Systems with Dual Augmentation

文章目录 前言一、论文摘要二、论文动机2.1目标问题2.2相关工作 三.本文工作3.1 摘要攻击器受攻击的词选择器使用 LM 和梯度进行攻击 3.2 双重增强漏洞分析增强设计输入空间增强潜在语义空间增强 四 实验效果4.1数据集4.2 对比模型4.3实施细节4.4评估指标4.5 实验结果SummAttacker EvaluationRobustness Evaluation噪声数据集的鲁

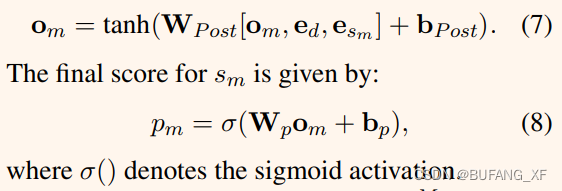

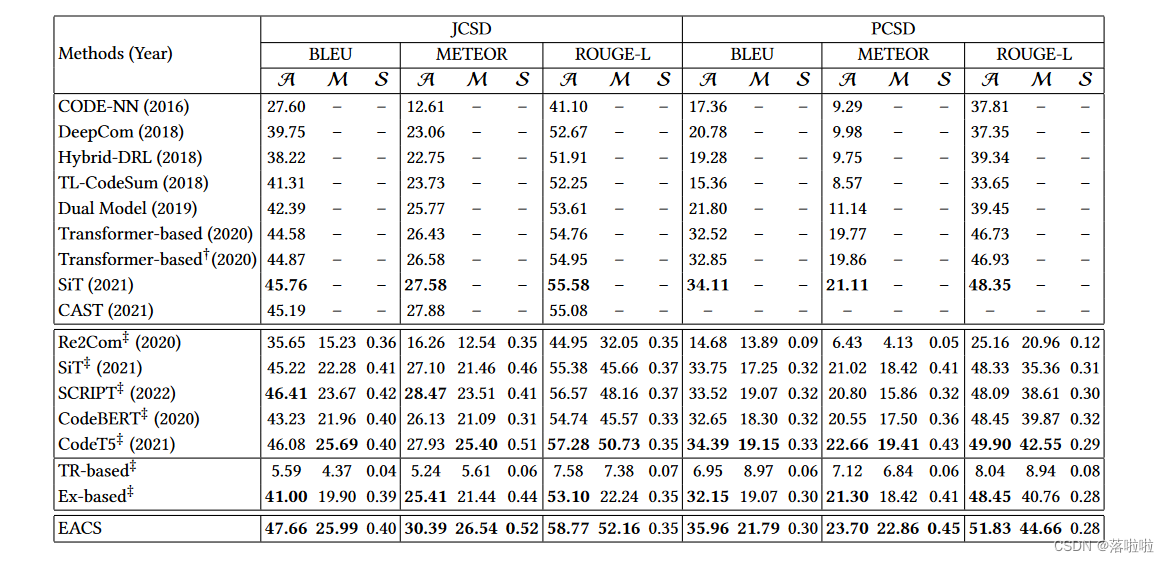

【论文笔记】An Extractive-and-Abstractive Framework for Source Code Summarization

An Extractive-and-Abstractive Framework for Source Code Summarization 1. Introduction2. Model2.1 Overview2.2 Training of EACS2.2.1 Part i : Training of Extractor2.2.2 Part ii : Training of Abstract

A Prompt Learning Framework for Source Code Summarization

Q: 这篇论文试图解决什么问题? A: 这篇论文试图解决的问题是自动生成代码片段的自然语言摘要(也称为注释),这对于帮助开发人员理解和维护源代码至关重要。最近,随着大型语言模型(LLMs)在许多领域的成功应用,软件工程研究人员也尝试将LLMs应用于代码摘要任务。然而,现有的适应LLMs的方案,如指令提示和面向任务的微调,要么需要用户设计精心制作的提示,要么需要高昂的训练成本。因此,作者提出了一种

SEOpinion: Summarization and Exploration Opinion of E-Commerce Websites

Authors: Alhassan Mabrouk ; Rebeca P. Díaz-Redondo ; Mohammed Kayed Q: 这篇论文试图解决什么问题? A: 这篇论文试图解决的问题是电子商务(EC)网站上的产品评论中意见的总结和探索。具体来说,它旨在通过结合产品模板信息和客户评论来提供产品方面的摘要,并突出显示关于它们的一个或多个意见。该论文提出了一种名为SEOpinion(

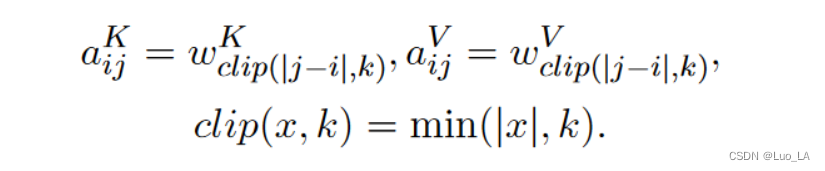

【论文笔记】A Transformer-based Approach for Source Code Summarization

A Transformer-based Approach for Source Code Summarization 1. Introduction2. Approach2.1 ArchitectureSelf-AttentionCopy Attention 2.2 Position Representations编码绝对位置编码成对关系 1. Introduction 生

Deep Reinforcement Learning for Unsupervised Video Summarization with Diversity-Representativeness..

Deep Reinforcement Learning for Unsupervised Video Summarization with Diversity-Representativeness Reward Abstract 视频摘要旨在通过制作短而简洁的摘要来促进大规模浏览视频,这些摘要是多种多样的,并且代表了原始视频。在本文中,我们规定视频摘要作为一个顺序决策过程,并开发一个

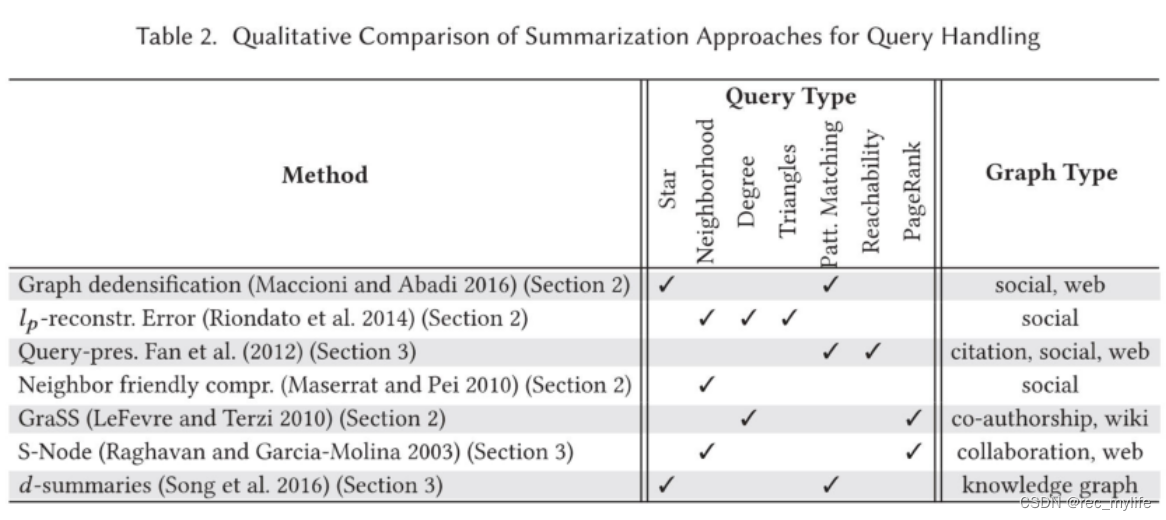

Graph Summarization Methods and Applications: A Survey

文章目录 ABSTRACT1 INTRODUCTION1.1 Challenges1.2 Types of Graph Summaries1.3 Differences from Prior Surveys 2 STATIC GRAPH SUMMARIZATION: PLAIN NETWORKS2.1 Grouping-Based Methods2.1.1 Node-Grouping Met

ACL2020 Heterogeneous Graph Neural Networks for Extractive Document Summarization

Heterogeneous Graph Neural Networks for Extractive Document Summarization 异构图神经网络提取文档摘要摘要1 引言2 相关工作3 Methodology3.1 Document as a Heterogeneous Graph3.2 Graph Initializers3.3 Heterogeneous Graph La

[摘要生成]Knowledge Graph-Augmented Abstractive Summarization with Semantic-Driven Cloze Reward

arxiv 2020 论文链接:https://arxiv.org/pdf/2005.01159.pdf github链接:https://github.com/luyang-huang96/GraphAugmentedSum 看具体内容,直接跳转链接。本文只从个人角度出发看本篇paper。 疑惑 数据集: NYT:training, validation, and test sets 58

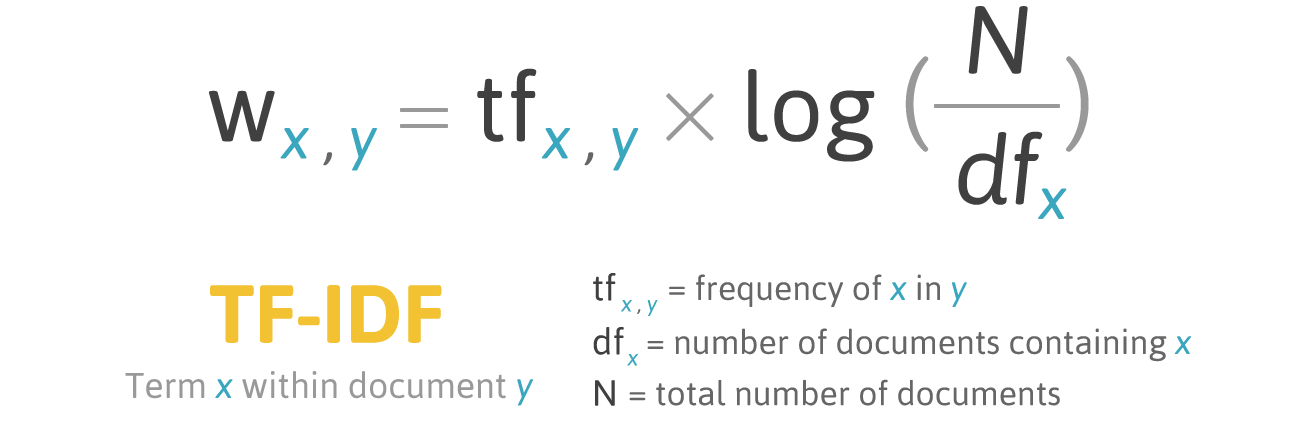

使用TF-IDF对Tweets做summarization

文本自动文摘(automatic summarization/abstracting)是利用计算机自动实现文本分析、内容归纳和摘要自动生成的技术。这项技术在互联网技术迅速发展、海量信息急速膨胀的今天,具有非常重要的用途。Tweets作为社交媒体内容的典型代表,具有极大的研究价值。本文尝试将经典的TF-IDF算法应用到tweets上提取原文中最有代表性的句子做automatic summarizat

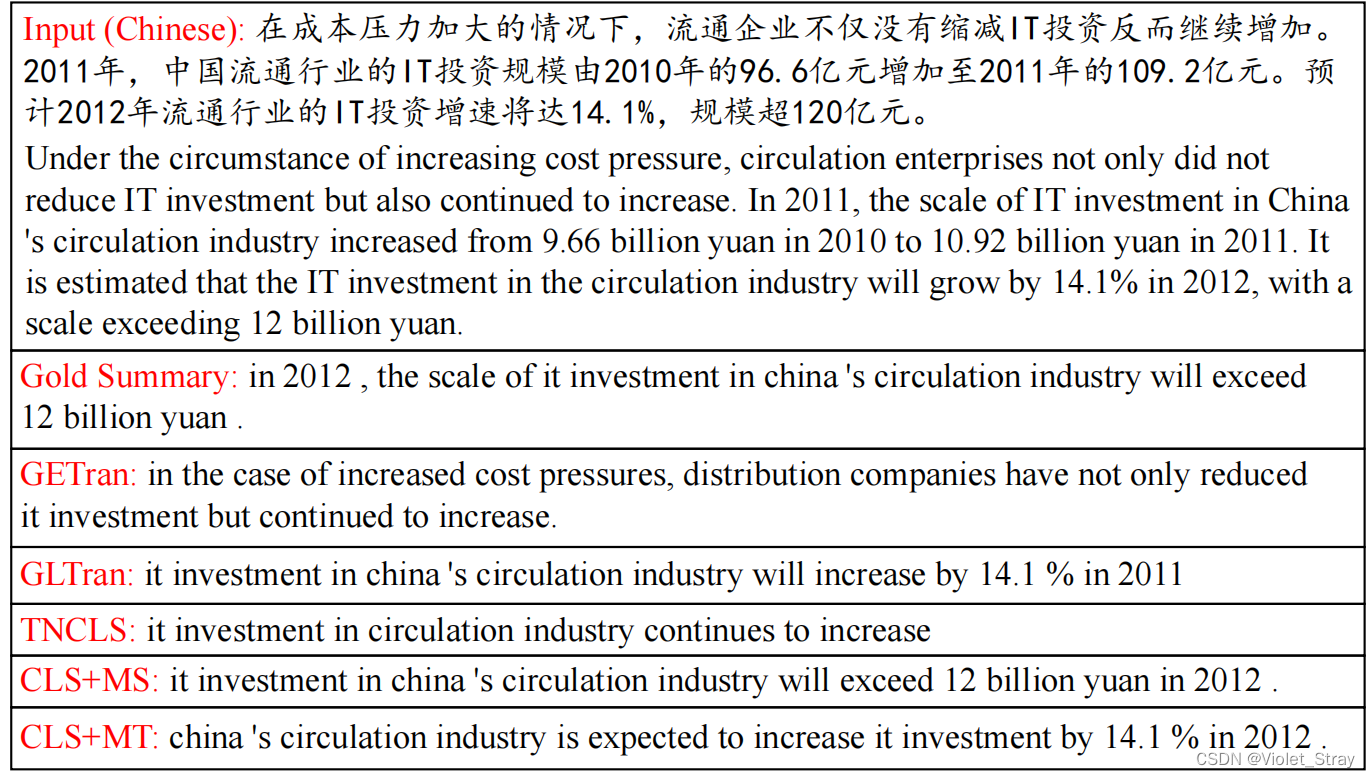

【翻译】NCLS: Neural Cross-Lingual Summarization

Abstract 跨语言摘要(CLS)是为不同语言的源文件生成特定语言摘要的任务。现有方法通常将此任务分为两个步骤:摘要和翻译,导致错误传播的问题。为了解决这个问题,我们首次提出了一种端到端的CLS框架,我们称之为神经跨语言摘要(NCLS)。此外,我们建议通过将两个相关任务,即单语摘要和机器翻译,纳入多任务学习的CLS培训过程中,进一步改进NCLS。由于缺乏监督CLS数据,我们提出了一种往返翻译

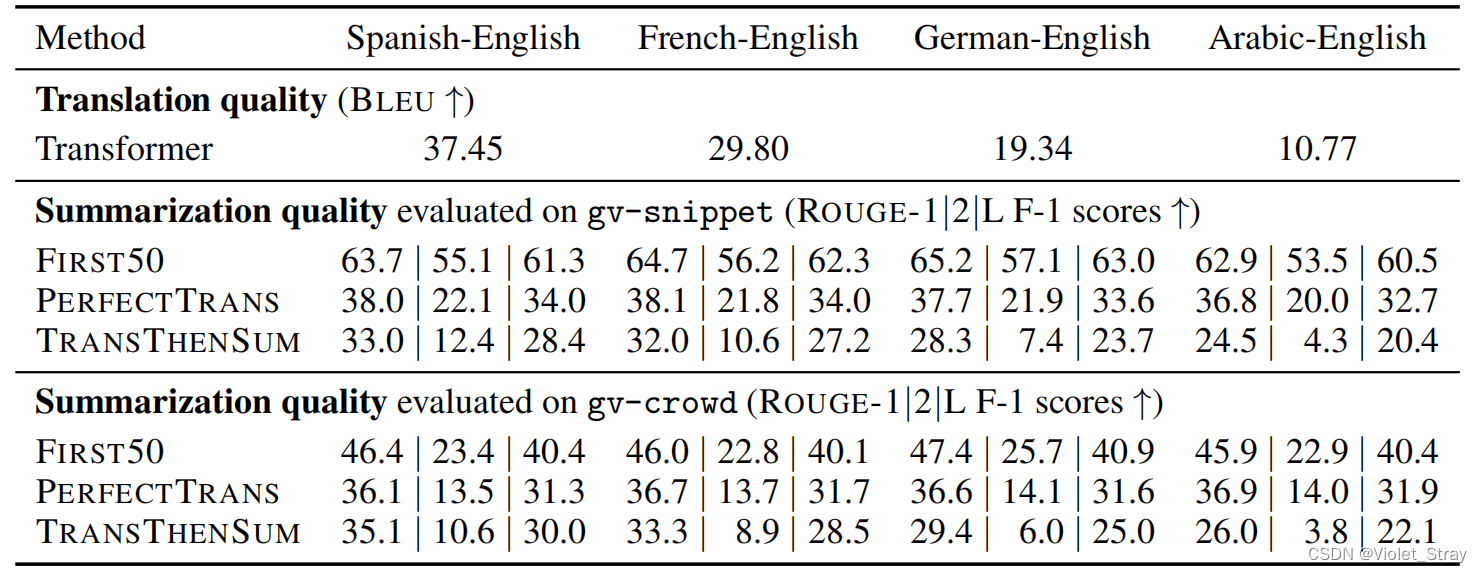

【翻译】Global Voices: Crossing Borders in Automatic News Summarization

Abstract 我们构建了一个名为“Global Voices”的多语言数据集,用于评估跨语言摘要方法。我们从Global Voices新闻文章中提取社交网络描述,以廉价的方式收集评估数据,用于15种语言的英译和译英摘要。特别是对于英译摘要任务,我们通过众包方式创建了一个高质量的评估数据集,基于强调准确性、覆盖范围和可理解性的指南。为了确保这个数据集的质量,我们收集了人工评级来筛选掉糟糕的摘要

![[摘要生成]Knowledge Graph-Augmented Abstractive Summarization with Semantic-Driven Cloze Reward](https://img-blog.csdnimg.cn/202101131006148.png?x-oss-process=image/watermark,type_ZmFuZ3poZW5naGVpdGk,shadow_10,text_aHR0cHM6Ly9ibG9nLmNzZG4ubmV0L1NBUkFDSF9XT05H,size_16,color_FFFFFF,t_70)