本文主要是介绍论文:MDETR - Modulated Detection for End-to-End Multi-Modal Understanding用于端到端多模态理解的调制检测,希望对大家解决编程问题提供一定的参考价值,需要的开发者们随着小编来一起学习吧!

作者

摘要

多模态推理系统依靠预先训练的目标检测器从图像中提取感兴趣的区域。然而,这一关键模块通常被用作一个黑匣子,独立于下游任务进行训练,并使用固定的对象和属性词汇表。这使得这类系统很难捕捉以自由形式文本表达的视觉概念的长尾。在本文中,我们提出了MDETR,这是一种端到端的调制检测器,用于检测以原始文本查询为条件的图像中的对象,如标题或问题。我们使用基于转换器的架构,通过在模型的早期阶段融合这两种模式,对文本和图像进行联合推理。我们在1.3M文本-图像对上对网络进行预训练。从预先存在的多模态数据集中挖掘,文本中的短语和图像中的对象之间具有明确的对齐。然后,我们对几个下游任务进行微调,例如短语基础、引用表达式理解和分割,在流行基准上获得最先进的结果。我们还研究了当在几个镜头设置中进行微调时,我们的模型作为给定标签集上的对象检测器的实用性。我们表明,我们的预训练方法提供了一种处理对象类别的长尾的方法,这些对象类别具有很少的标记实例。我们的方法可以很容易地扩展为可视化问答,在GQA和CLEVR上实现有竞争力的性能。有关代码和模型,请访问https://github.com/ashkamath/mdetr

Introduction

目标检测构成了大多数最先进的多模态理解系统的一个组成部分,通常用作黑匣子,用于检测图像中固定的概念词汇,然后进行多模态对齐。这种“流水线”方法限制了与其他模式作为上下文的共同训练,并限制下游模型只能访问检测到的对象,而不能访问整个图像。此外,检测系统通常是冻结,这会阻止进一步细化模型的感知能力。在视觉语言设置中,这意味着将结果系统的词汇限制为检测器的类别和属性,并且通常是这些任务性能的瓶颈[72]。因此,这样的系统无法识别自由形式文本中表达的概念的新颖组合。

图一查询“粉红大象”的MDETR输出。颜色不是分割遮罩,而是像素的真实颜色。这位模特在训练中从未见过粉红或蓝色的大象

图一查询“粉红大象”的MDETR输出。颜色不是分割遮罩,而是像素的真实颜色。这位模特在训练中从未见过粉红或蓝色的大象

最近的一项工作[66,45,13]考虑了文本条件下的目标检测问题。这些方法扩展了主流的一级和两级检测架构,以实现这一目标。然而,据我们所知,还没有证明这种检测器可以提高下游任务的性能,这些任务需要对检测到的对象进行推理,例如视觉问答(VQA)。我们认为这是因为这些检测器不是端到端可微的,因此无法与下游任务协同训练。

我们的方法MDETR是基于最新DETR[2]检测框架的端到端调制检测器,结合自然语言理解执行对象检测,实现真正的端到端多模态推理。MDETR仅依赖文本和对齐框作为图像中概念的监督形式。因此,与当前的检测方法不同,MDETR从自由格式文本中检测细微的概念,并将其概括为看不见的类别和属性组合。我们展示了这样一种组合以及调制检测图1。通过设计,我们的预测基于文本,这是视觉推理的关键要求[65]。当使用200000个图像和带方框注释的对齐文本数据集进行预训练时,我们在Flickr30k数据集上获得了最佳报告结果,用于短语基础,RefCOCO/+/g数据集用于引用表达式理解,以及引用短语切割上的表达式分段,以及GQA和CLEVR视觉问答基准的竞争性能。

- 我们的贡献如下:

- 我们介绍了一种端到端文本调制检测系统,该系统源于DETR检测器

- 我们证明,调制检测方法可以无缝应用于解决诸如短语基础和引用表达理解等任务,使用具有合成图像和真实图像的数据集在这两项任务上设置新的最先进性能

- 我们表明,良好的调制检测性能自然转化为下游任务性能,例如,在视觉问答、引用表达式分割和少镜头长尾目标检测方面实现具有竞争力的性能

Method

2.1Background

DETR

我们的调制检测方法建立在DETR系统[2]的基础上,我们在此简要回顾一下。我们请读者参阅原稿以了解更多细节。DETR是一种端到端检测模型,由主干网(通常为卷积剩余网络[12])和Transformer Encoder-Decoder[59]组成。

DETR编码器在主干的2D平坦图像特征上运行,并应用一系列Transformer层。解码器将一组称为对象查询的N个已学习嵌入作为输入,可以将其视为模型需要用检测到的对象填充的插槽。所有对象查询都并行地反馈给解码器,解码器使用交叉注意层查看编码图像,并预测每个查询的输出嵌入。每个对象查询的最终表示使用共享前馈层独立解码为框坐标和类标签。对象查询的数量实际上是模型可以同时检测到的对象数量的上限。对于给定图像中可能遇到的对象数量,必须将其设置为足够大的上限。由于特定图像中对象的实际数量可能小于查询的数量N,因此使用对应于“无对象”的额外类标签,由∅模型经过训练,可以为每个与对象不对应的查询输出此类。

DETR使用Hungarian matching loss进行训练,其中在N个拟用对象和地面真值对象之间计算二部匹配。每个匹配的对象都使用对应的目标作为背景真值进行监督,而未匹配的对象则被监督以预测“无对象”标签∅. 分类头使用标准交叉熵进行监督,而边界盒头使用绝对误差(L1损失)和广义IoU的组合进行监督[48]。

2.2MDETR

2.2.1Architecture

我们在图2中描述了MDETR的体系结构。在DETR中,图像由卷积主干编码并展平。为了保存空间信息,将二维位置嵌入添加到该展平向量中。我们使用预先训练的transformer语言模型对文本进行编码,以生成与输入大小相同的隐藏向量序列。然后,我们将模态相关的线性投影应用于图像和文本特征,将它们投影到共享的嵌入空间中。然后将这些特征向量在序列维度上串联,以产生图像和文本特征的单个序列。该序列被馈送到称为交叉编码器的联合变压器编码器。在DETR之后,我们对对象查询应用transformer解码器,同时交叉处理交叉编码器的最终隐藏状态。解码器的输出用于预测实际的盒子。

MDETR使用卷积主干提取视觉特征,使用语言模型(如RoBERTa)提取文本特征。这两种模式的特征都被投射到一个共享的嵌入空间,连接并馈送到变压器编码器-解码器,该编码器-解码器预测对象的边界框及其在文本中的基础

MDETR使用卷积主干提取视觉特征,使用语言模型(如RoBERTa)提取文本特征。这两种模式的特征都被投射到一个共享的嵌入空间,连接并馈送到变压器编码器-解码器,该编码器-解码器预测对象的边界框及其在文本中的基础

2.2.2Training

我们介绍了MDETR使用的两个附加损失函数,它们鼓励图像和文本之间的对齐。两者使用相同的注释源:带有对齐边界框的自由格式文本。我们称之为Soft token predictionloss的第一个损失函数是非参数对齐损失。第二种称为文本查询对比对齐,是一种参数损失函数,用于增强对齐对象查询和标记之间的相似性。

Soft token prediction

对于调制检测,与标准检测设置不同,我们对预测每个检测对象的分类不感兴趣。相反,我们从引用每个匹配对象的原始文本中预测标记的范围。具体地说,我们首先将任何给定句子的最大标记数设置为L=256。对于使用双向匹配与地面真值框匹配的每个预测框,对模型进行训练,以预测与对象对应的所有标记位置的均匀分布。图2显示了一个示例,其中cat框经过训练以预测前两个单词的均匀分布。在图6中,我们展示了本例中损失的简化可视化,即每个方框的字分布,但在实践中,我们在使用BPE方案标记化后使用标记跨度[52]。任何与目标不匹配的查询都经过训练以预测“无对象”标签∅. 请注意,文本中的多个单词可能对应于图像中的同一对象,相反,多个对象可能对应于同一文本。例如,图像中两个框所指的“一对”,可以在同一标题中单独指代。通过以这种方式设计损失函数,我们的模型能够从相同的引用表达式中了解共引用对象。

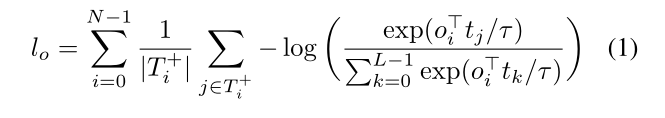

Contrastive alignment

当软token预测使用位置信息将对象与文本对齐时,对比对齐损失强制在解码器输出处的对象的嵌入表示与交叉编码器输出处的文本表示之间对齐。这种额外的对比对齐丢失确保(视觉)对象及其对应(文本)标记的嵌入在特征空间中比不相关标记的嵌入更接近。此约束比软token预测损失更强,因为它直接对表示进行操作,并且不完全基于位置信息。更具体地,考虑到最大的token数目L,object最大数量的对象是N。设 T i + \Tau^{+}_{i} Ti+为给定对象 ο i \omicron_{i} οi应与之对齐的标定集, O i + \Omicron^{+}_{i} Oi+为给定对象 t i t_{i} ti应与之对齐的标定集,

受InfoNCE[40]启发,所有对象的对比损失通过每个对象的正标记数进行标准化,可写为:

其中τ是我们设置为0.07的temperature parameter参考文献文献[63,47]。根据对称性,所有标记的对比损失(通过每个标记的正对象数量标准化)由以下公式给出:

我们将这两个损失函数的平均值作为对比校准损失。

Combining all the losses在MDETR中,正如在DETR中一样,使用二部匹配来查找预测和地面真实目标之间的最佳匹配。主要区别在于没有为每个对象预测类标签,而是预测文本中与该对象对应的相关位置上的均匀分布(软标记预测),使用软交叉熵进行监督。匹配成本包括预测和目标框之间的L1& GIoU损失,如DETR所示。匹配后,总损耗包括盒预测损耗(L1& GIoU)、软token预测损耗和对比对准损耗。

Experiment

在本节中,我们描述了用于训练前MDETR的数据和训练,并提供了用于评估方法的任务的详细信息和结果。表1中报告了CLEVR数据集的结果。有关CLEVR结果的讨论以及数据准备和训练的更多详细信息,请参见附录B。自然图像预训练和下游任务的实验细节详见§3。1和§3。2

3.1 Pre-training Modulated Detection

对于预训练,我们将重点放在调制检测的任务上,其目的是检测所有重新编码的在对齐的自由格式文本中查找到的对象。我们使用Flickr30k[46]、MS COCO[30]和Visual Genome(VG)[24]数据集的图像创建了一个组合数据集。来自引用表达式数据集、VG区域、Flickr实体和GQA训练平衡集的注释用于训练。图像可能有多个与之关联的文本注释。有关数据集的详细信息,请参见附录C。

Data combination

对于每个图像,我们从这些数据集中获取所有注释,并结合引用同一图像的文本,同时确保所有下游任务的验证或测试集中的所有图像都从序列集中删除。句子的组合使用图着色算法来完成,该算法确保只有带有GIoU框的短语≤05个字符,且组合句的总长度小于250个字符。通过这种方式,我们得到了一个具有1.3M的对齐的图像-文本对数据集。这一组合步骤之所以重要,有两个原因:1)数据效率,通过将更多信息打包到单个训练示例中;2)它为我们的软令牌预测损失提供了更好的学习信号,因为模型必须学会在同一对象类别的多次出现之间消除歧义,如图3所示。在单句子的情况下,软标记预测任务变得微不足道,因为它总是可以预测句子的词根,而无需查看图像。在实验中,我们发现这样密集的注释可以更好地在文本和图像之间建立基础,从而获得更好的下游性能。

Model

我们使用预先训练过的RoBERTa base[32]作为文本编码器,它有12个transformer编码器层,每个层的隐藏尺寸为768,在multihead attention中有12个头部。我们使用HuggingFace[61]中的实现和权重。对于视觉主干,我们探讨了两种选择。第一种是在ImageNet上预训练的ResNet-101[12],带有冻结的batchnorm层,来自TorchVision。这与当前多模态理解领域的文献相当,其中流行的方法是使用BUTD对象检测器,并使用[1]中在VG数据集上训练的Resnet-101主干。在我们的工作中,我们不受预先训练的探测器的限制,并且受到其在目标检测方面的成功[58]的启发,我们选择探索EfficientNet家族[57]作为我们的主干。我们使用了一个模型,该模型除了ImageNet外,还使用了大量未标记数据,使用了一种称为Noised Student的伪标记技术[64]。我们选择了 EfficientNetB3。ImageNet上仅12M weights达到的84%的顶级精度和 EfficientB5达到86.1%使用30M weights。我们使用Timm库[?]提供的实现,并冻结batchnorm层。我们在32个V100 GPU上预训练了40个时代的模型,有效批量大小为64,训练大约需要一周时间。训练参数详见附录A。

3.2 Downstream Tasks

我们在4个下游任务中评估了我们的方法:引用表达理解和切分、视觉问答和短语基础。所有任务的 training hyperprameters可在附录A中找到。

![准确性是指代表达理解的结果*如UNITER[6]所述,使用BUTD检测器[1]的盒子方案的方法会出现测试集泄漏,因为检测器是根据图像(包括重新理解数据集的验证和测试集)进行训练的。我们从他们使用这些“污染特征”的论文中报告了这些方法的数量,但我们想强调的是,我们所有的预训练都排除了在任何下游数据集的val/测试中使用的图像,包括用于重新理解的图像。CC是指概念性标题[53],VG是指视觉基因组[24],SBU是指SBU标题[41],COCO是指Micosoft COCO[30]。](https://img-blog.csdnimg.cn/cbda821561954e20a364cc6694222f81.png?x-oss-process=image/watermark,type_ZHJvaWRzYW5zZmFsbGJhY2s,shadow_50,text_Q1NETiBA5bCP5LuZ5aWz5ZGA54Gs,size_20,color_FFFFFF,t_70,g_se,x_16)

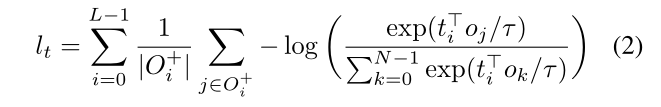

Phrase grounding

给定一个或多个短语,其中可能是相互关联的,任务是为每个短语提供一组边界框。我们使用Flickr30k entities数据集执行此任务,并使用[46]提供的train/val/test拆分,并从以下方面评估我们的性能:Recall@k. 对于测试集中的每个句子,我们预测100个边界框,并使用软标记对齐预测根据对应于短语的标记位置的分数对框进行排序。我们根据两个协议进行评估,我们将其命名为ANY-BOX[26,22]和MERGEDBOXES[44]。有关这两个协议的讨论,请参见附录D。我们将我们的方法与现有两种方法的最新结果进行比较——文本条件检测模型[45,66]和基于转换器的视觉语言预训练模型[26]。在任意框设置中,我们得到一个8。在这项任务上比目前的技术水平提高了5个百分点Recall@1在验证集上,不使用任何预培训(无其他数据)。通过预培训,在使用相同主干的情况下,在测试集上比最佳模型的性能提高12.1。

Referring expression comprehension

给定纯文本中的图像和引用表达式,任务是通过返回其周围的边界框来定位引用的对象。在这项任务中,大多数先前工作[69,34,6,68]所采用的方法是对一组预提取的与图像相关的边界框进行排序,这些边界框是使用预先训练的对象检测器获得的。在本文中,我们解决了一个更难的任务-我们训练我们的模型,以便在给定引用表达式和相关图像的情况下直接预测边界框。该任务有三个已建立的数据集,分别称为RefCOCO、RefCOCO[70]和RefCOCOg[36]。因为在预培训期间,我们对文本中提到的每个对象都进行了注释,所以在该任务中使用模型的方式有了轻微的改变。例如,在预培训期间,给出标题“身穿蓝色连衣裙的女士站在玫瑰花丛旁边”。MDETR将接受培训,以预测所有参考对象(如女士、蓝色连衣裙和玫瑰花丛)的方框。然而,对于引用表达式,任务是只返回一个边界框,这表示整个表达式引用的是女性。因此,我们在数据集上对model进行5个epoch的微调。在推理时,我们使用∅标签对100个检测到的框进行排序。让P(∅)当概率分配给“无对象”标签时,我们按1的降序排列−P(∅). 我们在表2中报告了结果,显示了对所有数据集的现状的巨大改进。

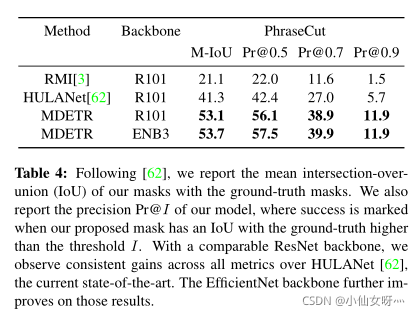

Referring expression segmentation

与DETR类似,我们表明,我们的方法可以通过评估最近的PhraseCut[62]数据集的引用表达式分割任务来进行分割,该数据集由来自VG的图像组成,并为每个引用表达式标注了分割掩码。这些表达式包含对象、属性和关系的广泛词汇表,使其成为具有挑战性的基准。与其他引用表达式分段数据集相反,在PhraseCut中,表达式可能引用多个对象。该模型应能找到所有相应的实例。我们的训练分两个阶段进行。在第一步中,我们在40个时代后获取预先训练的模型,并在此数据集上对其进行10个时代的微调,监督模型为引用的表达式输出正确的框。我们使用验证集上的框AP提前停止。在第二阶段,在[2]之后,我们冻结网络的权重,只训练35个时期的分段头,25个时期的学习率下降,使用Dice/F1损失[38]和焦点损失[29]的组合进行监督。在推断时,我们为每个预测框指定一个等于1的置信度−P(∅)何处(∅)是分配给“无对象”标记的概率(见§2)。然后,我们以低于0.7的置信度筛选框。最后,我们将每个框对应的掩码合并为一个与此引用表达式对应的二进制掩码。结果收集在表4中。我们的模型能够为短语切割涵盖的各种长尾概念生成干净的掩码。附录A给出了该数据集模型的预测示例。

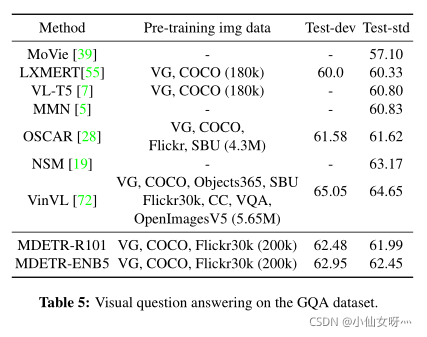

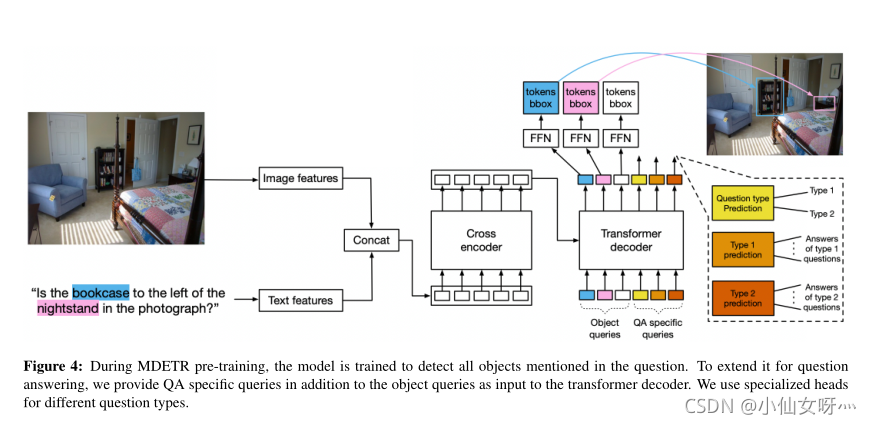

Visual Question Answering

我们评估了我们的假设,即调制检测是一个有用的组件,用于多目标检测-通过在GQA数据集上微调预先训练的模型进行模态推理。为了训练MDETR,我们使用GQA中提供的场景图来获得问题词和框之间的对齐。我们的模型架构如图4所示。对象查询是输入到解码器的学习嵌入,每个查询都可用于检测对象。除了用于检测的100个查询外,我们还使用专门针对问题类型的其他查询以及用于预测问题类型的查询,其中类型在GQA注释asREL、OBJ、GLOBAL和Catadantr中定义。我们在我们的组合数据集上对40个epoch的预训练模型进行训练,并随机初始化这些查询以及每个查询的头部,首先在不平衡的ALLGQA分割上对125个epoch进行微调,然后在平衡分割上对10个epoch进行微调,类似于之前的工作[28,5]。在前125个阶段中,我们在回答问题的同时训练调制的检测损失,但在回答问题的损失上加一个权重,这鼓励模型更加关注这项任务。对于平衡分裂微调,我们只使用问答损耗。在推理过程中,类型负责人预测问题类型,答案取自该负责人。使用我们的带有Resnet-101主干的模型,我们不仅优于使用可比数据量的LXMERT[55]和VL-T5[7],还优于在预训练中使用数量级更多数据的OSCAR[28]。如表5所示,具有EfficientNet-B5主干网的MDETR能够提高性能。NSM模型使用外部场景图生成模型,而MMN模型在训练期间使用场景图和功能程序。

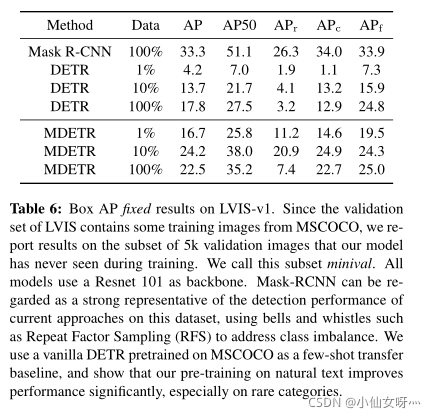

3.2.1 Few-shot transfer for long-tailed detection

受CLIP[47]的成功启发,关于图像分类的零镜头传输,我们探索了在给定标签集上使用一个pretraind MDETR检测器的可能性。与CLIP不同,我们不确保我们的预训练数据集包含所有目标类的平衡表示。通过构造,我们的数据集没有训练实例,其中有零个框与文本对齐,从而使模型偏向于总是预测给定文本的框。这会阻止在真正的零炮传输设置中进行评估,因此我们转而使用few-shot设置,在这些设置中,模型在可用标记数据的一小部分上进行训练。我们在L VIS数据集[11]上进行了实验,该数据集是一个词汇量为1.2k类别的检测数据集。具有包含很少训练样本的long-tail,使其成为当前方法的一个具有挑战性的数据集。联邦数据集经常给标准检测器带来问题,需要开发特定的损失函数[56],但是属性使其非常适合于训练MDETR:对于每个积极类别,我们创建一个由图像和类名的文本版本组成的训练实例,并将该类别的所有实例作为注释提供。对于每个负面类别,我们提供类名和一组空注释。对于给定图像的推断,我们查询每个可能的类名,然后合并在每个文本提示上检测到的框集。这种推理方案在GPU上的成本约为10s/image。

我们在LVIS序列集的三个子集上微调MDETR,每个子集分别包含1%、10%和100%的图像。我们确保类别的均衡抽样,这样我们的1%集合包含每个类别中至少一个正面和一个负面示例。我们比较了两个基线:第一个基线是仅在LVIS的完整训练集上训练的掩码RCNN。另一个是在MSCOCO上预先训练的DETR模型,然后在L VIS训练集的各个子集上进行微调。我们的结果如表6所示。根据最近关于大词汇量背景下AP评估的建议[8],我们报告了框APfixed,通过限制每个类别而不是每个图像的检测次数获得。即使每个类只有一个示例,MDETR也利用了文本预训练,在稀有类别上优于完全微调的DETR。然而,我们注意到,在对整个训练集进行完全微调的情况下,稀有对象的性能从10%的数据20.9AP大幅下降到100%的数据7.5,可能是由于极端的阶级不平衡。我们预计,重复因子抽样等常用技术将改善未来工作中的情况。

Related works

CLEVR数据集[20]是一个流行的vision语言基准,用于对对象、对象之间的关系以及这些关系的组成进行推理。一项重要的工作[21,67,37,15]利用了作为CLEVR数据集一部分的功能程序注释。这样的方法往往在问答基准上占主导地位,但无法推广到合成数据之外。相反,许多方法[42,51,60,17]直接从图像或预先检测到的物体中学习,并根据QA任务定制不同数量的感应偏差。我们的方法可以看作是介于两者之间的:虽然没有显式地使用程序监督,但它经过训练可以检测执行中间推理步骤所需的对象。

多模态理解的最新进展主要是通过预先训练大型Transformer模型,从大量对齐的图像文本数据中学习通用多模态表示[53],然后在下游任务中对其进行微调。这些方法可分为单流[6,28,72,26]和双流[55,34,35,54]架构,具体取决于文本和图像是由单个组合变换器处理还是由两个单独的变换器处理,然后是一些交叉注意层。对于这两种类型,流行的方法是独立地提取视觉和文本特征,然后使用Transformer的注意机制来学习两者之间的对齐。虽然这种方法在图像文本检索[72]、短语基础[26]、图像字幕[28]和视觉问答[25]等多种任务上改善了最先进的结果,但它为更紧密的体系结构留下了机会,如MDETR,在模型的早期阶段,信息在两种模式之间流动。以前使用调制架构(如[42]和[39])实现这一目标的一些尝试表明,在计算任务和可视化问答方面有了改进。

当前最先进的模型所使用的视觉特征是使用外部预训练检测器[1]提取的,该检测器输出的区域噪声大、通常过采样且不明确。[28]试图通过使用标签作为文本和图像之间的锚来缓解图像特征的噪声问题。与MDETR相比,这仍然是一种较弱的监督形式,在MDETR中,文本中的单词或短语与图像中的对象之间有明确的对齐。为了减轻固定概念词汇表所隐含的限制,[72]对一组更大的目标检测数据集进行训练,以寻求更好的覆盖范围。[9] 在现有高性能模型的基础上进行对抗性训练,使性能更高。其他方法[68]尝试将场景图预测作为预训练的一部分,以学习更稳健的表示。最近的一些工作还试图构建多用途多模式体系结构,能够在单个体系结构中处理各种视觉语言[7]以及纯语言任务[16]。针对与我们类似的问题但任务更为特殊的模型架构的另一条工作线是专门为此任务设计的单[66,4,27]和两阶段[45,13]引用表达式分割和短语检测模型。

Conclusion

我们提出了MDETR,一种完全可微的调制检测器。我们在多种数据集的多模态理解任务中建立了其强大的性能,并在其他下游应用中展示了其潜力,如少量镜头检测和视觉问答。我们希望这项工作为开发完全集成的多模式体系结构提供了新的机会,而不依赖于黑匣子对象检测器。

这篇关于论文:MDETR - Modulated Detection for End-to-End Multi-Modal Understanding用于端到端多模态理解的调制检测的文章就介绍到这儿,希望我们推荐的文章对编程师们有所帮助!