本文主要是介绍论文:Leveraging Type Descriptions for Zero-shot Named Entity Recognition and Classification,希望对大家解决编程问题提供一定的参考价值,需要的开发者们随着小编来一起学习吧!

个人目前感觉,可借鉴意义不大。

前言

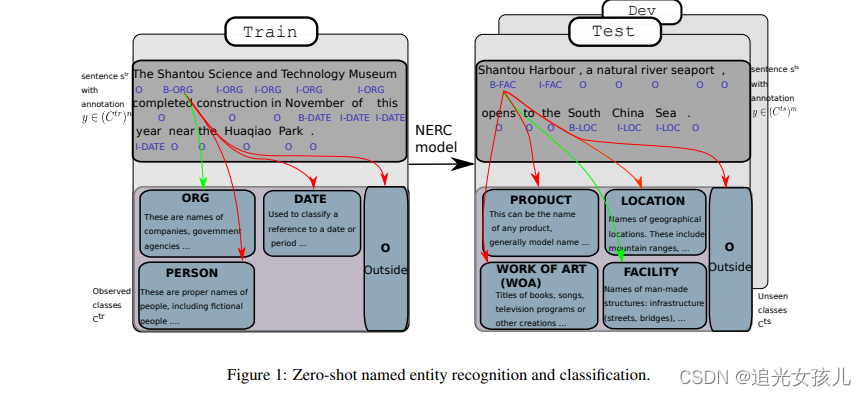

利用类型描述信息在zero-shot任务中,完成NERC任务。

没咋看懂。

存在问题:(1)每个class的description是如何构建的?

模型

将NER任务建模为多分类任务,预测每个token w的正确class。

argmax F (s,w,d),s是sentence,w是token,d是description .

模型encoder部分的输入是:【CLS】s【SEP】d【SEP】。

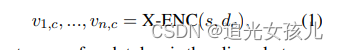

每个token的表示可以通过如下得到:

X-ENC是跨注意力编码。

token_t 的每种类型的score表示为:

在确定entity的class时,选择经过softmax之后的概率最大的那一个。

创新点

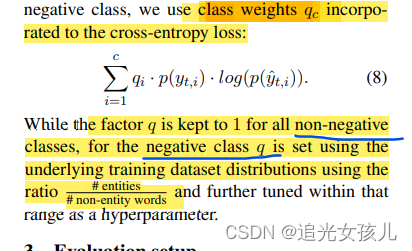

我觉得论文的创新点可能也就是negative class的建模问题。文中考虑到在train阶段是non-entity的token可能在test阶段是entity。

计算token 是neg的方式,文中提出了三种,

i) using a (textual) description for the negative class,

(ii) modelling the negative class directly,

(iii) modelling the negative class using the representations

generated for the classes corresponding to types

第一种舍掉,因为description是固定的,很难找到合适的description。

第二种,直接encoder编码sent得到sent中每个token是neg的表示。

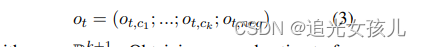

第三种,借用其他class的represention,得到neg class 的表示,应用了max pool得到neg class的表示,在通过linear 变换,得到分值。(但这种操作似乎也是作者自己提出的,也没有其他参考。。。)

we propose to model the negative

class by combining the representations generated

for the other classes, as generated by the crossattention encoder (Eq. 1): vt,c0, …, vt,ck. Each

vector is then linearly transformed, using wneg−cl

and then concatenated to a feature map m. We

then apply a max-pooling operation over this feature set and take the maximum value:

ot,neg−cl = max{m}. (7)

Finally, we compute ot,neg by linearly combining

the representation from the independent encoding

and ot,neg−cl.

训练

这篇关于论文:Leveraging Type Descriptions for Zero-shot Named Entity Recognition and Classification的文章就介绍到这儿,希望我们推荐的文章对编程师们有所帮助!