descriptions专题

Enhancing CLIP with GPT-4: Harnessing Visual Descriptions as Prompts

标题:用GPT-4增强CLIP:利用视觉描述作为提示 源文链接:Maniparambil_Enhancing_CLIP_with_GPT-4_Harnessing_Visual_Descriptions_as_Prompts_ICCVW_2023_paper.pdf (thecvf.com)https://openaccess.thecvf.com/content/ICCV2023W/MMF

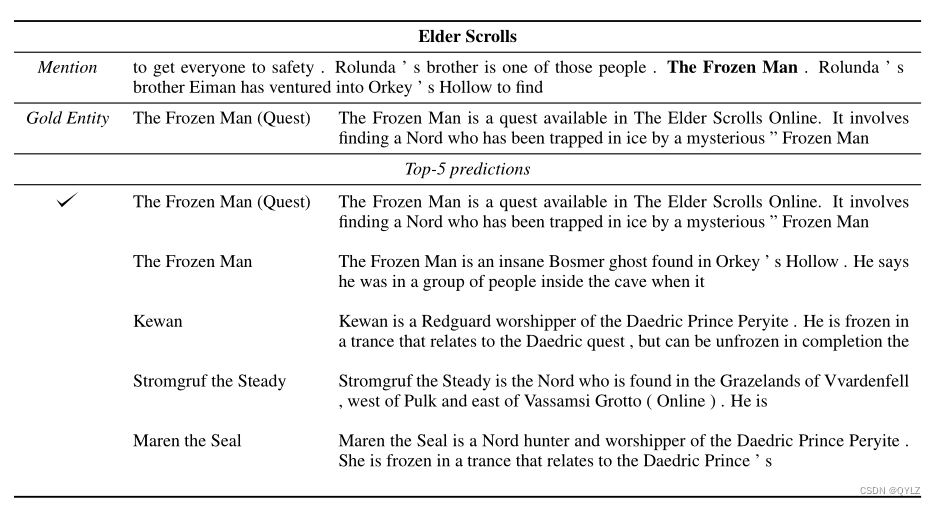

论文:Zero-Shot Entity Linking by Reading Entity Descriptions翻译笔记(阅读实体描述、实体链接)

文章目录 论文题目:通过阅读实体描述实现零样本实体链接摘要1 介绍2 零点实体链接2.1 审查: 实体链接2.2 任务定义2.3 与其他 EL 任务的关系 3 数据集构建4 实体链接模型4.1 生成候选4.2 候选排序 5 适应目标世界6 实验6.1 基线6.2 对未知实体和新世界6.3 领域自适应预训练的影响6.4 测试结果和性能分析 7 相关工作8 结论A 检验模型误差和预测

element el-descriptions 去掉背景色

2024.3.19今天我学习了el-descriptions怎么去掉背景色, 当我们使用这个组件的时候,如果宽度不够会出现留白的地方,我们需要用: ::v-deep .el-descriptions__body{background: #06153b !important;} el-descriptions__body这个属性进行修改。 :label-class-name="'lab

【翻译】Deep Visual-Semantic Alignments for Generating Image Descriptions

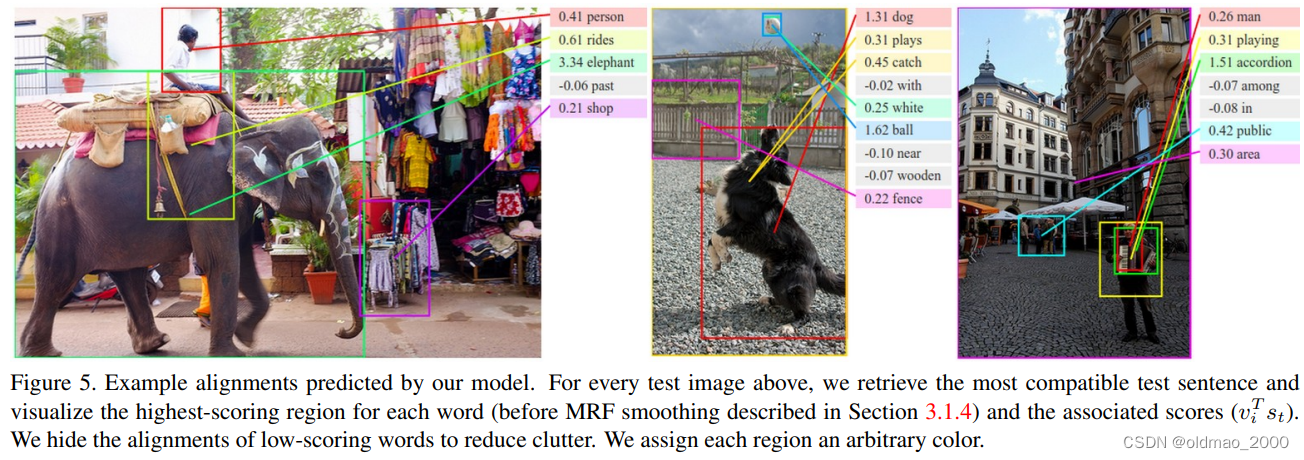

用于生成图像描述的深度视觉语义对齐 摘要:我们提出了一个模型,该模型生成图像及其区域的自然语言描述。 我们的方法利用图像数据集及其句子描述来了解语言和视觉数据之间的模态对应关系。 我们的对齐模型基于图像区域上的卷积神经网络,句子上的双向递归神经网络以及通过多模态嵌入将两种模态对齐的结构化目标的新颖组合。 然后,我们描述一种多模态递归神经网络架构,该架构使用推断的路线来学习生成图像区域的新颖描述。

Deep Visual-Semantic Alignments for Generating Image Descriptions 翻译

Abstract摘要We present a model that generates natural language descriptions of images and their regions. 我们提出一个模型来生成图像及其区域的自然语言描述。Our approach leverages datasets of images and their sentence descripti

(reading)Deep Visual-Semantic Alignments for Generating Image Descriptions

**作者:AK大神和李飞飞大神 ** 发表于2015年的CVPR 文章概述:这篇文章提出了一个视觉语义的对齐模型用来推断图像区域与语句片段的对应关系,并将对齐好的图像区域和语句片段作为训练数据,用来训练提出的另一个多模态的RNN模型,该模型通过输入测试图像最终生成该图像的文本描述。 过程: **视觉语义对齐模型通过构造一个结构化的目标函数,利用多模态嵌入空间来对齐视觉区域和语句片段。

【SEO】Meta Descriptions 对于 SEO 的重要性

【原文链接】https://www.wordstream.com/meta-description 元描述 (有时也称为元描述属性或标签) 是一种 HTML 元素。It describes and summarizes the contents of your page for the benefit of users and search engines. 虽然元数据对 SEO 排名不像

循环生成el-descriptions-item

0 后端返回数据格式 {"msg": "操作成功","code": 200,"data": {"id": 42,"contactInfo": [{"contactPerson": "张三","contactPhone": "13688888888"},{"contactPerson": "李四","contactPhone": ""},{"contactPerson": "","contactP

vue+elementUI 设置el-descriptions固定长度并对齐

问题描述 对于elementUI组件,el-descriptions 在以类似列表的形式排列的时候,上下无法对齐的问题。 问题解决 在el-descriptions 标签中,添加属性: :contentStyle="content_style" 控制其内容栏长度 <el-descriptions class="margin-top" :column="2" size="20px" bo

循环生成el-descriptions-item

0 后端返回数据格式 {"msg": "操作成功","code": 200,"data": {"id": 42,"contactInfo": [{"contactPerson": "张三","contactPhone": "13688888888"},{"contactPerson": "李四","contactPhone": ""},{"contactPerson": "","contactP

Distant Supervision for Relation Extraction with Sentence-Level Attention and Entity Descriptions

主要贡献 作者提出了基于句子级别的Attention模型来选择有效的句子。从FreeBase和Wikipedia页面去获取实体描述,从而弥补背景知识不足的缺陷,从而给实体更好的representation。做了很多实验,效果很好。 任务定义 所有句子被分到N组bags中, {B1,B2,⋯,Bi} { B 1 , B 2 , ⋯ , B i } \{ B_1,B_2,⋯,

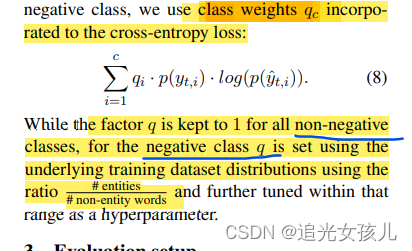

论文:Leveraging Type Descriptions for Zero-shot Named Entity Recognition and Classification

个人目前感觉,可借鉴意义不大。 前言 利用类型描述信息在zero-shot任务中,完成NERC任务。 没咋看懂。 存在问题:(1)每个class的description是如何构建的? 模型 将NER任务建模为多分类任务,预测每个token w的正确class。 argmax F (s,w,d),s是sentence,w是token,d是description . 模型encoder部分的输

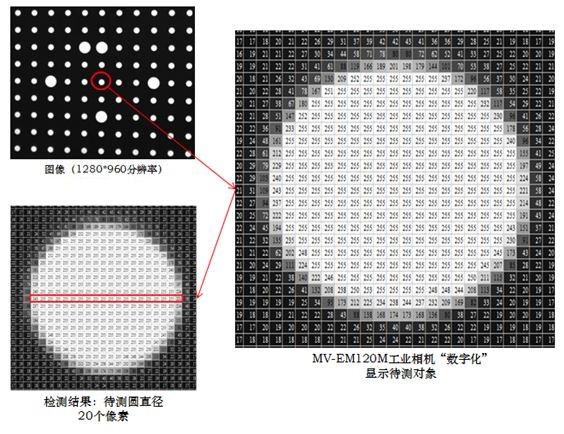

Halcon XLD: eXtended Line Descriptions 亚像素轮廓

XLD: eXtended Line Descriptions 亚像素轮廓 1、何谓亚像素? 面阵摄像机的成像面以像素为最小单位。例如某CMOS摄像芯片,其像素间距为5.2微米。摄像机拍摄时,将物理世界中连续的图像进行了离散化处理。到成像面上每一个像素点只代表其附近的颜色。至于“附近”到什么程度?就很困难解释。两个像素之间有5.2微米的距离,在宏观上可以看作是连在一起的。但是在微观上,它们之间

02.Deep Visual-Semantic Alignments for Generating Image Descriptions

目录 前言泛读摘要IntroductionRelated Work小结 精读Model3.1 学习对齐视觉与语言数据图片表征句子表征对齐目标损失函数解码文本片段对齐图像 MRNN生成描述优化 实验结论 代码 前言 本课程来自深度之眼《多模态》训练营,部分截图来自课程视频。 文章标题:Deep Visual-Semantic Alignments for Generating Im