本文主要是介绍视频去噪EMVD:Efficient Multi-Stage Video Denoising with Recurrent Spatio-Temporal Fusion 全文翻译,希望对大家解决编程问题提供一定的参考价值,需要的开发者们随着小编来一起学习吧!

摘要

近年来,基于深度学习的去噪方法以巨大的计算复杂度为代价,取得了无可比拟的性能。在这项工作中,我们提出了一种有效的多阶段视频去噪算法,称为EMVD,以大幅降低复杂性,同时保持甚至提高性能。首先,融合阶段通过递归组合视频中所有过去帧来减少噪声。然后,去噪阶段去除融合帧中的噪声。最后,细化阶段恢复在去噪帧中丢失的高频在去噪帧中恢复。所有阶段都在可学习和可逆线性算子获得的变换域表示上进行操作,这同时提高了模型的精度并降低了复杂性。最终输出的单个损失足以成功收敛,因此使EMVD易于训练。对真实原始数据的实验表明,当复杂性受到限制时,EMVD可以达到最先进的水平,甚至可以与复杂度高出几个数量级的方法相竞争。此外,EMVD的低复杂度和内存要求使得能够在移动设备的商用Soc上进行实时视频去噪。

1.引言

即使随着技术的进步,由于图像形成过程的随机性(如光子计数)[16],使用紧凑的相机硬件(如移动传感器或镜头)[42],以及具有挑战性的采集设置(如微光),数字图像始终受到一些固有或外部干扰因素的影响。因此,必须对低质量观测数据应用多种方法(即图像处理pipeline),以生成最终的高质量输出图像。去噪尤其重要,因为它通常位于pipeline的开始处,因此其输出对所有其他操作都有直接影响[39]。

在过去的几十年里,文献[5,12]中提出了大量的图像去噪算法,但目前的技术水平主要是基于卷积神经网络(CNN)的深度学习方法[43,25,27]。视频去噪模型利用了自然视频中固有的时间相关性,因此实现了比单帧方法更好的性能[28、1、30、36、42],然而,它们的计算要求使得在大多数硬件上无法实现实时处理,除非在图像质量上做出一些妥协[15]。

在这项工作中,我们提出了EMVD,一种有效的多阶段视频去噪方法,以大幅降低实现高质量结果所需的复杂性。首先,通过递归融合视频中所有过去的帧来减少输入帧中的噪声。然后,去噪阶段去除融合图像中的任何剩余噪声。最后,对去噪后的图像进行细化处理,通过自适应恢复高频细节进一步提高图像质量。所有阶段都是在可学习和可逆线性变换操作符生成的域内执行的,这些操作符联合去相关颜色和频率信息。如图1所示,所提出的EMVD能够以计算成本的一小部分跑赢更复杂的最新方法[42]。总之,这项工作的主要贡献是:

• 高质量高效去噪。EMVD通过专门的处理阶段利用自然视频的时空相关性,即时间融合、空间去噪和时空细化。这种设计允许在不影响其去噪能力的情况下显著降低模型复杂性。

• 可解释的设计。EMVD中的所有阶段都有一个明确的目标,并且在没有任何明确监督的情况下自然会收敛到所需的行为。因此,EMVD的内部工作在推理和训练时都可以很容易地检查和控制。

• 可学习和可逆转换。线性变换算子被实现为可学习的卷积层,用于最佳地解相关颜色和频率信息。可学习参数在损失中正则化,以确保变换的可逆性。这同时允许降低复杂性并提高模型的准确性。

2.相关工作

图像去噪。去噪是一个长期研究的研究课题[5,12],然而最近提出的大量工作[43,25,27,8]表明,人们对这个问题的兴趣仍然非常活跃,尤其是在实际原始数据的更具挑战性的情况下[3,20,23,9]。

经典方法大量利用非局部图像先验知识[4,12],至今仍能提供出色的性能。尽管这种方法是针对高斯噪声设计的,但当使用方差稳定变换(VST)时,这种方法也可以应用于实际原始数据[29]。最近,自开创性工作以来,深度学习和CNN已成为所有视觉问题的实际标准解决方案,包括去噪。基于CNN的方法最显著地利用了残差学习[43]、小波分解[27]、注意机制[25]和空间自适应处理[34,8]。

视频去噪。自然视频在时间维度上表现出很强的相关性,即连续帧中相应位置的像素可能非常相似。解释时间相关性的一种可行策略是,使用块匹配[28]、光流[7、32]、核预测网络[30]或可变形卷积[37、38]等方法明确估计视频中的运动。这样,可以在过滤之前对齐帧,以帮助执行恢复任务。然而,由于运动估计是一个具有挑战性且计算量大的问题,不同的研究方向建议通过时空注意模块等隐式处理运动,这些模块在不同的时间步递归聚合特征[22、41、38、13]。这些方法可进一步分类为多帧方法,其输入包括由模型联合处理的多个连续帧[28、11、35、36、42],或循环方法,其中使用从前一时间步获得的图像[32、15]和/或特征[19、17]作为额外输入来估计当前帧。有几种型号的设计都考虑到了效率,但在大多数硬件上仍然无法实现实时计算[17、36],或者性能无法与最先进的技术媲美[15]。

3.方法

3.1 观测模型

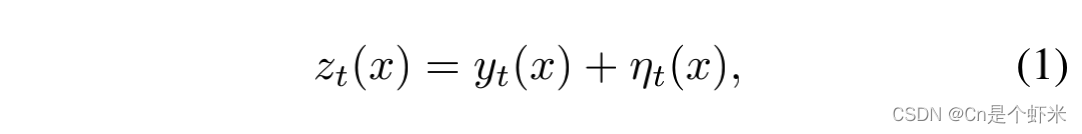

我们去噪算法的目标是从观测到的噪声数据中以非常低的复杂度获得干净视频的估计值。观测模型定义为

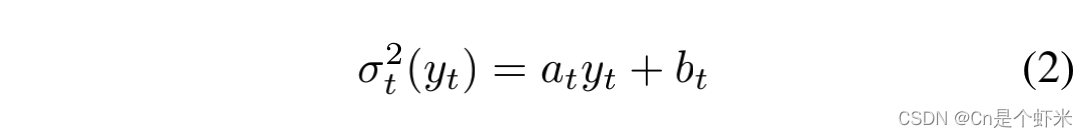

其中t∈ T⊂ N是视频中帧的时间索引,x∈ X⊂ N2是帧中的空间像素位置,z∈ RH×W×C是观察到的压缩形式的有噪声原始视频,具有H×W分辨率,C=4个颜色通道(例如RGGB),y是要估计的基本(未知)无噪声数据,ηt∼ N (0,σ2t(yt))是从具有信号相关方差的异方差高斯分布中提取的噪声实现

分别由at和bt∈ R参数化的信号相关(shot)和信号无关(read)噪声源建模。由于存在许多稳健的估计方法[16,2],我们假设已知给定传感器和摄像机ISO的此类噪声参数。

3.2 可学习可逆变换

该方法利用YUV和小波变换的可学习变换算子对原始数据的颜色和频率信息进行去相关。这些算子是线性的,设计为可逆的,因此可以作为标准卷积运算来实现,并故意调整权重。

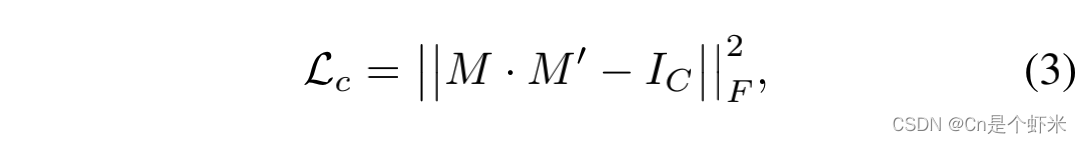

颜色变换。颜色变换Tc实现为逐点卷积,其核被约束为正交矩阵M∈ R C×C,将CFA图像中的C=4种颜色(例如RGGB)与亮度色度表示解相关[6]。作为颜色变换正交,其逆T-1c简单地实现为另一个点态卷积,核初始化为M′=M⊤. 在这项工作中,正矩阵和逆矩阵中的权重不共享,以允许更多的自由度。因此,得到的变换是双正交的,其可逆性由定义为

其中·是矩阵乘法,IC是秩C的单位矩阵,||·||F表示Frobenius范数。

频率变换。受双正交小波的启发,我们设计了一个变换Tf:R H×W×C→ R H/2×W/2×4C将输入频率解相关为四个半分辨率分量,即低通LL和高通{LH,HL,HH}子带。该变换再次是线性的,因此可以实现为四个n×n核的跨步卷积,这些核初始化为一些选定的小波分解滤波器ψ∈ R2×n的外积,为n∈ N+小波滤波器的(偶数)长度(例如,对于Haar,N=2)。相反,逆算子T-1f被实现为转置卷积,其核这次从相应的重构滤波器φ初始化∈ R2×n。请注意,相同的Tf可以递归应用于LL子带,以产生输入的多尺度分解。

我们通过在滤波器的矩阵形式上添加一个损失项来强制变换的可逆性,如下所示

其中I2是秩2的单位矩阵。因此,提出的方法是学习频率变换的一维滤波器表示,而不是学习核的卷积形式。另一种策略是强制学习的滤波器遵循小波参数模型[40]。因此,我们的方法可能会生成不满足基本小波特性的滤波器,但是我们的滤波器有更多的自由度,并且仍然会生成可逆变换。

注意颜色和频率变换Tc◦ Tf的组成仍然是线性和可逆的。两种变换的联合应用可以同时提高模型的精度并降低复杂性,因为图像有意义部分的能量与噪声能量不相关,同时数据的空间分辨率减半。图2示出了所提议的EMVD的示意图。在本文的其余部分中,我们将假设数据已经在变换域中给出,因此,为了简化注释,我们将省略变换运算符。

3.3 融合阶段

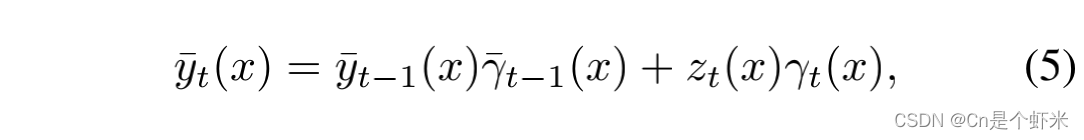

EMVD的第一个处理阶段是时序融合。该阶段的目标是使用视频中固有的时间相关性最大限度地减少图像中的噪声,而不会引入任何时间伪影或降低图像结构。形式上,融合定义为递归凸组合

其中,zt是时间t处的变换噪声帧,yt-1是前一时间t-1处的变换融合输出帧,γ∈ R H/2×W/2×1是在任意给定变换域位置x∈ χ⊂ N H/2×W/2×4C满足条件γt-1(x)+ γt(x)=1的非负凸权重。等式(5)的初始条件为y0≡ z0,因为在时间t=0时没有前一帧可用。请注意,γ的通道数为1,因此通过元素广播实现完整4C输入通道的融合。因此,我们对输入帧的每个通道(即子带)应用相同的权重。可以为不同的输入通道预测不同的权重,但这将显著增加预测任务的难度以及内存需求。

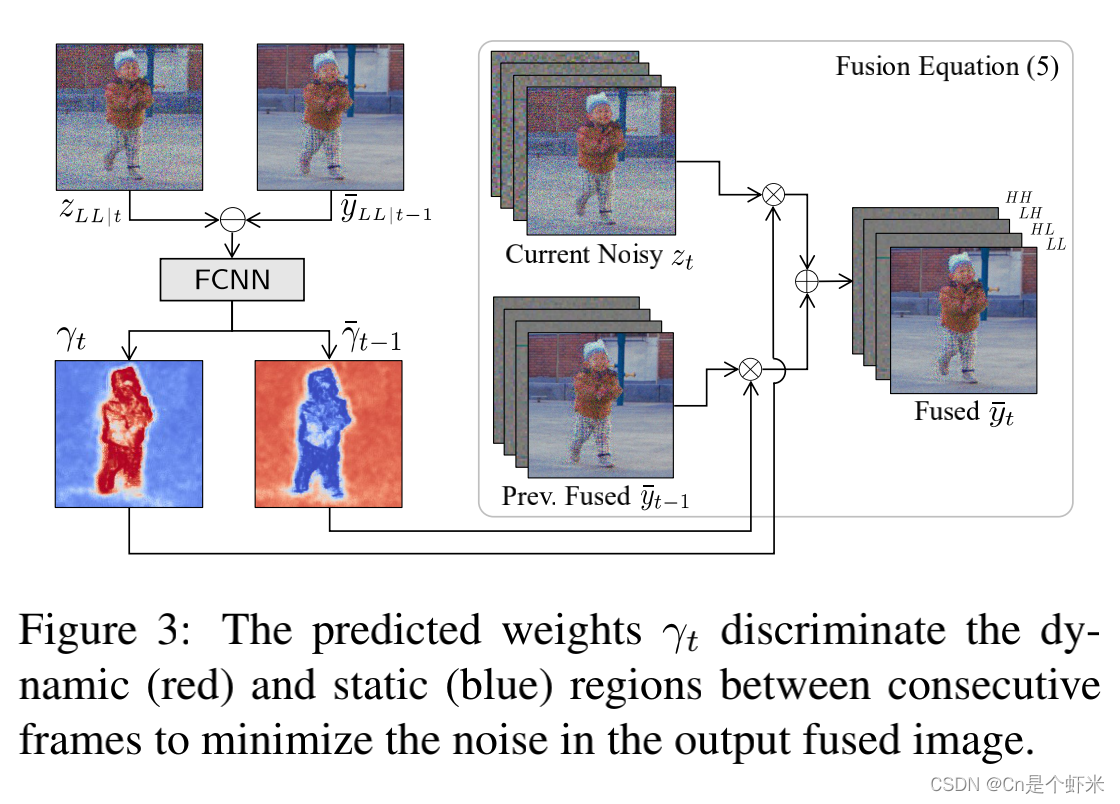

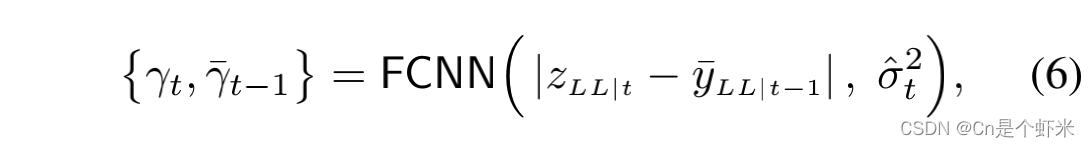

(5)中的权重由融合网络预测,我们称之为FCNN,定义如下: 其中|·|表示绝对值,zLL|t是变换后的噪声输入帧的低通,yLL|tt-1是前一个融合帧的低通,σˆ2t=σ2t(zLL|t)是按(2)计算的输入帧方差。注意,使用zt的低通作为(未知)无噪声yt的代理来近似方差。为了保持(5)的凸性,FCNN的输出层由一个sigmoid函数激活。图3示出了融合网络的图;注意预测权重γt是如何将动态区域与静态区域清楚地分开的。结果,通过对传入帧进行自适应平均来生成输出融合图像。请注意,融合是在较低的图像分辨率下执行的,任何给定比例i的单个位置实际上对应于原始图像中的2i×2i邻域,因此允许一定程度的运动补偿。如图2所示,当多个尺度可用时,从较低尺度的融合阶段获得的权重被上采样并连接到(6)的输入以提供额外的引导信息。

其中|·|表示绝对值,zLL|t是变换后的噪声输入帧的低通,yLL|tt-1是前一个融合帧的低通,σˆ2t=σ2t(zLL|t)是按(2)计算的输入帧方差。注意,使用zt的低通作为(未知)无噪声yt的代理来近似方差。为了保持(5)的凸性,FCNN的输出层由一个sigmoid函数激活。图3示出了融合网络的图;注意预测权重γt是如何将动态区域与静态区域清楚地分开的。结果,通过对传入帧进行自适应平均来生成输出融合图像。请注意,融合是在较低的图像分辨率下执行的,任何给定比例i的单个位置实际上对应于原始图像中的2i×2i邻域,因此允许一定程度的运动补偿。如图2所示,当多个尺度可用时,从较低尺度的融合阶段获得的权重被上采样并连接到(6)的输入以提供额外的引导信息。

最后,(6)可以解释为1×1核的核预测网络[30]的特例,因此(5)可以简单地扩展为一般(卷积)形式,如下所示: ⊛ 表示卷积,k是应用于带噪帧的大小为p×p的空间自适应核,kt-1是应用于前一帧的大小为p×p的核。实际上,可以通过让融合网络的输出层预测由softmax函数激活的p2+p2通道来获得(7)中的核,以确保融合方程仍然是凸的。

⊛ 表示卷积,k是应用于带噪帧的大小为p×p的空间自适应核,kt-1是应用于前一帧的大小为p×p的核。实际上,可以通过让融合网络的输出层预测由softmax函数激活的p2+p2通道来获得(7)中的核,以确保融合方程仍然是凸的。

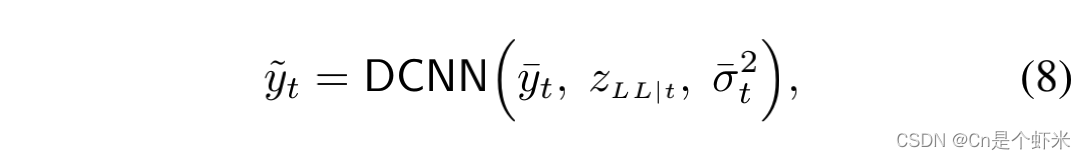

3.4 去噪阶段

输出融合图像yt中的噪声经过等式(5)降低了,但没有完全降低。例如,当运动无法得到有效补偿,或者当处理的时间数据量不足以增加帧中的信噪比(SNR)时,这不可避免地发生。因此,我们使用一个称为DCNN的去噪网络来去除yt中的任何剩余噪声: 其中,yt是去噪图像,σ2t是融合图像yt的噪声方差。输入还包括当前噪声帧zLL|t的低通,以便网络有机会从未经衰减的噪声输入中提取有价值的信息。当有多个比例可用时,以较低比例估计的图像将连接到(8)的输入。

其中,yt是去噪图像,σ2t是融合图像yt的噪声方差。输入还包括当前噪声帧zLL|t的低通,以便网络有机会从未经衰减的噪声输入中提取有价值的信息。当有多个比例可用时,以较低比例估计的图像将连接到(8)的输入。

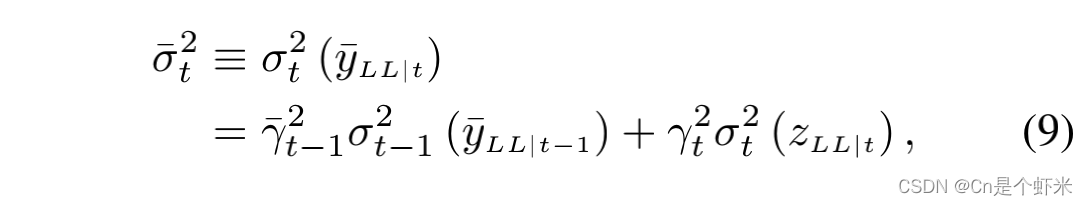

对融合图像yt进行去噪比直接对输入zt进行去噪更容易,但方差σ2t的形式非常复杂,因为它取决于t帧处与信号相关的方差以及融合所有先前帧t∈ {0,…,t t 1}的累积效应。尽管如此,融合本身是线性的,所以我们可以通过将(5)扩展为(2),使用基本统计特性1定义融合方差的递归公式,如下所示:

其中初始条件为σ2t(yLL | 0)≡ σ2t(zLL | 0),协方差项为零,因为我们假设噪声与时间无关。注意,由于对于所有的x和t而言γt(x)≤ 1,方差(9)是(非严格地)随时间递减的,因此证明了融合将逐步减少输入中的噪声这一直观想法是正确的。

3.5 细化阶段

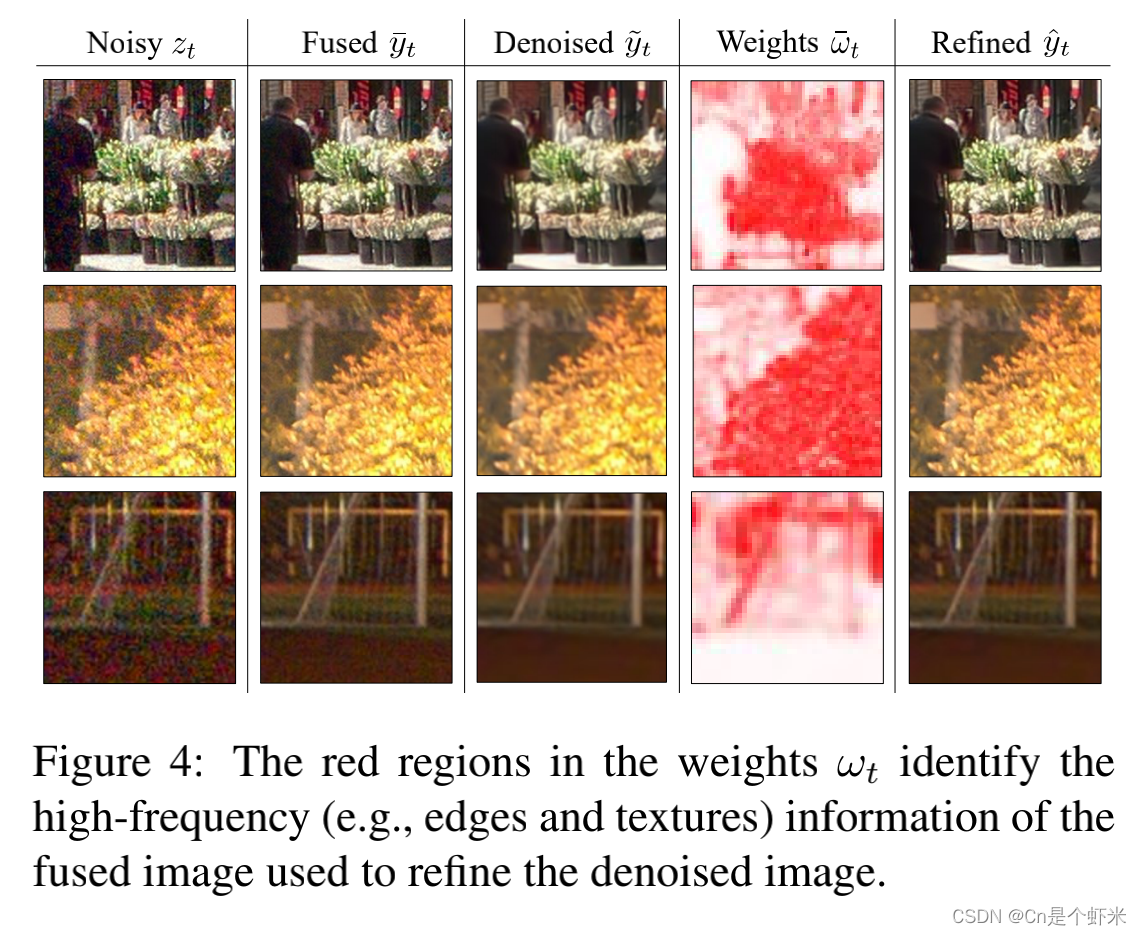

任何去噪方法都可能引入伪影和图像细节丢失,尤其是当输入图像的信噪比很低或模型的复杂性受到显著限制时。因此,我们建议使用最后的细化阶段将细节但仍有噪声的融合图像yt与无噪声但可能过平滑的去噪图像y~t相结合。在这样做的过程中,我们希望恢复通过去噪可能移除的精细细节和纹理,这项任务通过我们学习的频率表示来实现,该频率表示自然地将低频到高频信息去相关。形式上,我们寻求求解一个精化方程 对于所有x,凸权重满足ω′t(x)+ωОt(x)=1∈ χ。细化权重由另一个称为RCNN的网络预测,其操作如下:

对于所有x,凸权重满足ω′t(x)+ωОt(x)=1∈ χ。细化权重由另一个称为RCNN的网络预测,其操作如下: 其中,通过在最终输出层上应用sigmoid激活再次确保输出权重的凸性。尽管公式(10)与融合方程(5)等效,但细化权重ω的含义与融合权重γ的含义明显不同。事实上,如图4所示,细化权重用于从融合图像中识别高频信息,而融合权重用于在连续帧之间递归聚合一致的时序信息,以减少噪声的影响。有趣的是,不需要明确的监督就可以收敛到这种行为。

其中,通过在最终输出层上应用sigmoid激活再次确保输出权重的凸性。尽管公式(10)与融合方程(5)等效,但细化权重ω的含义与融合权重γ的含义明显不同。事实上,如图4所示,细化权重用于从融合图像中识别高频信息,而融合权重用于在连续帧之间递归聚合一致的时序信息,以减少噪声的影响。有趣的是,不需要明确的监督就可以收敛到这种行为。 如图2所示,细化网络仅在频率分解的较高尺度下使用,虽然在较低尺度可用时也是如此。最后,我们强调(11)可以扩展到预测任意大小的核,类似于[30]。

如图2所示,细化网络仅在频率分解的较高尺度下使用,虽然在较低尺度可用时也是如此。最后,我们强调(11)可以扩展到预测任意大小的核,类似于[30]。

4 实验

我们将提出的EMVD与各种最先进的视频去噪方法进行比较,即VBM4D[28]、RViDeNet[42]、FastDVDnet[36]和EDVR[38]。在我们的实验中,我们展示了上述模型在不同复杂程度上的性能,以浮点运算(FLOPs)来衡量。附加技术细节和实验可在补充材料中找到。

为了评估我们的模型,我们使用了[42]中提出的视频基准数据集。这包括由SONY IMX385传感器捕获的真实原始视频数据集(CRVD)和由[10]生成的合成数据集(SRVD);所有视频都有五个不同的ISO级别,从1600到25600不等。在[42]之后,我们使用SRVD视频和CRVD的场景1-6进行培训,因此保留CRVD场景7-11进行客观验证。CRVD还包括一些没有ground truth的室外有噪音的原始视频,我们将其用作主观评估视觉质量的测试集。

4.1 训练

我们使用由n块大小为128×128的补丁组成的训练序列,这些补丁在训练视频的随机时空位置裁剪,以保持CFA Bayer模式[26]。具体而言,我们使用n=3表示RViDeNet,n=5表示FastDVDnet和EDVR,n=25表示EMVD。请注意,EMVD是一个循环模型,因此受益于较大的n值,因为模型在训练期间会暂时展开,以允许时序反向传播。不同的是,RViDeNet、FastDVDnet和EDVR是多帧方法,因此n等于其输入中使用的帧数。

损耗定义为L=Lr+Lc+Lf:

其中Lr表示序列中每个预测yˆt和ground truth的yt帧之间差值的平均L1范数,Lc和Lf分别是约束颜色(3)和频率(4)变换可逆性的项。我们使用Adam optimizer(24)对网络进行训练,批量大小为16,初始学习率为1e-4。我们采用分段常数衰减,每100000次迭代将学习率降低10倍。所有模型在CRVD和SRVD数据集上进行初始300000次迭代的训练,然后仅在CRVD上进行额外300000次迭代的微调。我们使用华为MindSpore[31]和TensorFlow实现了提出来的EMVD;两种实现都显示出相当的准确性和效率。

对于RViDeNet,我们直接利用了作者提供的模型和权重,并且我们使用原始论文中建议的相同三阶段程序以降低复杂性的方式训练版本[42]。对于VBM4D,我们在目标sRGB图像上执行网格搜索,以找到最大化验证PSNR的最佳参数。

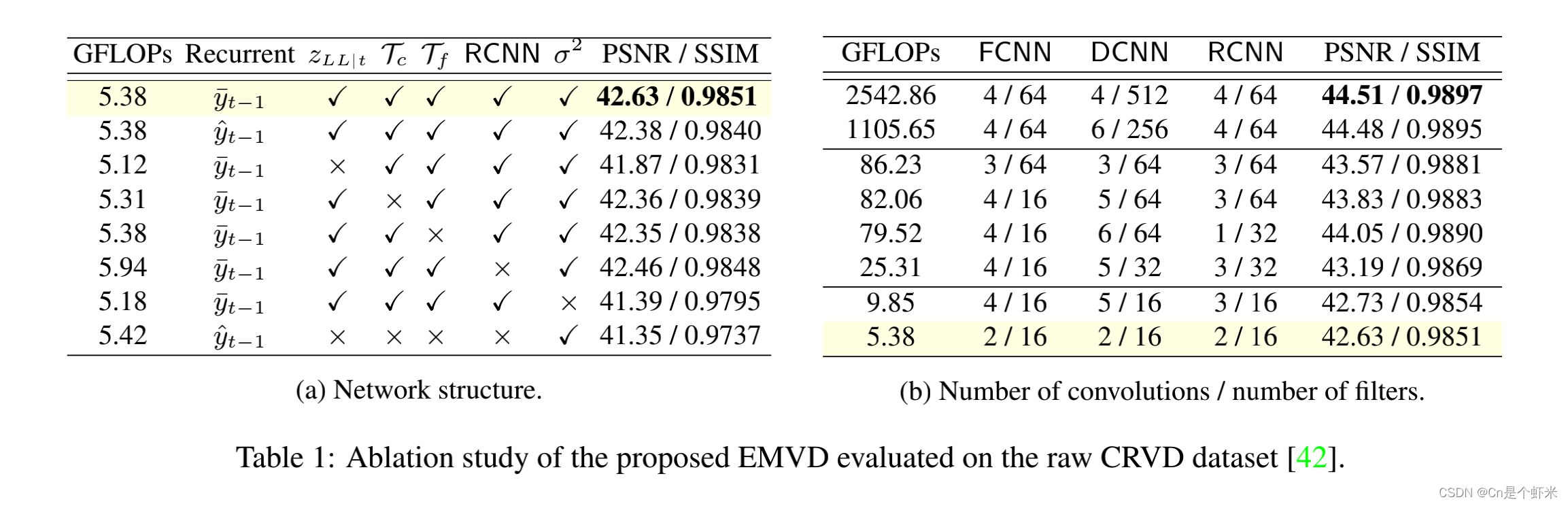

4.2 消融实验

Baseline。EMVD含有三个CNN。可以使用任何主干,但为了效率起见,在所有情况下,我们都使用两个卷积层(3×3内核,16个过滤器),然后再进行ReLU激活加上一个最终输出卷积。在处理之前,输入(即图像和方差)始终串联在一起。融合和细化CNN的输出层都由一个sigmoid激活,但不激活去噪CNN。我们使用三个分解尺度。频率变换用Haar核初始化,颜色变换按[6]中的方式初始化。该配置在所有表格中以黄色突出显示,对应于5.38 GFLOP。 网络结构。表1a报告了拟定方法结构的消融实验研究。在融合(6)中,如果我们使用先前的最终输出yˆ而不是先前的融合图像y',则PSNR降低0.25dB;相反,如果我们从去噪(8)中去除低通噪声输入zLL | t,则PSNR将降低0.76dB。颜色变换虽然只需花费0.08 GFLOPs,但可以提供相当大的0.27dB的提升,如果我们用pixel shuffle取代可学习的频率变换,则峰值信噪比会降低0.28dB。然后,如果我们移除细化阶段,同时增加去噪网络的容量,以不改变整体复杂度,我们会观察到0.17dB的下降。接下来,我们表明,从所有网络中移除方差σ2输入(即,盲模拟)会导致非常显著的1.24dB PSNR下降。最后,在最后一行中,我们展示了当融合和细化都被禁用时,下降幅度更大(1.28dB)。

网络结构。表1a报告了拟定方法结构的消融实验研究。在融合(6)中,如果我们使用先前的最终输出yˆ而不是先前的融合图像y',则PSNR降低0.25dB;相反,如果我们从去噪(8)中去除低通噪声输入zLL | t,则PSNR将降低0.76dB。颜色变换虽然只需花费0.08 GFLOPs,但可以提供相当大的0.27dB的提升,如果我们用pixel shuffle取代可学习的频率变换,则峰值信噪比会降低0.28dB。然后,如果我们移除细化阶段,同时增加去噪网络的容量,以不改变整体复杂度,我们会观察到0.17dB的下降。接下来,我们表明,从所有网络中移除方差σ2输入(即,盲模拟)会导致非常显著的1.24dB PSNR下降。最后,在最后一行中,我们展示了当融合和细化都被禁用时,下降幅度更大(1.28dB)。

容量分配。在表1b中,我们报告了EMVD如何受到每个阶段中滤波器和卷积数量的影响。我们的实验表明,将更多的容量用于去噪CNN是有益的(因为去噪是最困难的阶段),同时可以在不显著影响性能的情况下降低融合和细化CNN的容量。

递归融合。我们使用之前的融合图像y_t-1作为融合的输入,这比使用之前的输出帧yˆt-1或带噪帧zt-1更好,因为我们的目标是在不去除图像细节的情况下最大限度地降低噪声。事实上,使用有噪声的zt-1最多可以将噪声方差减少2倍,从而有效地将我们的递归模型减少为多帧模型。然后,如表1a所示,使用输出y_t-1也不是最理想的。这可能与直觉相反,但由于去噪应用于y_t-1,那么递归方差(9)将不再允许封闭形式的定义(因为去噪是非线性的),并且图像中的一些高频信息可能会过平滑甚至丢失。 融合预测。在表2中,我们比较了使用不同核大小的验证核预测融合(7)。第一行对应于表1b中定义的具有元素级融合(即1×1核)的性能最好的基线模型。我们比较了分别应用于先前融合图像和当前噪声图像的核p‘×p’和p×p的不同大小(高达5×5)。我们观察到,在前一幅图像上使用大的核更为有利,这实际上是需要运动补偿的地方,并且该策略在相对有限的复杂度增加的情况下将PSNR提高了约0.1dB。

融合预测。在表2中,我们比较了使用不同核大小的验证核预测融合(7)。第一行对应于表1b中定义的具有元素级融合(即1×1核)的性能最好的基线模型。我们比较了分别应用于先前融合图像和当前噪声图像的核p‘×p’和p×p的不同大小(高达5×5)。我们观察到,在前一幅图像上使用大的核更为有利,这实际上是需要运动补偿的地方,并且该策略在相对有限的复杂度增加的情况下将PSNR提高了约0.1dB。

4.3 实验结果

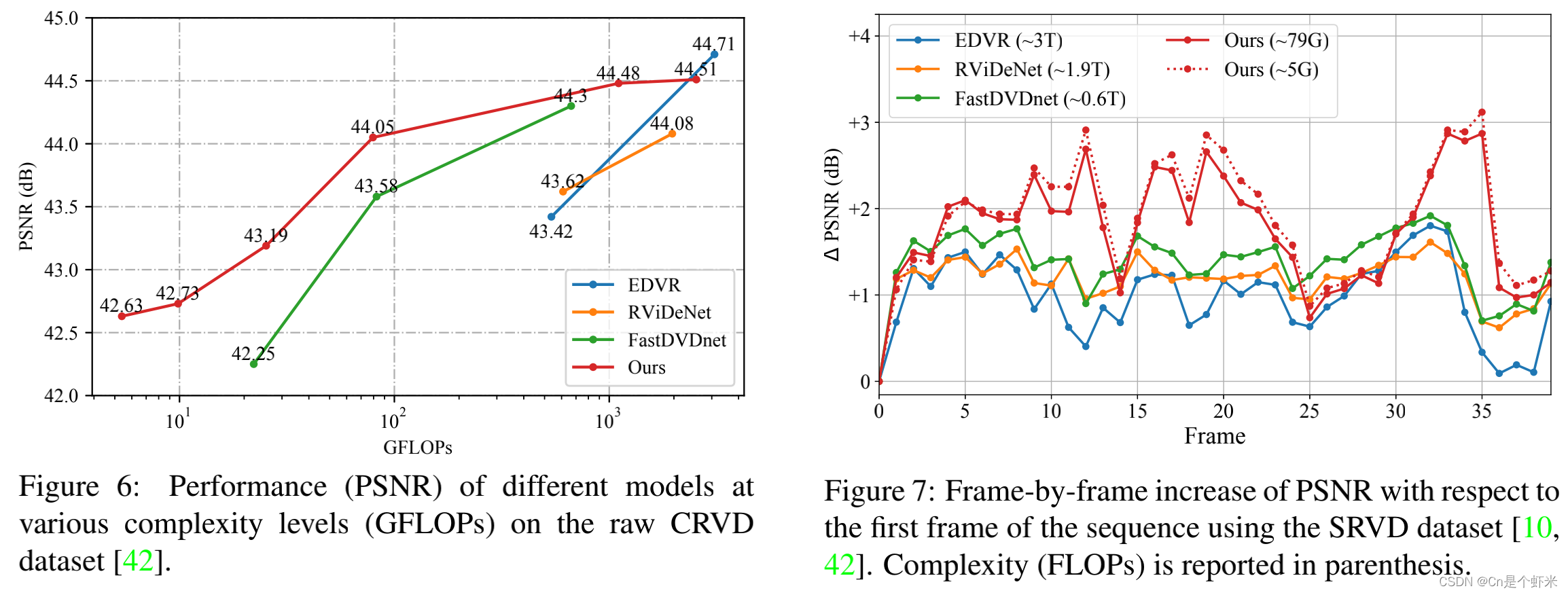

表3和图6显示了所有比较模型的客观结果。我们用†低复杂度实现来表示,通过均匀减少卷积层和通道的数量来实现。我们的实验表明,当GFLOPs低于100时,所提出的EMVD方法的性能明显优于所有比较的方法,并且随着复杂度的降低,PSNR的改善增加到1dB以上。请注意,我们没有提供复杂度低于100 GFLOPs的RViDeNet和EDVR的结果,因为此类模型无法在该范围内收敛。表1b中给出了所提出方法在不同复杂程度下的网络结构细节。补充材料中讨论了更多的技术实施细节。

有趣的是,EMVD甚至能够与具有更高复杂性的最先进方法相比保持良好的优势。例如,如果我们将约79 GFLOPs的EMVD与25×更大的RViDeNet进行比较,我们只观察到PSNR损失0.03dB。这证实了我们的方法能够在严格的计算预算下运行,而不会显著降低性能和图像质量。在图5中,我们显示了ISO 25600中捕获的CRVD数据集中几个测试视频的视觉比较。图中背景中的砖块和树木表明,EDVR和FastDVDnet生成的细节比RViDeNet更好。所提出的EMVD在静态和动态区域都能产生最令人满意的视觉效果,尽管其复杂度比EDVR低573倍,比RViDeNet低364倍。

有趣的是,EMVD甚至能够与具有更高复杂性的最先进方法相比保持良好的优势。例如,如果我们将约79 GFLOPs的EMVD与25×更大的RViDeNet进行比较,我们只观察到PSNR损失0.03dB。这证实了我们的方法能够在严格的计算预算下运行,而不会显著降低性能和图像质量。在图5中,我们显示了ISO 25600中捕获的CRVD数据集中几个测试视频的视觉比较。图中背景中的砖块和树木表明,EDVR和FastDVDnet生成的细节比RViDeNet更好。所提出的EMVD在静态和动态区域都能产生最令人满意的视觉效果,尽管其复杂度比EDVR低573倍,比RViDeNet低364倍。

在图7中,我们使用SRVD数据集(MOT17-01综合ISO 25600)分析比较模型的时间行为[10,42]。特别是,该图显示了相对于序列初始帧的逐帧PSNR差异。我们注意到,RViDeNet、FastDVDnet和EDVR的峰值信噪比在初始预热期后平均稳定。事实上,多帧方法的性能受这些模型在任何给定时间设计用于处理的帧数量的限制。不同的是,所提出的EMVD是一种递归方法,因此通过累积长期的时间依赖性,它能够在大多数序列中实现显著更高的PSNR。然而,多帧方法在动态场景(即帧25–30)中有一点优势,因为它们可以访问未来的帧。尽管如此,即使在这些情况下,所提出的EMVD也能够非常快速地恢复,因为在仅处理几帧后,它比所有其他方法的峰值信噪比(PSNR)高出2dB以上。

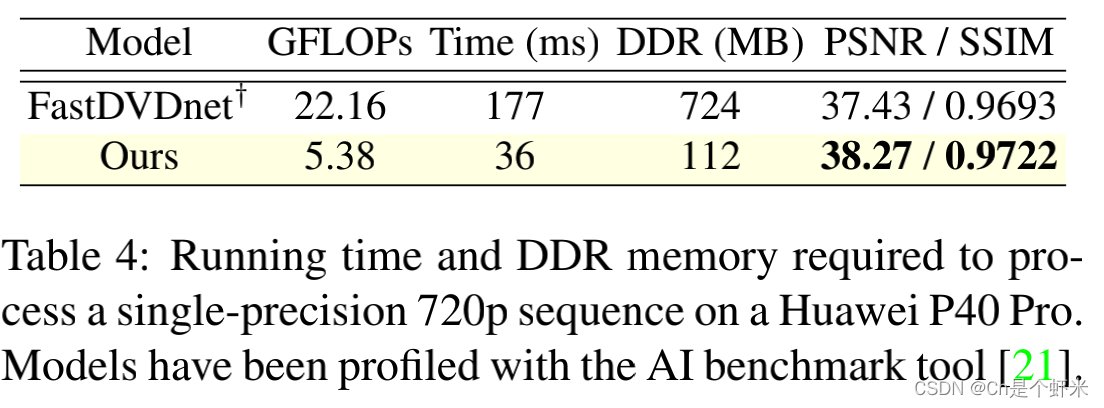

最后,表4报告了使用AI基准工具在商用SoC(华为P40 Pro智能手机)上分析的片上运行时间和内存使用情况[21]。结果表明,我们的方法可以获得实时性能(~30fps),同时在计算要求(4.9×更快的推理速度,6.5×更少的内存)以及客观性能(0.84dB更好的峰值信噪比)方面仍优于参考的低复杂度方法FastDVDNet。

5 结论

在这项工作中,我们提出了EMVD,这是一种高效的视频去噪方法,它通过以循环方式应用的多个级联处理阶段,即时间融合、空间去噪和时空细化,递归地利用自然视频中固有的时空相关性。

这种多阶段设计,加上可学习和可逆的解相关变换,可以显著降低模型复杂性,而不会严重影响其性能。有趣的是,每个阶段使用的CNN在没有明确监督的情况下(即损失中的额外条款)收敛到所需的行为,因此使拟议模型易于训练。此外,我们可以通过检查每个阶段(图3和图4)的输出来了解模型的内部工作,这反过来又可以解释和理清空间和时间处理的影响。

所提出的EMVD(1)在复杂度受到约束时显著优于其他最先进的视频恢复方法,(2)甚至在比较模型的复杂度高出几个数量级时仍具有竞争力(图6)。此外,我们还验证了EMVD在商用SoC(表4)上以有限的内存占用实现实时性能(720p时为e30fps),从而证明所提出的方法可以实际用于移动设备上的视频处理。

这篇关于视频去噪EMVD:Efficient Multi-Stage Video Denoising with Recurrent Spatio-Temporal Fusion 全文翻译的文章就介绍到这儿,希望我们推荐的文章对编程师们有所帮助!