本文主要是介绍NVIDIA发布Nemotron-4 340B 用于生成高质量的合成数据,希望对大家解决编程问题提供一定的参考价值,需要的开发者们随着小编来一起学习吧!

Nemotron-4 340B 是一系列为 NVIDIA NeMo 和 NVIDIA TensorRT-LLM 优化的模型,包括最先进的指令和奖励模型,以及用于生成式 AI 训练的数据集。

英伟达今日宣布推出 Nemotron-4 340B,这是一系列开放模型,开发者可以使用它们生成用于训练大型语言模型(LLM)的合成数据,以应用于医疗、金融、制造、零售及其他各行各业的商业应用。

高质量的训练数据在定制 LLM 的性能、准确性和响应质量中起着至关重要的作用,但健全的数据集通常价格高昂且难以获取。

通过一种独特的宽松开放模型许可,Nemotron-4 340B 为开发者提供了一种免费的、可扩展的方式来生成合成数据,从而帮助构建强大的 LLM。

Nemotron-4 340B 系列包括基础模型、指令模型和奖励模型,这些模型构成了一个管道,用于生成训练和改进 LLM 所需的合成数据。这些模型经过优化,可与 NVIDIA NeMo 一起工作,NVIDIA NeMo 是一个用于端到端模型训练的开源框架,包括数据策划、定制和评估。它们也经过优化,可与开源的 NVIDIA TensorRT-LLM 库进行推理。

Nemotron-4 340B 现已可以从 Hugging Face 下载。开发者很快可以在 ai.nvidia.com 访问这些模型,届时它们将被打包为 NVIDIA NIM 微服务,具有标准应用编程接口,可以部署到任何地方。

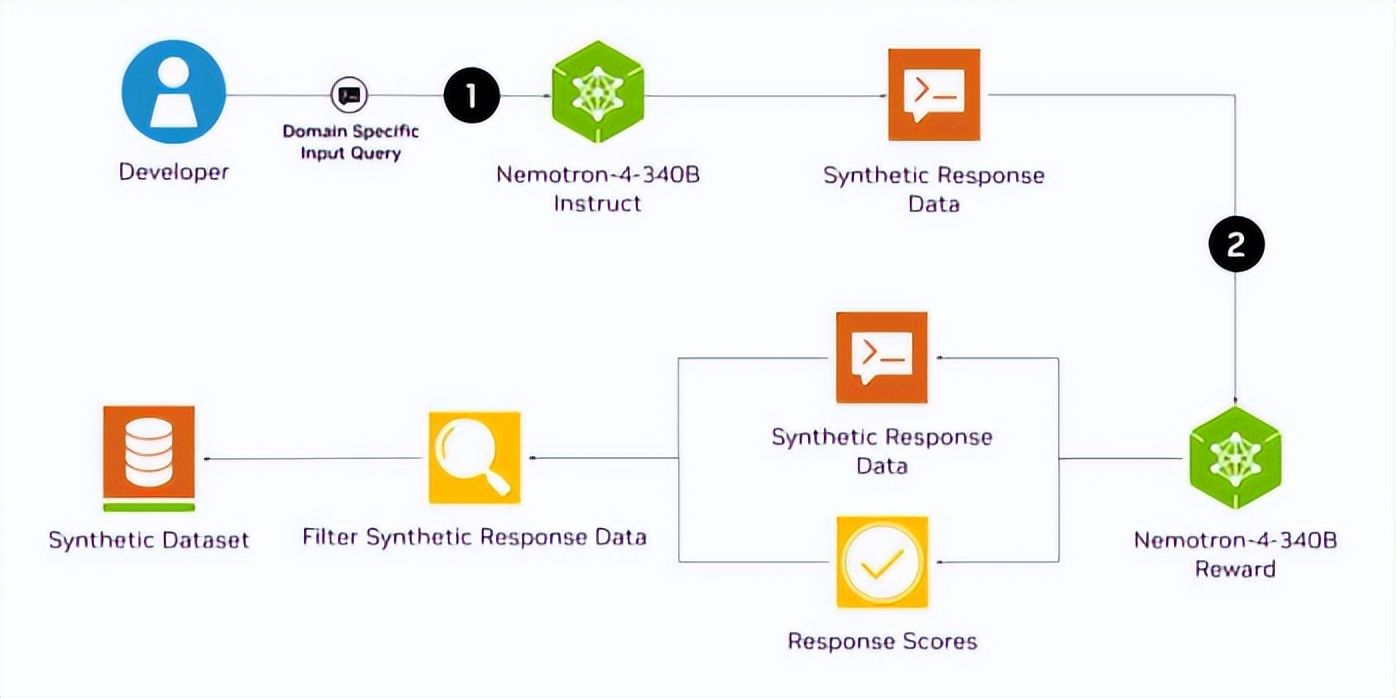

使用 Nemotron 生成合成数据 LLM 可以帮助开发者在无法获取大量、多样的标注数据集的情况下生成合成训练数据。

Nemotron-4 340B 指令模型创建的多样化合成数据模拟了真实世界数据的特征,有助于提高数据质量,从而提升定制 LLM 在各个领域的性能和鲁棒性。

接着,为了提升 AI 生成数据的质量,开发者可以使用 Nemotron-4 340B 奖励模型来筛选高质量的响应。Nemotron-4 340B 奖励模型根据五个属性对响应进行评分:有用性、正确性、一致性、复杂性和详细性。它目前在 Hugging Face 的 RewardBench 排行榜上名列第一,该排行榜由 AI2 创建,用于评估奖励模型的能力、安全性和潜在问题。

研究人员还可以通过使用其专有数据并结合包括的 HelpSteer2 数据集,定制 Nemotron-4 340B 基础模型来创建自己的指令或奖励模型。

使用 NeMo 微调和使用 TensorRT-LLM 优化推理 利用开源的 NVIDIA NeMo 和 NVIDIA TensorRT-LLM,开发者可以优化其指令和奖励模型的效率,以生成合成数据并对响应进行评分。

所有 Nemotron-4 340B 模型都经过 TensorRT-LLM 优化,利用张量并行技术,这是一种将单个权重矩阵拆分到多个 GPU 和服务器上的模型并行方法,从而实现大规模高效推理。

Nemotron-4 340B 基础模型在 9 万亿个标记上训练,可以使用 NeMo 框架进行定制,以适应特定的使用场景或领域。这一微调过程受益于广泛的预训练数据,并为特定下游任务生成更准确的输出。

通过 NeMo 框架提供多种定制方法,包括监督微调和参数高效微调方法,如低秩适应(LoRA)。

为了提升模型质量,开发者可以使用 NeMo Aligner 和由 Nemotron-4 340B 奖励模型标注的数据集对其模型进行对齐。对齐是训练 LLM 的关键步骤,通过使用人类反馈强化学习(RLHF)等算法微调模型行为,以确保其输出安全、准确、上下文适当并符合预期目标。

需要企业级支持和生产环境安全性的企业可以通过云原生的 NVIDIA AI Enterprise 软件平台访问 NeMo 和 TensorRT-LLM,该平台为生成式 AI 基础模型提供加速和高效的运行时。

评估模型安全性并开始使用 Nemotron-4 340B 指令模型经过了广泛的安全评估,包括对抗性测试,并在各种风险指标上表现良好。用户仍应对模型的输出进行仔细评估,以确保生成的合成数据适合、安全且准确地用于他们的使用场景。

高性价GPU活动:https://www.ucloud.cn/site/active/gpu.html?ytag=gpu_wenzhang_tongyong_shemei

这篇关于NVIDIA发布Nemotron-4 340B 用于生成高质量的合成数据的文章就介绍到这儿,希望我们推荐的文章对编程师们有所帮助!