本文主要是介绍每天五分钟深度学习:逻辑回归算法完成m个样本的梯度下降,希望对大家解决编程问题提供一定的参考价值,需要的开发者们随着小编来一起学习吧!

本文重点

上节课程我们学习了单样本逻辑回归算法的梯度下降,实际使用中我们肯定是m个样本的梯度下降,那么m个样本的如何完成梯度下降呢?

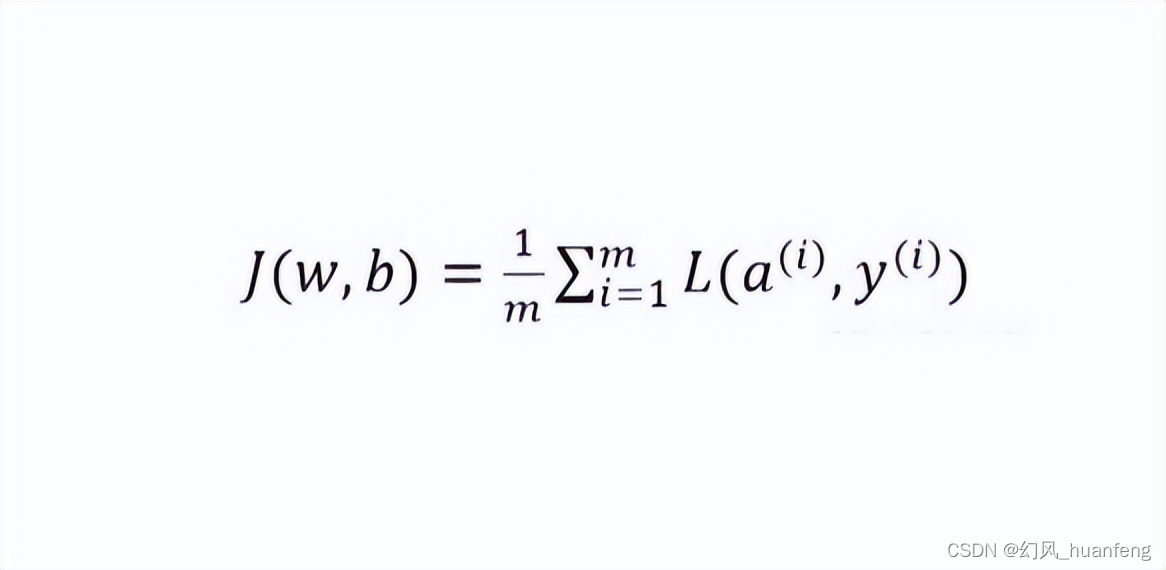

m个样本的损失函数定义为:

我们定义第i个样本的dw、db为:

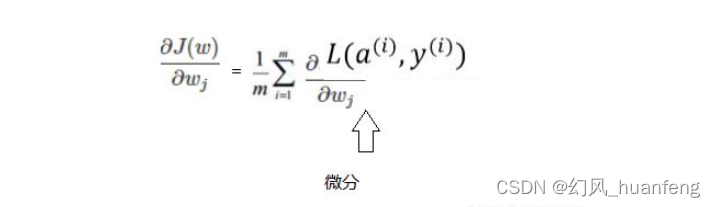

dw和db为损失J对w和b的偏导数,因为m个样本的代价函数J是1到m个样本总损失的平均。所以m个样本代价函数对wj的微分也同样是各项样本损失对wj微分的平均。

对比来说单个样本就是求出dw就ok了,而m个样本就是求出m个样本的dw然后加起来求平均,这就是求m个样本求dw的方式。(dw表示损失函数对参数w的偏导数)

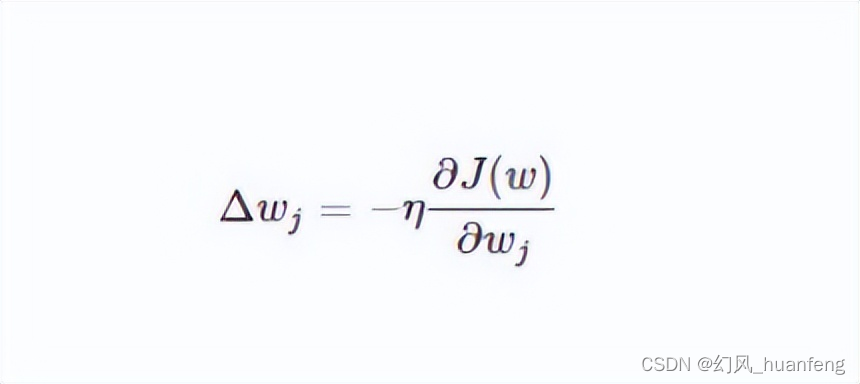

求出m个样本的dw之后,我们就可以将其直接应用到梯度下降算法了。

伪代码表示为:

这篇关于每天五分钟深度学习:逻辑回归算法完成m个样本的梯度下降的文章就介绍到这儿,希望我们推荐的文章对编程师们有所帮助!