本文主要是介绍(2024,示例记忆,模型记忆,遗忘,差分评估,概率评估)深度学习中的记忆:综述,希望对大家解决编程问题提供一定的参考价值,需要的开发者们随着小编来一起学习吧!

Memorization in deep learning: A survey

公和众和号:EDPJ(进 Q 交流群:922230617 或加 VX:CV_EDPJ 进 V 交流群)

目录

0 摘要

1 引言

0 摘要

深度神经网络(DNNs)驱动的深度学习(DL)已经在各个领域引发了革命性变化,但理解 DNN 决策和学习过程的复杂性仍然是一个重大挑战。最近的研究发现了一个有趣的记忆现象,即 DNN 倾向于记住示例中的具体细节,而不是学习一般图样(pattern),这会影响模型的泛化能力、安全性和隐私性。这引发了关于 DNN 泛化性质及其易受安全漏洞影响的关键问题。在本次调查中,我们提出了一个系统的框架,根据泛化和安全/隐私领域组织记忆的定义,并总结了在示例和模型级别的记忆评估方法。通过全面的文献回顾,我们探讨了 DNN 记忆行为及其对安全和隐私的影响。我们还介绍了由记忆引起的隐私漏洞以及遗忘现象,并探索其与记忆的联系。此外,我们重点介绍了利用记忆和遗忘机制的各种应用,包括噪声标签学习、隐私保护和模型增强。本次调查首次提供了对 DNN 记忆的理解,提供了有关其挑战和机遇的见解,以在增强 AI 发展的同时解决关键的伦理问题。

1 引言

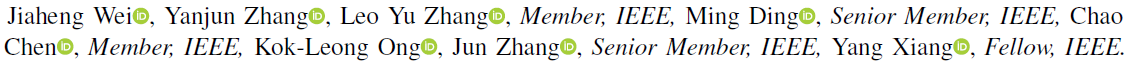

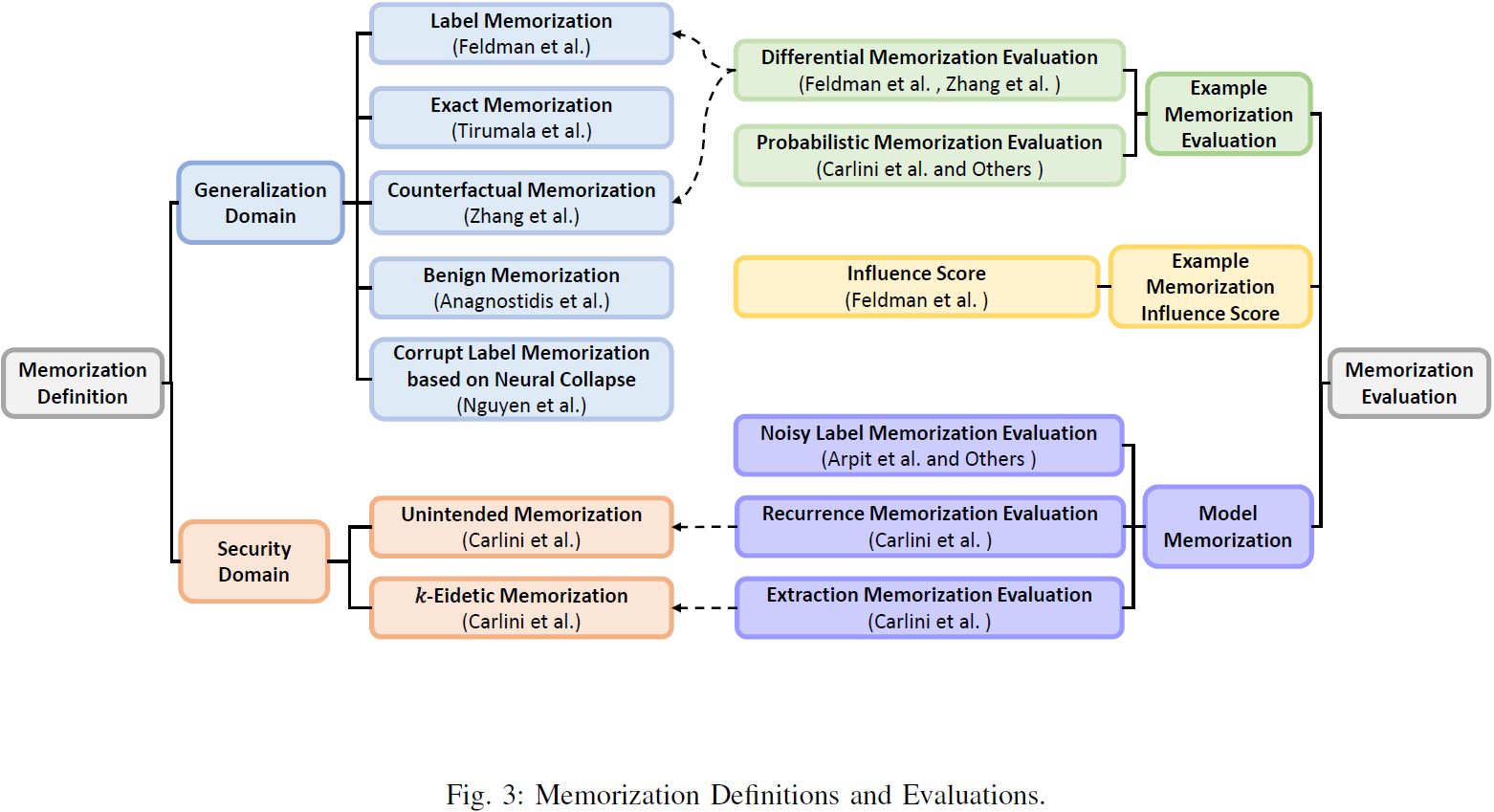

迄今为止,许多论文发现了神经网络在使用梯度下降训练过程中可能记住一些训练数据的记忆效应[9],[10],[8],[11],[12]。当前的记忆研究主要集中在两个领域:标准训练中的行为和安全/隐私风险。我们基于泛化和安全/隐私领域总结了文献中的显式记忆定义。然而,缺乏广泛采用的记忆定义,使得描述和讨论记忆概念变得具有挑战性。许多相关工作提供了不一致,有时甚至是相互矛盾的记忆定义。尤其是,许多工作直接将 “记忆” 一词作为 “学习” 和 “拟合” 的同义词使用。因此,我们采用以下术语来促进讨论:记忆学习(Memorization Learning)指的是 DNN 学习示例的具体细节或特定特征,而常见的图样学习(Pattern Learning)表示 DNN 学习数据分布的常见模式或泛化特征。在图 1a 中,我们使用大型语言模型来说明记忆学习和图样学习。我们使用 “泛化” 一词来定义模型在新的、未见过的数据上的表现。如果没有额外解释,所有类似 “记忆”、“记忆效应” 和 “记忆现象” 的术语都指记忆学习。此外,我们认为模式学习和记忆学习共同构成了 DNN 的学习路径。

此外,记忆是一个复杂的概念,需要我们在各种层次上考虑它。在我们看来,记忆学习和图样学习在特征层次上运作。然而,直接理解神经网络的特征对人类来说极其困难。因此,我们主要在示例级别和模型级别上研究记忆,如图 1b 所示。

直观上,示例记忆和模型记忆表示研究对象是示例和模型。因此,不同层次的记忆概念激发了不同的记忆评估方法。示例记忆评估尝试确保一个示例是否被记住,包括差分评估(differential evaluation)和概率评估。另一方面,模型记忆评估衡量模型记住的程度或模型的记忆能力。我们将各种方法总结为三种主要方法:有噪标签评估、重复性评估和提取评估(noisy label evaluation, recurrence evaluation, and extraction evaluation)。

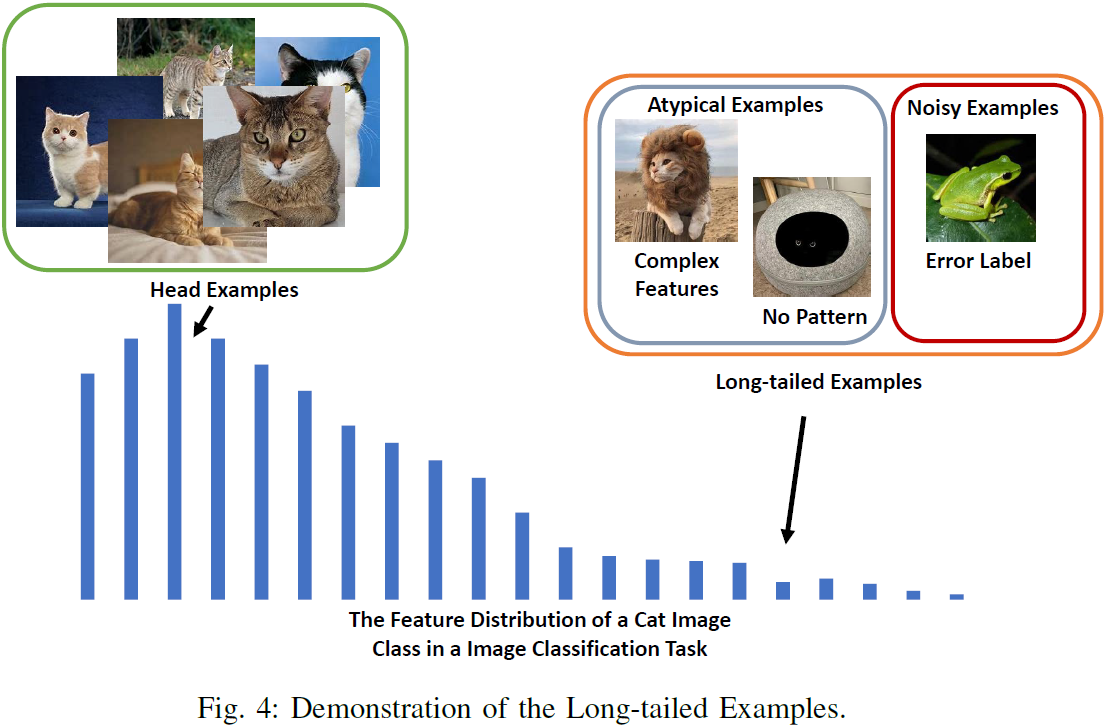

在定义和评估方法之后,我们系统性地回顾了相关文献。对于标准训练中的记忆行为,现有研究调查了记忆效应与训练数据、训练阶段、模型架构、过拟合、正则化和其他因素之间的关系。一项研究 [13],[11] 得出了一个有趣的结论,即记忆学习提高了模型的泛化能力,因为记忆罕见和非典型示例实际上有助于类似罕见子群体的泛化表现,这与一些早期观点相悖。此外,一些证据 [14],[15],[16] 显示,过拟合并不是记忆的原因。记忆是训练中的一个持续过程。对于安全/隐私风险,被记住的特定特征成为多种风险来源,如成员推断风险和提取风险,使攻击者能够利用记忆机制侵犯隐私和违反 DNN 的安全规则。相比之下,一些风险,如对抗攻击风险,与记忆机制并无明显关系。

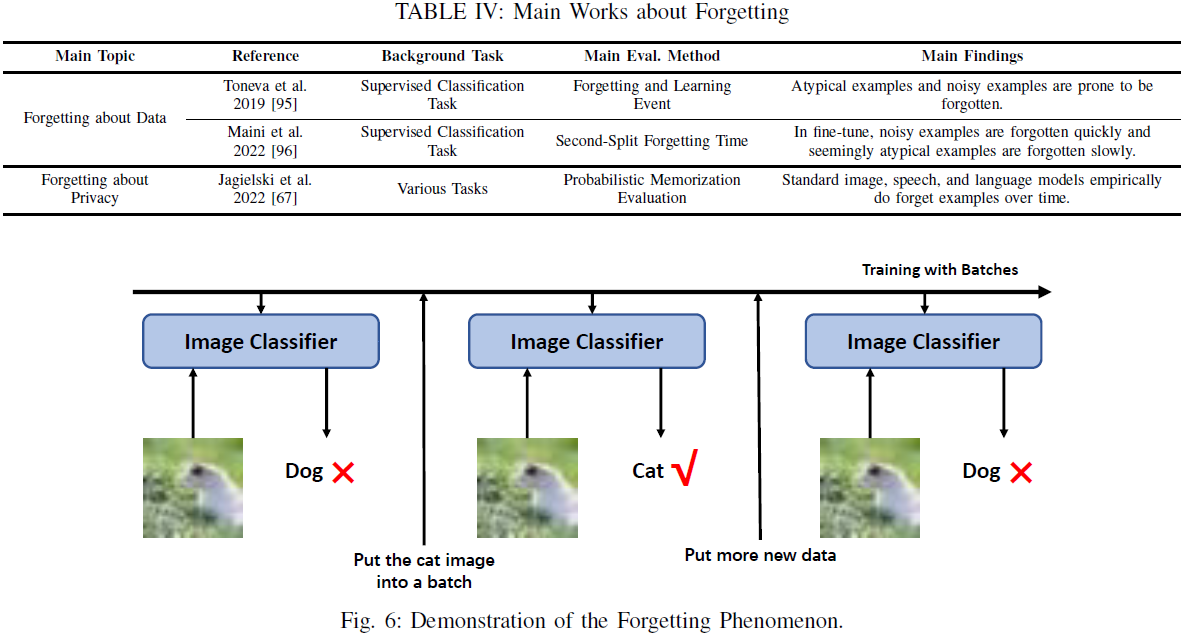

在相关方面,遗忘现象与记忆效应密切相关。因此,我们还讨论并回顾了遗忘效应。我们探讨了有用的遗忘定义和评估方法,并总结了相关的遗忘现象研究。

这篇关于(2024,示例记忆,模型记忆,遗忘,差分评估,概率评估)深度学习中的记忆:综述的文章就介绍到这儿,希望我们推荐的文章对编程师们有所帮助!