解释性专题

深度学习可解释性学习资料汇总

一、著名的大佬课题组 1、张拳石教授的知乎 【导读】张老师的知乎个人简介: I am leading a group for explainable AI. The related topics include explainable CNNs, explainable generative networks, unsupervised semanticization of pre-tr

人工智能-机器学习:机器学习的可解释性(Explainable Machine Learning)

什么是机器学习的可解释性? 可解释性(explainability)有大量的近义词,比如可理解 (understandable), 可诠释 (interpretable), 透明(transparent), 可靠 (robust), 公平 (fair), 明确(explicit),忠实(faithful), 负责(responsible)。这些词与可解释性 (explainable) 之间到底存

Transformer模型、强化学习、深度学习模型可解释性与可视化方法、注意力机制、目标检测算法、图神经网络、强化学习

近年来,伴随着以卷积神经网络(CNN)为代表的深度学习的快速发展,人工智能迈入了第三次发展浪潮,AI技术在各个领域中的应用越来越广泛。 抽丝剥茧、深入浅出讲解注意力机制、Transformer模型(BERT、GPT-1/2/3/3.5/4、DETR、ViT、Swin Transformer等)、生成式模型(变分自编码器VAE、生成式对抗网络GAN、扩散模型Diffusion Model等)、目标

透明性和解释性AI:概念与应用

随着人工智能(AI)技术的迅猛发展,AI系统在日常生活、工业生产、医疗健康等领域的应用日益广泛。然而,随着AI系统的复杂性和影响力不断增加,透明性(Transparency)和解释性(Explainability)成为了AI研究和应用中的两个重要问题。本文将详细探讨透明性和解释性AI的概念、其在各领域的应用,以及面临的挑战和未来的发展方向。 1. 什么是透明性AI?

基于SHAP进行特征选择和贡献度计算——可解释性机器学习

方法介绍 SHAP(SHapley Additive exPlanations)是一个 Python 包,旨在解释任何机器学习模型的输出。SHAP 的名称源自合作博弈论中的 Shapley 值,它构建了一个加性的解释模型,将所有特征视为“贡献者”。对于每个预测样本,模型会产生一个预测值,而 SHAP 值则表示该样本中每个特征的贡献度。 假设第i个样本为Xi,第i个样本的第j个特征为Xij,模型

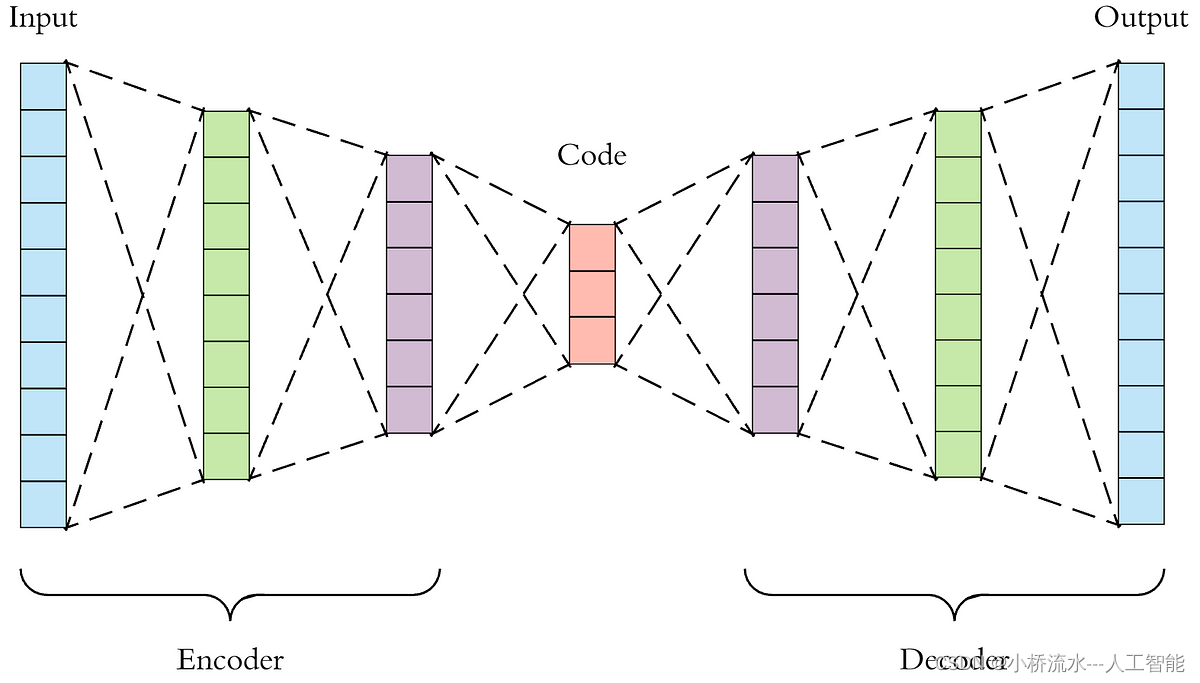

为什么堆叠自编码器(Stacked Autoencoders, SAE)解释性很强!?

堆叠自编码器(Stacked Autoencoders, SAE)相对于卷积神经网络(CNN)在某些情况下具有更高的解释性,主要原因在于其结构和特性使其在特征提取和表示上具有一定的透明度和可解释性。以下是具体原因: 特征表示的透明性: 低维特征表示:自编码器通过压缩输入数据,将高维数据映射到低维特征空间。这些低维特征表示保留了输入数据的主要信息,并且这种映射是显式的,易于分析和理解。逐层特

德克萨斯大学奥斯汀分校自然语言处理硕士课程汉化版(第九周) - 可解释性

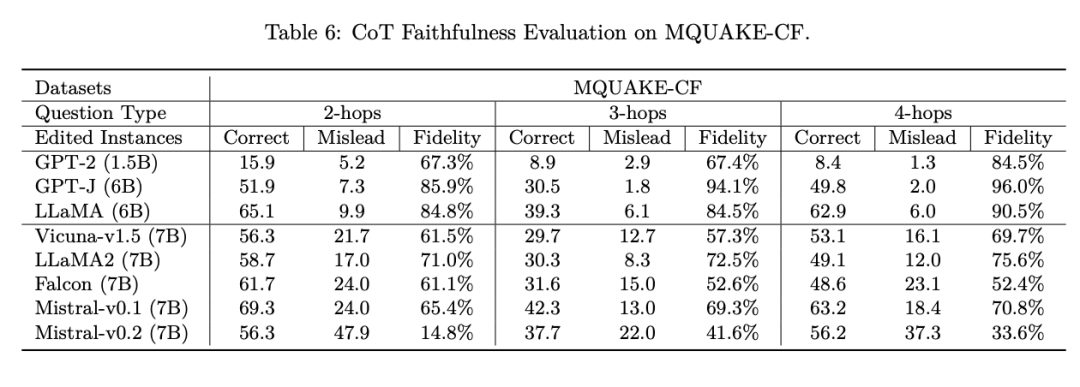

可解释性 1. NLP中的可解释性 1.1. 局部解释1.2. 文本解释1.3. 模型探测 2. 标注伪影3. 思维链 1. NLP中的可解释性 在自然语言处理领域,可解释性是指理解和揭示NLP模型如何做出决策的能力。一些模型本身是自然透明的,我们可以理解它们为何做出这样的决策(例如,一个小于10个结点的决策树)。随着NLP模型(尤其是基于深度学习的模型,如Transformer、BE

用于原发性进行性失语症分类的可解释性机器学习影像组学模型

摘要 背景:原发性进行性失语症(PPA)是一种以语言障碍为特征的神经退行性疾病。两种主要的临床亚型分别为语义型(svPPA)和非流利型失语(nfvPPA)。对PPA患者的诊断和分类是一个复杂的挑战,需要整合多模态信息,包括临床、生物学和放射学特征。结构神经影像学在辅助PPA鉴别诊断和构建诊断支持系统方面起着至关重要的作用。 方法:本研究对56例PPA患者(31例svPPA和25例nfvPPA)

机器学习-10-可解释性机器学习库Shapash

可解释性机器学习库Shapash——鸢尾花XGBoost分类解释实现 shapash的GitHub地址 机器学习的可解释性 1 机器学习的可解释性 1.1 可解释性简介 在机器学习的场景中,可解释性(interpretability)就表示模型能够使用人类可认知的说法进行解释和呈现。 机器学习模型被许多人称为“黑盒”。 这意味着虽然我们可以从中获得准确的预测,但我们无法清楚地解释或识别这些预

深度学习模型在OCR中的可解释性问题与提升探讨

摘要: 随着深度学习技术在光学字符识别(OCR)领域的广泛应用,人们对深度学习模型的可解释性问题日益关注。本文将探讨OCR中深度学习模型的可解释性概念及其作用,以及如何提高可解释性,使其在实际应用中更可靠和可信赖。通过分析当前OCR中深度学习模型的可解释性问题,探讨提高可解释性的方法,并结合实际案例和挑战,旨在促进深度学习模型在OCR领域的更广泛应用。 1. 可解释性的概念及作用 可解释

大模型的灵魂解读:Anthropic AI的Claude3 Sonnet可解释性研究

大模型技术论文不断,每个月总会新增上千篇。本专栏精选论文重点解读,主题还是围绕着行业实践和工程量产。若在某个环节出现卡点,可以回到大模型必备腔调重新阅读。而最新科技(Mamba,xLSTM,KAN)则提供了大模型领域最新技术跟踪。若对于构建生产级别架构则可以关注AI架构设计专栏。技术宅麻烦死磕LLM背后的基础模型。 Anthropic的模型可解释性团队,一直想和大模型的灵魂交流,最近在研究C

XAI、探索LLM时代利用可解释性的10种策略

在大模型时代,可解释性人工智能技术(XAI)有怎样的使用价值?近日,来自佐治亚大学、新泽西理工学院、弗吉尼亚大学、维克森林大学、和腾讯 AI Lab 的研究者联合发布了解释性技术在大语言模型(LLM)上的可用性综述,提出了 「Usable XAI」 的概念,并探讨了 10 种在大模型时代提高 XAI 实际应用价值的策略。 论文题目:Usable XAI: 10 Strategies Toward

paddleX LIME可解释性

使用LIME算法将模型预测结果的可解释性可视化。LIME表示与模型无关的局部可解释性,可以解释任何模型。LIME的思想是以输入样本为中心,在其附近的空间中进行随机采样,每个采样通过原模型得到新的输出,这样得到一系列的输入和对应的输出,LIME用一个简单的、可解释的模型(比如线性回归模型)来拟合这个映射关系,得到每个输入维度的权重,以此来解释模型。 https://paddlex.readt

探讨解释性AI对人工智能系统的重要性及未来发展

解释性AI的定义与重要性 解释性AI(Explainable AI,XAI)是指一种人工智能系统,其能够以易于理解和透明的方式解释其决策过程、行为和推理机制,目标是增加人对AI系统决策和操作的理解,从而提高系统的可信度、可靠性和可接受性。XAI旨在提高人工智能系统的透明度和可理解性,使人们更好地理解AI的决策过程和原理。下面将探讨解释性AI对人工智能系统的重要性,分析其在建立

XAI有什么用?探索LLM时代利用可解释性的10种策略

ChatGPT狂飙160天,世界已经不是之前的样子。 新建了免费的人工智能中文站https://ai.weoknow.com 新建了收费的人工智能中文站https://ai.hzytsoft.cn/ 更多资源欢迎关注 你是否也好奇,在大模型时代,可解释性人工智能技术(XAI)有怎样的使用价值?近日,来自佐治亚大学、新泽西理工学院、弗吉尼亚大学、维克森林大学、和腾讯 AI Lab

Python大型数据集(GPU)可视化和Pillow解释性视觉推理及材料粒子凝聚

🎯要点 Python图像处理Pillow库:🎯打开图像、保存图像、保存期间的压缩方式、读取方法、创建缩略图、创建图像查看器。🎯获取 RGB 值,从图像中获取颜色,更改像素颜色,转换为黑白。创建 4 色照片。创建棕褐色照片 ,创建图像转换器 GUI。🎯获取 Exif 标签数据、获取 GPS Exif 数据、获取 TIFF 标签数据、创建 Exif GUI。🎯滤波器:模糊、

论文浅尝 | 推荐系统的可解释性浅谈

References: Explainable Recommendation via Multi-Task Learning in Opinionated Text Data Published at: The 41st International ACM SIGIR Conference on Research andDevelopment in Information Retriev

难以捉摸?机器学习模型的可解释性初探

引子:在机器学习中,可解释性的概念既重要又难以捉摸。我们能相信模型吗?它在部署过程中会起作用吗?关于这个世界,模型还能告诉我们什么?模型不仅应该是好的,而且应该是可以解释的,然而,可解释性似乎没有具体的说明和定义。本文编译自 Zachary C. Lipton 的一篇文章https://queue.acm.org/detail.cfm?id=3241340,希望对模型的可解释性能够有所认知。

乳腺癌患者生存分析大揭秘:可解释性学习全方位解读!

一、引言 乳腺癌作为女性中最常见的恶性肿瘤之一,不仅具有高发性,而且在治疗过程中也存在着诸多挑战。根据统计数据显示,乳腺癌患者的生存率受到多种因素的影响,包括疾病分期、肿瘤特征、治疗方式等。本文旨在通过生存分析和可解释性学习的方法,揭示乳腺癌患者生存背后的关键信息,以期为个性化治疗和预后评估提供更深入的洞察。 二、乳腺癌患者生存分析 2.1 生存率与关键因素 乳腺癌是女性常见的恶性肿瘤之一,但随

解释性的语言和编译性的语言(转)

<一>翻译的方式有两种,一个是编译,一个是解释。两种方式只是翻译的时间不同。 1.编译型语言写的 程序执行之前,需要一个专门的编译过程,把程序编译成为机器语言的文件,比如exe文件,以后要运行的话就不用重新翻译了,直接使用编译的结果就行了(exe文件),因为翻译只做了一次,运行时不需要翻译,所以编译型语言的程序执行效率高。 例如C++。 2.解释则不同,解释性语言的程序

机器学习-可解释性机器学习:支持向量机与fastshap的可视化模型解析

一、引言 支持向量机(Support Vector Machine, SVM)作为一种经典的监督学习方法,在分类和回归问题中表现出色。其优点之一是生成的模型具有较好的泛化能力和可解释性,能够清晰地展示特征对于分类的重要性。 fastshap是一种用于快速计算SHAP值(SHapley Additive exPlanations)的工具,通过近似SHAP值的计算加速了模型的解释过程,使得模型的解释

8分SCI | 揭示随机森林的解释奥秘:探讨LIME技术如何提高模型的可解释性与可信度!

一、引言 Local Interpretable Model-agnostic Explanations (LIME) 技术作为一种局部可解释性方法,能够解释机器学习模型的预测结果,并提供针对单个样本的解释。通过生成局部线性模型来近似原始模型的预测,LIME技术可以帮助用户理解模型在特定样本上的决策过程,提高模型的可解释性和信任度。在实际应用中,LIME技术已被广泛应用于图像分类、自然语言处理等

可解释性对人工智能发展的影响

文章目录 每日一句正能量前言可解释AI已成热点可解释性人工智能的重要性可解释性人工智能的研究现状推动可解释模型构建未来展望后记 每日一句正能量 不好等待运气降临,就应去发奋掌握知识。 前言 随着人工智能技术的快速发展,越来越多的应用场景需要人工智能系统能够提供可解释性的结果和决策过程。可解释性人工智能(ExplainableArtificialIntellige

机器学习-可解释性机器学习:随机森林与fastshap的可视化模型解析

一、引言 机器学习在当今社会扮演着日益重要的角色,但黑盒模型的不可解释性限制了其应用范围。因此,可解释性机器学习成为研究热点,有助于提高模型的可信度和可接受性。本文旨在探讨随机森林和fastshap作为可视化模型解析工具的应用,以帮助解释机器学习模型的决策过程和关键特征。通过对这两种方法的深入研究,可以更好地理解模型背后的逻辑,为进一步的应用提供指导。 二、可解释性机器学习的概念 可解释性对于机

AI决策的解构与实践:初探可解释性技术(XAI)

随着人工智能(AI)技术在各个领域的广泛应用,解释性人工智能(XAI)的概念备受瞩目。作为开发者,我们深知AI系统的复杂性,以及对于用户和利益相关者来说理解AI决策过程的重要性。本文将深入探讨可解释性AI的定义、重要性,并通过分析XAI在开发者工作中的关键作用,为我们构建更透明和可理解的AI系统提供新的视角。 目录 AI决策的解构与实践:初探可解释性技术(XAI)什么是可解释人工

基于知识图的增强路径推理的可解释性疾病预测

代码地址: https://github.com/ZJU-BMI/PBXAI 摘要 目的:结合医学知识和医学数据,以可解释的方式预测疾病风险。方法:我们将疾病预测任务表述为沿着知识图谱(KG)的随机游动。具体而言,我们根据经过验证的医学知识建立了一个KG,以记录疾病和危险因素之间的关系。然后,一个数学对象沿着KG走。它开始在患者实体处行走,该患者实体根据患者当前的疾病或风险因素将KG连接起来