本文主要是介绍paddleX LIME可解释性,希望对大家解决编程问题提供一定的参考价值,需要的开发者们随着小编来一起学习吧!

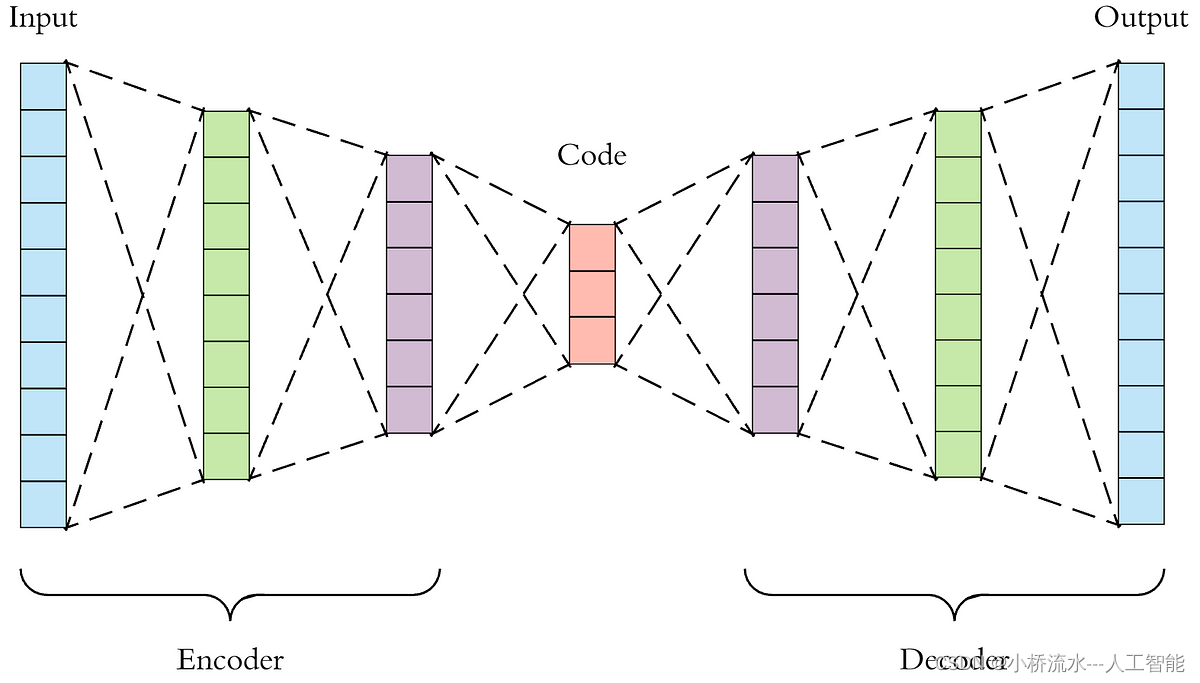

使用LIME算法将模型预测结果的可解释性可视化。LIME表示与模型无关的局部可解释性,可以解释任何模型。LIME的思想是以输入样本为中心,在其附近的空间中进行随机采样,每个采样通过原模型得到新的输出,这样得到一系列的输入和对应的输出,LIME用一个简单的、可解释的模型(比如线性回归模型)来拟合这个映射关系,得到每个输入维度的权重,以此来解释模型。

https://paddlex.readthedocs.io/zh_CN/latest/apis/visualize.html

使用NormLIME算法将模型预测结果的可解释性可视化。 NormLIME是利用一定数量的样本来出一个全局的解释。NormLIME会提前计算一定数量的测试样本的LIME结果,然后对相同的特征进行权重的归一化,这样来得到一个全局的输入和输出的关系。

注意: 可解释性结果可视化目前只支持分类模型。

这篇关于paddleX LIME可解释性的文章就介绍到这儿,希望我们推荐的文章对编程师们有所帮助!