lime专题

在uniapp+vue cli中使用lime-echart图表,关于使用异步数据_lime-echartuniapp

import {TitleComponent,TooltipComponent,GridComponent, DatasetComponent, TransformComponent, LegendComponent } from ‘echarts/components’; // 标签自动布局,全局过渡动画等特性 import {LabelLayout,UniversalTransition} f

10模型可解释和LIME

模型可解释和LIME 学习目标 知道LIME的原理知道LIME API的使用方法 1 模型可解释性介绍 近年来深度学习模型、集成学习模型(比如XGBoost、LightGBM等)在很多领域都取得了很好的成果,但是这类模型有共同的特点: 内部结构非常复杂,其运作机制就像一个黑盒子一样,难以用人类可以理解的语言去描述模型输出结果也难以被解释,使得其在一些有关生命安全或重要决策领域的应用受到

paddleX LIME可解释性

使用LIME算法将模型预测结果的可解释性可视化。LIME表示与模型无关的局部可解释性,可以解释任何模型。LIME的思想是以输入样本为中心,在其附近的空间中进行随机采样,每个采样通过原模型得到新的输出,这样得到一系列的输入和对应的输出,LIME用一个简单的、可解释的模型(比如线性回归模型)来拟合这个映射关系,得到每个输入维度的权重,以此来解释模型。 https://paddlex.readt

LIME技术个人总结和理解

方法: 干涉输入,然后观察预测结果会怎样变化。 实验表明这种做法在可解释性上是有用的。 因为我们可以通过改变人类可以理解的组件(比如单词或图像的一部分)来改变输入,即使模型使用的是更加复杂的组件(比如词向量)作为输入的特征。 LIME 背后的关键直觉就是,通过一个简单的模型来局部地(在我们想要解释的预测的附近)逼近一个黑箱模型会比全局性地去逼近这个模型要容易得多。 怎么实现?(通过给改变

SHAP和LIME:Python机器学习模型解释

SHAP和LIME:Python机器学习模型解释 为了更好地展示,示例代码参见和鲸社区,一键运行 简介 机器学习模型在各个领域得到广泛应用,但其黑盒性质往往使人难以理解其决策过程,降低了模型的可信度和可靠性。为了解决这一问题,可解释性人工智能(XAI)应运而生,其目标是为模型的行为和决策提供清晰、可理解的解释。 一、SHAP SHAP(SHapley Additive Explanati

8分SCI | 揭示随机森林的解释奥秘:探讨LIME技术如何提高模型的可解释性与可信度!

一、引言 Local Interpretable Model-agnostic Explanations (LIME) 技术作为一种局部可解释性方法,能够解释机器学习模型的预测结果,并提供针对单个样本的解释。通过生成局部线性模型来近似原始模型的预测,LIME技术可以帮助用户理解模型在特定样本上的决策过程,提高模型的可解释性和信任度。在实际应用中,LIME技术已被广泛应用于图像分类、自然语言处理等

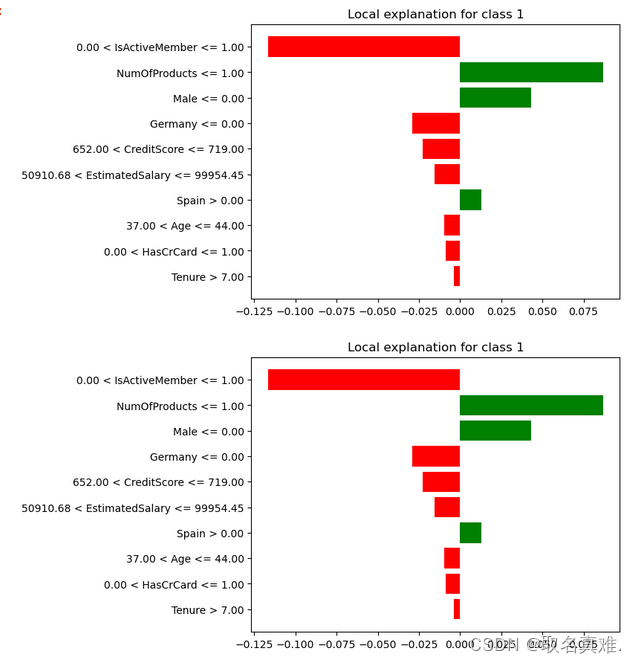

对于已交付(客户流失预警)模型的模型可解释LIME

目录 介绍: 数据: 数据处理: 随机森林建模: LIME 例一: 例二: 介绍: LIME (Local Interpretable Model-agnostic Explanations) 是一种解释机器学习模型的方法。它通过生成一个可解释模型,来解释黑盒模型的预测。LIME的主要思想是在附近生成一组局部数据点,然后使用可解释模型来逼近黑盒模型在这些数据点上的预测。

文章:LIME:Why Should I Trust You?

本文结合文章 “Why Should I Trust You?” Explaining the Predictions of Any Classifier 主要阐述一下内容: LIME 算法意义LIME 算法原理LIME 算法效果 原文参见:https://arxiv.org/pdf/1602.04938v1.pdf 一、LIME 算法意义 LIME 是解释模型的算法,目的为了解模型的预测

LIME:为什么我应该相信你?解释任何模型的预测结果

LIME:为什么我应该相信你?解释任何模型的预测结果 概述简介案例解释LIME原理解释Step 1 围绕待解释样本随机生成样本Step 2 对随机样本标准化,以及利用模型对标准化数据进行预测Step 3 特征选择 Step 4 特征贡献值确定总结 Github 项目链接:https://github.com/marcotcr/lime 参考链接: LIME - Local In

LIME:为什么我应该相信你?解释任何模型的预测结果

LIME:为什么我应该相信你?解释任何模型的预测结果 概述简介案例解释LIME原理解释Step 1 围绕待解释样本随机生成样本Step 2 对随机样本标准化,以及利用模型对标准化数据进行预测Step 3 特征选择 Step 4 特征贡献值确定总结 Github 项目链接:https://github.com/marcotcr/lime 参考链接: LIME - Local In

SHAP 和 LIME 解释模型

内容大纲 1、SHAP 解释器1.1 案例:用于预测患者肺癌1.2 案例中使用的shap解释器1.3 举例说明:SHAP工作原理 2、LIME 解释器2.1 案例:判断法律案件胜诉可能性2.2 LIME解释器工作原理2.3 本地解释模型的训练过程2.4 举例说明1:新闻分类2.4 举例说明2:电影评论判断 1、SHAP 解释器 1.1 案例:用于预测患者肺癌 该案例使用肺癌数

LIME低亮度图像增强

LIME低亮度图像增强 main.cpp #include <opencv2/core/core.hpp>#include <opencv2/highgui/highgui.hpp>#include <iostream>#include <opencv2/imgproc/imgproc.hpp>#include "lime.h"int main(){cv::Mat img_

电动滑板车巨头Lime任命联合创始人鲍周佳为新CEO

【TechWeb】5月24日消息,据国外媒体报道,在一次全体会议上,电动滑板车巨头Lime证实,该公司联合创始人鲍周佳(Brad Bao)将接替该公司另一名联合创始人托比·孙(Toby Sun),担任新的首席执行官(CEO)。 除了任命新的CEO,Lime的首席运营官兼前GV合伙人乔·克劳斯(Joe Kraus)也被提拔为总裁。去年年底,克劳斯加入Lime,此前他在Alphabet的风险投资部