深度图专题

深度图的方法实现加雾,Synscapes数据集以及D455相机拍摄为例

前言 在次之前,我们已经做了图像加雾的一些研究,这里我们将从深度图的方法实现加雾展开细讲 图像加雾算法的研究与应用_图像加雾 算法-CSDN博客 接下来将要介绍如何使用深度图像生成雾效图像的方法。利用Synscapes数据集,通过读取EXR格式的深度信息,结合摄像机参数和暗通道先验等技术,计算传输图和大气光照强度,并应用朗伯-比尔定律生成雾效图像。文中提供了完整的代码示例,包括从深度图读取数

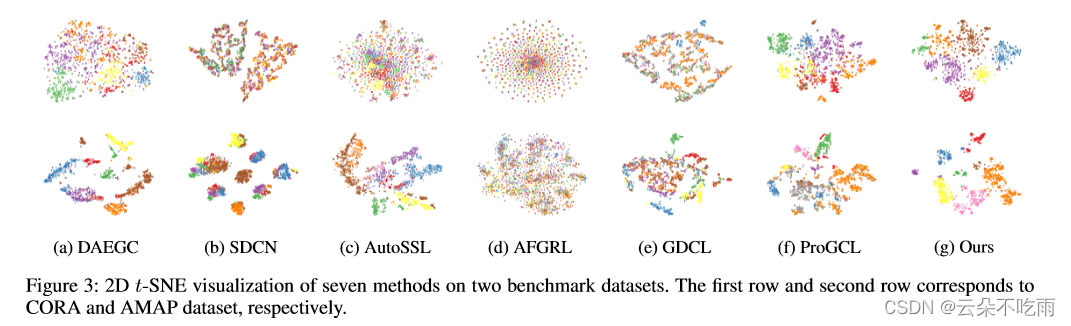

对比深度图聚类的硬样本感知网络

Hard Sample Aware Network for Contrastive Deep Graph Clustering 文章目录 Hard Sample Aware Network for Contrastive Deep Graph Clustering摘要引言方法实验结论启发点 摘要 本文提出了一种名为Hard Sample Aware Network (HSAN

Python opencv读取深度图,网格化显示深度

效果图: 代码: import cv2import osimg_path = "./outdir/180m_norm_depth.png"depth_img = cv2.imread(img_path, cv2.IMREAD_ANYDEPTH)filename = os.path.basename(img_path)img_hig, img_wid = depth_img.sh

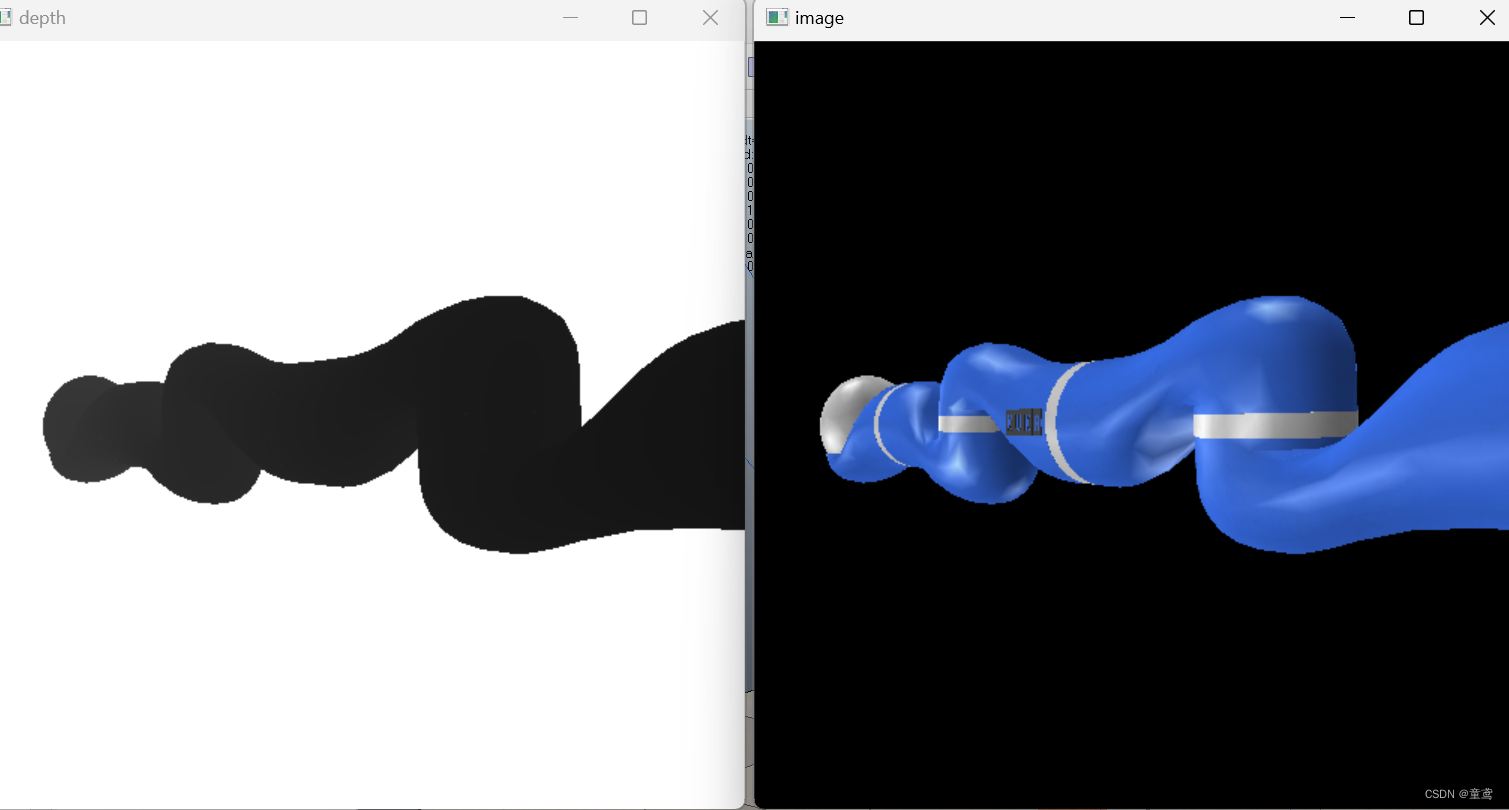

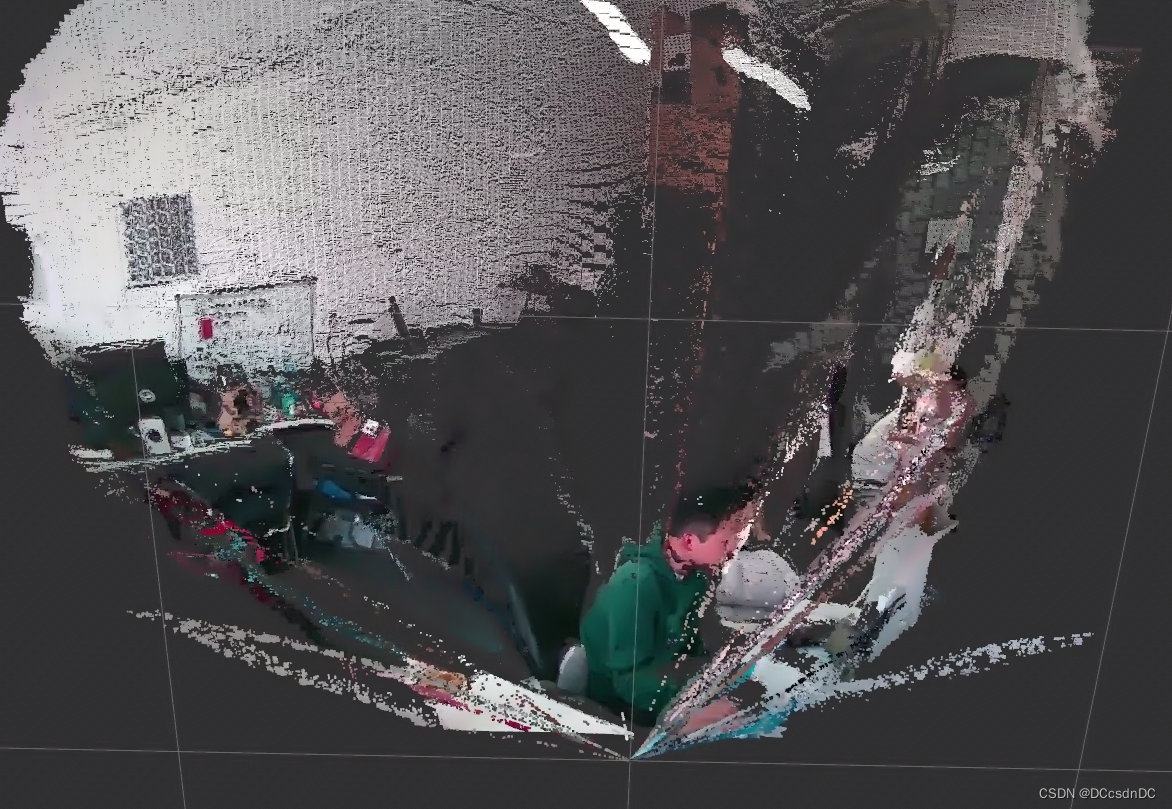

Python 基于深度图、RGB图生成RGBD点云数据

RGBD点云生成 一、概述1.1 定义1.2 函数讲解 二、代码示例三、结果示例 一、概述 1.1 定义 RGBD点云:是一种包含颜色和深度信息的点云数据。RGB代表红、绿、蓝三原色,表示点云中每个点的颜色信息;D代表深度,表示点云中每个点的相对于相机的距离信息。通过结合颜色和深度信息,RGBD点云可以提供更丰富的场景信息,对于目标识别、场景重建等计算机视觉任务具有重要作

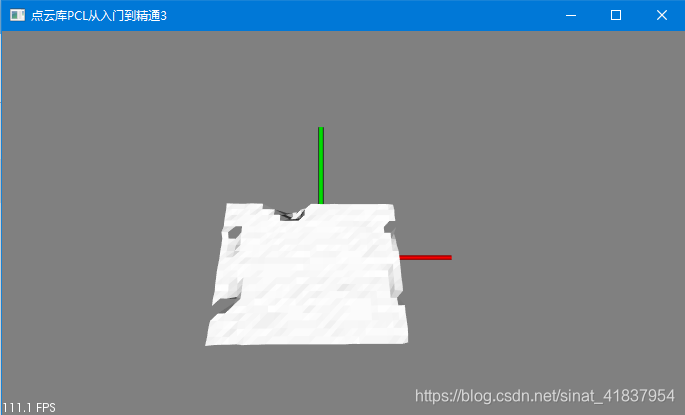

python 深度图生成点云(方法二)

深度图生成点云 一、介绍1.1 概念1.2 思路1.3 函数讲解 二、代码示例三、结果示例 接上篇:深度图生成点云(方法1) 一、介绍 1.1 概念 深度图生成点云:根据深度图像(depth image)和相机内参(camera intrinsics)生成点云(PointCloud)。 1.2 思路 点云坐标的计算公式如下: z = d / depth_sc

PCL 点云生成深度图

点云生成深度图 一.介绍1.1 深度图1.2 主要函数 二.代码示例三.结果示例 一.介绍 1.1 深度图 点云深度图:是一种二维图像,用于表示三维点云中每个点的深度信息。它将每个点的深度值映射到一个像素上,深度值表示点到相机或参考平面的距离。深度图可以用来估计场景的几何结构,包括物体的距离、形状和大小等信息。 1.2 主要函数 template <typenam

VTK——模拟深度相机拍摄深度图

VTK——模拟深度相机拍摄深度图(RGB-D)_vtk 设置相机内参-CSDN博客 VTK(二)---相机外参矩阵Tcw转VTK相机,构建VR虚拟相机_vtk渲染 设置相机内参外参-CSDN博客

基于opencv SGBM的双目深度图提取在FPGA上的实现

代码分享于github: https://github.com/tishi43/sgbm 主要包含以下部分: line_buffer_8row.sv, 从ddr读左图和右图,缓存8行,为什么8行,5x5的cost加窗运算最多要7行图像,此7行用来输出,另一行用来从ddr读入。 calc_bt_cost.sv,代价计算,正向的代价计算,从x=minD开始到width-1,反向的代价

使用cv::ximgproc::FastBilateralSolverFilter优化realsense D455的深度图

1 源码 OpenCV中内置了很多滤波器,这里我们讨论cv::ximgproc其中包含的滤波器。 https://docs.opencv.org/3.4/da/d17/group__ximgproc__filters.html 需要注意的是,默认安装的OpenCV中不包含cv::ximgproc,请从源码重修编译。 在这里贴上我的测试源码。 /*cv::ximgproc::Adaptive

realsense系列(二):录制深度图和RGB图

录制深度图和RGB图 本次任务使用方法总结 本次任务 利用realsenseviewer软件录制深度图和RGB图 使用方法 1.将realsense连接到计算机上,然后打开realsenseviewer软件,打开后默认Record是灰色的,无法点击。 2.将Stereo Module和RGB Camera设置为on状态 3.点击Record按钮,开始进行录制

乐视三合一体感摄像头Astra pro开发记录1(深度图、彩色图及点云简单显示)

在某鱼上淘的乐视三合一体感摄像头,捡漏价九十几块,买来玩玩。 网上已经有一些关于此款摄像头的开发资料。 官方的开发资料:[官网链接](https://orbbec3d.com/index/download.html) 按官方网站以及其他帖子,下载并安装相机的驱动和SDK,不难配置好相机。 据说目前最新的opencv4.5.1提供了Astra相机的api接口,然而我并没有尝试成功,先就这样吧。。

从metashape导出深度图,从深度图恢复密集点云

从metashape导出深度图,从深度图恢复密集点云 1.从metashape导出深度图 参考:https://blog.csdn.net/WHU_StudentZhong/article/details/123107072?spm=1001.2014.3001.5502 2.从深度图建立密集点云 首先从metashape导出blockExchange格式的xml文件,里面记录了相机的内外

【OpenCV-Python】教程:6-4 Depth Map from Stereo Images 立体图像的深度图

OpenCV Python Depth Map from Stereo Images 立体图像的深度图 【目标】 通过立体图像创建一个深度图 【理论】 上一节中,我们学习了一些基本概念,如对极约束和其他一些相关术语。我们还可以看到,如果我们有同一个场景的两张图像,我们可以以一种直观的方式获得深度信息。 上图包含等价三角形。写出它们的等价方程,得到如下结果: d i s p a r

[Python图像处理] 使用OpenCV创建深度图

使用OpenCV创建深度图 双目视觉创建深度图相关链接 双目视觉 在传统的立体视觉中,两个摄像机彼此水平移动,用于获得场景上的两个不同视图(作为立体图像),就像人类的双目视觉系统: 通过比较这两个图像,可以以视差的形式获得相对深度信息,该视差编码对应图像点的水平坐标的差异。 两个立体图像中单个像素的位移量称为视差 (disparity),像素的视差与其在场景中的深度成反比。

数字图像处理(实践篇)三十三 OpenCV-Python从立体图像创建深度图实践

目录 一 方案 二 实践 双眼视觉是指人类使用两只眼睛同时观察同一场景,通过左右眼的视差来感知深度。左眼和右眼的视差是由于它们在空间中的位置不同而产生的,这种差异可以被大脑解读为物体的距离和深度。为了从立体图像构建深度图,找到两个图像之间的视差,可以初始化并创建一个StereoBM对象,然后使用stereo.comput()函数计算视差 。其中,stereo 是创建的 StereoB

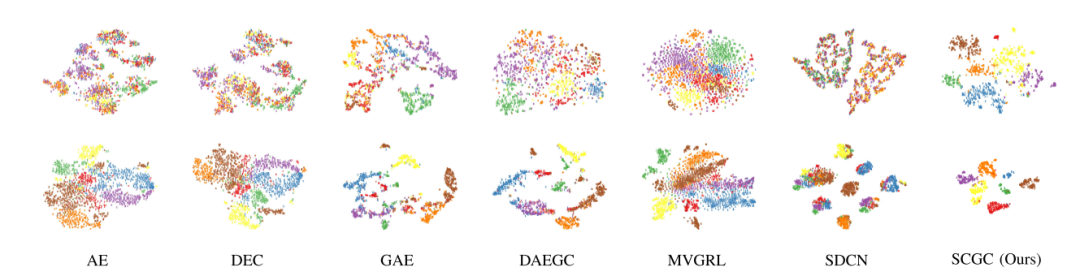

对比学习在深度图聚类方法

今天给大家分享的是国防科技大学刘新旺老师团队发表在IEEE TRANSACTIONS ON NEURAL NETWORKS AND LEARNING SYSTEMS的论文"Simple Contrastive Graph Clustering"。论文提出了一种简单高效的图对比学习聚类方法SCGC,SCGC十分轻量,并且和一般的深度图聚类相比,不需要花大量时间去预训练。文章提出了一种新的

谷歌CVPR最新成果!采用数据驱动方法通过YouTube视频生成深度图(效果最先进!)

点上方蓝字计算机视觉联盟获取更多干货 在右上方 ··· 设为星标 ★,与你不见不散 本文来源于联盟成员翻译笔记 昨日(4月25日)刚更新的文章 地址:https://arxiv.org/pdf/1904.11111.pdf 摘要: 本文提出了一种在自由移动的场景中预测密集深度的方法。现有的从单目视频中恢复动态非刚性物体深度的方法对物体的运动有很强的假设,只能恢复稀疏深度。在本文中采用数据驱动

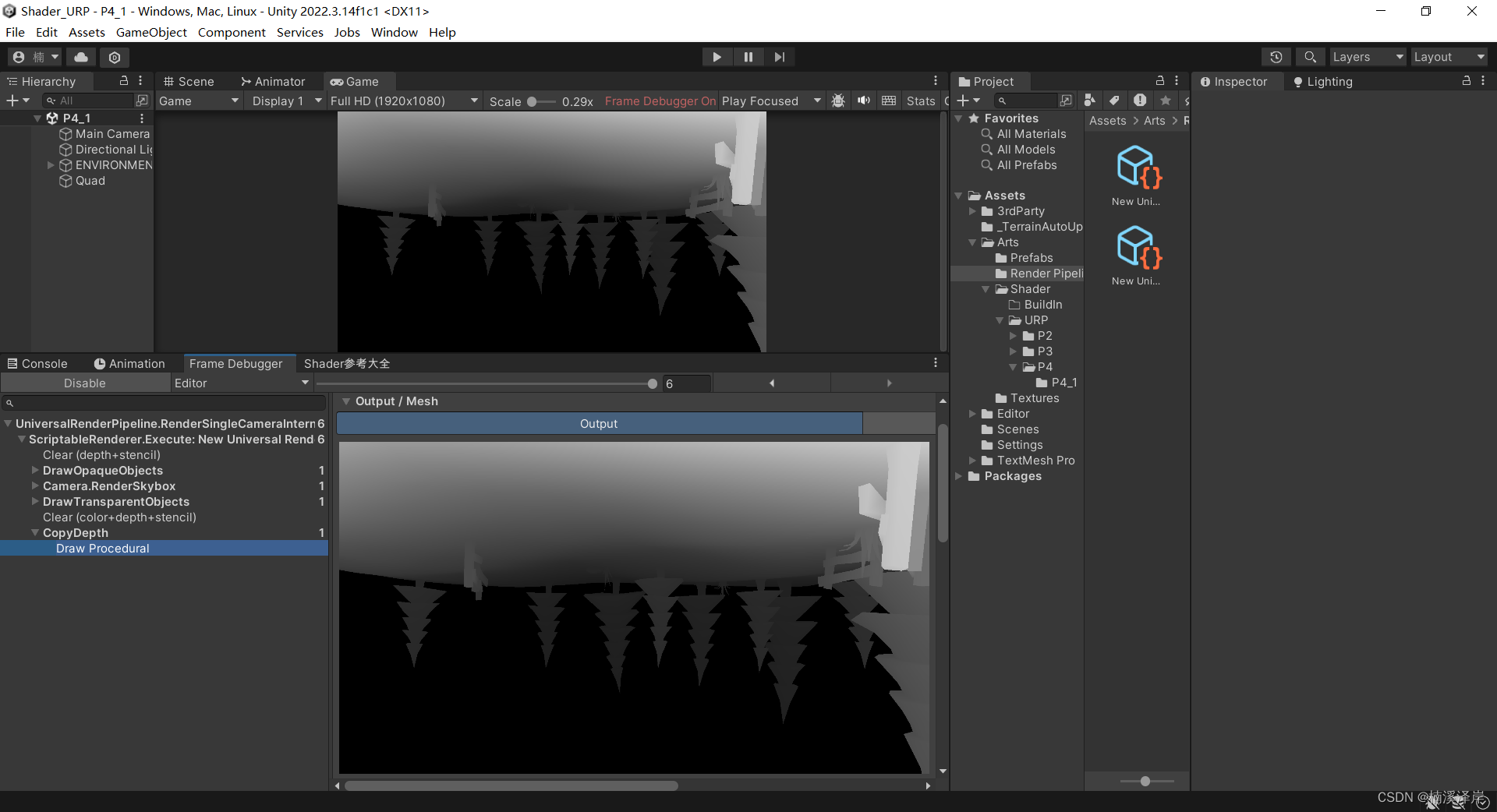

unity 关于深度图优化(drawcall不翻倍)

深度图基础 深度图里存放了[0,1]范围的非线性分布的深度值,这些深度值来自NDC坐标。 在延迟渲染中,深度值默认已经渲染到G-buffer; 深度图可以做什么效果 先上图,这是物件插入半球体边缘效果(这里我加了优化扭曲的) https://www.jianshu.com/p/80a932d1f11e这里已经有详细说明 没优化前深度图获取 在C#中设置Camera.main.dep

机器人持续学习基准LIBERO系列5——获取显示深度图

0.前置 机器人持续学习基准LIBERO系列1——基本介绍与安装测试机器人持续学习基准LIBERO系列2——路径与基准基本信息机器人持续学习基准LIBERO系列3——相机画面可视化及单步移动更新机器人持续学习基准LIBERO系列4——robosuite最基本demo 1.更改环境设置 LIBERO-master/libero/libero/envs/env_wrapper.py,第37行ca

Unity中BRP下的深度图

文章目录 前言一、在Shader中使用1、在使用深度图前申明2、在片元着色器中 二、在C#脚本中开启摄像机深度图三、最终效果 前言 在之前的文章中,我们实现了URP下的深度图使用。 Unity中URP下使用屏幕坐标采样深度图 在这篇文章中,我们来看一下BRP下深度图怎么单独使用。 一、在Shader中使用 1、在使用深度图前申明 sampler2D _Came

Unity中URP下开启和使用深度图

文章目录 前言一、在Unity中打开URP下的深度图二、在Shader中开启深度图1、使用不透明渲染队列才可以使用深度图2、半透明渲染队列深度图就会关闭 三、URP深度图 和 BRP深度图的区别四、在Shader中,使用深度图1、定义纹理和采样器2、在片元着色器对深度图采样并且输出3、创建一个面片,用于查看输出的深度图4、对深度图进行线性黑白转化5、平台区别 五、测试代码 前言

Unity中URP下使用屏幕坐标采样深度图

文章目录 前言一、Unity使用了ComputeScreenPos函数得到屏幕坐标1、 我们来看一下这个函数干了什么2、我们看一下该函数实现该结果的意义 二、在Shader中使用(法一)1、在Varying结构体中2、在顶点着色器中3、在片元着色器中 三、在Shader中使用(法二)1、在片元着色器中 四、最终效果 前言 在上一篇文章中,我们实现了URP下深度图的使用。 U

使用Kinect SDK获取深度图与彩色图并保存

感谢http://blog.csdn.net/zouxy09 #include <stdlib.h>#include <iostream>#include <string>#include "OpenNI.h"#include "opencv2/core/core.hpp"#include "opencv2/highgui/highgui.hpp"#include "ope

PCL——点云到深度图的变换与曲面重建

点云到深度图的变换与曲面重建 点云数据需要通过k-d tree等索引来对数据进行检索; 深度图和图像类似,可以通过上下左右等近邻来直接进行索引。 所以有必要将点云数据转换为深度图像,进而使用PCL内部只适用于深度图像的算法来进行曲面重建等。 代码实现: #include <pcl/range_image/range_image.h>#include <pcl/range_image/rang

V-rep(CoppeliaSim)添加相机,与python联合仿真,并使用python读取V-rep中的RGB图与深度图

目录 前言在V-rep中构建场景建立python与V-rep通信 前言 本文主要介绍了如何使用python与V-rep联合仿真,并用OpenCV可视化V-rep中视觉传感器所能看到的 RGB图和深度图,效果图如下。 在V-rep中构建场景 本文使用的V-rep版本是3.5: 打开V-rep,并将任意一个目标(如机械臂)拖入到场景中。添加视觉传感器,在场景的空白处点击右键–

![[Python图像处理] 使用OpenCV创建深度图](https://img-blog.csdnimg.cn/9760aa8ef2ca480b8a169f897a1e3f4e.png)