snn专题

直接训练SNN:从LIF模型到MNIST分类的完整实战【含源码】

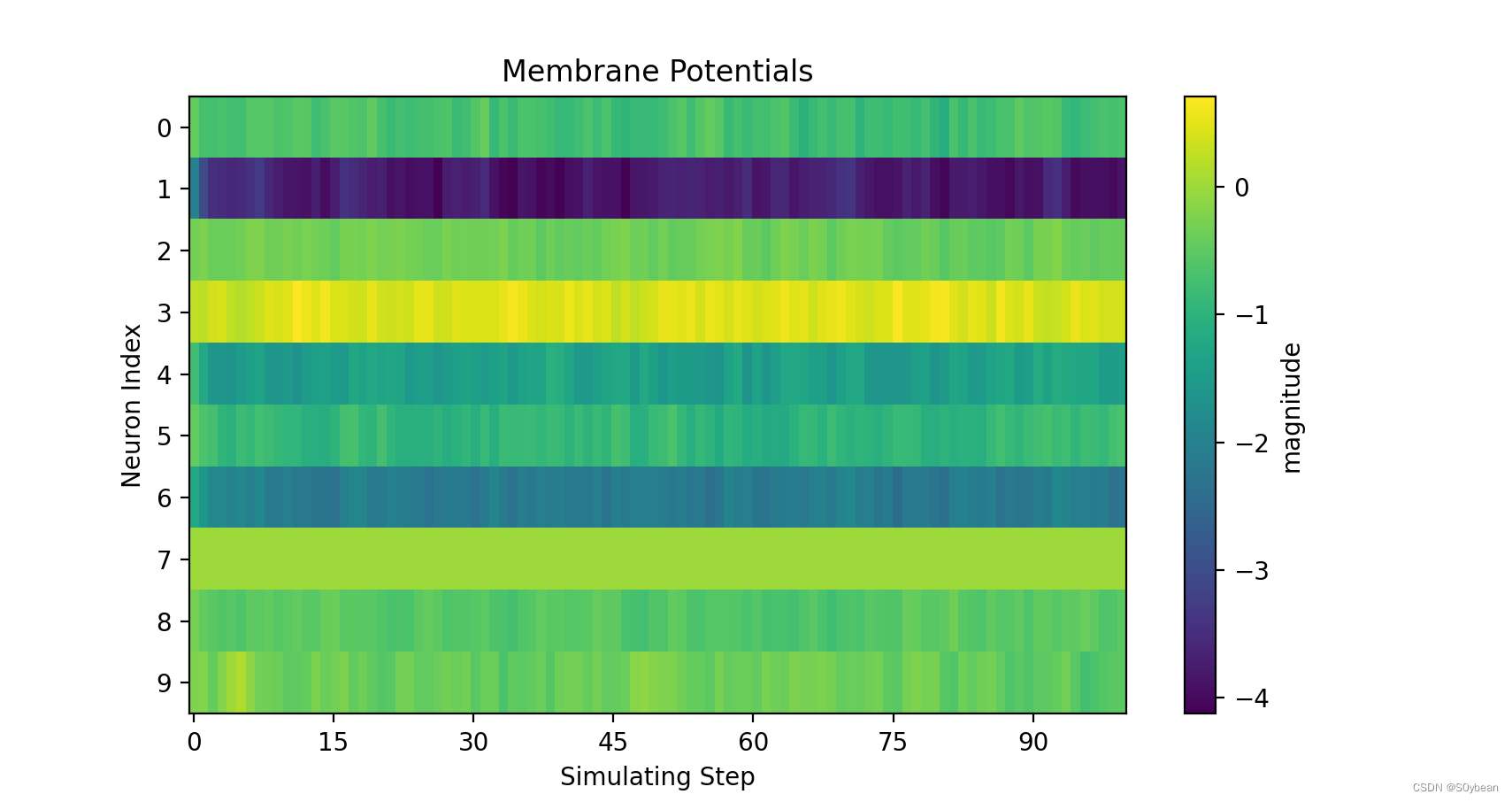

我们计划使用原生Python代码直接训练SNN,并在相同的精度、超参数和网络结构下与SpikingJelly进行精度对比。以下是基准方法和相关教程的链接: 时间驱动:使用单层全连接SNN识别MNIST — SpikingJelly alpha 文档 在直接训练SNN时,我们需要实现以下三个方面: LIF神经元:实现充电、发射脉冲、重置等操作。编码方式:将连续值转换为适合SNN输入的形式

点击率预测|深度学习在CTR中的应用,FNN,SNN论文解读

请点击上方“AI公园”,关注公众号 【导读】LR,FM,FFM都是浅层模型,想不想试试深度学习?请看下面: 摘要:预测用户的反馈,如点击率,转换率在很多的网络应用中非常的重要,如网络搜索、个人推荐、在线广告等。和图像和语音领域的特征不同,这些场景的输入的特征常常是多领域的,离散的,类别化的特征,相互之间的依赖的相关知识也很少。主流的用户反馈模型要么使用线性模型,要么手工组合高阶的特征,前者缺乏

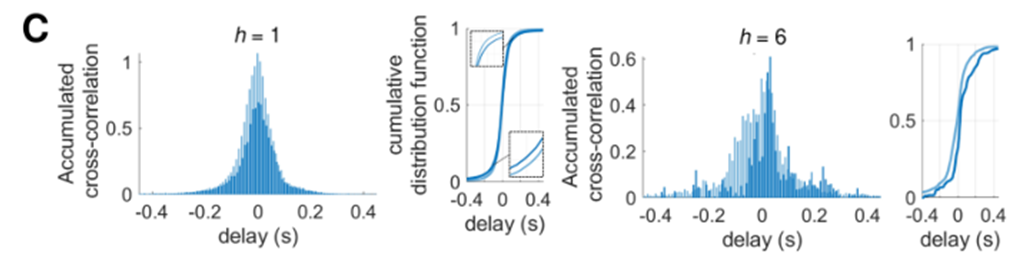

【精读Yamamoto】方向性连接如何丰富神经网络的功能复杂度 | 体外神经元培养实验 | 脉冲神经元模型(SNN) | 状态转移模型

探索大脑的微观世界:方向性连接如何丰富神经网络的功能复杂度 在神经科学领域,理解大脑如何通过其复杂的网络结构实现高级功能一直是一个核心议题。最近,一项由Nobuaki Monma和Hideaki Yamamoto博士领导的研究为我们提供了新的视角,他们通过创新的结合生物神经元培养皿实验和计算仿真模型,揭示了在生物神经网络中引入方向性连接如何显著影响网络的动态行为和功能性复杂度。 这次介绍

Hadoop0.23.0初探3---HDFS NN,SNN,BN和HA

前言 保证HDFS高可用是Hadoop被推广以来很多技术人员一直关心的问题,通过搜索引擎搜索也可以得到很多的方案。恰逢HDFS Federation出炉,本文将一些涉及到有关NameNode、SecondaryNameNode、BackupNode的含义与区别,以及HDFS HA框架做一个总结。除此之外,文章的最后,将介绍Hadoop-0.23.0如何配置NameNode、SecondaryNam

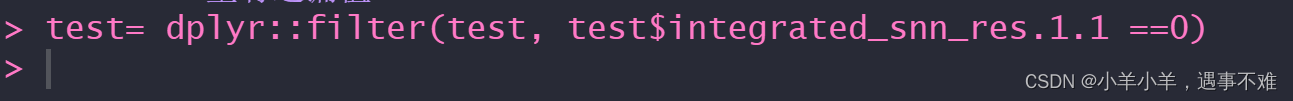

R中使用filter函数过滤数据时报错Error in filter(test, test$integrated_snn_res.1.1 == 0) : ‘filter‘里有遺漏值

R中使用filter函数过滤数据时报错Error in filter(test, test$integrated_snn_res.1.1 == 0) : 'filter'里有遺漏值 解决方法: 告诉R需要用哪个包里的filter函数 参考(5条消息) R语言dplyr包filter函数 Error in filter(., ) : 找不到对象的报错原因和解决办法_Yann_Y

2023年顶会、顶刊SNN相关论文

原文链接:https://blog.csdn.net/qq_43622216/article/details/128918566 个人收集精力有限,欢迎各位评论或者私信告知SNN相关论文研究! 2023年顶会、顶刊SNN相关论文 个人收集精力有限,欢迎各位评论或者私信告知SNN相关论文研究!目录说明AAAI2023IJCAI(International Joint Conference

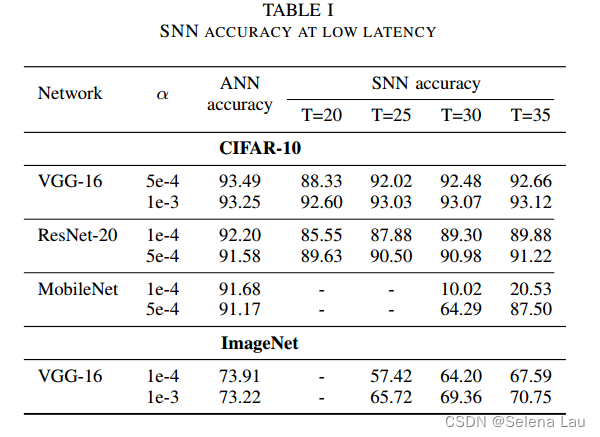

【读论文】TCL: an ANN-to-SNN Conversion with Trainable Clipping Layers

DAC 2021 背景 通过ANN2SNN的方法得到的SNN中,存在准确性和延迟之间的一种权衡关系,在较大的数据集(如ImageNet)上可能会有较高的延迟。 主要贡献 分析了转换后SNN精度与延迟之间存在权衡关系的原因,并指出了如何缓解这种权衡关系;提出TCL(trainable clipping layer)技术改善权衡关系,TCL的剪裁区域是被训练过的,跟着ReLU层,可以找到精度

脉冲神经网络(SNN)论文阅读(五)-----AAAI-2024 时间步长逐渐收缩的SNN

原文链接:CSDN-脉冲神经网络(SNN)论文阅读(五)-----AAAI-2024 时间步长逐渐收缩的SNN Shrinking Your TimeStep: Towards Low-Latency Neuromorphic Object Recognition with Spiking Neural Networks 目录论文信息主要贡献Timestep ShrinkageEarly C

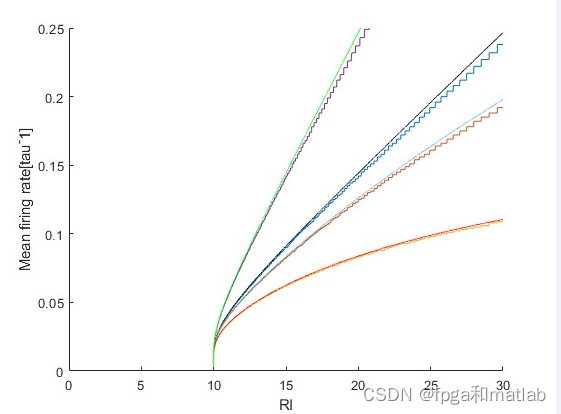

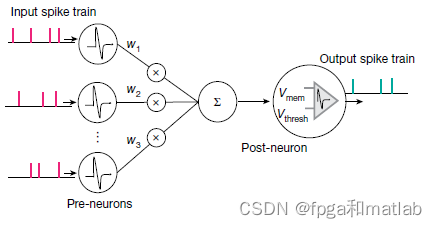

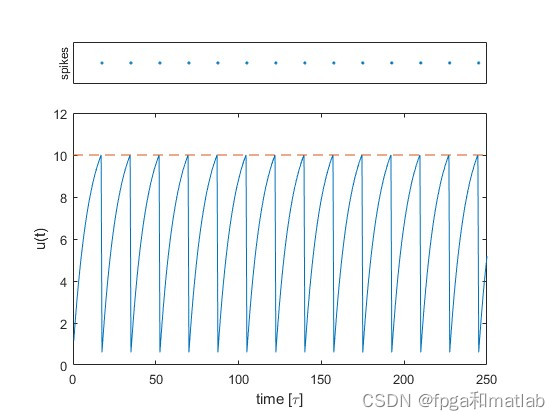

基于SNN脉冲神经网络中的IF神经元matlab仿真

目录 一、理论基础 二、核心程序 三、仿真结论 一、理论基础 SNN(Spiking Neural Network)脉冲神经网络是一种模拟神经系统中脉冲传递的神经网络模型。其中,IF(Integrate-and-Fire)神经元模型是一种常用的脉冲神经元模型。本文将详细介绍IF神经元脉冲在SNN中的具体实现步骤、数学公式以及其中的难点。 第三代神经网络,脉冲神经网络

【解读Spikingjelly】使用单层全连接SNN识别MNIST

原文档:使用单层全连接SNN识别MNIST — spikingjelly alpha 文档 代码地址:完整的代码位于activation_based.examples.lif_fc_mnist.py GitHub - fangwei123456/spikingjelly: SpikingJelly is an open-source deep learning framework for Spi

基于IM模型的SNN脉冲神经网络的verilog程序开发

目录 1.SNN脉冲神经网络概述 2.verilog核心程序 1.SNN脉冲神经网络概述 脉冲神经网络大体上可以和传统的人工神经网络一样被用在信息处理中,而且脉冲神经网络可以对一个虚拟昆虫寻找食物的问题建模,而不需要环境的先验知识。并且,由于它更加接近现实的性能,使它可以用来学习生物神经系统的工作,电生理学的脉冲和脉冲神经网络在电脑上的模拟输出相比,决定了拓扑学和生物

第三代神经网络——脉冲神经网络(SNN)的仿真

1.问题描述: 同传统的人工神经网络一样,脉冲神经网络同样分为三种拓扑结构。它们分别是前馈型脉冲神经网络(feed-forward spiking neural network)、递归型脉冲神经网络(recurrent spiking neural network)和混合型脉冲神经网络(hybird spiking neural network)。 学习是人工智能领域

【论文系列研读】Superpixel: SLIC+SNN

1、SLIC(PAMI2012) Title:SLIC Superpixels Compared to State-of-the-art Superpixel Methods Author:Radhakrishna Achanta ... (École Polytechnique Fédérale de Lausanne,EPFL 瑞士联邦理工学院) Other Algorithms

SNN脉冲神经网络中IF神经元的matlab仿真

目录 1.内部电位积分 2.阈值判定和脉冲发放 3.脉冲传播时间间隔 4.部分核心程序 第三代神经网络,脉冲神经网络 (Spiking Neural Network,SNN) ,旨在弥合神经科学和机器学习之间的差距,使用最拟合生物神经元机制的模型来进行计算,更接近生物神经元机制。脉冲神经网络与目前流行的神经网络和机器学习方法有着根本上的不同。SNN 使用脉冲——这是一种发

ANN Converse to SNN|(2) Max-Norm

Fast-Classifying, High-Accuracy Spiking Deep Networks Through Weight and Threshold Balancing 作者:Peter U. Diehl,Daniel Neil, Jonathan Binas,Matthew Cook,Shih-Chii Liu and Michael Pfeiffer 会议:IJCNN201

多模态+SNN个人学习历程和心得

祖传开头 这次想写一个一直深藏心中的研究方向,那就是多模态方向。其实当初在实验室那会儿,最先接触的就是多模态的工作,因此这是我科研之路的起点。只不过,后来经历了一些波折,导致个人没有往这个方向深挖,这篇博客主要是想记录一些多模态相关的知识基础,还会涉及一些脉冲神经网络(SNN)的知识,同时记录个人参与过的工作,留下一些回忆。 多模态学习 基本概念 多模态学习,或者称为多模态机器学习(M

2024年顶会、顶刊SNN相关论文----------持续更新中

原文链接:https://blog.csdn.net/qq_43622216/article/details/135167498 个人收集精力有限,欢迎各位评论或者私信告知SNN相关论文研究! 2024年顶会、顶刊SNN相关论文 个人收集精力有限,欢迎各位评论或者私信告知SNN相关论文研究!目录说明AAAI 2024(共15篇)IJCAI 2024ICLR 2024ICML 2024EC

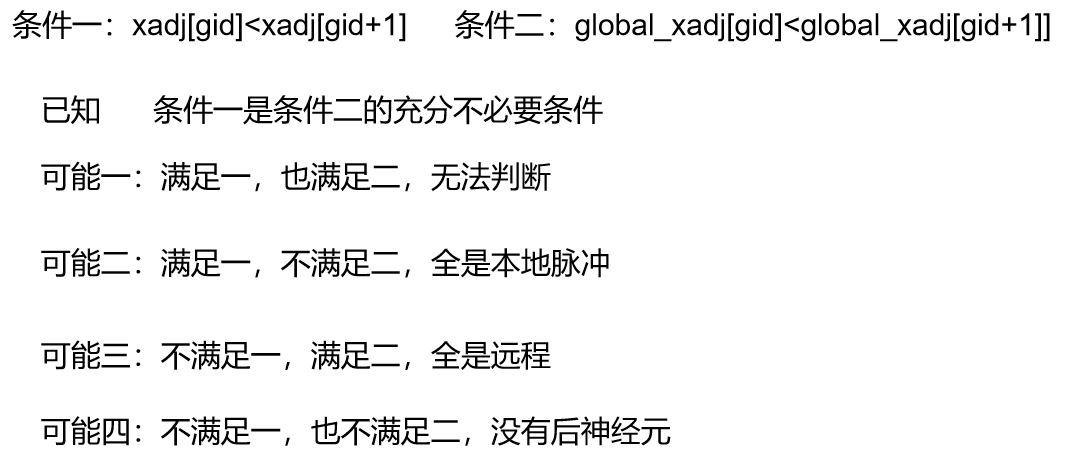

分布式仿真SNN的思考

我之前实现的仿真完全基于如下图设计的 将整体的网络构成见一个邻接表,突触和神经元作为类分别存储,所以当一个神经元发射脉冲时,很容易的将脉冲传输到突触指向的后神经元。但是在分布式方丈中,由多个进程仿真整体的网络,如图所示 那么整体的邻接表就变成了 明显,对于神经元来说,很容易将其进行分区,但是对于突触来说就没那么简单了,有些文献建议将突触和后神经元存储在一起,邻接表就变成上图的

Hadoop商业环境实战-HDFS NameNode 宕机元数据一致保障及SNN机制深入研究

版权声明:本套技术专栏是作者(秦凯新)平时工作的总结和升华,通过从真实商业环境抽取案例进行总结和分享,并给出商业应用的调优建议和集群环境容量规划等内容,请持续关注本套博客。版权声明:禁止转载,欢迎学习。QQ邮箱地址:1120746959@qq.com,如有任何商业交流,可随时联系。 1 从文件目录树谈起(FSImage与EditLog) 文件目录树存在于NameNode的内存里,维护了整个HD

脉冲神经网络(SNN)论文阅读(四)-----IJCAI-2022 多级发射方法的脉冲神经网络

原文链接:CSDN-脉冲神经网络(SNN)论文阅读(四)-----IJCAI-2022 多级发射方法的脉冲神经网络 Multi-Level Firing with Spiking DS-ResNet: Enabling Better and Deeper Directly-Trained Spiking Neural Networks 目录说明相关信息主要贡献MLF方法Dormant-Sup

2023年顶会、顶刊SNN相关论文----------持续更新中

原文链接:https://blog.csdn.net/qq_43622216/article/details/128918566 个人收集精力有限,欢迎各位评论或者私信告知SNN相关论文研究! 2023年顶会、顶刊SNN相关论文 个人收集精力有限,欢迎各位评论或者私信告知SNN相关论文研究!目录说明AAAI2023NeurIPSIJCAI(International Joint Conf