本文主要是介绍2023年顶会、顶刊SNN相关论文,希望对大家解决编程问题提供一定的参考价值,需要的开发者们随着小编来一起学习吧!

原文链接:https://blog.csdn.net/qq_43622216/article/details/128918566

个人收集精力有限,欢迎各位评论或者私信告知SNN相关论文研究!

2023年顶会、顶刊SNN相关论文

- 个人收集精力有限,欢迎各位评论或者私信告知SNN相关论文研究!

- 目录

- 说明

- AAAI2023

- IJCAI(International Joint Conference on Artificial Intelligence)

- ICASSP(IEEE International Conference on Acoustics, Speech and Signal Processing)

- Knowledge-Based Systems

- Pattern Recognition

- ICML

- CVPR

- ICCV(共10篇)

- NeurIPS(共14篇)

- ICLR

目录

说明

这篇博客主要用于记录2023年在一些顶会顶刊(AAAI、CVPR等)上发表的SNN相关论文,以及相关论文的链接及简单介绍。

更新SNN相关论文、动态信息,欢迎浏览讨论!

AAAI2023

-

论文1: Reducing ANN-SNN Conversion Error through Residual Membrane Potential

- 由北京大学余肇飞组发表于AAAI 2023。

-

论文2: Exploring Temporal Information Dynamics in Spiking Neural Networks

- 由耶鲁大学研究人员发表于AAAI 2023。

- 发现Temporal information concentration(TIC)现象:随着网络训练,后期的timestep中蕴含的信息量逐渐减少,而早期的timestep中信息量逐渐增多。

-

论文3: Deep Spiking Neural Networks with High Representation Similarity Model Visual Pathways of Macaque and Mouse

* -

论文4: ESL-SNNs: An Evolutionary Structure Learning Strategy for Spiking Neural Networks

- 由浙江大学唐华锦团队发表于AAAI 2023。

-

论文5: Complex Dynamic Neurons Improved Spiking Transformer Network for Efficient Automatic Speech Recognition

- 由中科院自动化所研究人员发表于AAAI 2023。

- 引入四种类型的神经元动态对脉冲Transformer产生的序列模式进行后处理,得到复杂动态神经元改进脉冲Transformer神经网络(DyTr-SNN)。

- 四种神经元:

-

1、普通的一阶动力学神经元:相似于普通的IF神经元。

-

2、带有自适应阈值的一阶动力学神经元:发射阈值随时间衰减,同时,在接收到脉冲时阈值会增加。

-

3、二阶动力学神经元:

-

4、带有抑制性神经元的双神经元动力学:

-

-

论文6: Astromorphic Self-Repair of Neuromorphic Hardware Systems

- 由宾夕法尼亚州立大学研究人员发表于AAAI 2023。

- 探讨了神经胶质细胞,特别是星形胶质细胞的自我修复作用。

-

论文7: Scaling Up Dynamic Graph Representation Learning via Spiking Neural Networks

- 由中山大学等研究人员发表于AAAI 2023。

IJCAI(International Joint Conference on Artificial Intelligence)

-

论文1: Spike Count Maximization for Neuromorphic Vision Recognition

- IJCAI 2023。

-

论文2: A Low Latency Adaptive Coding Spike Framework for Deep Reinforcement Learning

- 由浙江大学唐华锦团队发表于IJCAI 2023。

-

论文3: Learnable Surrogate Gradient for Direct Training Spiking Neural Networks

- 由浙江大学唐华锦团队发表于IJCAI 2023。

- 推导得出:经过tdBN正则化后的输出,其神经元膜电势的分布服从正态分布,并且仅与膜电势的decay系数相关。

通过将代理梯度中的超参数α和膜电势decay系数β相关联,能自适应地根据每一个时刻每一层的膜电势分布决定代理梯度的形状。

-

论文4: Spatial-Temporal Self-Attention for Asynchronous Spiking Neural Networks

- 由电子科技大学屈鸿、张马路团队发表于IJCAI 2023。

- 提出了新的空间-时间自注意力机制(Spatial-Temporal Self-Attention,STSA)以及spatial-temporal relative position bias (STRPB),并用于构建脉冲STS-Transformer。提出了spatial-temporal relative position bias (STRPB)。

- 相比于已有的注意力机制,STSA不会摧毁SNN的异步特性。STAT机制中最后的输出神经元接收四部分输入:当前位置当前时刻的输入;其它位置当前时刻的输入;当前位置过去的输入;其他位置过去的输入。

-

论文5: Enhancing Efficient Continual Learning with Dynamic Structure Development of Spiking Neural Networks

- 由中科院自动化所曾毅团队发表于IJCAI 2023。

- 提出了Dynamic Structure Development of Spiking Neural Networks (DSD-SNN),当学习一系列任务时,DSD-SNN动态地为新任务分配和生长新神经元,并修剪冗余神经元,从而增加内存容量,减少计算开销。

ICASSP(IEEE International Conference on Acoustics, Speech and Signal Processing)

-

论文1: Adaptive Axonal Delays in feedforward spiking neural networks for accurate spoken word recognition

- 由根特大学研究人员发表于ICASSP 2023。

-

论文2: Joint ANN-SNN Co-training for Object Localization and Image Segmentation

- 由俄亥俄大学研究人员发表于ICASSP 2023。

- 预训练一个ANN,然后将其转换为SNN;

- 对转换后的SNN进行微调:前向过程使用SNN,BP更新的时候将其中的脉冲神经元换成非脉冲的激活函数(等同于ANN)。

-

论文3: Training Robust Spiking Neural Networks with ViewPoint Transform and SpatioTemporal Stretching

- 由华中科技大学研究人员发表于ICASSP 2023。

- 提出了新的神经形态数据增强方法:ViewPoint Transform and SpatioTemporal Stretching (VPT-STS)。通过变换时空域的旋转中心和角度来生成不同视点的样本,从而提高snn的鲁棒性,引入spatiotemporal stretching避免在视角转换中的信息损失。

- 视点变换通过引入平衡系数来解决样本的时空尺度失配问题,通过在时空域中变换旋转中心和角度来生成不同视点的样本。

-

论文4: Leveraging Sparsity with Spiking Recurrent Neural Networks for Energy-Efficient Keyword Spotting

* -

论文5: Training Robust Spiking Neural Networks on Neuromorphic Data with Spatiotemporal Fragments

- 由华中科技大学研究人员发表于ICASSP 2023。

- 提出了Event SpatioTemporal Fragments (ESTF)对神经形态数据进行增强,在时空和极性域对event片段进行反转(ISTP),在时空域进行漂移(DST)。

- ISTP:在时间域、空间域或极性域反转event。

- DST:在时间域或空间域将event偏移一定的距离,丢弃超出边界的部分。

-

论文6: Training Stronger Spiking Neural Networks with Biomimetic Adaptive Internal Association Neurons

- 由华中科技大学研究人员发表于ICASSP 2023。

- associative long-term potentiation (ALTP) phenomenon:除了神经元之间的学习机制外,神经元内部还存在关联效应。当同时受到刺激时,神经元内部会产生联想效应,且效果与输入权值呈正相关。

- 提出了Adaptive Internal Association (AIA) neuron model,当一个神经元的多个突触同时受到刺激时应该具有额外的效果(使用一个函数 f ( . ) f(.) f(.)对输入电流x进行过滤)函数 f ( x ) f(x) f(x)对 x x x的导数建模为 x x x。

-

论文7: In-Sensor & Neuromorphic Computing Are all You Need for Energy Efficient Computer Vision

*

Knowledge-Based Systems

- 论文1: An Improved Probabilistic Spiking Neural Network with Enhanced Discriminative Ability

- 电子科技大学左琳教授团队研究人员发表于Knowledge-Based Systems

- 使用平滑的概率机制替换不可微分的脉冲活动

- 将注意力机制用于脉冲神经元累积膜电势的过程中

Pattern Recognition

- 论文1: Joint A-SNN: Joint Training of Artificial and Spiking Neural Networks via Self-Distillation and Weight Factorization

-

中国航天科工集团公司智能科学技术研究院研究人员发表于Pattern Recognition

-

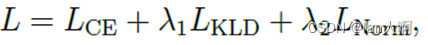

将网络(ANN和SNN)分为多个stage,每个stage后跟着全局平均池化和全连接层,每一个输出都和label计算交叉熵loss。

-

每一个stage,ANN的输出作为label和SNN对应的输出计算KL散度loss。ANN的输出进行detach处理。

-

ANN和SNN提取到的特征可能有不同的标准化幅度。每一个stage,ANN的输出作为label和SNN对应的输出计算L2 norm loss(向量的模的平方,不开根号)。ANN的输出进行detach处理。

-

前几个stage的输出计算loss能够缓和SNN中由于梯度爆炸/消失引起的前几层网络无法训练的问题。

-

最终的训练loss为:

-

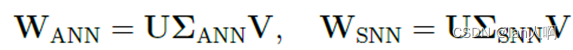

提出了weight-factorization training (WFT):对ANN和SNN的参数进行因子分解,使其具有相同的奇异向量(U和V),但是各自的奇异值可以不同。

-

U、V以及ANN和SNN的对角矩阵基于梯度下降进行优化。

-

ICML

-

论文1: Adaptive Smoothing Gradient Learning for Spiking Neural Networks

- 由浙江大学唐华锦组发表于ICML2023。

- 前向传播过程中的阶跃函数被修改为代理梯度函数的不定积分结合阶跃函数,BP更新时仅使用代理梯度。前向传播过程中由于阶跃函数被修改所以产生实值的输出,但推理阶段还是使用阶跃函数。

- 为了确保网络最终能够进化为一个SNN,设置代理梯度中的 α \alpha α可学习。

-

论文2: A Unified Optimization Framework of ANN-SNN Conversion: Towards Optimal Mapping from Activation Values to Firing Rates

- 由阿联酋阿布扎比穆罕默德·本·扎耶德人工智能大学、哈工大等研究人员发表于ICML2023。

-

论文3: Surrogate Module Learning: Reduce the Gradient Error Accumulation in Training Spiking Neural Networks

- 由电子科技大学顾实团队、耶鲁大学等研究人员发表于ICML2023。

CVPR

- 论文1: Rate Gradient Approximation Attack Threats Deep Spiking Neural Networks

- 由北京大学余肇飞组发表于CVPR 2023。

- 论文2: 1000 FPS HDR Video with a Spike-RGB Hybrid Camera

- 由北京大学黄铁军组发表于CVPR 2023。

- 论文3: Constructing Deep Spiking Neural Networks from Artificial Neural Networks with Knowledge Distillation

- 由大连理工大学徐齐、浙江大学唐华锦团队发表于CVPR 2023。

- 联合ANN和SNN使用知识蒸馏训练SNN。

提出了两种方式:response-based knowledge distillation和feature-based knowledge distillation。

ICCV(共10篇)

-

论文1: Deep Directly-Trained Spiking Neural Networks for Object Detection

- 由中科院(李国齐)、西安交大、清华大学、北京大学、华为等机构研究人员发表于ICCV 2023。

- 提出了Energy-efficient Membrane-Shortcut ResNet(EMS-ResNet)和EMS-YOLO,实现低能耗、高效的目标检测。

-

论文2: Towards Memory- and Time-Efficient Backpropagation for Training Spiking Neural Networks

- 由香港中文大学、北京大学(Zhouchen Lin)、鹏城实验室等研究人员发表于ICCV 2023。

- 发现时间维度的梯度和空间维度的梯度相比很小,梯度中的空间部分主导着梯度。因此提出了Spatial Learning Through Time (SLTT)方法忽视训练过程中的时间关系,从而在每个时间步长内可以单独更新参数以降低训练过程中的时间和内存开销。

- SLTT-K:训练过程中的每次迭代随机选择K个时间索引,仅在这K个时间步长中更新参数。

-

论文3: Masked Spiking Transformer

- 由香港科技大学(广州)许人镜组、北卡罗莱纳州立大学、香港大学等研究人员发表于ICCV 2023。

- 基于quantal synaptic failures(量子突触失效,说明神经信号传输过程中丢失的信息可能不会影响突触后神经元的计算信息,但能够降低能耗),构建ANN转SNN的Transformer模型。

- 提出了Masked Spiking Transformer(MST),合并了Random Spike Masking(RSM)方法。

- 使用Swin Transformer作为backbone,把LN替换成BN,使用QCFS转换ANN到IF神经元。

- RSM:随机mask一部分输入的脉冲信号。

-

论文4: Unleashing the Potential of Spiking Neural Networks with Dynamic Confidence

- 由曼彻斯特大学研究人员发表于ICCV 2023。

- 为每一个样本动态地决定SNN推理应该使用的时间步长。

-

论文5: Membrane Potential Batch Normalization for Spiking Neural Networks

- 由中国航天科工集团公司智能科学技术研究院等研究人员发表于ICCV 2023。

- 在脉冲神经元累积膜电势之后对膜电势使用BN,然后再产生脉冲。使用重新参数化在推理时将BN合并入发射阈值,因此不影响推理效率。

-

论文6: Inherent Redundancy in Spiking Neural Networks

- 由西安交大、自动化所李国齐组等研究人员发表于ICCV 2023。

- 使用注意力机制减少冗余的脉冲。

- 先将接收到的输入从时间和通道维度划分为两组,对于每一组单独应用空间注意力机制然后再进行拼接。调整膜电势分布从而优化输出的脉冲。

-

论文7: Temporal-Coded Spiking Neural Networks with Dynamic Firing Threshold: Learning with Event-Driven Backpropagation

- 由电子科技大学(屈鸿、张马路组)、诺森比亚大学、清华大学等研究人员发表于ICCV 2023。

-

论文8: RMP-Loss: Regularizing Membrane Potential Distribution for Spiking Neural Networks

- 由中国航天科工集团公司智能科学技术研究院等研究人员发表于ICCV 2023。

- 使用额外的损失项限制脉冲神经元的膜电势向0/1靠近。使用MPR(ECCV 2022)里提出的函数。

-

论文9: Efficient Converted Spiking Neural Network for 3D and 2D Classification

- 由厦门大学、清华大学、东北大学等研究人员发表于ICCV 2023。

- 应用ANN转SNN进行3D分类(点云)。

- 阈值的初始化:逐层设置能使得ANN和SNN输出的KL散度最小的脉冲神经元阈值。

- Adaptive Dynamic Threshold Based on Activation State:用于转换后的推理时,基于未激活的神经元比例计算一个系数w,当比例较高时 w w w较低,从而 w w w与阈值的加权较低,让更多神经元产生脉冲。

- adaptive firing mechanism:使用α调节膜电势,膜电势达到多少倍的阈值就发射几个脉冲(多比特脉冲)。设置脉冲数量上界为 2 n − 1 2^n-1 2n−1和下界为0

-

论文10: SSF: Accelerating Training of Spiking Neural Networks with Stabilized Spiking Flow

- 由中科院自动化所、西安交通大学等研究人员发表于ICCV 2023。

NeurIPS(共14篇)

-

论文1: Spiking PointNet: Spiking Neural Networks for Point Clouds

- 由中国航天科工集团公司智能科学技术研究院等研究人员发表于NeurIPS 2023。

- 提出了Spiking PointNet(SNN版本的PointNet)用于点云识别。

- 提出了Trained-less But Learning-more Framework:训练时时间步长小(使用1),推理时时间步长较大。

- 静态数据(包括点云)中不存在时序特征,SNN的时间步长增大导致效果变好的原因可能在于每个时间步长的初始膜电势(有残余)不同,因此多个时间步长的输出相当于多个模型的集成。

- 提出了Membrane Potential Perturbation:在训练时,每个epoch随机初始化脉冲神经元的初始膜电势。

-

论文2: Spike-driven Transformer

- 由中科院自动化所李国齐团队发表于NeurIPS 2023。

-

论文3: Evolving Connectivity for Recurrent Spiking Neural Networks

- 由清华大学等研究人员发表于NeurIPS 2023。

-

论文4: Exploring Loss Functions for Time-based Training Strategy in Spiking Neural Networks

- 由北京大学黄铁军、于肇飞团队发表于NeurIPS 2023。

-

论文5: EICIL: Joint excitatory inhibitory cycle iteration learning for deep spiking neural networks

- 由大连理工大学徐齐团队等研究人员发表于NeurIPS 2023。

- 提出了Deep Spiking Neural Networks with Joint Excitatory Inhibition Loop Iterative Learning (EICIL)方法训练SNN。

- 使用多层STDP-BW(在STDP中合并BP机制)方法作为EICIL中的抑制机制,梯度替换方法实现刺激机制。

- 方法1:异质性学习:最后一层线形层使用STDP训练,其余层使用梯度替换训练,每一轮权重更新后使用STDP微调。

- 方法2:循环迭代学习:每个epoch代表网络模型中的一个训练周期,使用不同的时间步长作为间隔,迭代使用兴奋和抑制机制来训练网络。利用当前兴奋机制获得的最优结果来训练抑制机制,反过来利用当前抑制机制获得的最优结果来训练兴奋机制。

-

论文6: Addressing the speed-accuracy simulation trade-off for adaptive spiking neurons

- 由牛津大学等研究人员发表于NeurIPS 2023。

- 重新解释adaptive leaky integrate-and-fire (ALIF)模型,以实现速度和精度的权衡。

- ALIF模型:自适应地改变发射阈值,具有不应期。

-

论文7: Parallel Spiking Neurons with High Efficiency and Ability to Learn Long-term Dependencies

- 由北京大学于肇飞团队发表于NeurIPS 2023。

- 当去除重置时,神经元动力学以非迭代形式重新表述,并且可以并行化。

- 提出了Parallel piking Neuron (PSN)和两个变体:masked PSN和sliding PSN。

-

论文8: Unsupervised Optical Flow Estimation with Dynamic Timing Representation for Spike Camera

- 由北京大学黄铁军、于肇飞团队发表于NeurIPS 2023。

-

论文9: Meta-learning families of plasticity rules in recurrent spiking networks using simulation-based inference

- 由奥地利科学技术研究所等研究人员发表于NeurIPS 2023。

-

论文10: Temporal Conditioning Spiking Latent Variable Models of the Neural Response to Natural Visual Scenes

- 由浙江大学唐华锦团队发表于NeurIPS 2023。

-

论文11: Enhancing Adaptive History Reserving by Spiking Convolutional Block Attention Module in Recurrent Neural Networks

- 由大连理工大学徐齐团队、浙江大学唐华锦团队发表于NeurIPS 2023。

- 在Spiking ConvLSTM中融入Spiking CBAM机制,提取历史信息。

-

论文12: Trial matching: capturing variability with data-constrained spiking neural networks

- 由洛桑理工学院研究人员发表于NeurIPS 2023。

-

论文13: SparseProp: Efficient Event-Based Simulation and Training of Sparse Recurrent Spiking Neural Networks

- 由哥伦比亚大学的Rainer Engelken发表于NeurIPS 2023。

-

论文14: SEENN: Towards Temporal Spiking Early Exit Neural Networks

- 由耶鲁大学研究人员(Yuhang Li)发表于NeurIPS 2023。

- 提出了Spiking Early-Exit Neural Networks (SEENNs),对于每个样本,在测试时使用不同的时间步长。简单的样本在较短的时间步长内结束,难识别的样本使用长时间步长。

- SEENN-Ⅰ:使用置信度阈值,以尽可能快的速度输出一个置信度预测。预设一个阈值,在每个时间步都计算置信度(输出层的softmax值的最大者),一旦置信度达到阈值就输出。

- SEENN-Ⅱ:使用强化学习找到最优的时间步长。使用一个policy network产生n维的policy vector,基于policy vector产生的时间步长运行SNN,SNN的输出计算reward function

ICLR

-

论文1: Bridging the Gap between ANNs and SNNs by Calibrating Offset Spikes

- 由北京大学余肇飞组发表于ICLR 2023。

-

论文2: A Unified Framework for Soft Threshold Pruning

- 由北京大学余肇飞组发表于ICLR 2023。

-

论文3: Heterogeneous Neuronal and Synaptic Dynamics for Spike-Efficient Unsupervised Learning: Theory and Design Principles

- 佐治亚理工学院电气与计算机工程系研究人员发表于ICLR 2023。

- 神经元和突触动力学的异质性降低了循环脉冲神经网络(RSNN)的脉冲活动,同时提高了预测性能。仅仅使用神经元的异质性能够提升性能,但不会影响脉冲发射活动。

- 神经元整合/松弛动力学的多样性提高了RSNN学习更多不同输入模式的能力(更高的记忆容量),从而提高了性能。进一步证明了突触的异质STDP动力学降低了脉冲活动但保留了记忆容量。

- 异质性的神经元:使用具有不同膜电势时间常数和阈值的LIF神经元,这些膜电势时间常数和阈值来自于某个分布。

- 异质性的STDP:使用不同的突触时间常数和scaling functions η \eta η。

-

论文4: Spiking Convolutional Neural Networks for Text Classification

- 复旦大学计算机科学学院研究人员发表于ICLR 2023。

- 通过转换+微调训练SNN用于文本分类。

-

论文5: Spikformer: When Spiking Neural Network Meets Transformer

- 北极大学、鹏城实验室等研究人员发表于ICLR 2023。

- 提出了Spiking Self Attention (SSA)以及Spiking Transformer (Spikformer),通过使用脉冲版本的query、key、value来实现注意机制。

本文出自于CSDN-lan人啊,转载请注明!

这篇关于2023年顶会、顶刊SNN相关论文的文章就介绍到这儿,希望我们推荐的文章对编程师们有所帮助!