recall专题

命名实体识别(NER)-模型评估:词级别评估、实体级别评估【Precision、Recall、F1】

一、概述 命名实体识别的评判标准:实体的边界是否正确;实体的类型是否标注正确。主要错误类型包括: 文本正确,类型可能错误;反之,文本边界错误,而其包含的主要实体词和词类标记可能正确。 对于二分类的模型,预测结果与实际结果分别可以取0和1。我们用N和P代替0和1,T和F表示预测正确和错误。将他们两两组合,就形成了下图所示的混淆矩阵(注意:组合结果都是针对预测结果而言的)。 由于1和0是数字

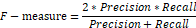

分类问题的评价指标:多分类【Precision、 micro-P、macro-P】、【Recall、micro-R、macro-R】、【F1、 micro-F1、macro-F1】

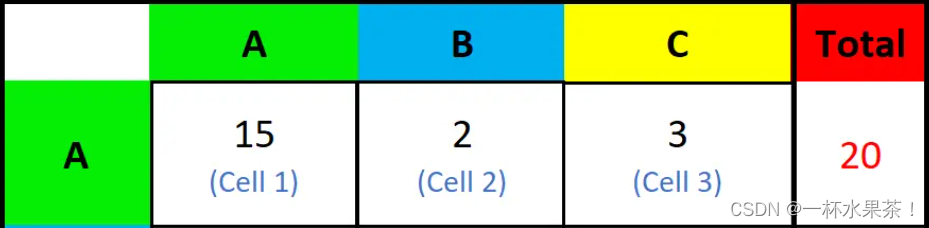

一、混淆矩阵 对于二分类的模型,预测结果与实际结果分别可以取0和1。我们用N和P代替0和1,T和F表示预测正确和错误。将他们两两组合,就形成了下图所示的混淆矩阵(注意:组合结果都是针对预测结果而言的)。 由于1和0是数字,阅读性不好,所以我们分别用P和N表示1和0两种结果。变换之后为PP,PN,NP,NN,阅读性也很差,我并不能轻易地看出来预测的正确性与否。因此,为了能够更清楚地分辨各种预测情

ROC Recall Precision Accuracy FPR TPR TAR FAR

分类 混淆矩阵ROCAUCPR曲线回归 平均绝对误差平均平方误差Ref: 分类 混淆矩阵 probablity distribution True Positive(真正, TP):将正类预测为正类数.True Negative(真负 , TN):将负类预测为负类数.False Positive(假正, FP):将负类预测为正类数 →误报 (Type I error).

coco如何计算map的,recall如何插值的

不同召回率阈值是通过将累积的真阳性数量除以所有正样本的数量来产生的。在代码中,召回率阈值 `recThrs` 是预定义的,是用于评估的标准参数。具体步骤如下: 1. **预定义召回率阈值:** - `recThrs` 是在参数 `p` 中预定义的,是一组固定的值,用于在评估过程中衡量不同的召回率水平。 - 例如,`recThrs` 可能是一个从 0 到 1 的等间隔数组,用于表示从

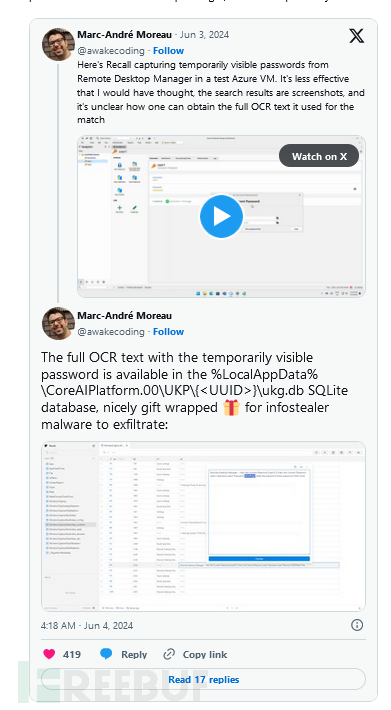

[240614] 微软推迟发布 Recall AI 功能 | YouTube 尝试在服务器端注入广告

目录 微软推迟发布 Recall AI 功能YouTube 尝试在服务器端注入广告 微软推迟发布 Recall AI 功能 微软表示,由于担心隐私风险,不会在下周推出 “Recall” 功能,这是一项跟踪计算机使用情况的 AI 功能 Recall 功能能跟踪网页浏览,语音聊天,和计算机上的操作记录,用户可以随时对过去他们所做的事情进行搜索微软表示,Recall 功能将在未来几

微软无所不知的人工智能召回功能“Recall”被推迟,将不会与 Copilot Plus PC 一起提供

微软计划下周推出新的 Copilot Plus 个人电脑,取消其备受争议的 Recall 功能,该功能可以截取您在这些新笔记本电脑上所做的所有操作。该软件制造商推迟了 Recall,以便可以通过 Windows Insider 程序对其进行测试,此前该公司最初承诺将 Recall 作为一项可选功能提供,并进行额外的安全改进。 喜好儿网 微软在更新的博客文章中表示:“我们正在调整 Recal

sklearn工具包---分类效果评估(acc、recall、F1、ROC、回归、距离)

一、acc、recall、F1、混淆矩阵、分类综合报告 1、准确率 第一种方式:accuracy_score # 准确率import numpy as npfrom sklearn.metrics import accuracy_scorey_pred = [0, 2, 1, 3,9,9,8,5,8]y_true = [0, 1, 2, 3,2,6,3,5,9] #共9个数据,3个相

微软Recall功能争议及其背后的网络安全与用户期望

微软Recall功能争议及其背后的网络安全与用户期望 一、引言 随着技术的迅猛发展,操作系统作为软件生态的基石,其稳定性和用户体验的重要性日益凸显。微软作为操作系统领域的巨头,其每一次的产品更新和功能发布都备受关注。然而,距离微软Build大会刚刚过去15天,其发布的Recall预览版功能便引发了广泛争议,遭到了来自网络安全人士、开发者乃至普通消费者的抵制。本文将围绕Recall功能的争议展开

微软新AI工具 Recall 被白帽公开锤了?

近日,一些网络安全研究人员演示了恶意软件是如何成功窃取 Windows Recall 工具收集到的数据。 2024年5月21日,微软发布全新的“Copilot+PC”,这类 AI PC 通过与高通的最新芯片合作,实现了一个叫做“Recall”的功能。借助这个人工智能工具,用户可以搜索和回忆在PC上看到或做过的任何事情。工具推出后,鉴于其扫描并保存电脑屏幕的定期截图,有可能暴露敏感数据,例如

微软新功能Recall引发隐私担忧,英国数据监管机构展开调查

每周跟踪AI热点新闻动向和震撼发展 想要探索生成式人工智能的前沿进展吗?订阅我们的简报,深入解析最新的技术突破、实际应用案例和未来的趋势。与全球数同行一同,从行业内部的深度分析和实用指南中受益。不要错过这个机会,成为AI领域的领跑者。点击订阅,与未来同行! 订阅:https://rengongzhineng.io/ 英国数据监管机构(ICO)表示,正在“向微软进行询问”,了解其新功能

precision_score, recall_score, f1_score的计算

1 使用numpy计算true positives等 [python] view plain copy import numpy as np y_true = np.array([0, 1, 1, 0, 1, 0]) y_pred = np.array([1, 1, 1, 0, 0, 1]) # true positive TP = np.

【AI】图示:精确度(查准率)Precision、召回率(查全率)Recall

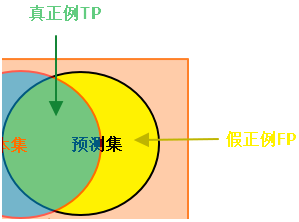

对Precision、Recall的直译是“精确度”和“召回率”,第一次接触这两个词,很难从字面上知道它们的含义。而翻译成“查准率”和“查全率”就比较好理解,下面统一使用“查准率”和“查全率”。 1、真假正负例 真正例(True Positive, TP):预测值和真实值都为1 假正例(False Positive,FP):预测值为1,真实值为0 真负例(True Negative,TN)

python计算precision@k、recall@k和f1_score@k

sklearn.metrics中的评估函数只能对同一样本的单个预测结果进行评估,如下所示: from sklearn.metrics import classification_reporty_true = [0, 5, 0, 3, 4, 2, 1, 1, 5, 4]y_pred = [0, 2, 4, 5, 2, 3, 1, 1, 4, 2]print(classification_repo

[机器学习] 第二章 模型评估与选择 1.ROC、AUC、Precision、Recall、F1_score

准确率(Accuracy) = (TP + TN) / 总样本 =(40 + 10)/100 = 50%。 定义是: 对于给定的测试数据集,分类器正确分类的样本数与总样本数之比。 精确率(Precision) = TP / (TP + FP) = 40/60 = 66.67%。它表示:预测为正的样本中有多少是真正的正样本,它是针对我们预测结果而言的。Precision又称为查准率。 召回率

【YOLO学习】召回率(Recall),精确率(Precision),平均正确率(Average_precision(AP) ),交除并(Intersection-over-Union(IoU))

摘要 在训练YOLO v2的过程中,系统会显示出一些评价训练效果的值,如Recall,IoU等等。为了怕以后忘了,现在把自己对这几种度量方式的理解记录一下。 这一文章首先假设一个测试集,然后围绕这一测试集来介绍这几种度量方式的计算方法。 大雁与飞机 假设现在有这样一个测试集,测试集中的图片只由大雁和飞机两种图片组成,如下图所示: 假设你的分类系统最终的目的是:能取出测试集中所有飞机的

Accuracy准确率,Precision精确率,Recall召回率,F1 score

真正例和真反例是被正确预测的数据,假正例和假反例是被错误预测的数据。然后我们需要理解这四个值的具体含义: TP(True Positive):被正确预测的正例。即该数据的真实值为正例,预测值也为正例的情况; TN(True Negative):被正确预测的反例。即该数据的真实值为反例,预测值也为反例的情况; FP(False Positive):被错误预测的正例。即该数据的真实值为反例,但被错误预

【目标检测】计算YOLOv5/7/8/9的TP, FP, FN, Recall和Precision

1. 设定IoU和Conf阈值 2. 保存推理结果的txt文件 3. 计算TP, FP, FN import osclasses = {0: "class 1",1: "class 2"}def iou(box1, box2):box1_x1 = box1[0] - box1[2] / 2box1_y1 = box1[1] - box1[3] / 2box1_x2 = box1[0] + b

评价指标_Precision(精确率)、Recall(召回率)和Accuracy(准确率)区别和联系

Precision(精确率)、Recall(召回率)和Accuracy(准确率)是机器学习和信息检索领域常用的评价指标,它们用于评估分类器或检索系统的性能,但各自关注的方面略有不同。 Precision(精确率): 精确率是指分类器在预测为正例的样本中,真正为正例的比例。公式:Precision = TP / (TP + FP)其中,TP 表示真正例(True Positives),FP 表示

分类任务中的评估指标:Accuracy、Precision、Recall、F1

概念理解 T P TP TP、 T N TN TN、 F P FP FP、 F N FN FN精度/正确率( A c c u r a c y Accuracy Accuracy) 二分类查准率 P r e c i s i o n Precision Precision,查全率 R e c a l l Recall Recall 和 F 1 − s c o r e F1-score

增加负样本对二分类precision, recall指标的影响

背景 最近在做一个二分类模型,通过增加一半随机采样负样本(3000->6000, 负正样本比由0.74:0.25上升至0.87:0.12, 即3:1上升至7:1),精确率提高2%(89%->91),召回率降低6%(62->57%); 为什么在训练集中增加负样本能够提升精确率? 从精确率的公式上解释,precision = tp/(tp+fp), 增加负样本,实际上是增强模型对负样本的识别能力,因

Python3写精确率(precision)、召回率(recall)以及F1分数(F1_Score)

1. 四个概念定义:TP、FP、TN、FN 先看四个概念定义: - TP,True Positive - FP,False Positive - TN,True Negative - FN,False Negative 如何理解记忆这四个概念定义呢? 举个简单的二元分类问题 例子: 假设,我们要对某一封邮件做出一个判定,判定这封邮件是垃圾邮件、还是这封邮件不是垃圾邮件? 如果判定

评价指标对比:准确率(accuracy)、精确率(Precision)、召回率(Recall)、IOU、Kappa系数

https://blog.csdn.net/zsc201825/article/details/93487506

关于机器学习中准确率(Accuracy) | 查准率(Precision) | 查全率(Recall)

准确率(Accuracy) | 查准率(Precision) | 查全率(Recall) 在机器学习中,对于一个模型的性能评估是必不可少的。准确率(Accuracy)、查准率(Precision)、查全率(Recall)是常见的基本指标。 为了方便说明,假设有以下问题场景: 一个班有50人,在某场考试中有40人及格,10人不及格。 现在需要根据一些特征预测出所有及格的学生。 在某一

理解查全率(precision)与查准率(recall)

理解查全率与查准率 1. 概念解读2. F 1 F_1 F1度量3. F β F_\beta Fβ度量 1. 概念解读 在一个二分类问题中,非对既是错 真实情况\预测情况positivenegativeTrueTPTNFalseFPFN Notice: 上面的图表是个反例,错误的原因是T\F的使用,T代表着预测正确,F代表着预测错误。 真实情况\预测情况positi

机器学习性能评估指标---准确率(Accuracy), 精确率(Precision), 召回率(Recall)

分类 混淆矩阵1 True Positive(真正, TP):将正类预测为正类数.True Negative(真负 , TN):将负类预测为负类数.False Positive(假正, FP):将负类预测为正类数 → → 误报 (Type I error).False Negative(假负 , FN):将正类预测为负类数 → → 漏报 (Type II error).

在分类任务中准确率(accuracy)、精确率(precision)、召回率(recall)和 F1 分数是常用的性能指标,如何在python中使用呢?

在机器学习和数据科学中,准确率(accuracy)、精确率(precision)、召回率(recall)和 F1 分数是常用的性能指标,用于评估分类模型的性能。 1. 准确率(Accuracy): 准确率是模型预测正确的样本数占总样本数的比例。 from sklearn.metrics import accuracy_score y_true = [0, 1, 1, 0, 1, 1]

![[机器学习] 第二章 模型评估与选择 1.ROC、AUC、Precision、Recall、F1_score](https://img-blog.csdnimg.cn/20210418025501926.png?x-oss-process=image/watermark,type_ZmFuZ3poZW5naGVpdGk,shadow_10,text_aHR0cHM6Ly9ibG9nLmNzZG4ubmV0L1RyYW5jZTk1,size_16,color_FFFFFF,t_70)