mediapipe专题

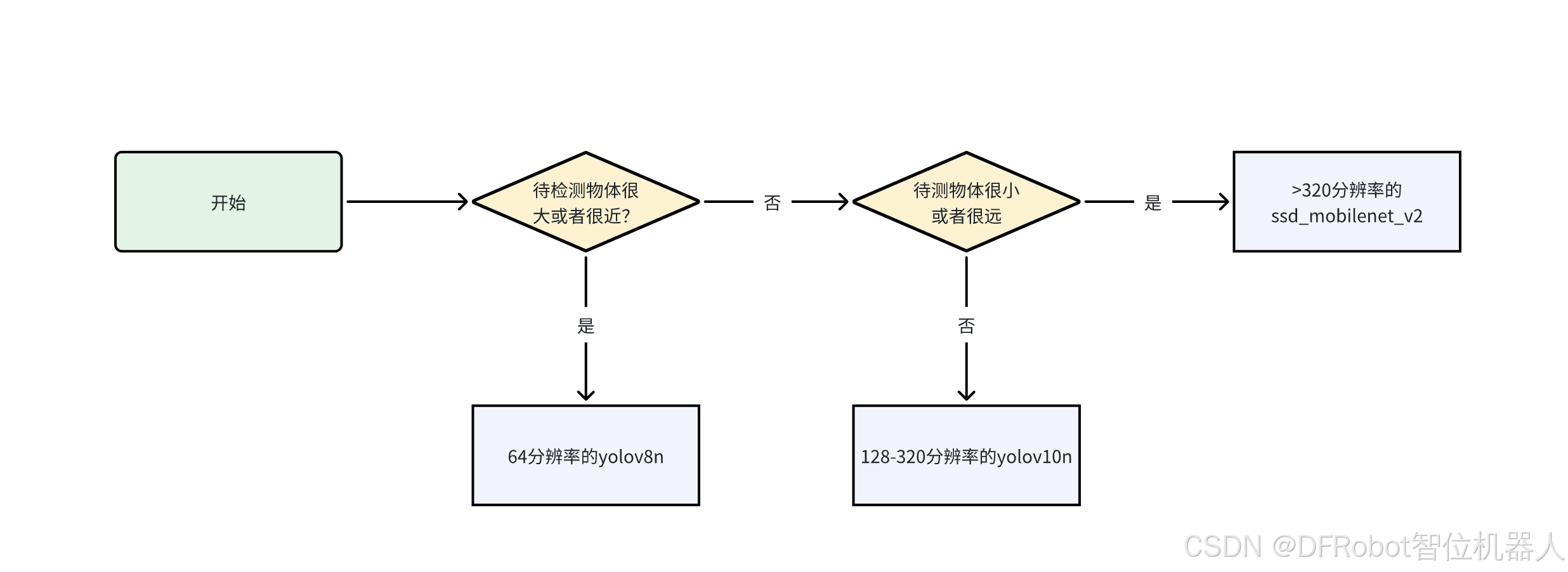

行空板上YOLO和Mediapipe视频物体检测的测试

Introduction 经过前面三篇教程帖子(yolov8n在行空板上的运行(中文),yolov10n在行空板上的运行(中文),Mediapipe在行空板上的运行(中文))的介绍,我们对如何使用官方代码在行空板上运行物体检测的AI模型有了基本的概念,并对常见的模型进行了简单的测试和对比。 在行空板上YOLO和Mediapipe图片物体检测的测试(中文)中我们对于行空板上使用YOLO和Medi

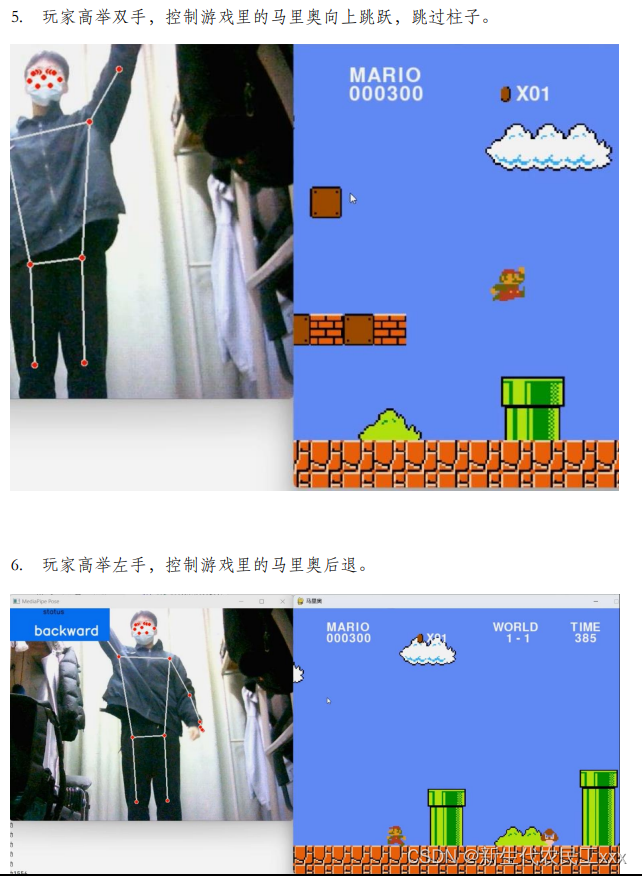

基于Python的mediapipe和opencv的人体骨骼、人体姿态关键点的实时跟踪项目

随着计算机视觉技术的发展,人体姿态估计在虚拟现实、运动分析、人机交互等领域得到了广泛应用。传统的姿态估计方法通常依赖于深度学习模型,需要大量的计算资源。而 Google 开发的 MediaPipe 框架则提供了高效且易于使用的解决方案,它可以在各种设备上运行实时的多模态应用。 项目目标 本项目旨在利用 MediaPipe 和 OpenCV 实现对人体姿态关键点的实时检测和跟踪,并通过可视化

Mediapipe holistic pose 以及 blazepose 的前端开发

文章目录 参考: 参考: 1、blazepose:https://github.com/tensorflow/tfjs-models/tree/master/pose-detection/src/blazepose_mediapipe

谷歌Mediapipe安装部署教程

MediaPipe Solutions 提供了一套库和工具,可帮助您在您的应用中快速应用人工智能 (AI) 和机器学习 (ML) 技术。您可以立即将这些解决方案插入到您的应用中,根据需要对其进行自定义,并在多个开发平台上使用。MediaPipe Solutions 是 MediaPipe 开源项目的一部分,因此您可以进一步自定义解决方案代码以满足您的应用需求。MediaPipe 解决方案套件包括以

Mediapipe 在RK3399PRO上的初探(二)(自定义Calculator)

PS:要转载请注明出处,本人版权所有。 PS: 这个只是基于《我自己》的理解, 如果和你的原则及想法相冲突,请谅解,勿喷。 环境说明 Ubuntu 18.04gcc version 7.5.0 (Ubuntu 7.5.0-3ubuntu1~18.04)RK3399PRO 板卡 前言 本文有一篇前置文章为《Mediapipe 在RK3399PRO上的初探(一)(编译、运行CPU和GPU

Mediapipe 在RK3399PRO上的初探(一)(编译、运行CPU和GPU Demo, RK OpenglES 填坑,编译bazel)

PS:要转载请注明出处,本人版权所有。 PS: 这个只是基于《我自己》的理解, 如果和你的原则及想法相冲突,请谅解,勿喷。 前置说明 BlogID=103 环境说明 Ubuntu 18.04gcc version 7.5.0 (Ubuntu 7.5.0-3ubuntu1~18.04)OpenGl ES 3.1 or 3.1+RK3399PRO 板卡 前言 由于我们小组的产品

【Modelground】个人AI产品MVP迭代平台(4)——Mediapipe视频处理网站介绍

文章目录 介绍模型配置输入输出核心实现(源码)总结 介绍 这篇文章我将硬核介绍Modelground的第一个产品——Mediapipe视频处理!网站入口为https://tryiscool.space/ml-video/,如图所示,欢迎体验。 tip: 由于服务器带宽较小,初次加载模型需要一定的等待时间。 Mediapipe视频处理的目标是:在线生成Mediapipe各类模

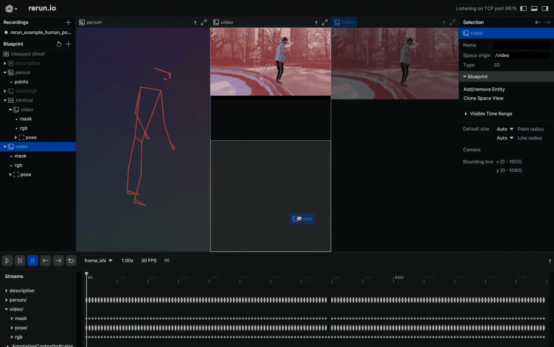

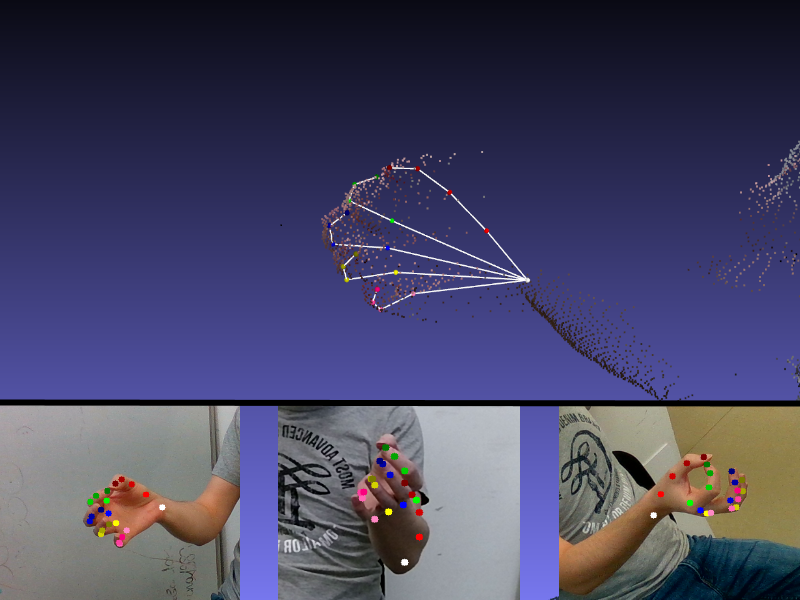

基于 MediaPipe 的 2D 和 3D 的人体姿态追踪:Rerun 展示

点击下方卡片,关注“小白玩转Python”公众号 概述 我们探讨一个使用 MediaPipe 在 2D 和 3D 中追踪人体姿态的用例。使这次探索更加有趣的是通过开源可视化工具 Rerun 提供的可视化功能,可以全方位展示人体姿态的动态。在这篇博文中,您将学习如何使用 MediaPipe 追踪 2D 和 3D 的人体姿态,并探索 Rerun 的可视化能力。 人体姿态追踪 人体姿态追踪是计算机视

1.1 Mediapipe随手简记(一)

为了后续项目展开,需要Python、C++、Linux、OpenCV、Mediapipe、ROS知识。 最后面有手势识别(数字)精准案例,项目会用到。 Mediapipe学习篇1 Mediapipe 是一个开源的跨平台框架,它提供了大量的解决方案,用于构建高性能、跨平台的计算机视觉应用。Mediapipe 使用计算图(Calculation Graph)来表示算法的执行流程,可以轻松地组合和

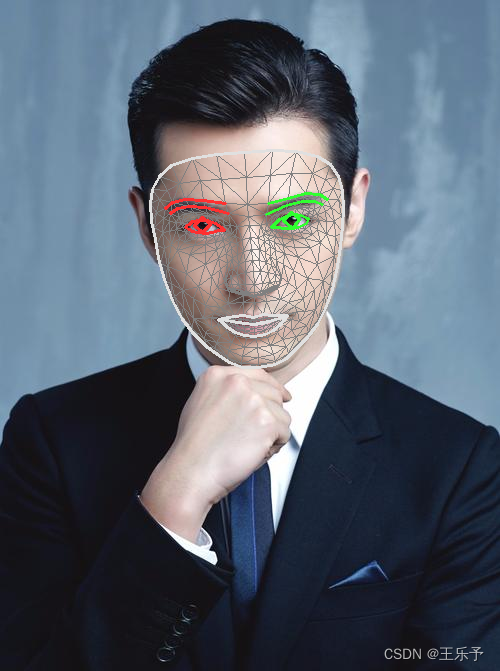

【深度学习实战—9】:基于MediaPipe的人脸关键点检测

✨博客主页:王乐予🎈 ✨年轻人要:Living for the moment(活在当下)!💪 🏆推荐专栏:【图像处理】【千锤百炼Python】【深度学习】【排序算法】 目录 😺一、MediaPipe概述😺二、MediaPipe人脸关键点检测概述😺三、关键函数😺四、代码实现😺五、检测结果 😺一、MediaPipe概述 MediaPipe 是一款由 Goog

【深度学习实战—8】:基于MediaPipe的人脸检测

✨博客主页:王乐予🎈 ✨年轻人要:Living for the moment(活在当下)!💪 🏆推荐专栏:【图像处理】【千锤百炼Python】【深度学习】【排序算法】 目录 😺一、MediaPipe概述😺二、MediaPipe人脸检测概述😺三、程序实现😺四、检测结果 😺一、MediaPipe概述 MediaPipe 是一款由 Google Research

基于开源二兄弟MediaPipe+Rerun实现人体姿势跟踪可视化

概述 本文中,我们将探索一个利用开源框架MediaPipe的功能以二维和三维方式跟踪人体姿势的使用情形。使这一探索更有趣味的是由开源可视化工具Rerun提供的可视化展示,该工具能够提供人类动作姿势的整体视图。 您将一步步跟随作者使用MediaPipe在2D和3D环境中跟踪人体姿势,并探索工具Rerun的可视化功能。 人体姿势跟踪 人体姿势跟踪是计算机视觉中的一项任务,其重点是识别关键的身体

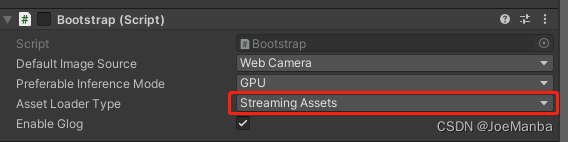

插件:MediaPipe

一、介绍 这是一个使用 MediaPipe (0.10.9) 的 Unity (2022.3.16f1) 原生插件;此项目的目标是将 MediaPipe API (C++) 逐个移植到 C#,以便可以从 Unity 调用它。开源地址。 二、实战

通过MediaPipe+MiDaS实现人脸单目测距

MediaPipe:是Google开发的适用于直播和流媒体的开源、跨平台、可定制的机器学习解决方案。code地址:https://github.com/google/mediapipe ,最新发布版本v0.10.11,license为Apache-2.0。MediaPipe Solutions提供了一套库和工具,供你在应用程序中快速应用人工智能(AI)和机器学习(ML)技术,包括:目标

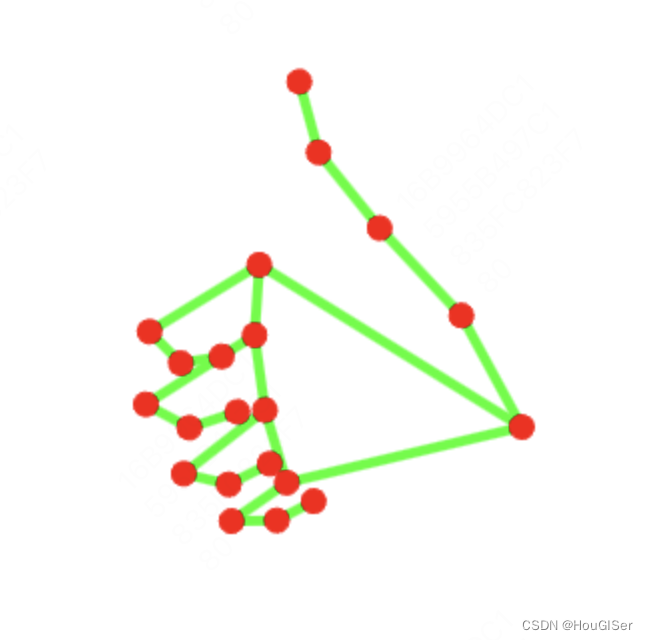

mediapipe人体姿态检测(全方位探索手部、面部识别、姿势识别与物体检测及自拍分割技术)

引言 本文将聚焦于MediaPipe对人体姿态检测的全面支持,包括手部、面部识别、全身姿势识别、物体检测以及自拍分割五大关键技术。通过深入了解这些功能,读者将能更好地运用MediaPipe在各种应用中实现精准的人体动作捕捉与分析。 一、手部关键点检测 MediaPipe的手部关键点检测模块(`mediapipe.solutions.hands`)能够实时识别和追踪双手的21个关键点,包括

mediapipe中 怎么更改 人脸检测中的 框体颜色?

我们 以 examples 的为 例子 android/src/java/com/google/mediapipe/apps/facedetectiongpu的 BUILD文件,描述了apk 生成的条件: 我们可以看到: 75 line android_binary( name = “facedetectiongpu”, manifest = “AndroidManifest.xml”, man

mediapipe中的人脸检测(java)代码初探

1.android代码,从创建activity说起. facedetectioncpu(我们暂时讲cpu版本) 下的MainActivity.java文件. a. 毫无疑问,我们来看看. protected void onCreate(Bundle savedInstanceState); 在创建activity的时候,做了些什么工作呢? super.onCreate(sa

编译mediapipe途中遇到不能下载的第三方包咋办?

1.在mediapipe这个框架中,引用了不少第三方库,例如opencv,protobuf, tf 甚至还有一些图形图像编解码库 这里就不一一举例了 2.在WORKSPACE 文件. mediapipe下载了 libyuv 开源库,具体位置大概在该文件的80-90 行 可能会因版本变迁,有所更改,正常. 而我的文章可能没来得及更新. # libyuv #http_archi

[python][whl]python模块mediapipe的whl文件下载地址汇总

[windows平台] mediapipe-0.10.8-cp38-cp38-win_amd64.whl下载地址: 点我下载该文件 mediapipe-0.10.8-cp39-cp39-win_amd64.whl下载地址: 点我下载该文件 mediapipe-0.10.8-cp310-cp310-win_amd64.whl下载地址: 点我下载该文件 mediapipe-0.10.

SignAll SDK:基于 MediaPipe 的手语接口现已开放

客座博文 / 由 SignAll 与 MediaPipe 团队联合完成。请注意,以下内容中的信息、用途及应用场景完全来自 SignAll 客座作者的观点。 SignAll SDK 当 Google 发布第一个基于 MediaPipe 的设备端手部追踪技术时,它便成为了开发者构建手语识别解决方案应用的基础。Google 之后对这个手部跟踪解决方案的进一步更新,将其准确率提升至其他技术所无法达到的

【手势识别】基于 MediaPipe 的手语接口调用

基于 MediaPipe 的手语接口调用 SignAll SDK:使用 MediaPipe 的手语接口现对开发者开放 当 Google 发布第一个基于 MediaPipe 的设备端手部追踪技术时,它便成为了开发者构建手语识别解决方案应用的基础。Google 之后对这个手部跟踪解决方案的进一步更新,将其准确率提升至其他技术所无法达到的水平(图 1)。

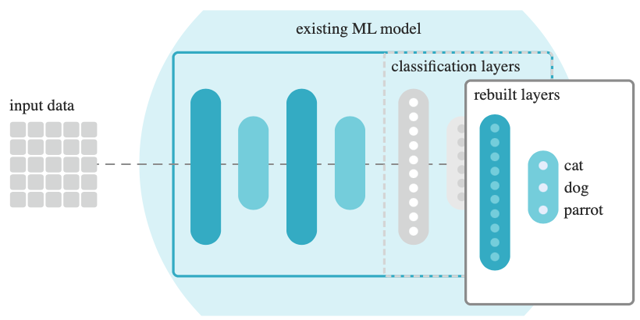

探索MediaPipe自定义机器学习模型

MediaPipe支持人脸识别、目标检测、图像分类、人像分割、手势识别、文本分类、语音分类。每个模块都有对应的模型,但是原有模型可能比较大、推理耗时比较长,我们可以自定义模型来进行进行优化。 目录 一、训练准备 1、准备数据 1.1 原始数据 1.2 标注数据 2、简化模型 2.1 减少标签 2.2 剪裁边缘 2.3 模型复用 3、训练迭代 二、目标检测训练 1、准备

[ Python+OpenCV+Mediapipe ] 实现对象识别

一、写在前面 本文所用例子为个人学习的小结,如有不足之处请各位多多海涵,欢迎小伙伴一起学习进步,如果想法可在评论区指出,我会尽快回复您,不胜感激! 所公布代码或截图均为运行成功后展示。 二、本文内容 使用OpenCV和Mediapipe提供的库,通过摄像头捕捉画面,调用mpp的模型识别库,识别对象的是什么,并标注可信度。 如

基于Mediapipe的姿势识别并同步到Unity人体模型中

如题,由于是商业项目,无法公开源码,这里主要说一下实现此功能的思路。 人体关节点识别 基于Mediapipe Unity插件进行开发,性能比较低的CPU主机,无法流畅地运行Mediapipe,这个要注意一下。 Mediapipe33个人体关节点图如下: Mediapipe关节点映射到Unity人体骨骼 这是开发此功能的一个难点,涉及到了关节点位置与骨骼位置的映射,还有骨骼反向运动。 1、使用un

Windows下如何运行mediapipe(极简版)

硬件准备:一个USB摄像头 必备库: 1.安装opencv-python库(win下安装opencv非常简单,此处不再赘述) 2.安装mediapipe库 pip install mediapipe 打开vscode,随便新建一个空的.py文件,将示例代码复制进去,这里以face_detection举例: 示例代码网址 :Face Detection | mediapipe (goog

![[python][whl]python模块mediapipe的whl文件下载地址汇总](/front/images/it_default.jpg)

![[ Python+OpenCV+Mediapipe ] 实现对象识别](https://img-blog.csdnimg.cn/direct/79f2f3c81f544bb1a1646cf73992f926.png)