llama3专题

从零开始使用 LangGraph、LLaMA3 和 Elasticsearch 向量存储构建本地代理的教程

作者:来自 Elastic Pratik Rana 在本教程中,我们将了解如何使用 LangGraph、LLaMA3 和 Elasticsearch Vector Store 从头开始创建可靠的代理。我们将结合 3 篇高级 RAG 论文中的想法: 用于路由的自适应 RAG:根据内容将问题引导到向量存储或网络搜索纠正性 RAG 回退机制:使用该机制,当问题与向量存储不相关时,我们将引入回

AI学习记录 - 解读llama3

持续更新 这是github大佬的llama3的代码,我继续加上属于我自己的理解 https://github.com/naklecha/llama3-from-scratch 如何token化 special_tokens :token 就是你对自然语言的字符的拆分颗粒度以及拆分方式,在我同类文章当中有所介绍,包括bep算法概略介绍也有。下面代码加载llama3的token,然后自己添加上属

LLama3本地部署安装

这篇教程将指导你如何在本机上安装 LLama3 客户端和可视化对话界面,我们会分为三部分:安装 LLama3 客户端、部署大模型和设置模型文件路径。 一、LLama3客户端安装 去 Ollama 官网下载 Ollama 客户端 Download Ollama on macOS 选择合适的操作系统平台后点击Download按钮等待下载完成即可。

LLama3技术报告笔记(系统)

1.6万块卡,700W TDP, 80GB显存;每台机器2块CPU+8块GPU,GPU之间NVLink互联; 通用分布式存储:240PB, 共7500个存储节点(30TB/节点), 全部是SSD;稳定吞吐量2TB/s,峰值吞吐量7TB/s (平均每个节点是1GB/s);Checkpointing写入是重点做的; 405B使用RoCE(RDMA over Converged Ethernet

最少钱学习并构建大模型ollama-llama3 8B

学习大模型时可能面临一些困难,这些困难可能包括: 计算资源限制:训练大模型通常需要大量的计算资源,包括CPU、GPU等。如果设备资源有限,可能会导致训练时间长、效率低下或无法完成训练。 内存限制:大模型通常需要大量内存来存储模型参数和计算中间结果。内存限制可能会导致内存不足错误或无法加载大模型。 数据集规模:训练大模型通常需要大规模的数据集来获得良好的性能。获取和处理大规模数据集可能需要大

【LLM大模型】本地玩转多模态Llama3

一般开源的LLM,例如Llama3和Qwen2等,只支持文本的输入,只能理解文本的内容,实现基于文本的逻辑推理和意图识别。 但是一些Chatbot,例如GPT-4V,就是拥有视觉能力,能够理解图片内容,能够更好的解决现实中的实际问题。 如何给开源大模型添加上视觉Vision?本篇文章助力大家在本地玩转多模态的Llama3。 理解LLaVA方案 给LLM装上电子眼: 添加上一个Imag

win10环境配置ollama-ui运行llama3模型

先说我的笔记本电脑配置intel-i7-11390h,4核8处理器,内存16G。显卡NVIDA GeFroce MX450,2G显存,这是一台5000元左右的电脑。 我用它跑roop、sd1.5、ffusion2、ChatTTs还有python+pytorch的自定义模型,现在用来跑llama3。当然,sd1.5和ffusion2这点显存,只能是基本体验。至于最近的Stable Diffus

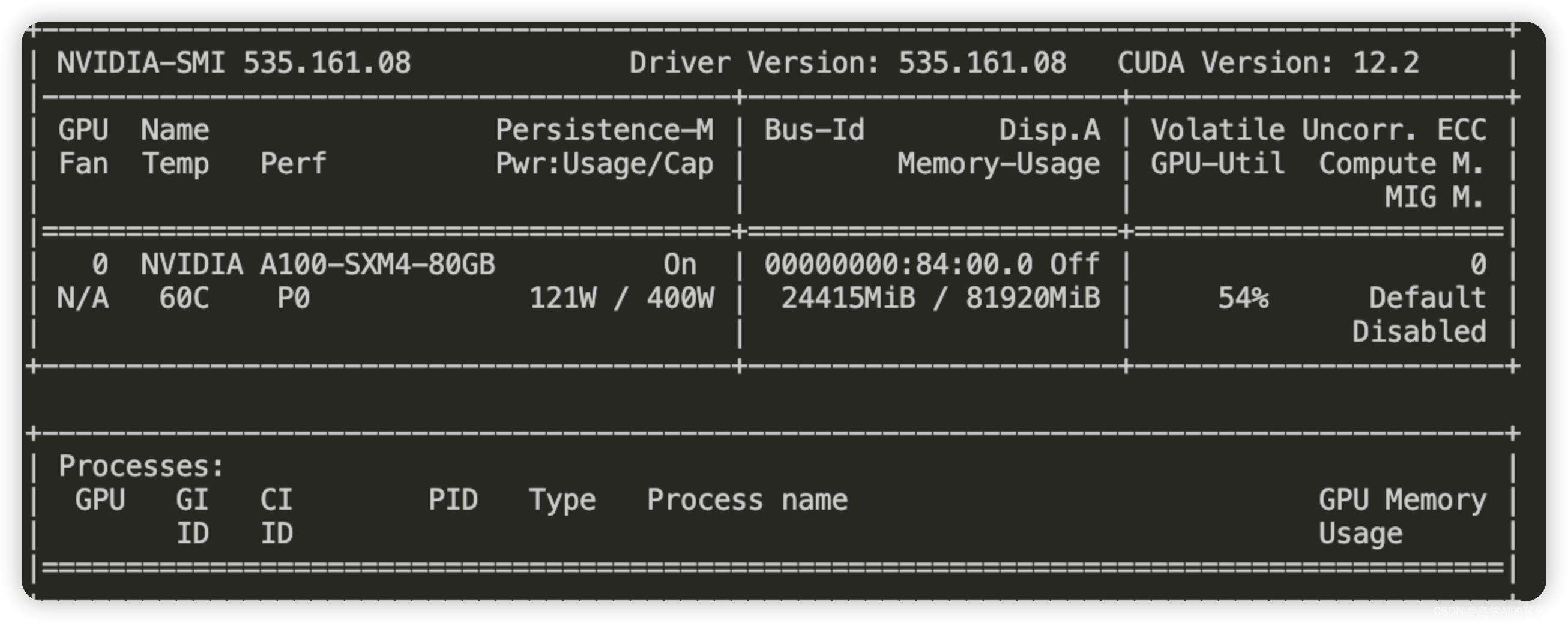

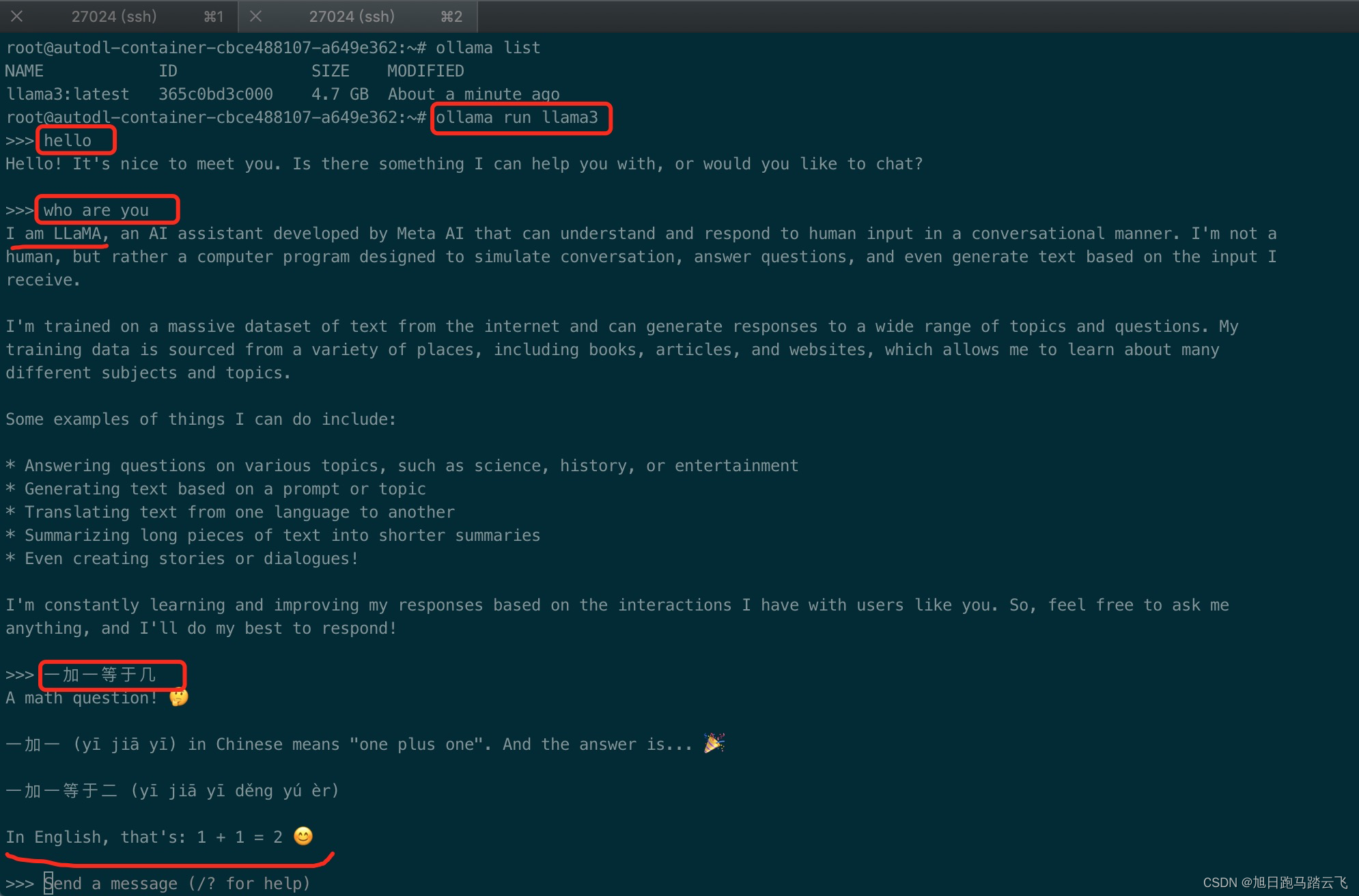

【AI基础】租用云GPU之autoDL部署大模型ollama+llama3

在这个显卡昂贵的年代,很多想要尝试一下AI的人可能都止步于第一步。这个时候我们可以租用在线的GPU资源来使用AI。autoDL就是这样的一个云平台。 一、创建服务器 1.1 注册账号 官网:https://www.autodl.com/ | 租GPU就上AutoDL 帮助文档:https://www.autodl.com/docs/ | AutoDL帮助文档 登录官网,注册账号。 1

[AI基础]租用云GPU之autoDL部署大模型ollama+llama3

在这个显卡昂贵的年代,很多想要尝试一下AI的人可能都止步于第一步。这个时候我们可以租用在线的GPU资源来使用AI。autoDL就是这样的一个云平台。 一、创建服务器 1.1 注册账号 官网:https://www.autodl.com/ | 租GPU就上AutoDL 帮助文档:https://www.autodl.com/docs/ | AutoDL帮助文档 登录官网,注册账号。 1

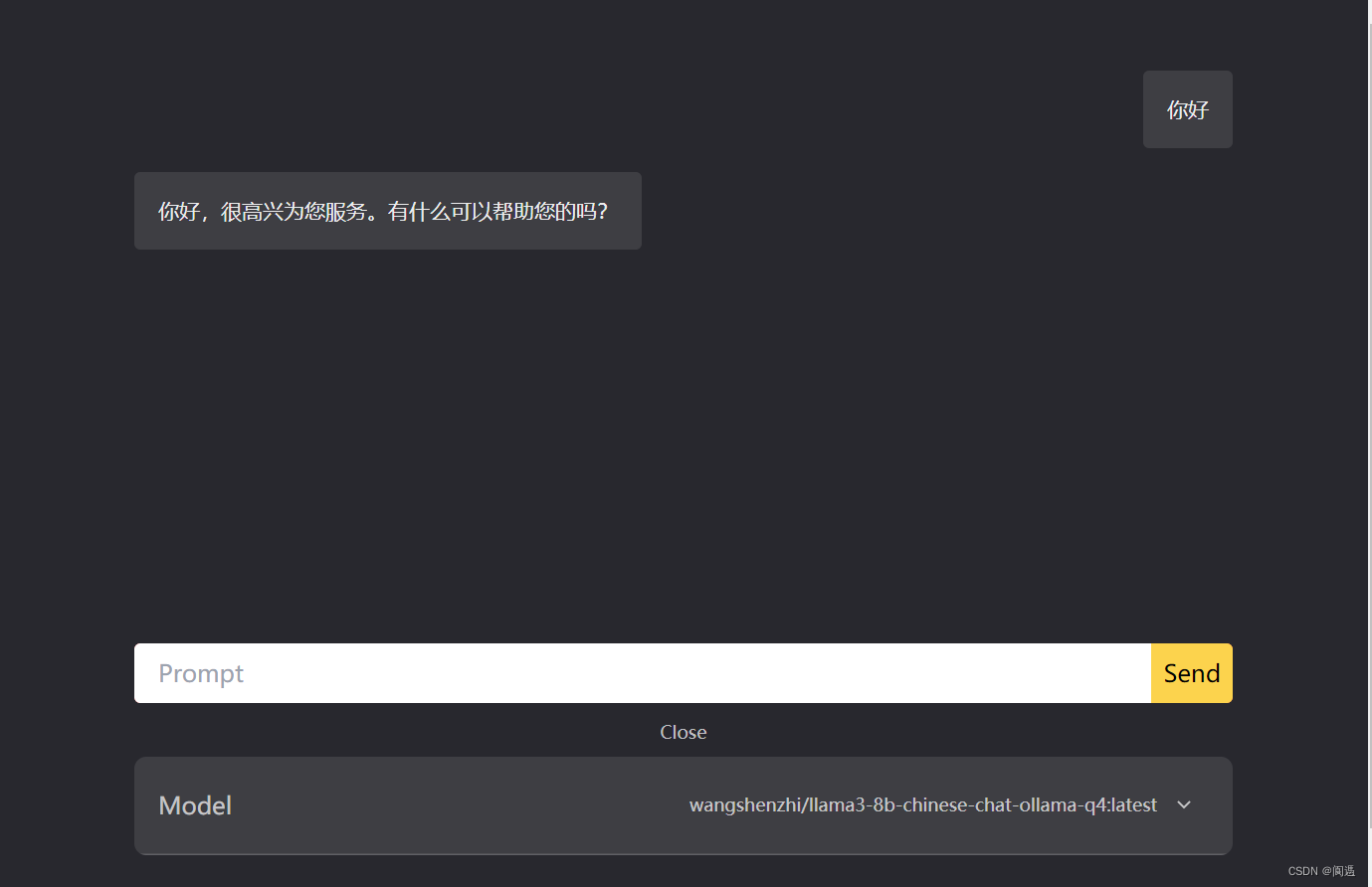

Llama3-8B-Chinese-Chat 聊天机器人

Llama3-8B-Chinese-Chat 聊天机器人 1. 创建虚拟环境2. 安装 pytorch3. 安装 transformers 和 gradio4. 开发 ui 代码5. 运行 ui 代码6. 访问 web ui 1. 创建虚拟环境 conda create -n llama3-chinese python=3.11 -yconda activate llama3-

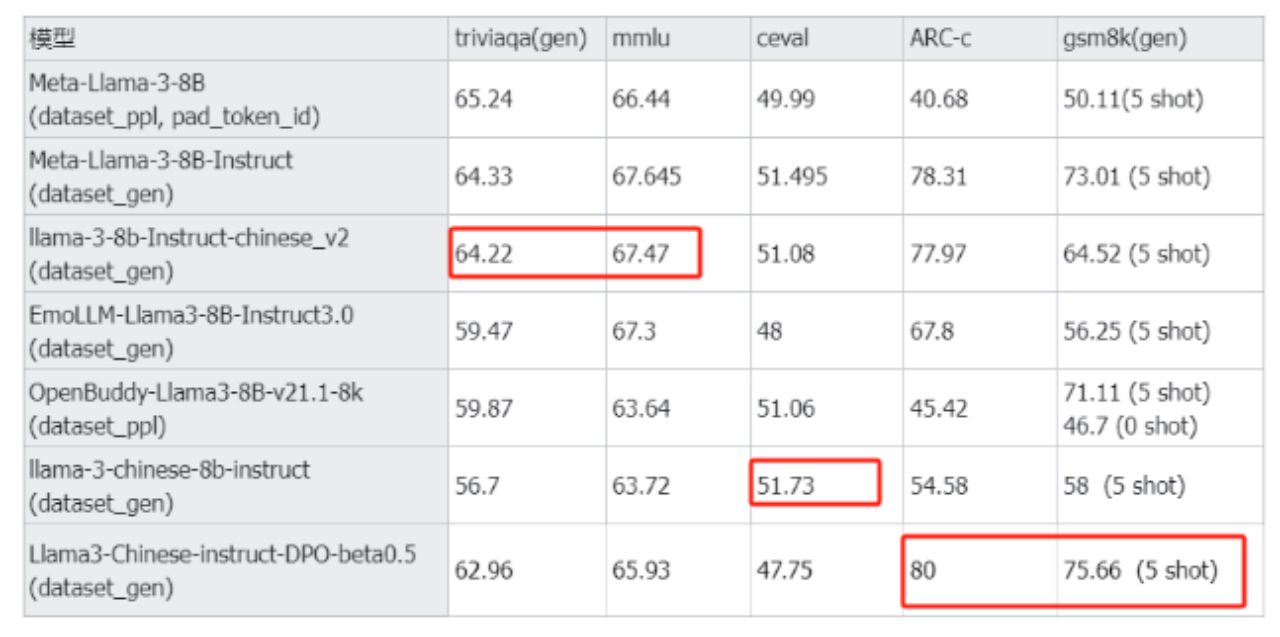

使用Unsloth微调Llama3-Chinese-8B-Instruct中文开源大模型

微调Llama3-Chinese-8B-Instruct 微调是指在大规模预训练的基础模型上,使用特定领域或任务数据集进行少量迭代训练,以调整模型参数,提升其在特定任务上的表现。这种方法可以充分利用预训练模型的广泛知识,同时针对特定应用进行优化,达到更精准高效的效果。 Llama-3-Chinese-8B-Instruct Llama-2已经表现的很出色了,但其仅使用了2万亿Toke

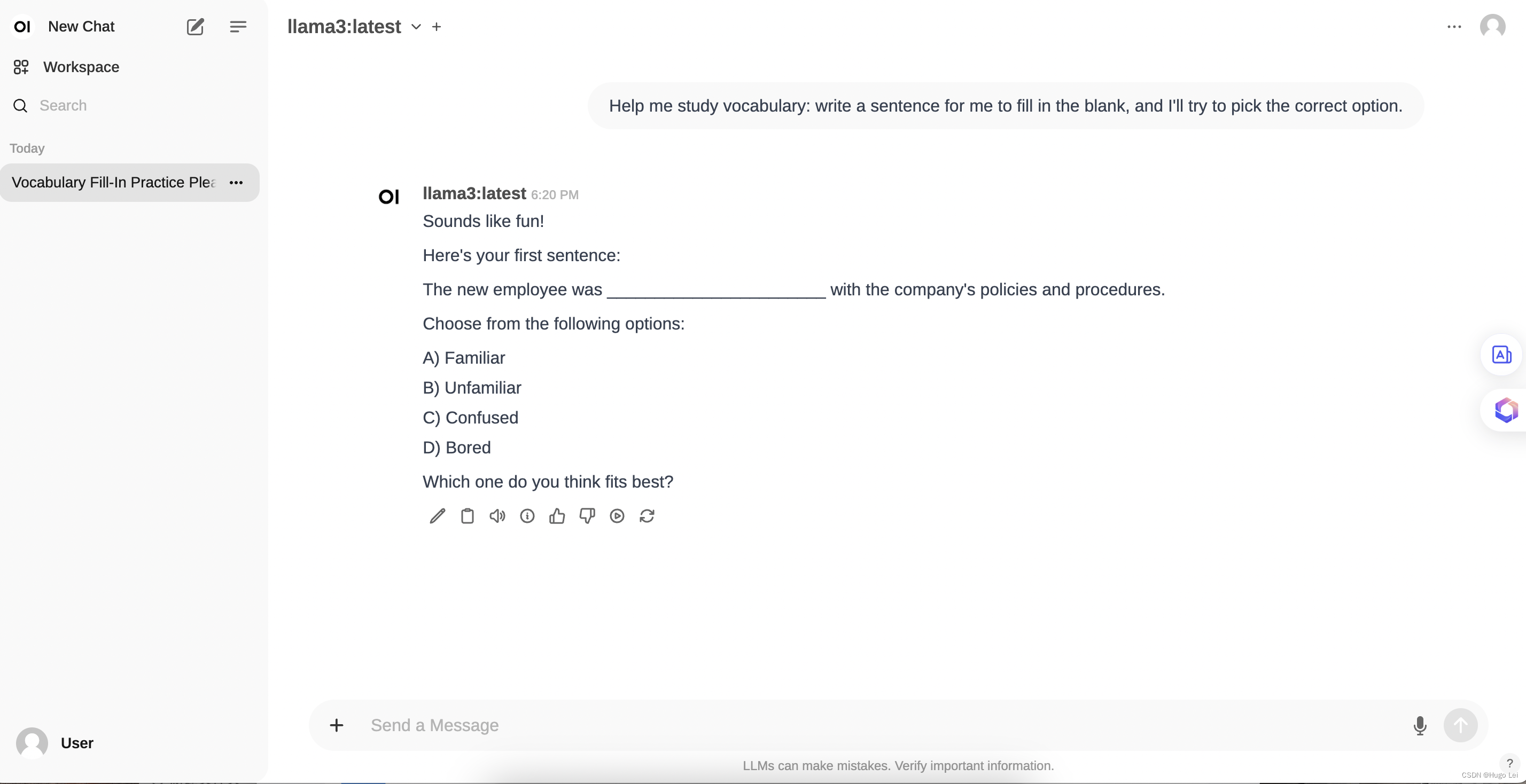

Ollama+Open WebUI本地部署Llama3 8b(附踩坑细节)

先展示一下最终结果,如下图所示: 1. 添加环境变量 在下载 ollama 之前,先去配置环境变量,确保模型下载到我们想要的地方 win10 和 win11 输入path或者环境变量: 增加系统环境变量 变量名不可更改,必须是OLLAMA_MODELS,变量值可以自定义, 2. 下载ollama 下载网址:Download Ollama on macOS 下

[大模型]LLaMA3-8B-Instruct Lora 微调

本节我们简要介绍如何基于 transformers、peft 等框架,对 LLaMA3-8B-Instruct 模型进行 Lora 微调。Lora 是一种高效微调方法,深入了解其原理可参见博客:知乎|深入浅出 Lora。 这个教程会在同目录下给大家提供一个 nodebook 文件,来让大家更好的学习。 环境准备 在 Autodl 平台中租赁一个 3090 等 24G 显存的显卡机器,如下图所

GLM-4开源版本终于发布!!性能超越Llama3,多模态媲美GPT-4V,MaaS平台全面升级

今天上午,在 AI 开放日上,备受关注的大模型公司智谱 AI 公布了一系列行业落地数据: 根据最新统计,智谱 AI 大模型开放平台目前已拥有 30 万注册用户,日均调用量达到 4000 亿 Tokens。GPT-4o深夜发布!Plus免费可用!https://www.zhihu.com/pin/1773645611381747712 没体验过OpenAI最新版GPT-4o?快戳最详细升级教程,几

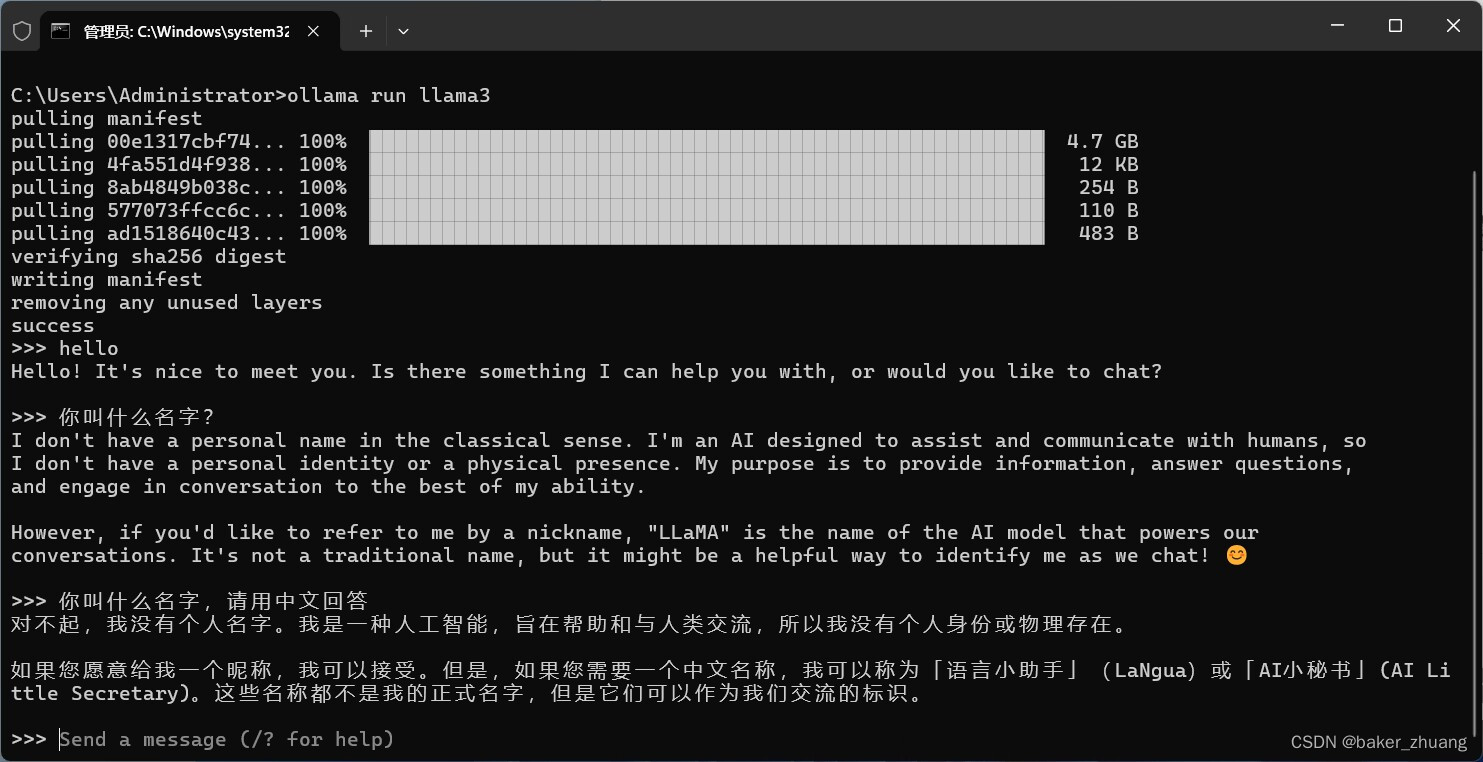

使用ollama分别在我的window、mac、小米手机上部署体验llama3-8b

1、ollama到底是个什么玩意 一句话来说, Ollama 是一个基于 Go 语言开发的简单易用的本地大模型运行框架。可以将其类比为 docker(有类似docker中的一些常规命令list,pull,push,run 等等),事实上确实也制定了类似 docker 的一种模型应用标准,在后边的内容中,你能更加真切体会到这一点。 在管理模型的同时,它还基于 Go 语言中的 Web 框架 gin

新手教程之使用LLaMa-Factory微调LLaMa3

文章目录 为什么要用LLaMa-Factory什么是LLaMa-FactoryLLaMa-Factory环境搭建微调LLaMA3参考博文 为什么要用LLaMa-Factory 如果你尝试过微调大模型,你就会知道,大模型的环境配置是非常繁琐的,需要安装大量的第三方库和依赖,甚至需要接入一些框架。 但是大模型微调的方法又是非常类似的,那有没有一种工具可以统一这些操作,让大模型微调变成

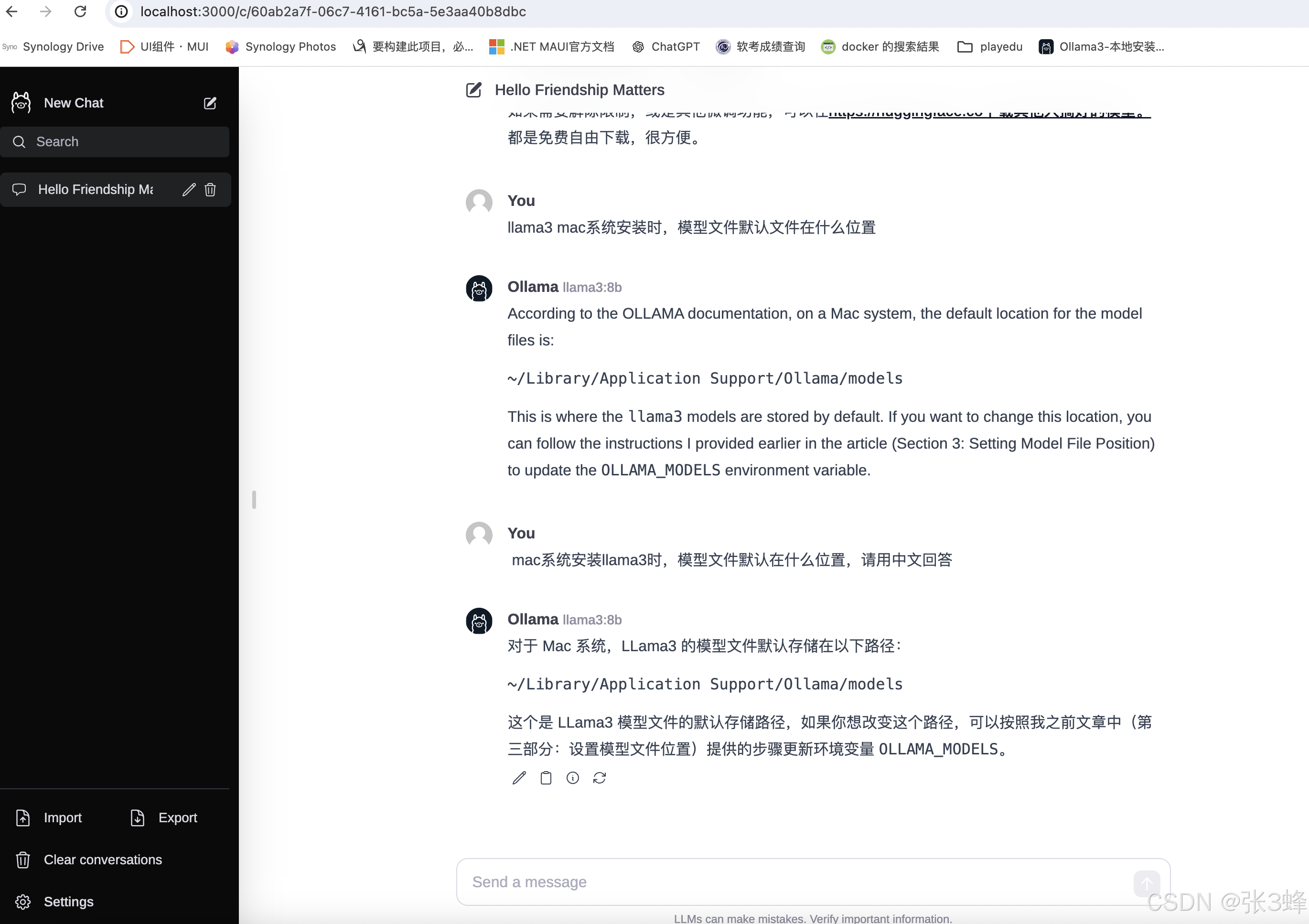

Llama(二):Open WebUI作为前端界面,使用本机的llama3

目录 背景 Open WebUI是什么 工程能力特性 产品功能特性 用户体验特性 Open WebUI安装并使用 背景 Mac M1芯片,16G 内存 llama3 8B的部署参考Llama(一):Mac M1芯片运行Llama3-CSDN博客在Mac M1 16G内存环境中,部署并使用Llama3 8Bhttps://blog.csdn.net/hugo_lei/art

【AIGC调研系列】LlamaFS-使用llama3操作文件夹

LlamaFS是一个基于Llama 3模型的自组织文件管理系统,旨在帮助用户自动重命名和组织电脑中的文件。它通过智能化的AI技术,能够根据文件内容和已知约定(例如时间)自动进行文件的重命名和分类整理[1][5][8]。 LlamaFS有两种运行模式:批量处理模式和监视模式。在批量处理模式下,用户可以一次性处理大量文件,避免了手动整理的繁琐[6][10]。而在监视模式下,LlamaFS作为守护进程

使用 Ollama框架 下载和使用 Llama3 AI大模型的完整指南

🏡作者主页:点击! 🤖AI大模型部署与应用专栏:点击! ⏰️创作时间:2024年5月24日20点59分 🀄️文章质量:96分 目录 💥Ollama介绍 主要特点 主要优点 应用场景 示例模型 📶Llama3 介绍 功能展示 Llama3 的应用 Llama3 的未来 🤖部署教程 1.下载Ollama 2.下载llama3的大模型

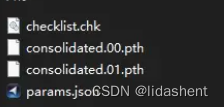

llama3-8b-instruct-262k微调过程的问题笔记(场景为llama论文审稿)

目录 一、环境配置 1.1、模型 1.2、微调环境 1.3、微调数据 二、发现的问题 2.1、过拟合问题 2.2、Qlora zero3 保存模型时OOM问题(已解决) 一、环境配置 1.1、模型 llama3-8b-instruct-262k (英文) 1.2、微调环境 Package Version-------------

在电脑本地运行llama3-8b模型

文章目录 流程我的案例api调用llama.cpp 流程 ollama支持可运行的模型,图片这里只是一部分而已,只需要下载下面的软件和模型文件,即可直接运行,而无需配置其他 模型文件下载地址 https://ollama.com/library 支持的部分模型,实际上更多,这里只是显示部分 登陆ollama官网 https://ollama.com/download 下载对

ollama离线部署llama3(window系统)

首先介绍下ollama是什么?Ollama是一个开源的大型语言模型服务工具,旨在为用户提供本地化的运行环境,满足个性化的需求。具体来说,Ollama是一个功能强大的开源框架,可以简化在Docker容器中部署和管理大型语言模型(LLM)的过程,使得用户能够快速地在本地计算机上运行大型语言模型,如Llama 2等。此外,Ollama还提供了类似OpenAI的API接口和聊天界面,方

Llama3中文聊天项目全能资源库

Llama3 中文聊天项目综合资源库,集合了与Lama3 模型相关的各种中文资料,包括微调版本、有趣的权重、训练、推理、评测和部署的教程视频与文档。1. 多版本支持与创新:该仓库提供了多个版本的Lama3 模型,包括基于不同技术和偏好的微调版本,如直接中文SFT版、Instruct偏好强化学习版、趣味版等。此外,还有Phi3模型中文资料仓库的链接,和性能超越了8b版本的Llama3。2. 部署与使

6.99元租H800,部署Llama3,羊毛速来薅!

猛然间,大模型圈掀起一股“降价风潮”。 前脚,智谱、DeepSeek等大模型厂商将API价格一降再降,输入100万tokens仅需1元。 紧接着,GPU租赁的价格也被打了下来。 现在潞晨云官方进行限时大额算力补贴,NVIDIA H800的租用价格,低至6.99元/卡/时;NVIDIA A800为5.99元/卡/时,4090甚至低至1.39元/卡/时。 不只有租赁服务,平台上还支持快速简

llama3 发布!大语言模型新选择 | 开源日报 No.251

meta-llama/llama Stars: 53.0k License: NOASSERTION llama 是用于 Llama 模型推理的代码。 提供了预训练和微调的 Llama 语言模型,参数范围从 7B 到 70B。可以通过下载脚本获取模型权重和 tokenizer。支持在本地快速运行推理,并提供不同规格的模型并行值。 meta-llama/llama3 Stars: 17

举办《Llama3关键技术深度解析与构建Responsible AI、算法及开发落地实战》线上高级研修讲座

举办《Llama3关键技术深度解析与构建Responsible AI、算法及开发落地实战》线上高级研修讲座

![[大模型]LLaMA3-8B-Instruct Lora 微调](https://img-blog.csdnimg.cn/direct/1620bcdf480942acb22a90f9350e16fb.png#pic_center)