continual专题

【论文笔记】基于预训练模型的持续学习(Continual Learning)(增量学习,Incremental Learning)

论文链接:Continual Learning with Pre-Trained Models: A Survey 代码链接:Github: LAMDA-PILOT 持续学习(Continual Learning, CL)旨在使模型在学习新知识的同时能够保留原来的知识信息了,然而现实任务中,模型并不能很好地保留原始信息,这也就是常说的灾害性遗忘(Catastrophic forgetting)

Codeforces Round 929 (Div. 3) D. Turtle Tenacity: Continual Mods(数学,贪心)

给定数组 a 1 , a 2 , … , a n a_1,a_2,…,a_n a1,a2,…,an ,判断是否有可能将其元素重排为 b 1 , b 2 , … , b n b_1,b_2,…,b_n b1,b2,…,bn ,从而得到 b 1 b_1 b1 m o d mod mod b 2 b_2 b2 m o d mod mod … m o d mod mod b

IJCAI23 - Continual Learning Tutorial

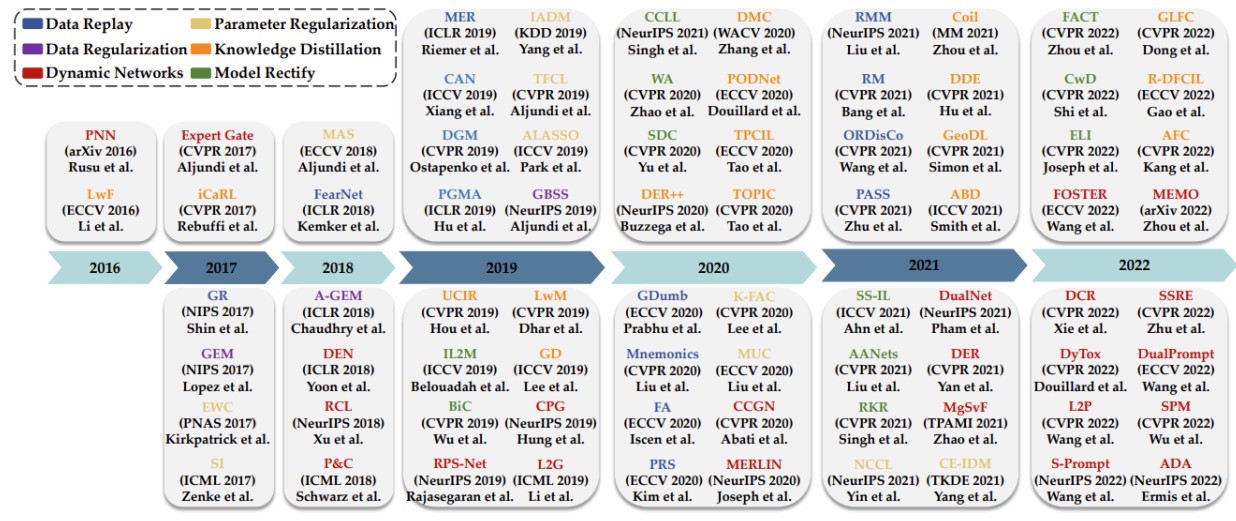

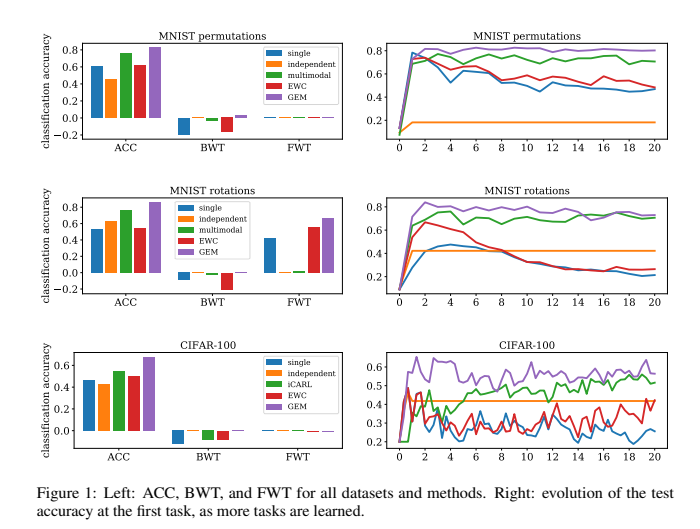

前言 如果你对这篇文章感兴趣,可以点击「【访客必读 - 指引页】一文囊括主页内所有高质量博客」,查看完整博客分类与对应链接。 本篇 Tutorial 主要介绍了 CL 中的一些基本概念以及一些过往的方法。 Problem Definition Continual Learning 和 Incremental learning 以及 Lifelong learning 属于同一概念, 其

【持续学习系列(九)】《Continual Learning with Pre-Trained Models: A Survey》

一、论文信息 1 标题 Continual Learning with Pre-Trained Models: A Survey 2 作者 Da-Wei Zhou, Hai-Long Sun, Jingyi Ning, Han-Jia Ye, De-Chuan Zhan 3 研究机构 National Key Laboratory for Novel Software Technolo

【博士每天一篇论文-算法】Continual Learning Through Synaptic Intelligence,SI算法

阅读时间:2023-11-23 1 介绍 年份:2017 作者:Friedemann Zenke,巴塞尔大学弗里德里希·米歇尔研究所(FMI) Ben Poole,谷歌 DeepMind 研究科学家 期刊: International conference on machine learning. PMLR 引用量:2309 这篇论文介绍了受生物神经网络启发的智能突触,用于解决人工神经网络(

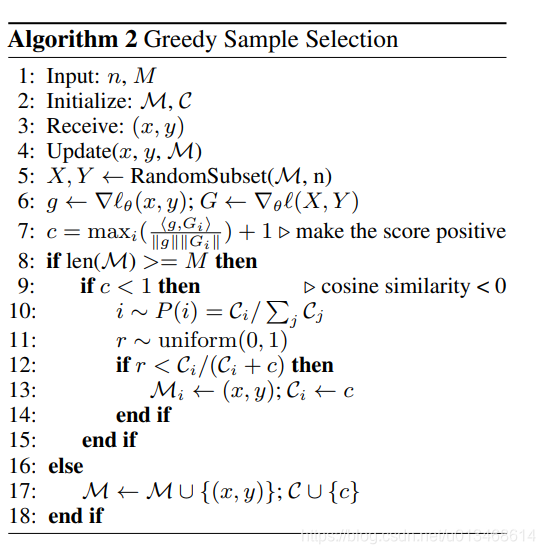

PRN(20210425):Gradient based sample selection for online continual learning

智能体需要具备不断适应环境的能力,这就使得其必须能够利用当前与环境或其他智能体交互的样本进行在线、增量式学习的能力。深度神经网络被广泛用于作为学习的模型,应用于这样的增量式学习任务时存在灾难性遗忘问题。缓解该问题的一种方法是:利用一个类似于DQN的经验回放单元存储重要的历史样本用来回忆(rehearsal)历史知识,使模型克服(目前还做不到“克服”,个人觉得用“缓解”更合适)灾难性遗忘问题。该方

连续学习(Continual Learning)或者增量学习的场景中,multiband和replay分别是什么?起到什么作用

multiband和replay是两种不同的训练策略,通常用在处理连续学习或者增量学习的场景中。这些策略旨在解决新知识学习导致旧知识遗忘的问题,即所谓的灾难性遗忘。以下是multiband和replay两种策略的基本区别: Multiband: 定义: multiband通常是指一种训练过程,其中模型被设计为可以同时学习和保持对多个任务或数据集的知识(同时学习新旧知识)。这种方法的目标是在整个

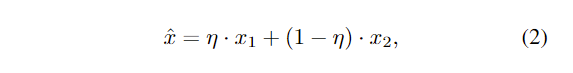

Multi-Modal Meta Continual Learning

⊙ \odot ⊙denotes the modulation operator,Cont. is the continuum data 辅助信息 作者未提供代码

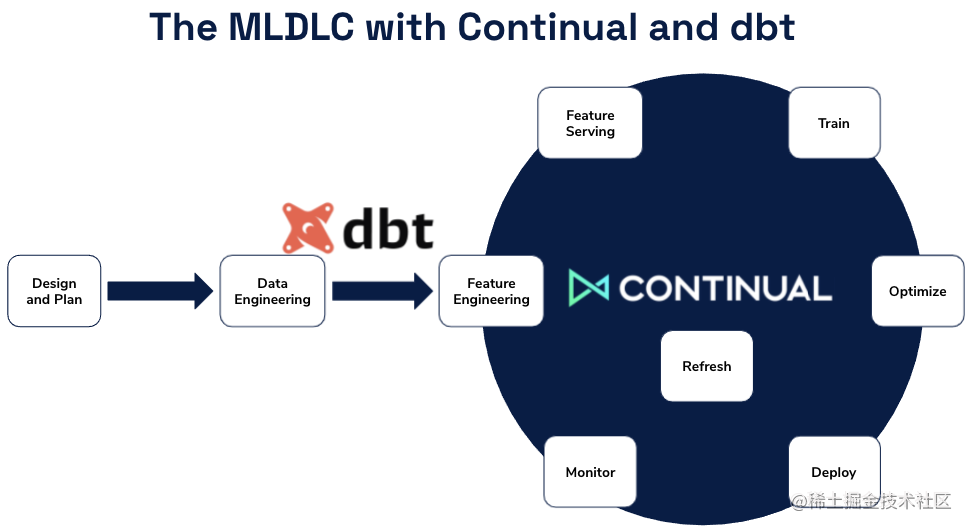

数据优先的人工智能会是下一个颠覆性的大事件吗?(Continual)

现代机器学习 (ML) 平台的起步已经大约有十年的时间了,这一平台的灵感主要来自数据科学家不断增长的基于Python的开源技术生态系统。现在是让我们来回顾已经取得的进展,同时突出企业在现有 ML 平台上存在的主要问题,并讨论下一代平台会是什么样子的好时机。正如我们将要讨论的,我们相信 ML 平台市场的下一个颠覆将是数据优先的 AI 平台的增长。 ML 解决方案的基本组件 曾经有一段时间,构建机

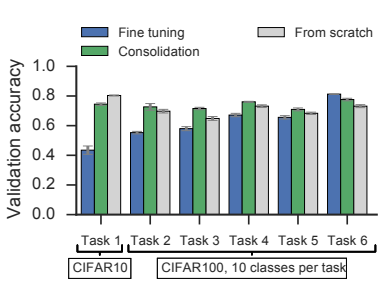

Compacting, Picking and Growing for Unforgetting Continual Learning 论文及代码流程解读

文章目录 论文翻译Abstract1 Introduction方法设计的动机Method Overview 2 Related Work3 The CPG approach for Continual Lifelong Learning 实验1复现1.baseline:VGG162.CPG_cifar100_scratch_mul_1.5.shTask1finetune modegradua

【博士每天一篇文献-算法】Gradient Episodic Memory for Continual Learning

阅读时间:2023-10-26 1 介绍 年份:2017 作者:David Lopez-Paz, Marc’Aurelio Ranzato 期刊:Part of Advances in Neural Information Processing Systems 30 (NIPS 2017) 引用量:2044 针对持续学习中灾难性遗忘问题提出一种名为Gradient Episodic Memor

Representation Compensation Networks for Continual Semantic Segmentation

Representation Compensation Networks for Continual Semantic Segmentation Abstract1. Introduction2. Related Work3. Method3.1. Preliminaries3.2. Representation Compensation Networks3.3. Pooled Cube K

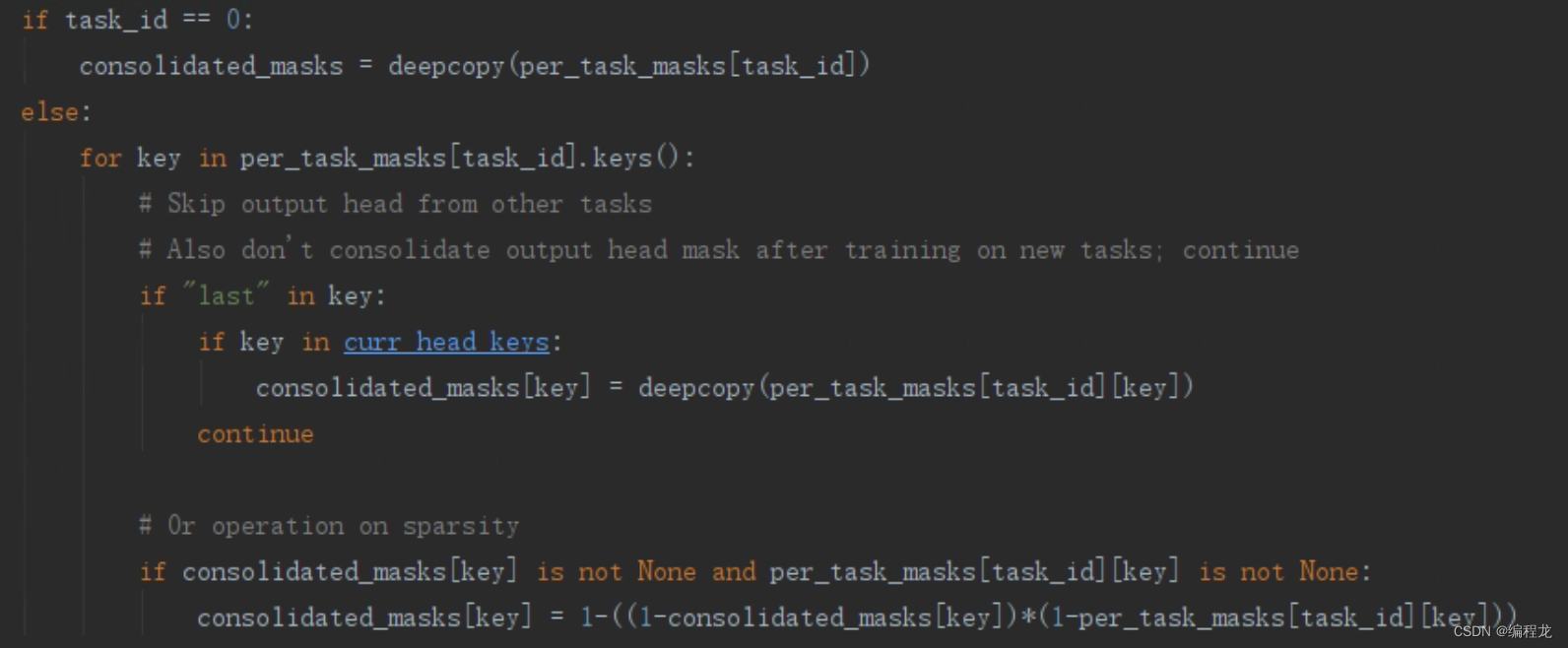

Forget-free Continual Learning with Winning Subnetworks论文阅读+代码解析

本篇文章是来自ICML2022上的一篇,而且是由之前出名的FedWEIT的团队进行研究的,因此这篇文章中也存在着相似的影子,论文地址点这里。 一. 背景(简要介绍) 持续学习又被称为增量式学习,要求不断地接受数据样本并且不会产生灾难性遗忘。最广泛的3种类型为:基于正则化的持续学习,基于记忆重塑的持续学习以及基于动态架构的持续学习。然而,上述的方法都会造成新的内存压力,特别是对于记忆重塑和动态架

ConPET: Continual Parameter-Efficient Tuning for Large Language Models

本文是LLM系列文章,针对《ConPET: Continual Parameter-Efficient Tuning for Large Language Models》的翻译。 ConPET:大型语言模型的连续参数高效调优 摘要1 引言2 相关工作3 提出的方法4 实验5 结论与未来工作 摘要 持续学习需要不断调整模型以适应新出现的任务,同时尽量减少对旧任务的灾难性遗忘。由于高

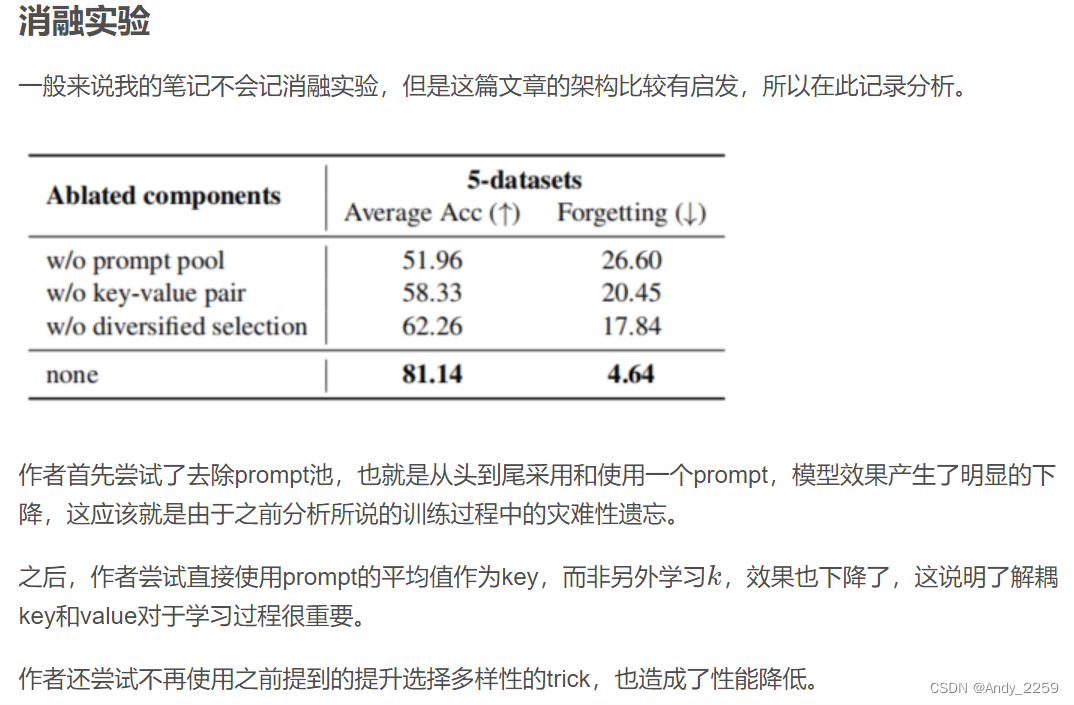

Learning to Prompt for Continual Learning 翻译

Learning to Prompt for Continual Learning (CVPR2022) 持续学习的学习激励 目录 传送门Abstract 摘要1. Introduction 引言2. Related Work 相关工作3Prerequisites 预备知识3.1. Continual learning protocols 连续学习的定义3.2 Prompt-based l