chatchat专题

Langchain-Chatchat本地部署的解决方案

大家好,我是herosunly。985院校硕士毕业,现担任算法研究员一职,热衷于大模型算法的研究与应用。曾担任百度千帆大模型比赛、BPAA算法大赛评委,编写微软OpenAI考试认证指导手册。曾获得阿里云天池比赛第一名,CCF比赛第二名,科大讯飞比赛第三名。授权多项发明专利。对机器学习和深度学习拥有自己独到的见解。曾经辅导过若干个非计算机专业的学生进入到算法行业就业。希望和大家一起成长进步。

基于LangChain-Chatchat实现的RAG-本地知识库的问答应用[5]-高阶实战微调

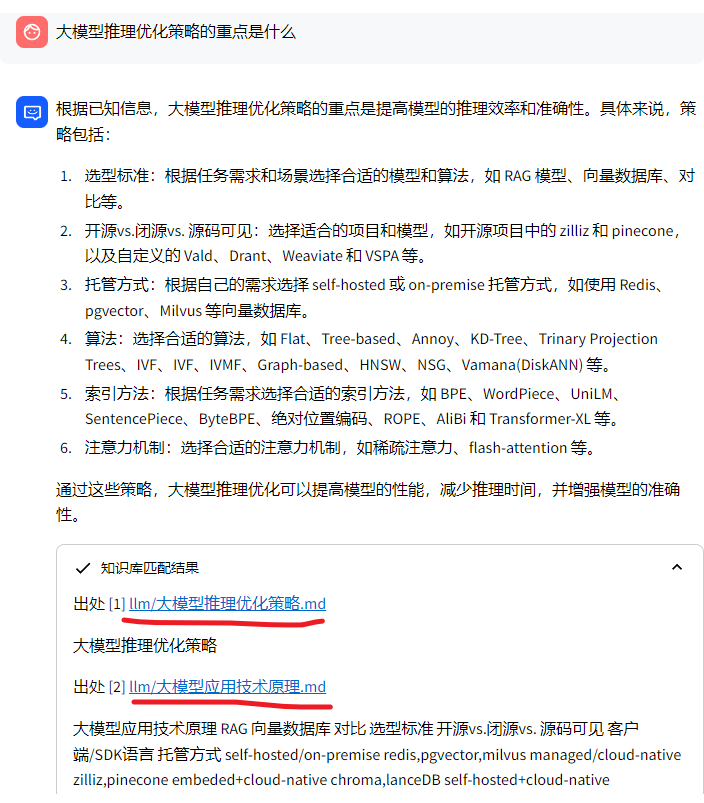

基于LangChain-Chatchat实现的RAG-本地知识库的问答应用[5]-高阶实战微调 1.推荐的模型组合 在默认的配置文件中,我们提供了以下模型组合 LLM: Chatglm2-6bEmbedding Models: m3e-baseTextSplitter: ChineseRecursiveTextSplitterKb_dataset: faiss 我们推荐开发者根

python-Langchain-Chatchat+ChatGLM2-6B在16G内存电脑上运行

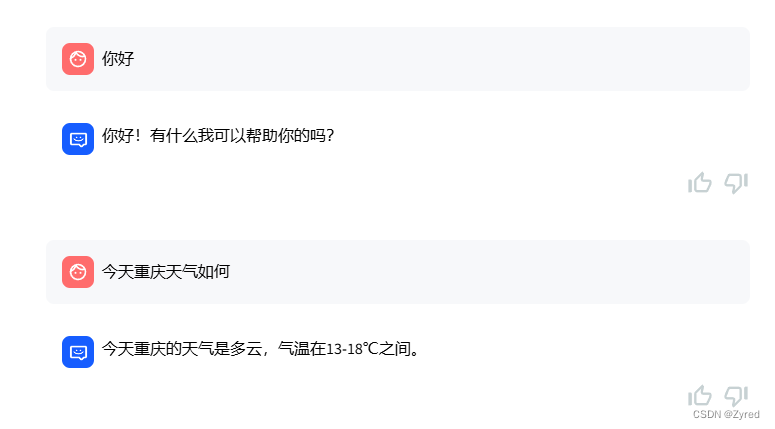

python-Langchain-Chatchat+ChatGLM2-6B在16G内存电脑上运行 代码链接ChatGLMLangchain-Chatchat 环境准备模型下载Langchain-Chatchat配置configs中example文件修改configs/model_config.py修改修改 server配置 知识库初始化参考链接 代码链接 ChatGLM ht

基于LangChain-Chatchat实现的RAG-本地知识库的问答应用[4]-高阶自定义模块

基于LangChain-Chatchat实现的RAG-本地知识库的问答应用[4]-高阶自定义模块 1.自定义分词器 在text_splitter文件夹下新建一个文件,文件名为您的分词器名字,比如my_splitter.py,然后在__init__.py中导入您的分词器,如下所示: from .my_splitter import MySplitter 修改config/kb_conf

基于LangChain-Chatchat实现的RAG-本地知识库的问答应用[2]-简洁部署版

基于LangChain-Chatchat实现的RAG-本地知识库的问答应用[2]-简洁部署版 1.环境要求 1.1 软件要求 要顺利运行本代码,请按照以下系统要求进行配置 已经测试过的系统 Linux Ubuntu 22.04.5 kernel version 6.7 其他系统可能出现系统兼容性问题。 最低要求 该要求仅针对标准模式,轻量模式使用在线模型,不需要安装 torc

基于LangChain-Chatchat实现的RAG-本地知识库的问答应用[1]-最新版快速实践并部署(检索增强生成RAG大模型)

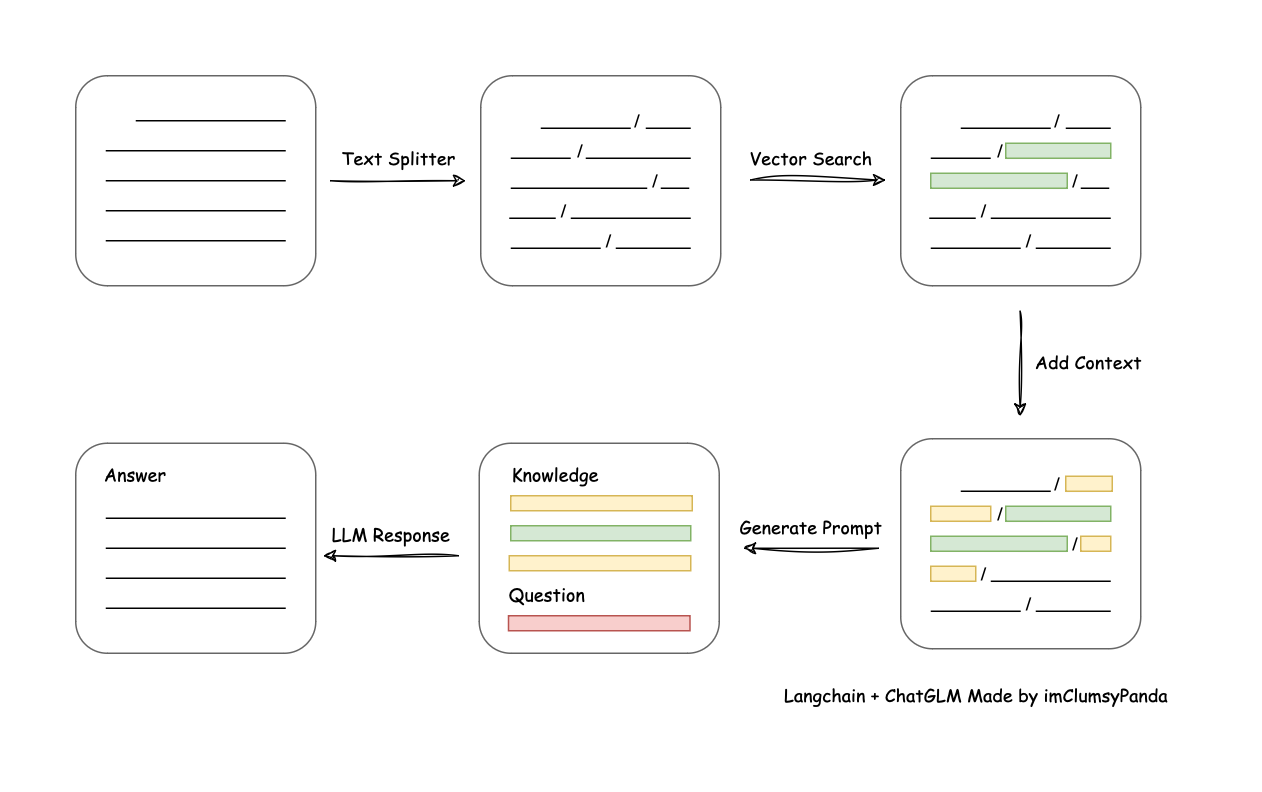

基于LangChain-Chatchat实现的RAG-本地知识库的问答应用[1]-最新版快速实践并部署(检索增强生成RAG大模型) 基于 ChatGLM 等大语言模型与 Langchain 等应用框架实现,开源、可离线部署的检索增强生成(RAG)大模型知识库项目。 1.介绍 一种利用 langchain思想实现的基于本地知识库的问答应用,目标期望建立一套对中文场景与开源模型支持友好、可

基于LangChain-Chatchat实现的本地知识库的问答应用-快速上手(检索增强生成(RAG)大模型)

基于LangChain-Chatchat实现的本地知识库的问答应用-快速上手(检索增强生成(RAG)大模型) 基于 ChatGLM 等大语言模型与 Langchain 等应用框架实现,开源、可离线部署的检索增强生成(RAG)大模型知识库项目。 1.介绍 一种利用 langchain思想实现的基于本地知识库的问答应用,目标期望建立一套对中文场景与开源模型支持友好、可离线运行的知识库问答解决

大模型 - Langchain-Chatchat小白本地部署踩坑血泪史

环境介绍 windows 11python 3.9.9显卡 GTX970 4G显存 (可怜巴巴)内存 24G 一、下载 Langchain-Chatchat 注意:这里先不要执行依赖下载,如果项目是通过 PyCharm 打开,就不要着急下载依赖,跟着往下面走,因为 pip 安装默认不走虚拟环境,如果所有的 python 项目都使用同一个依赖目录,会导致其他项目版本依赖出现问题,这是 pip

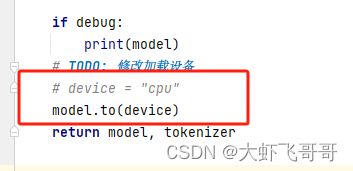

Langchain-Chatchat修改加载显卡

NLP - LLM - Langchain-Chatchat修改加载显卡 一、Langchain-Chatchat存在问题二、 Langchain-Chatchat加载显卡配置1. 模型加载的位置2. 函数中提供模型加载GPU的配置,但是不生效 三、 修改Langchain-Chatchat加载显卡配置1. 第一步修改(create_model_worker_app函数中 args.devi

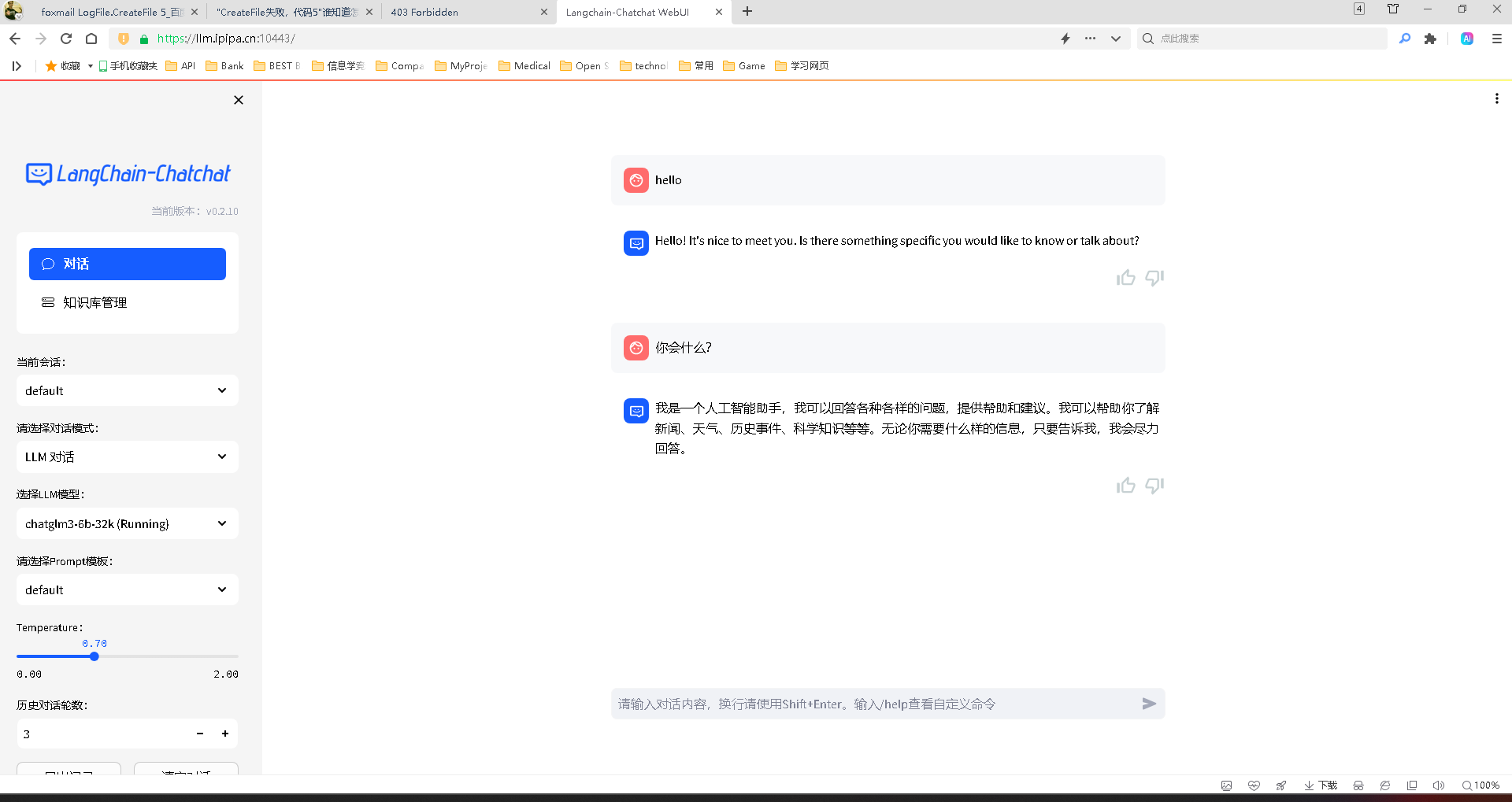

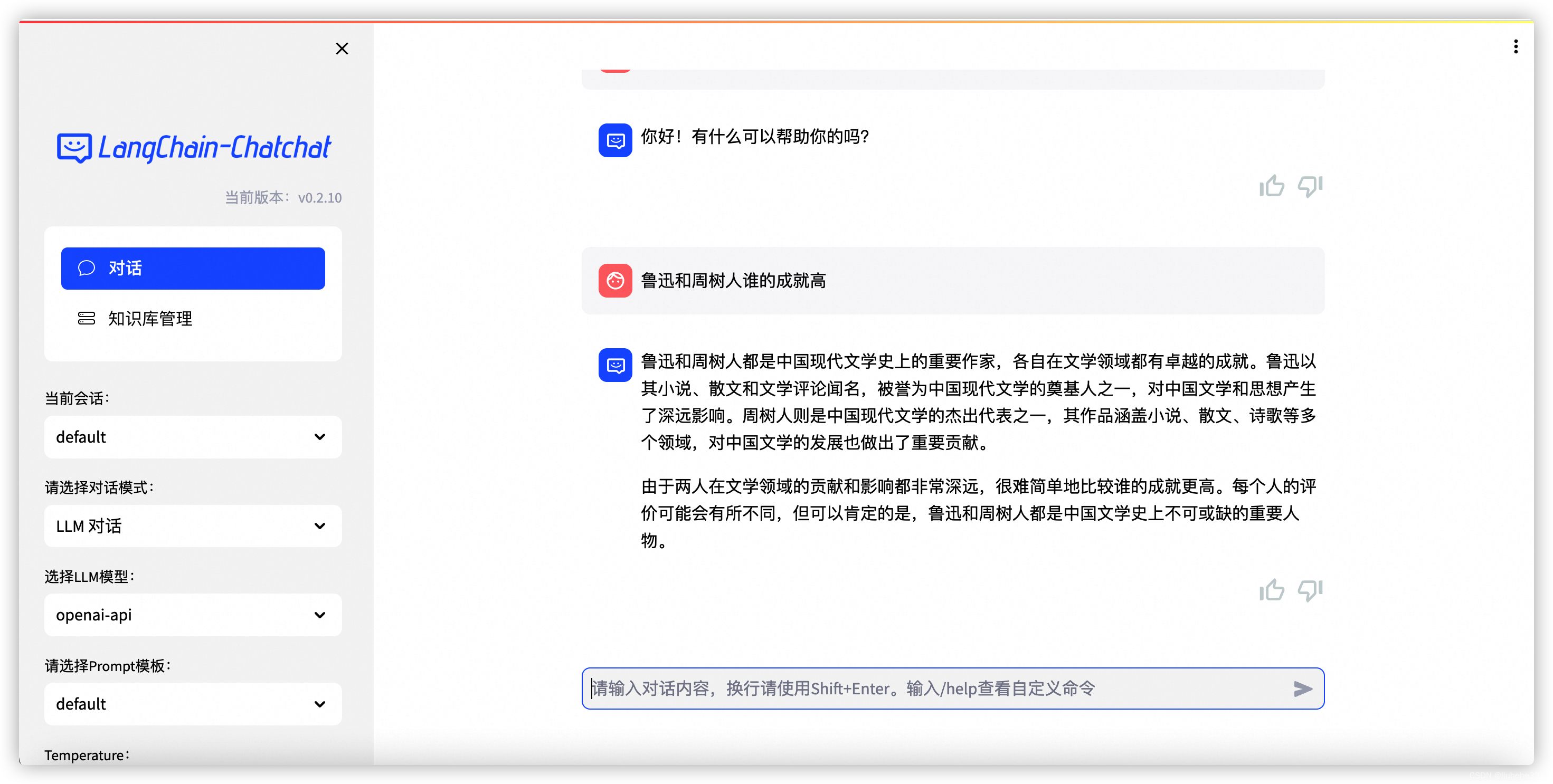

待会删!26.7 Star!LangChain-Chatchat 开源知识库来了

▼最近直播超级多,预约保你有收获 LangChain-Chatchat 是基于 ChatGLM 等大语言模型与 LangChain 等应用框架实现,开源、可离线部署的 RAG 检索增强生成大模型知识库项目。最新版本为 v0.2.10,目前已收获 26.7k Stars,非常不错的一个开源知识库项目。 项目地址:https://github.com/chatchat-space/Langcha

[大模型]Langchain-Chatchat安装和使用

项目地址: https://github.com/chatchat-space/Langchain-Chatchat 快速上手 1. 环境配置 首先,确保你的机器安装了 Python 3.8 - 3.11 (我们强烈推荐使用 Python3.11)。 $ python --versionPython 3.11.7 接着,创建一个虚拟环境,并在虚拟环境内安装项目的依赖 #

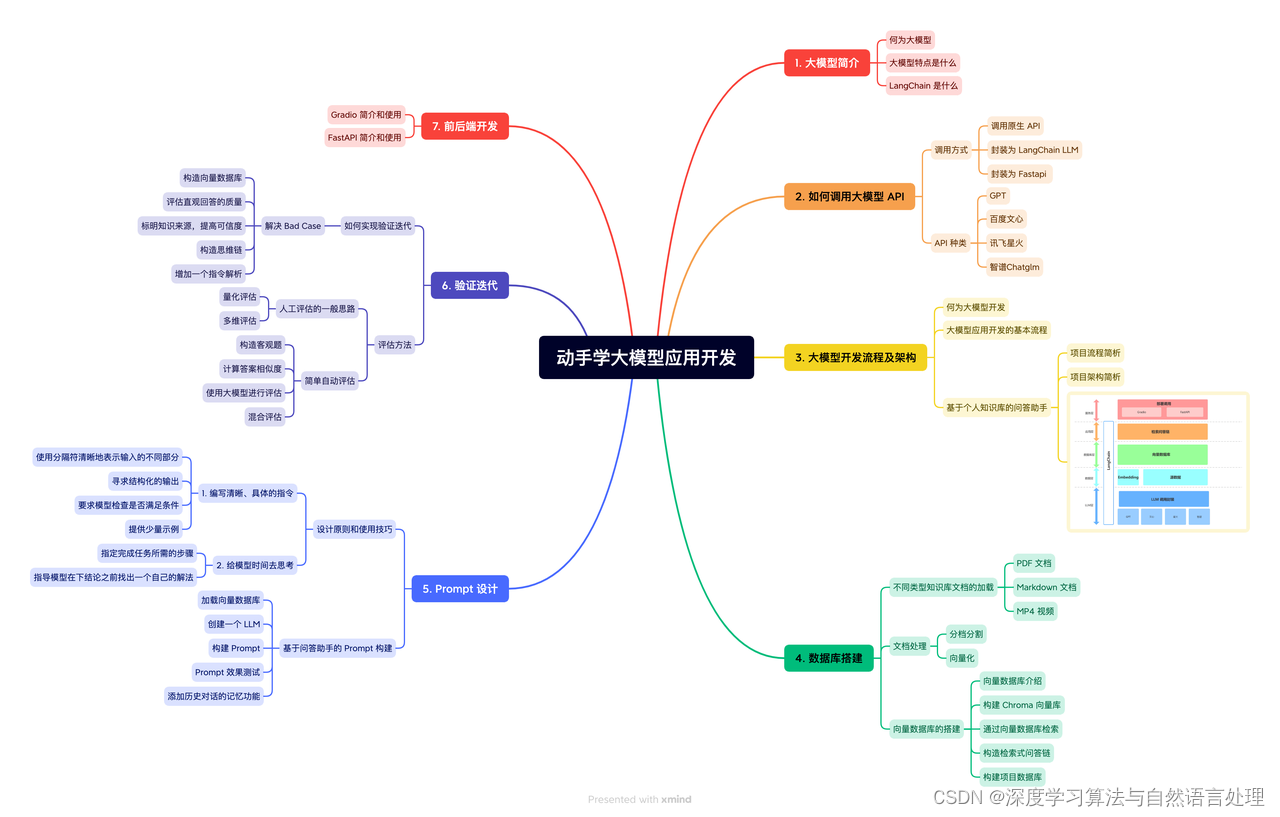

Langchain-Chatchat 从入门到精通(基于本地知识库的问答系统)(更新中)

目录 前言一、Langchain-Chatchat介绍1-1、Langchain-Chatchat介绍1-2、LangChain+ChatGLM 工作流1-3、文档角度的工作流 二、快速上手2-0、硬件要求2-1、环境配置2-2、模型下载2-3、初始化知识库和配置文件2-4、一键启动 三、配置文件详解(config目录下)3-1、basic_config3-2、kb_config3-3、mo

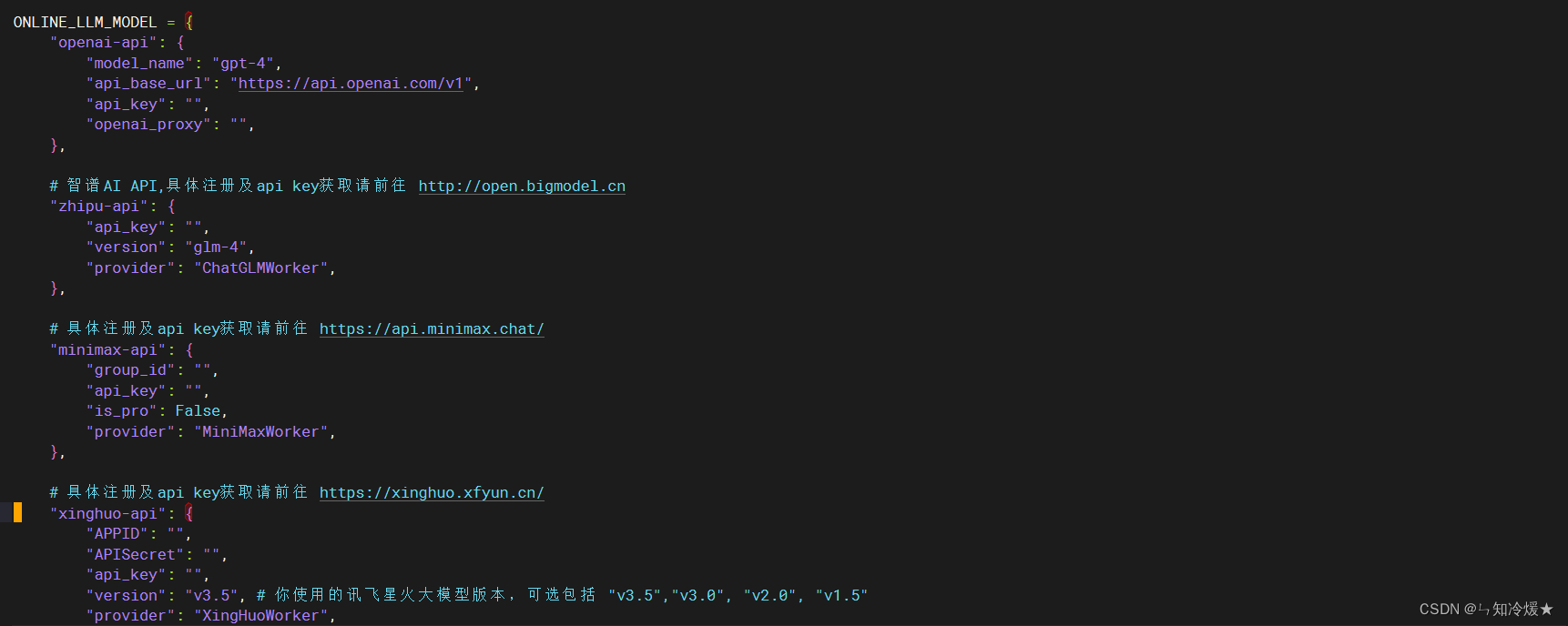

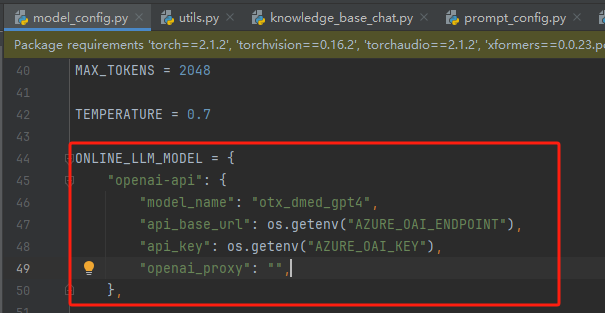

langchain-chatchat加载Azure Open AI

1.找到knowledge_base_chat.py文件中的get_ChatOpenAI函数 2.按crtl进入get_ChatOpenAI函数位置 3.注释原先的get_ChatOpenAI函数,修改成以下内容: def get_ChatOpenAI(model_name: str,temperature: float,streaming: bool = True,callbacks: L

【Langchain-Chatchat】部署ChatGLM3-6B-32K教程

介绍 Langchain-Chatchat这个框架可以帮助我们更容易的部署大语言模型,之前也写过ChatGLM传统的部署教程,有兴趣的可以参考 【ChatGLM3】第三代大语言模型多GPU部署指南【ChatGLM2-6B】从0到1部署GPU版本 借助Langchain-Chatchat框架,可以用更少的配置,帮我们做了大量的细节,并且还支持知识库和Agent等功能,下面将介绍如何使用dock

LangChain-Chatchat

文章目录 关于 LangChain-Chatchat特性说明实现原理文档处理流程技术路线图(截止0.2.10) 使用 关于 LangChain-Chatchat Langchain-Chatchat(原Langchain-ChatGLM)基于 Langchain 与 ChatGLM 等语言模型的本地知识库问答。 github : https://github.co

备忘: 踩坑linux环境部署轻量化的Langchain-Chatchat集成通义千问

看了许多材料,为了利用大模型构建以对话方式驱动的本地应用程序需要使用LangChain-chatchat,其基本介绍参考Langchain-Chatchat项目 通过查询资料,查到win上安装流程使用免费的通义千问 api 最轻量化部署Langchain-Chatchat,原以为在信创Linux系统上非常简单,但实践下来一堆坑,记录备忘吧… 需要解决几个问题 1 什么是轻量化部署 我理解是就是

Langchain-Chatchat本地搭建ChatGLM3模型和提取PDF内容

文章目录 1、软件要求2、安装CUDA2.1、安装gcc2.2、安装CUDA 3、安装Anaconda33.1、下载Anaconda33.2、创建python虚拟环境 4、部署系统4.1、下载源码4.2、安装依赖4.3、下载模型4.4、初始化配置和知识库4.4.1、初始化配置4.4.2、初始化知识库 4.5、运行4.6、运行4.6.1、启动4.6.2、启动创建知识库和上传pdf4.6.3、问

Langchain-Chatchat部署总结

项目地址: https://github.com/chatchat-space/Langchain-Chatchat 整体安装比较方便,在阿里云购买云主机,购买的国外站点机器, 该项目运行最佳坏境为 Linux Ubuntu 22.04.5Python 版本 == 3.11.7CUDA 版本: == 12.1torch==2.1.2 使用最轻量级部署方案 成功打开webUI界面

chatchat部署在ubuntu上的坑

1. 安装前要开代理,注意要下载很多东西,流量大 https://gitee.com/zhaodezan/chatchat 2. 不必要的步骤 下载模型需要先安装 Git LFS ,然后运行 $ git lfs install$ git clone https://huggingface.co/THUDM/chatglm3-6b$ git clone https://huggingfa

基于 Langchain-Chatchat,我搭建了一个本地知识库问答系统

文章目录 一、LangChain-Chatchat二、搭建步骤2.1 环境配置2.2 模型下载2.3 初始化知识库和配置文件2.4 一键启动2.5 启动界面示例 技术交流群用通俗易懂方式讲解系列 一、LangChain-Chatchat 基于 ChatGLM 等大语言模型与 Langchain 等应用框架实现,开源、可离线部署的检索增强生成(RAG)大模型知识库项目。

【langchain】实战笔记-Langchain-Chatchat win10本地部署FAQ(持续更新)

在发布了《 Langchain-Chatchat-win10本地安装部署成功笔记(CPU)》后,有不少同学给我私信,说根据我的文档安装成功,也有不少人在安装过程报错了,我的文章是基于V0.2.6版本写的,大部分都是因为升级版本引起的。当前最新版本是V0.2.10,经过验证V0.2.9按照原来的文章或官网的安装部署文档说明进行私有化安装部署都会出现一些问题,建议用V0.2.10版本。

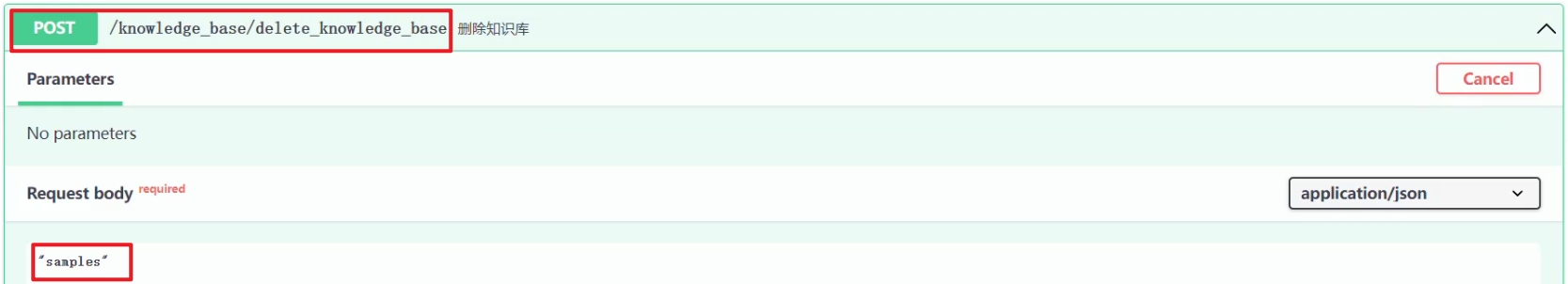

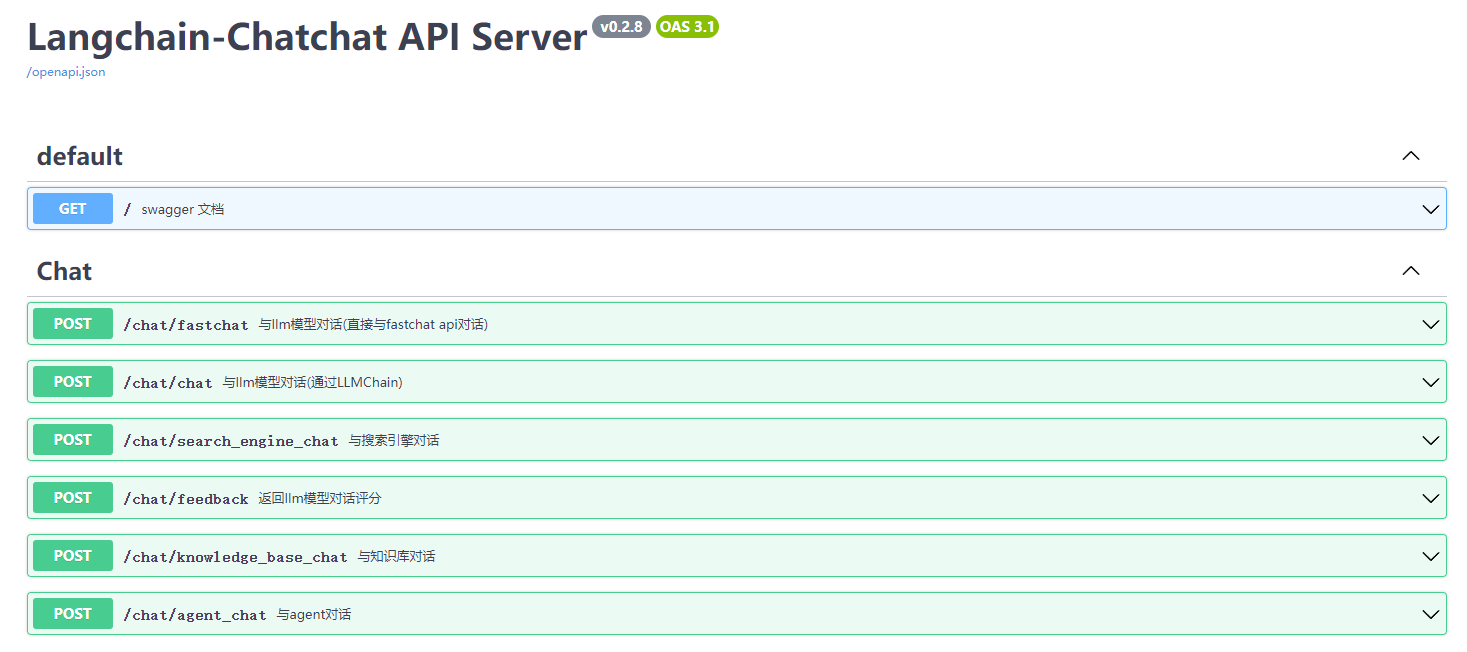

梳理Langchain-Chatchat知识库API接口

一.Langchain-Chatchat 知识库管理 1.Langchain-Chatchat 对话和知识库管理界面 Langchain-Chatchat v0.28 完整的界面截图,如下所示: 2.知识库中源文件和向量库 知识库 test 中源文件和向量库的位置,如下所示: 3.知识库表结构 knowledge_base 数据表内容,如下所示: 二.知识库操

Langchain-Chatchat开源库使用的随笔记(一)

笔者最近在研究Langchain-Chatchat,所以本篇作为随笔记进行记录。 最近核心探索的是知识库的使用,其中关于文档如何进行分块的详细,可以参考笔者的另几篇文章: 大模型RAG 场景、数据、应用难点与解决(四)RAG 分块Chunk技术优劣、技巧、方法汇总(五) 原项目地址: Langchain-ChatchatWIKI教程(有点简单) 1 Chatchat项目结构 整个

离线知识库服务(Langchain-Chatchat)本地搭建

基于模型的离线知识库的应用,这样的应用服务目前正在遍地开花,选择一个好的模型应用服务是能把大模型的能力充分利用的(Langchain-Chatchat)。 如果基础环境没有布置好可以参考我上篇文章《Ubuntu 22.04 Tesla V100s显卡驱动,CUDA,cuDNN,MiniCONDA3 环境的安装》。 Langchain-Chatchat 基于 ChatGLM 等大语言模型与 L

【AI】使用阿里云免费服务器搭建Langchain-Chatchat本地知识库

书接上文,由于家境贫寒的原因,导致我本地的GPU资源无法满足搭建Langchain-Chatchat本地知识库的需求,具体可以看一下这篇文章,于是我只能另辟蹊径,考虑一下能不能白嫖一下云服务器资源,于是去找网上找,您还别说,还真有,具体的领取方法可以查看我的这篇文章:【AI】阿里云免费GPU服务资源领取方法。 1.准备工作 1.1进入云服务器 服务器资源准备好之后就可以去做我们的开发任务了,

大模型工具_Langchain-Chatchat

https://github.com/chatchat-space/Langchain-Chatchat 原Langchain-ChatGLM 1 功能 整体功能,想解决什么问题 基于 Langchain 与 ChatGLM 等LLM模型,搭建一套针对中文场景与开源模型,界面友好、可离线运行的知识库问答解决方案。 当前解决了什么问题,哪些问题解决不了 目前 0.2.8 版本支持了多个本地模

![基于LangChain-Chatchat实现的RAG-本地知识库的问答应用[5]-高阶实战微调](https://img-blog.csdnimg.cn/direct/a47f9ec5714b4e7596d80f14902d8ebe.jpeg#pic_center)

![基于LangChain-Chatchat实现的RAG-本地知识库的问答应用[4]-高阶自定义模块](https://img-blog.csdnimg.cn/direct/a448ba3c083a4801867d6242244c24eb.jpeg#pic_center)

![基于LangChain-Chatchat实现的RAG-本地知识库的问答应用[2]-简洁部署版](https://img-blog.csdnimg.cn/direct/cf7349a2d47c4ed08a21e379600d6cb0.jpeg#pic_center)

![基于LangChain-Chatchat实现的RAG-本地知识库的问答应用[1]-最新版快速实践并部署(检索增强生成RAG大模型)](https://img-blog.csdnimg.cn/img_convert/6a7ae6d4174fcd3d55fee11dc029437c.png)

![[大模型]Langchain-Chatchat安装和使用](https://img-blog.csdnimg.cn/img_convert/85e9661b26c5b5bd6b425c6d4f3df1db.jpeg)