本文主要是介绍llama-factory SFT 系列教程 (四),lora sft 微调后,使用vllm加速推理,希望对大家解决编程问题提供一定的参考价值,需要的开发者们随着小编来一起学习吧!

文章目录

- 文章列表:

- 背景

- 简介

- llama-factory vllm API 部署

- 融合 lora 模型权重 vllm API 部署

- HuggingFace API 部署推理

- API 部署总结

- vllm 不使用 API 部署,直接推理

- 数据集 tenplate

- vllm 代码部署

文章列表:

- llama-factory SFT系列教程 (一),大模型 API 部署与使用

- llama-factory SFT系列教程 (二),大模型在自定义数据集 lora 训练与部署

- llama-factory SFT系列教程 (三),chatglm3-6B 命名实体识别实战

- llama-factory SFT 系列教程 (四),lora sft 微调后,使用vllm加速推理

背景

llama-factory 提供了 vllm API 部署,但笔者在测试时,发现部署的 vllm API 没有直接用vllm推理的速度快。

简介

首先使用 llama-factory 微调,得到微调后的 lora 权重;由于 vllm 并没有支持所有的模型;

故通用的方式是 将 lora 权重和大模型融合成新的大模型,再由 vllm 推理;

在使用 alpaca 样式的数据集微调时,llama-factory 框架在训练时,会自动在prompt 添加 template 。

所以,在微调大模型后,使用vllm推理时,也要给 vllm 传入 封装好的template 。

llama-factory vllm API 部署

融合 lora 模型权重 vllm API 部署

#!/bin/bash

# DO NOT use quantized model or quantization_bit when merging lora weightsCUDA_VISIBLE_DEVICES=0 python ../../src/export_model.py \--model_name_or_path ZhipuAI/chatglm3-6b \--adapter_name_or_path output \--template chatglm3 \--finetuning_type lora \--export_dir new_model \--export_size 2 \--export_legacy_format False

CUDA_VISIBLE_DEVICES=0 API_PORT=8000 python ../../src/api_demo.py \--model_name_or_path new_model \--template chatglm3 \--finetuning_type lora \--infer_backend vllm

首先要融合 lora 权重变成新的大模型保存到 new_model 文件夹下,vllm 推理时显存占用达到了20G 左右;

HuggingFace API 部署推理

CUDA_VISIBLE_DEVICES=0 API_PORT=8000 python ../../src/api_demo.py \--model_name_or_path ZhipuAI/chatglm3-6b \--adapter_name_or_path output/output_train/checkpoint-2250 \--template chatglm3 \--finetuning_type lora

如果不使用 vllm 推理,使用huggingface部署,显存占用只有 13G。

API 部署总结

笔者在测试时,发现使用 vllm API 部署 和 HuggingFace API 部署的推理速度都差不多,大概每秒处理 3.15 条数据;

vllm 不使用 API 部署,直接推理

如果上述 llama-factory API 部署,已经能够满足你的需求,无需继续往下阅读;

因为笔者有大量的文本需要大模型进行处理,故期望大模型能推理的更快一点;

笔者使用 vllm 直接推理的速度可以达到 每秒处理 15.96 条,相比之前 API 部署快了 5 倍,推理时间可以大幅缩短;

如下所示:推理40万条数据,耗时6小时57分钟。

Processed prompts: 100%|███████████████████████████████| 399997/399997

[6:57:49<00:00, 15.96it/s]

llama-factory 只提供了 API 形式的 vllm 推理,里面提供了vllm 推理的代码;

点击查看 LLaMA-Factory vllm_engine.py TODO: 读者可修改此处的代码

类似如下文章的实现:vllm 本地大模型加速推理

数据集 tenplate

lora 微调的数据集形式如下:

{"instruction": "你是专门进行企业分类的专家。请根据提供的企业相关信息:'{'企业名称(全称)': '自动化工程有限公司', '经营范围': '(省略...)'}',将企业划分到以下类别中,企业可能属于多个类别:['文化旅游', '人工智能', '深地深海深空', '空天信息', '电磁能']。请按照列表的格式回答。 ", "input": "", "output": "[\"人工智能\", \"高端装备和先进基础材料\"]"

}

使用 alpaca 数据集格式微调大模型时,会根据填入的模型和template,对数据集文本添加一些特殊字符,不同的大模型还都不一样。如果后续要使用大模型进行推理,也需要将文本调整成训练的时候一样。如果直接使用 LLaMA-Factory API 部署,无需考虑prompt里面的这些特殊字符, LLaMA-Factory 会自动封装完成。

既然咱们要自己使用 vllm 推理,prompt template 的封装就得咱们自己写;

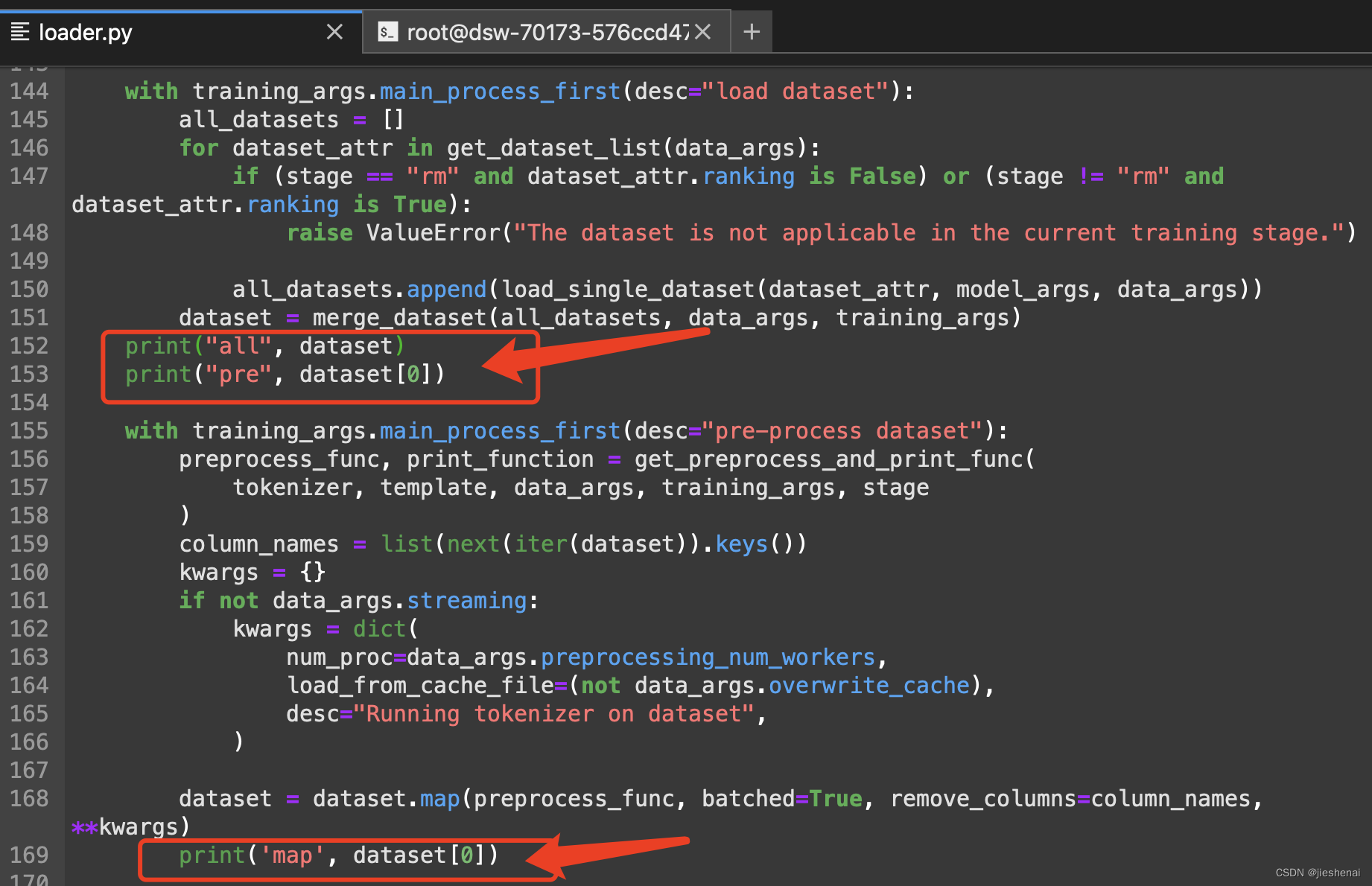

有一个简便方法,看到 LLaMA-Factory 给数据集封装的 template prompt 的样例。

如下图所示,修改该py文件的代码 https://github.com/hiyouga/LLaMA-Factory/blob/main/src/llmtuner/data/loader.py

把 dataset 的样子打印出来看看👀;

CUDA_VISIBLE_DEVICES=0 python ../../src/train_bash.py \

--stage sft \

--do_train \

--model_name_or_path ZhipuAI/chatglm3-6b \

--dataset_dir ../../data \

--dataset industry_class \

--template chatglm3 \

--finetuning_type lora \

--lora_target query_key_value \

--output_dir ./output_test/ \

--overwrite_cache \

--per_device_train_batch_size 1 \

--gradient_accumulation_steps 1 \

--lr_scheduler_type cosine \

--logging_steps 10 \

--save_strategy epoch \

--learning_rate 5e-5 \

--num_train_epochs 2.0 \

--plot_loss \

--fp16

训练的数据集样例打印结果如下所示:

onverting format of dataset: 100%|█████████████████| 2804/2804 [00:00<00:00, 84459.59 examples/s]

all Dataset({features: ['prompt', 'response', 'system', 'tools'],num_rows: 2804

})

pre {'prompt': [{'role': 'user', 'content': "你是专门进行企业分类的专家。请根据提供的企业相关信息:'{'企业名称(全称)': '【保密】有限公司', '经营范围': '一般项目:金属结构制造;金属结构销售;金属材料制造;金属材料销售;机械电气设备制造;机械电气设备销售;电子元器件与机电组件设备制造;通用设备修理;电气设备修理;电子、机械设备维护;金属切割及焊接设备制造;金属切割及焊接设备销售;船舶自动化、检测、监控系统制造;船用配套设备制造;工业自动控制系统装置制造;工业自动控制系统装置销售;工业机器人制造;工业机器人安装、维修;增材制造;增材制造装备制造;增材制造装备销售;智能机器人的研发;智能基础制造装备制造;智能基础制造装备销售;海洋工程装备制造;海洋工程装备销售;海上风电相关装备销售;人工智能基础软件开发;人工智能应用软件开发;技术服务、技术开发、技术咨询、技术交流、技术转让、技术推广;技术进出口;货物进出口;软件销售;软件开发;对外承包工程;工程管理服务;非居住房地产租赁;租赁服务', '所属行业': '金属制品、机械和设备修理业', '一级行业分类': '制造业', '二级行业分类': '金属制品、机械和设备修理业', '三级行业分类': '其他机械和设备修理业'}',将企业划分到以下类别中,企业可能属于多个类别:['文化旅游', '大健康和生物技术', '现代金融', '商贸物流', '绿色环保', '智能建造', '数字创意', '氢能', '高端装备和先进基础材料', '网络安全', '“光芯屏端网”新一代信息技术', '汽车制造和服务', '量子科技', '航空航天', '人工智能', '深地深海深空', '空天信息', '电磁能', '脑科学和类脑科学', '超级计算']。请按照列表的格式回答。 "}], 'response': [{'role': 'assistant', 'content': '["人工智能", "高端装备和先进基础材料"]'}], 'system': '', 'tools': ''}

Running tokenizer on dataset: 100%|██████████████████| 2804/2804 [00:02<00:00, 1112.92 examples/s]

map {'input_ids': [64790, 64792, 64795, 30910, 13, 30910, 34607, 33500, 31636, 31648, 33328, 54530, 32114, 31155, 55073, 31793, 35100, 31648, 45987, 29552, 30982, 30953, 31648, 33624, 31301, 54580, 55037, 31300, 5440, 765, 30952, 3337, 36244, 31713, 31301, 32841, 31300, 31830, 1589, 765, 32087, 32238, 5440, 765, 31873, 31671, 31211, 33948, 32126, 32273, 54659, 33948, 32126, 32172, 54659, 33948, 31976, 32273, 54659, 33948, 31976, 32172, 54659, 33024, 35989, 32077, 32273, 54659, 33024, 35989, 32077, 32172, 54659, 32157, 54751, 42052, 54619, 39984, 42708, 32077, 32273, 54659, 35753, 32077, 46991, 54659, 35989, 32077, 46991, 54659, 32157, 31201, 33024, 32077, 32487, 54659, 33948, 43314, 54643, 43964, 32077, 32273, 54659, 33948, 43314, 54643, 43964, 32077, 32172, 54659, 38331, 36244, 31201, 32348, 31201, 35189, 31739, 32273, 54659, 55745, 54571, 33818, 32077, 32273, 54659, 32068, 32679, 51868, 35343, 32273, 54659, 32068, 32679, 51868, 35343, 32172, 54659, 32068, 35200, 32273, 54659, 32068, 35200, 33441, 31201, 34888, 54659, 54866, 55179, 32273, 54659, 54866, 55179, 32273, 33610, 32273, 54659, 54866, 55179, 32273, 33610, 32172, 54659, 32093, 33290, 31664, 32569, 54659, 32093, 31811, 32273, 33610, 32273, 54659, 32093, 31811, 32273, 33610, 32172, 54659, 33187, 31713, 33610, 32273, 54659, 33187, 31713, 33610, 32172, 54659, 35688, 43228, 31724, 33610, 32172, 54659, 34797, 31811, 32602, 31936, 54659, 34797, 32002, 32602, 31936, 54659, 31668, 31645, 31201, 31668, 31936, 31201, 31668, 32539, 31201, 31668, 31964, 31201, 31668, 35928, 31201, 31668, 33129, 54659, 31668, 40321, 54659, 35980, 40321, 54659, 32602, 32172, 54659, 32602, 31936, 54659, 33522, 36231, 31713, 54659, 31713, 31641, 31645, 54659, 54836, 33269, 33934, 35741, 54659, 35741, 31645, 1589, 765, 37325, 31825, 5440, 765, 33948, 35390, 31201, 33024, 54542, 32077, 46991, 54569, 1589, 765, 34453, 31825, 33328, 5440, 765, 35626, 1589, 765, 35159, 31825, 33328, 5440, 765, 33948, 35390, 31201, 33024, 54542, 32077, 46991, 54569, 1589, 765, 37602, 31825, 33328, 5440, 765, 31722, 33024, 54542, 32077, 46991, 54569, 30953, 16963, 31123, 54687, 31648, 37982, 54555, 32040, 38724, 54538, 31123, 31648, 31667, 32180, 32858, 38724, 31211, 4005, 41908, 1589, 765, 54539, 31740, 54542, 53444, 1589, 765, 31999, 32021, 1589, 765, 40278, 33089, 1589, 765, 32658, 33242, 1589, 765, 32093, 34686, 1589, 765, 32224, 34357, 1589, 765, 53558, 1589, 765, 34052, 33610, 54542, 32519, 31811, 31976, 1589, 765, 39180, 1589, 765, 30989, 54853, 56508, 56033, 55396, 54766, 30991, 38157, 38078, 1589, 765, 32031, 32273, 37154, 1589, 765, 37962, 31748, 1589, 765, 45268, 1589, 765, 34797, 1589, 765, 54829, 54563, 51273, 54829, 54913, 1589, 765, 54913, 54614, 31707, 1589, 765, 43005, 54558, 1589, 765, 55514, 31760, 54542, 54931, 55514, 31760, 1589, 765, 34150, 32269, 4960, 31155, 55073, 32001, 39547, 54530, 36844, 33287, 31155, 30910, 64796, 30910, 13, 15404, 34797, 1252, 449, 34052, 33610, 54542, 32519, 31811, 31976, 5515, 2], 'attention_mask': [1, 1, 1, 1, 1, 1, 1, 1, 1, 1, 1, 1, 1, 1, 1, 1, 1, 1, 1, 1, 1, 1, 1, 1, 1, 1, 1, 1, 1, 1, 1, 1, 1, 1, 1, 1, 1, 1, 1, 1, 1, 1, 1, 1, 1, 1, 1, 1, 1, 1, 1, 1, 1, 1, 1, 1, 1, 1, 1, 1, 1, 1, 1, 1, 1, 1, 1, 1, 1, 1, 1, 1, 1, 1, 1, 1, 1, 1, 1, 1, 1, 1, 1, 1, 1, 1, 1, 1, 1, 1, 1, 1, 1, 1, 1, 1, 1, 1, 1, 1, 1, 1, 1, 1, 1, 1, 1, 1, 1, 1, 1, 1, 1, 1, 1, 1, 1, 1, 1, 1, 1, 1, 1, 1, 1, 1, 1, 1, 1, 1, 1, 1, 1, 1, 1, 1, 1, 1, 1, 1, 1, 1, 1, 1, 1, 1, 1, 1, 1, 1, 1, 1, 1, 1, 1, 1, 1, 1, 1, 1, 1, 1, 1, 1, 1, 1, 1, 1, 1, 1, 1, 1, 1, 1, 1, 1, 1, 1, 1, 1, 1, 1, 1, 1, 1, 1, 1, 1, 1, 1, 1, 1, 1, 1, 1, 1, 1, 1, 1, 1, 1, 1, 1, 1, 1, 1, 1, 1, 1, 1, 1, 1, 1, 1, 1, 1, 1, 1, 1, 1, 1, 1, 1, 1, 1, 1, 1, 1, 1, 1, 1, 1, 1, 1, 1, 1, 1, 1, 1, 1, 1, 1, 1, 1, 1, 1, 1, 1, 1, 1, 1, 1, 1, 1, 1, 1, 1, 1, 1, 1, 1, 1, 1, 1, 1, 1, 1, 1, 1, 1, 1, 1, 1, 1, 1, 1, 1, 1, 1, 1, 1, 1, 1, 1, 1, 1, 1, 1, 1, 1, 1, 1, 1, 1, 1, 1, 1, 1, 1, 1, 1, 1, 1, 1, 1, 1, 1, 1, 1, 1, 1, 1, 1, 1, 1, 1, 1, 1, 1, 1, 1, 1, 1, 1, 1, 1, 1, 1, 1, 1, 1, 1, 1, 1, 1, 1, 1, 1, 1, 1, 1, 1, 1, 1, 1, 1, 1, 1, 1, 1, 1, 1, 1, 1, 1, 1, 1, 1, 1, 1, 1, 1, 1, 1, 1, 1, 1, 1, 1, 1, 1, 1, 1, 1, 1, 1, 1, 1, 1, 1, 1, 1, 1, 1, 1, 1, 1, 1, 1, 1, 1, 1, 1, 1, 1, 1, 1, 1, 1, 1, 1, 1, 1, 1, 1, 1, 1, 1, 1, 1, 1, 1, 1, 1, 1, 1, 1, 1, 1, 1, 1, 1, 1, 1, 1, 1, 1, 1, 1, 1, 1, 1, 1, 1, 1, 1, 1, 1, 1], 'labels': [-100, -100, -100, -100, -100, -100, -100, -100, -100, -100, -100, -100, -100, -100, -100, -100, -100, -100, -100, -100, -100, -100, -100, -100, -100, -100, -100, -100, -100, -100, -100, -100, -100, -100, -100, -100, -100, -100, -100, -100, -100, -100, -100, -100, -100, -100, -100, -100, -100, -100, -100, -100, -100, -100, -100, -100, -100, -100, -100, -100, -100, ...

如上所示:

- 咱们提供的alpaca形式的数据集,会被 llama-factory 转成如下形式

{'prompt': [{'role': 'user', 'content': "你是专门进行企业分类的专家...请按照列表的格式回答。 "}], 'response': [{'role': 'assistant', 'content': '["人工智能", "高端装备和先进基础材料"]'}], 'system': '', 'tools': '' } - 训练的数据集样例

针对数据集编码;

'input_ids'

使用解码器,decode[64790, 64792, 64795, 30910, 13, 30910, 34607, 33500, 31636, 31648, 33328, 54530, 32114, 31155, 55073, 31793, 35100, 31648, 45987, 29552, 30982, 30953, 31648, 33624, 31301, 54580, 55037, 31300, 5440, 765, 30952, 3337, 36244, 31713, 31301, 32841, 31300, 31830, 1589, 765, 32087, 32238, 5440, 765, 31873, 31671, 31211, 33948, 32126, 32273, 54659, 33948, 32126, 32172, 54659, 33948, 31976, 32273, 54659, 33948, 31976, 32172, 54659, 33024, 35989, 32077, 32273, 54659, 33024, 35989, 32077, 32172, 54659, 32157, 54751, 42052, 54619, 39984, 42708, 32077, 32273, 54659, 35753, 32077, 46991, 54659, 35989, 32077, 46991, 54659, 32157, 31201, 33024, 32077, 32487, 54659, 33948, 43314, 54643, 43964, 32077, 32273, 54659, 33948, 43314, 54643, 43964, 32077, 32172, 54659, 38331, 36244, 31201, 32348, 31201, 35189, 31739, 32273, 54659, 55745, 54571, 33818, 32077, 32273, 54659, 32068, 32679, 51868, 35343, 32273, 54659, 32068, 32679, 51868, 35343, 32172, 54659, 32068, 35200, 32273, 54659, 32068, 35200, 33441, 31201, 34888, 54659, 54866, 55179, 32273, 54659, 54866, 55179, 32273, 33610, 32273, 54659, 54866, 55179, 32273, 33610, 32172, 54659, 32093, 33290, 31664, 32569, 54659, 32093, 31811, 32273, 33610, 32273, 54659, 32093, 31811, 32273, 33610, 32172, 54659, 33187, 31713, 33610, 32273, 54659, 33187, 31713, 33610, 32172, 54659, 35688, 43228, 31724, 33610, 32172, 54659, 34797, 31811, 32602, 31936, 54659, 34797, 32002, 32602, 31936, 54659, 31668, 31645, 31201, 31668, 31936, 31201, 31668, 32539, 31201, 31668, 31964, 31201, 31668, 35928, 31201, 31668, 33129, 54659, 31668, 40321, 54659, 35980, 40321, 54659, 32602, 32172, 54659, 32602, 31936, 54659, 33522, 36231, 31713, 54659, 31713, 31641, 31645, 54659, 54836, 33269, 33934, 35741, 54659, 35741, 31645, 1589, 765, 37325, 31825, 5440, 765, 33948, 35390, 31201, 33024, 54542, 32077, 46991, 54569, 1589, 765, 34453, 31825, 33328, 5440, 765, 35626, 1589, 765, 35159, 31825, 33328, 5440, 765, 33948, 35390, 31201, 33024, 54542, 32077, 46991, 54569, 1589, 765, 37602, 31825, 33328, 5440, 765, 31722, 33024, 54542, 32077, 46991, 54569, 30953, 16963, 31123, 54687, 31648, 37982, 54555, 32040, 38724, 54538, 31123, 31648, 31667, 32180, 32858, 38724, 31211, 4005, 41908, 1589, 765, 54539, 31740, 54542, 53444, 1589, 765, 31999, 32021, 1589, 765, 40278, 33089, 1589, 765, 32658, 33242, 1589, 765, 32093, 34686, 1589, 765, 32224, 34357, 1589, 765, 53558, 1589, 765, 34052, 33610, 54542, 32519, 31811, 31976, 1589, 765, 39180, 1589, 765, 30989, 54853, 56508, 56033, 55396, 54766, 30991, 38157, 38078, 1589, 765, 32031, 32273, 37154, 1589, 765, 37962, 31748, 1589, 765, 45268, 1589, 765, 34797, 1589, 765, 54829, 54563, 51273, 54829, 54913, 1589, 765, 54913, 54614, 31707, 1589, 765, 43005, 54558, 1589, 765, 55514, 31760, 54542, 54931, 55514, 31760, 1589, 765, 34150, 32269, 4960, 31155, 55073, 32001, 39547, 54530, 36844, 33287, 31155, 30910, 64796, 30910, 13, 15404, 34797, 1252, 449, 34052, 33610, 54542, 32519, 31811, 31976, 5515, 2]'input_ids'就可以看到真正送入模型推理的 prompt 的样例。

送入模型训练的数据集样例如下所示:from modelscope import AutoTokenizer, AutoModel, snapshot_download model_dir = snapshot_download("ZhipuAI/chatglm3-6b") tokenizer = AutoTokenizer.from_pretrained(model_dir, trust_remote_code=True) # model = AutoModel.from_pretrained(model_dir, trust_remote_code=True).half().cuda() input_ids = [64790, 64792, 64795, 30910, 13, 30910, 34607, 33500, 31636, 31648, 33328, 54530, 32114, 31155, 55073, 31793, 35100, 31648, 45987, 29552, 30982, 30953, 31648, 33624, 31301, 54580, 55037, 31300, 5440, 765, 30952, 3337, 36244, 31713, 31301, 32841, 31300, 31830, 1589, 765, 32087, 32238, 5440, 765, 31873, 31671, 31211, 33948, 32126, 32273, 54659, 33948, 32126, 32172, 54659, 33948, 31976, 32273, 54659, 33948, 31976, 32172, 54659, 33024, 35989, 32077, 32273, 54659, 33024, 35989, 32077, 32172, 54659, 32157, 54751, 42052, 54619, 39984, 42708, 32077, 32273, 54659, 35753, 32077, 46991, 54659, 35989, 32077, 46991, 54659, 32157, 31201, 33024, 32077, 32487, 54659, 33948, 43314, 54643, 43964, 32077, 32273, 54659, 33948, 43314, 54643, 43964, 32077, 32172, 54659, 38331, 36244, 31201, 32348, 31201, 35189, 31739, 32273, 54659, 55745, 54571, 33818, 32077, 32273, 54659, 32068, 32679, 51868, 35343, 32273, 54659, 32068, 32679, 51868, 35343, 32172, 54659, 32068, 35200, 32273, 54659, 32068, 35200, 33441, 31201, 34888, 54659, 54866, 55179, 32273, 54659, 54866, 55179, 32273, 33610, 32273, 54659, 54866, 55179, 32273, 33610, 32172, 54659, 32093, 33290, 31664, 32569, 54659, 32093, 31811, 32273, 33610, 32273, 54659, 32093, 31811, 32273, 33610, 32172, 54659, 33187, 31713, 33610, 32273, 54659, 33187, 31713, 33610, 32172, 54659, 35688, 43228, 31724, 33610, 32172, 54659, 34797, 31811, 32602, 31936, 54659, 34797, 32002, 32602, 31936, 54659, 31668, 31645, 31201, 31668, 31936, 31201, 31668, 32539, 31201, 31668, 31964, 31201, 31668, 35928, 31201, 31668, 33129, 54659, 31668, 40321, 54659, 35980, 40321, 54659, 32602, 32172, 54659, 32602, 31936, 54659, 33522, 36231, 31713, 54659, 31713, 31641, 31645, 54659, 54836, 33269, 33934, 35741, 54659, 35741, 31645, 1589, 765, 37325, 31825, 5440, 765, 33948, 35390, 31201, 33024, 54542, 32077, 46991, 54569, 1589, 765, 34453, 31825, 33328, 5440, 765, 35626, 1589, 765, 35159, 31825, 33328, 5440, 765, 33948, 35390, 31201, 33024, 54542, 32077, 46991, 54569, 1589, 765, 37602, 31825, 33328, 5440, 765, 31722, 33024, 54542, 32077, 46991, 54569, 30953, 16963, 31123, 54687, 31648, 37982, 54555, 32040, 38724, 54538, 31123, 31648, 31667, 32180, 32858, 38724, 31211, 4005, 41908, 1589, 765, 54539, 31740, 54542, 53444, 1589, 765, 31999, 32021, 1589, 765, 40278, 33089, 1589, 765, 32658, 33242, 1589, 765, 32093, 34686, 1589, 765, 32224, 34357, 1589, 765, 53558, 1589, 765, 34052, 33610, 54542, 32519, 31811, 31976, 1589, 765, 39180, 1589, 765, 30989, 54853, 56508, 56033, 55396, 54766, 30991, 38157, 38078, 1589, 765, 32031, 32273, 37154, 1589, 765, 37962, 31748, 1589, 765, 45268, 1589, 765, 34797, 1589, 765, 54829, 54563, 51273, 54829, 54913, 1589, 765, 54913, 54614, 31707, 1589, 765, 43005, 54558, 1589, 765, 55514, 31760, 54542, 54931, 55514, 31760, 1589, 765, 34150, 32269, 4960, 31155, 55073, 32001, 39547, 54530, 36844, 33287, 31155, 30910, 64796, 30910, 13, 15404, 34797, 1252, 449, 34052, 33610, 54542, 32519, 31811, 31976, 5515, 2] tokenizer.decode(input_ids)"[gMASK]sop<|user|> \n {text} <|assistant|> \n {label}"'[gMASK]sop<|user|> \n 你是专门进行企业分类的专家。请根据提供的企业相关信息:\'{\'企业名称(全称)\': \'DIG自动化工程(武汉)有限公司\', \'经营范围\': \'一般项目:金属结构制造;金属结构销售;金属材料制造;金属材料销售;机械电气设备制造;机械电气设备销售;电子元器件与机电组件设备制造;通用设备修理;电气设备修理;电子、机械设备维护;金属切割及焊接设备制造;金属切割及焊接设备销售;船舶自动化、检测、监控系统制造;船用配套设备制造;工业自动控制系统装置制造;工业自动控制系统装置销售;工业机器人制造;工业机器人安装、维修;增材制造;增材制造装备制造;增材制造装备销售;智能机器人的研发;智能基础制造装备制造;智能基础制造装备销售;海洋工程装备制造;海洋工程装备销售;海上风电相关装备销售;人工智能基础软件开发;人工智能应用软件开发;技术服务、技术开发、技术咨询、技术交流、技术转让、技术推广;技术进出口;货物进出口;软件销售;软件开发;对外承包工程;工程管理服务;非居住房地产租赁;租赁服务\', \'所属行业\': \'金属制品、机械和设备修理业\', \'一级行业分类\': \'制造业\', \'二级行业分类\': \'金属制品、机械和设备修理业\', \'三级行业分类\': \'其他机械和设备修理业\'}\',将企业划分到以下类别中,企业可能属于多个类别:[\'文化旅游\', \'大健康和生物技术\', \'现代金融\', \'商贸物流\', \'绿色环保\', \'智能建造\', \'数字创意\', \'氢能\', \'高端装备和先进基础材料\', \'网络安全\', \'“光芯屏端网”新一代信息技术\', \'汽车制造和服务\', \'量子科技\', \'航空航天\', \'人工智能\', \'深地深海深空\', \'空天信息\', \'电磁能\', \'脑科学和类脑科学\', \'超级计算\']。请按照列表的格式回答。 <|assistant|> \n ["人工智能", "高端装备和先进基础材料"]' - 预测的数据集样例

"[gMASK]sop<|user|> \n {text} <|assistant|>""[gMASK]sop<|user|> \n 你是专门进行企业分类的专家。请根据提供的企业相关信息:'{'企业名称(全称)': 'DIG自动化工程(武汉)有限公司', '经营范围': '一般项目:金属结构制造;金属结构销售;金属材料制造;金属材料销售;机械电气设备制造;机械电气设备销售;电子元器件与机电组件设备制造;通用设备修理;电气设备修理;电子、机械设备维护;金属切割及焊接设备制造;金属切割及焊接设备销售;船舶自动化、检测、监控系统制造;船用配套设备制造;工业自动控制系统装置制造;工业自动控制系统装置销售;工业机器人制造;工业机器人安装、维修;增材制造;增材制造装备制造;增材制造装备销售;智能机器人的研发;智能基础制造装备制造;智能基础制造装备销售;海洋工程装备制造;海洋工程装备销售;海上风电相关装备销售;人工智能基础软件开发;人工智能应用软件开发;技术服务、技术开发、技术咨询、技术交流、技术转让、技术推广;技术进出口;货物进出口;软件销售;软件开发;对外承包工程;工程管理服务;非居住房地产租赁;租赁服务', '所属行业': '金属制品、机械和设备修理业', '一级行业分类': '制造业', '二级行业分类': '金属制品、机械和设备修理业', '三级行业分类': '其他机械和设备修理业'}',将企业划分到以下类别中,企业可能属于多个类别:['文化旅游', '大健康和生物技术', '现代金融', '商贸物流', '绿色环保', '智能建造', '数字创意', '氢能', '高端装备和先进基础材料', '网络安全', '“光芯屏端网”新一代信息技术', '汽车制造和服务', '量子科技', '航空航天', '人工智能', '深地深海深空', '空天信息', '电磁能', '脑科学和类脑科学', '超级计算']。请按照列表的格式回答。 <|assistant|>"

vllm 代码部署

import json

import pickle

import pandas as pd

from vllm import LLM, SamplingParams# "top_p": 0, "n": 1,

sampling_params = SamplingParams(temperature=0, n=1, max_tokens=2048)model_path = 'new_model'

llm = LLM(model=model_path,trust_remote_code=True,tokenizer=model_path,tokenizer_mode='auto',tensor_parallel_size=1

)

将本地需要预测的文本,转成 template 风格的prompt,再让大模型去预测;

prompts = []

industry_name = []

with open('data.json','r') as f:for line in f:item = json.loads(line)text = item["instruction"]prompts.append(f"[gMASK]sop<|user|> \n {text}<|assistant|>")

这篇关于llama-factory SFT 系列教程 (四),lora sft 微调后,使用vllm加速推理的文章就介绍到这儿,希望我们推荐的文章对编程师们有所帮助!