本文主要是介绍论文阅读 - BIC: Twitter Bot Detection with Text-Graph Interaction and Semantic Consistency,希望对大家解决编程问题提供一定的参考价值,需要的开发者们随着小编来一起学习吧!

论文链接:https://arxiv.org/abs/2208.08320

目录

1 摘要

2 绪论

3 相关工作

3.1 Twitter-bot Detection

3.2 Text-Graph Interaction

4 问题定义

5 方法

5.1 模态交互

5.2 语义一致性检测

5.3 训练和推理

6 实验

6.1 实验设置

6.2 实验结果

6.3 文本-图形交互研究

6.4 语义一致性研究

6.5 案例分析

7 结论

1 摘要

Twitter bot 检测是一项重要且有意义的任务。现有的基于文本的方法可以深入分析用户的推文内容,实现高性能。然而,新颖的 Twitter 机器人通过窃取真实用户的推文并用良性推文稀释恶意内容来逃避这些检测。这些新颖的机器人被提议以语义不一致为特征。此外,最近出现了利用 Twitter 图结构的方法,显示出极大的竞争力。然而,几乎没有一种方法可以使文本和图形模态深度融合和交互,以利用这两种优点并了解两种模态的相对重要性。在本文中,我们提出了一种名为 BIC 的新模型,该模型使文本和图形模式深度交互并检测推文语义不一致。具体来说,BIC 包含一个文本传播模块、一个图传播模块,分别对文本和图结构进行机器人检测,以及一个经过验证的有效文本-图交互模块,使两者交互。此外,BIC 包含一个语义一致性检测模块,用于从推文中学习语义一致性信息。大量实验表明,我们的框架在全面的 Twitter 机器人基准测试中优于竞争基线。我们还证明了所提出的交互和语义一致性检测的有效性。

2 绪论

Twitter 是一个受欢迎的社交媒体平台,拥有来自世界各地的大量注册用户。然而,哪里有繁荣,哪里就有黑暗。数以百万计的 Twitter 机器人试图变相潜入真正的用户。 Twitter 机器人由自动化程序控制并被操纵以追求恶意目标,例如传播错误信息 (Cresci 2020) 和进行极端宣传 (Berger and Morgan 2015)。在这种情况下,已经付出了巨大的努力来对抗 Twitter 机器人。

Twitter 机器人检测的早期工作主要集中在特征工程上。传统机器学习算法考虑了各种特征类别:(i)用户推文特征(Cresci et al. 2016); (ii) 用户元数据特征(Yang et al. 2020; Miller et al. 2014; D'Andrea et al. 2015); (iii) 从邻域信息中提取的特征 (Yang, Harkreader, and Gu 2013)

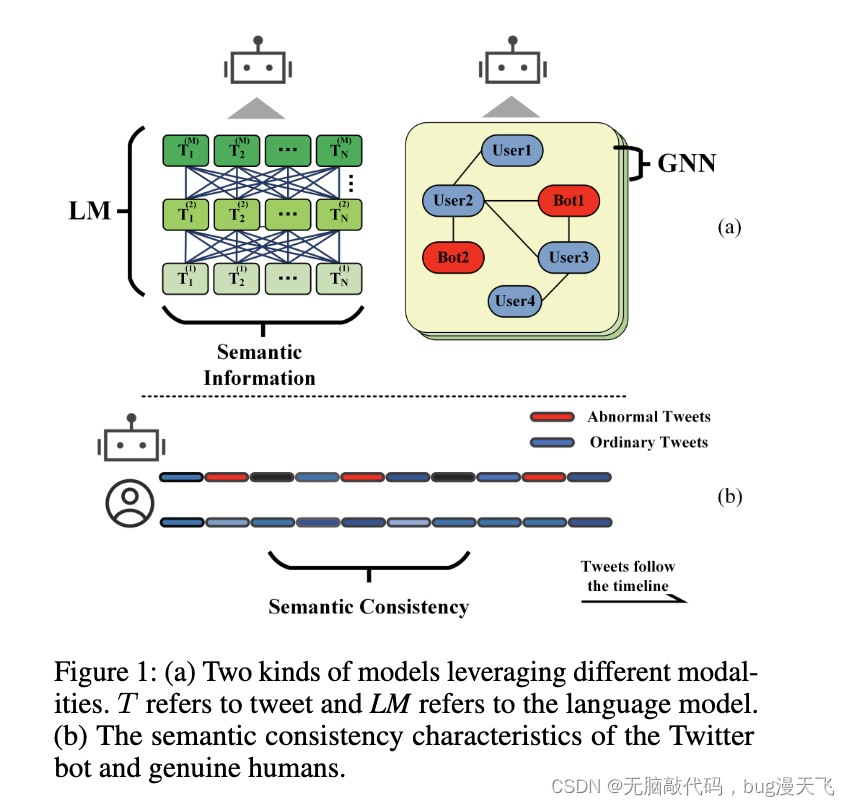

由于特征工程模型的主观性和有限的信息提取效率,基于神经网络的方法被用来进一步利用文本信息,其中语言模型彻底挖掘用户丰富的语义信息用于机器人检测。这种方法的模式在图 1 (a) 的左侧进行了描述。典型的方法 Kudugunta 和 Ferrara (2018) 结合特征工程和 LSTM 来检测带有用户语义信息的机器人。 Wei and Nguyen (2019) 在语义传播中采用了三层 BiLSTM。

然而,Twitter 机器人在不断发展,并且对简单的分析方法变得回避。新型机器人通过窃取真实用户的推文(Mukunthan 和 Arunkrishna 2021;Cresci 等人 2017b)并用良性推文稀释恶意内容(Yang、Harkreader 和 Gu 2013;Chu 等人 2012)来逃避检测。因此,新的 Twitter 机器人应该在他们的推文中具有更高的不一致性,而以前基于文本的方法忽略了这些有用的信息。这就需要对Twitter用户的语义一致性进行建模,并将其用于机器人检测。上述新型机器人的语义一致性特征如图1 (b)所示。

此外,基于文本的方法通常依赖于语言和机器人之间的简单且有时是虚假的相关性。另一方面,机器人检测研究的最新进展表明利用 Twitter 网络结构进行结构化推理和鲁棒性评估。 Ali Al-hosseini 等人 (2019)采用图卷积网络进行机器人检测。冯等人 (2022) 构建了一个利用关系和影响异质性的图表。两种方法在机器人检测任务中都表现出非凡的性能,证实了网络结构的有效性。此类方法的模式如图 1 (a) 的右侧所示.

然而,几乎没有一种方法同时利用文本和图形结构推理,尽管可以考虑各种信息。此外,简单地在两种模态中并行传播无法协调两种模态并了解模态在检测机器人中的相对重要性。这需要进行研究,以实现两种模式之间的深度融合和交流.

在本文中,我们提出了一个框架 BIC(Twitter Bot Detection with Text-Graph Interaction and Semantic Consistency)来检测用户推文中的不一致性,并利用两种方式的优势和合理的交互来学习相对重要性。具体来说,BIC 采用文本传播模块来处理用户的语义信息。 BIC采用图传播模块来充分传播用户邻域信息。 BIC 还包含一个交互模块,可生成深度链接并融合两个模块之间的信息。交互模块从两种模态中选择两种交互表示来交换信息,并基于相似性更好地了解两种模态的相对重要性。此外,BIC 包含一个语义一致性检测模块,可以利用注意力权重监控用户的不一致推文。最后,我们聚合所有模块并进行 Twitter 机器人检测。我们的主要贡献总结如下:

我们提出了一个语义一致性检测模块,它可以深入挖掘用户语义信息并监控大量推文中的语义不一致,因此可以检测出模仿人类的高级机器人;

我们提出了一个模型 BIC,它利用神经网络利用用户信息的文本和图形模态,并通过一个有效的基于相似性的交互模型通过交互表示将这两种模态深度联系起来。 BIC 可以学习模态的相对重要性,并使用两种模态更全面地检测机器人;

我们对综合数据集进行了广泛的实验。结果表明,我们的模型优于最先进的方法。进一步的分析也证实了我们提出的交互模型和语义一致性检测模型的有效性;

3 相关工作

3.1 Twitter-bot Detection

基于特征的方法。传统方法主要侧重于特征工程,采用机器学习分类器。利用多种特征来检测机器人,包括用户推文特征(Cresci et al. 2016; Ferreira Dos Santos et al. 2019; Kantepe and Ganiz 2017),用户资料特征(Yang et al. 2020; Beskow and Carley 2019; Echeverr ̈ı£¡ a et al. 2018),以及从用户中提取的其他特征(Miller et al. 2014; Beskow and Carley 2018; Loyola-Gonz ́alez et al. 2019; Rodŕıguez-Ruiz et al. 2020)

基于文本的方法。随着神经网络的蓬勃发展,基于深度学习的机器人检测方法如雨后春笋般涌现(Heidari、Jones 和 Uzuner 2020)。 Wei and Nguyen (2019) 采用循环神经网络来捕获推文特征。 Kudugunta 和 Ferrara (2018) 将 LSTM 应用于不同层次的特征。 Stanton 和 Irissappane (2019) 提出利用生成对抗网络来检测垃圾邮件机器人。哈亚维等人(2022) 采用了多种特征,并利用 LSTM 和密集层来学习表示。冯等人(2021a)提出了一个自监督框架,浅层地利用了尚未包含在图结构中的用户语义、属性和邻居信息。

基于图的方法。除了基于文本的神经网络外,图神经网络还用于改进 Twitter 机器人检测器(Magelinski、Beskow 和 Carley 2020;Dehghan 等人 2022;Yang 等人 2022)。 Alhosseini 等人(2019)使用卷积图网络进行机器人检测。冯等人(2021c)构建了一个用于机器人检测的异构图网络,而冯等人(2022)通过附加关系改善了异质性。

在本文中,我们在这些工作的基础上提出了一种模态交互式机器人检测器,它利用了两种结构的优势。我们还建议检测用户语义信息中的异常行为模式。

3.2 Text-Graph Interaction

文本-图形交互在 NLP 领域被广泛使用。在知识引导的问答问题中,有必要同时利用文本模态和知识图模态。早期的作品只是简单地聚合了这两种模式而没有交互(Mihaylov 和 Frank 2018)。后来的作品只允许两种模态以浅层的方式相互作用。通常,他们将一种模态作为附加项添加到另一种模态(Feng et al. 2020; Wang et al. 2019; Lin et al. 2019; Yang et al. 2019a; Lv et al. 2020),学习了隐式模态信息从另一个模型(Bosselut et al. 2019; Petroni et al. 2019; Hwang et al. 2021; Wang et al. 2020; Bosselut, Le Bras, and Choi 2020),或与 GNN 共同从两种模式中学习信息( Yasunaga et al. 2021)。最近,GreaseLM (Zhang et al. 2022) 提出了一种模型,通过交互节点在层之间交互两种模态,实现了真正的深度交互。在本文中,我们提出了一个受 GreaseLM 启发的框架,并在模态交互的帮助下进行机器人检测。

4 问题定义

在机器人检测任务中,我们可能会从用户那里获得多个信息。在本文中,我们将用户的描述和推文用于文本模块。 表示用户用 L 个词的描述。

表示用户的推文,每条推文

包含

个词。对于图形模块,考虑了用户元数据特征集:数值和分类特征,其中

表示用户的数值和分类用户属性集。具有 J 个邻居的用户邻居集表示为

。我们将用户信息 B、S、P、N 输入我们的模型并得出预测标签。

5 方法

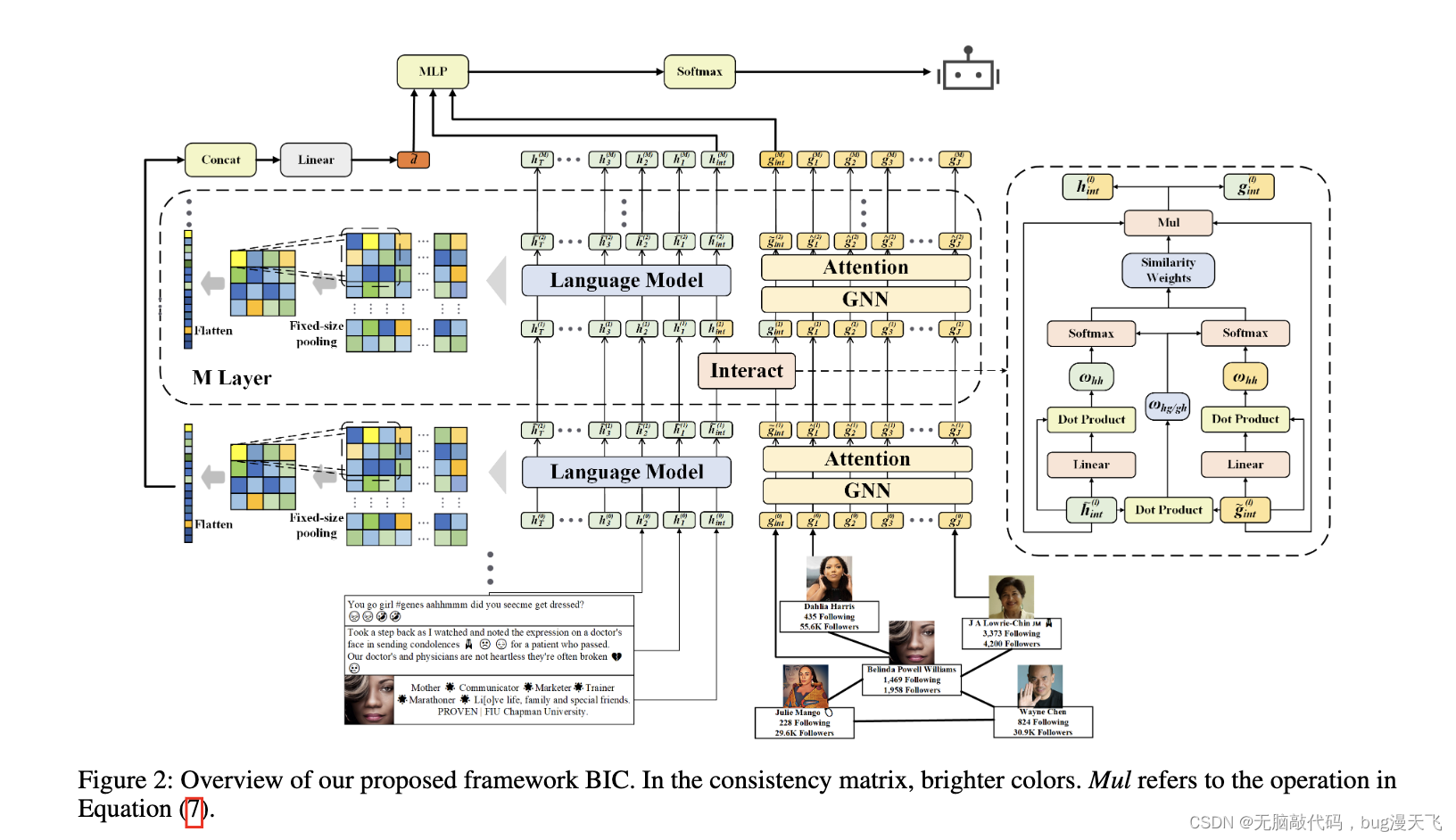

图 2 显示了我们提出的名为 BIC 的框架的概述。 BIC 由 M 层组成,其中每一层有两个组件:(i)模态交互,(ii)语义一致性检测,而第一个组件包含三个模块:文本传播模块、图传播模块和文本-图交互模块。

5.1 模态交互

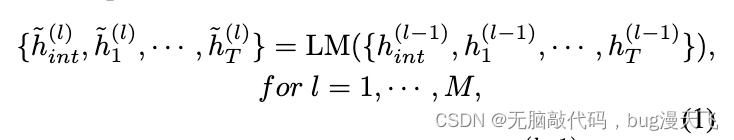

文本传播模块在文本传播模块的每一层,我们将文本表示提供给一个语言模型,该语言模型将学习语义信息,并将交互信息从交互表示更新到其他表示,即

其中 LM 指的是语言模型,表示第 (l-1) 层中文本模态的交互式表示,

表示第(l-1)层中文本模态的其他表示。为了彻底挖掘用户的内容信息,我们采用 Transformer (Vaswani et al. 2017) 作为每一层的文本模块。

对于第一层,我们首先使用 RoBERTa (Liu et al. 2019) 预训练的编码模型对用户描述 B 进行编码,并获得用户对描述 的初始嵌入,这将用作交互式表示。然后我们将用户推文

分别发送到 RoBERTa 编码模型,并推导出初始推文嵌入集

。最后,初始表示被送入第一个文本传播模块。

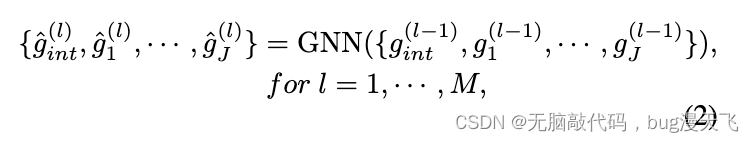

图传播模块 对于图模块中的每一层,图表示首先被输入到 GNN 层以在用户与其邻居之间传播信息,其中也为邻居更新交互信息,即

其中表示用户在第 (l-1) 层中的图模态的交互式表示,而

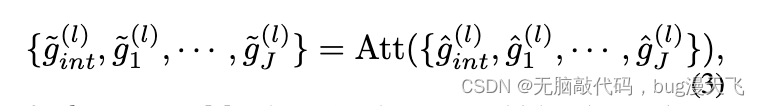

表示在第(l-1)层的邻居表示。由于 GCN (Kipf and Welling 2016) 是一种广泛使用且性能优异的模型,我们使用 GCN 作为图神经网络。然后使用多头注意力层利用注意力权重更新用户邻域信息:

对于 l = 1,··· ,M,其中 Att 表示多头注意力。

对于第一层,我们采用与 Feng 等人相同的用户特征编码程序(2021c)。我们进行 z-score 归一化并获得用户数字属性 和分类属性

的表示。我们聚合用户特征表示的所有多样性以生成用户初始嵌入

用于图模态,其中

表示用户的初始特征嵌入,用于交互式表示,而

是用户 J 个邻居的初始特征嵌入。然后将初始表示送到第一层图模块。

文本图交互模块。文本图交互模块学习两种模式的相对重要性,并在两个特别选择的交互表示之间融合信息,即

![]()

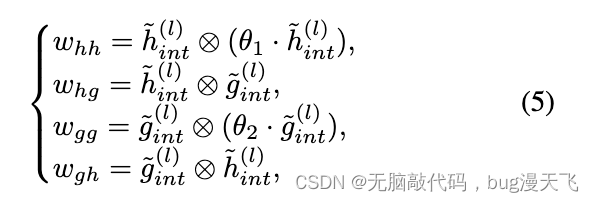

其中 Int 是指交互功能。具体来说,我们首先计算两个表示与其自身之间的相似系数。在本文中,我们采用点积作为相似度函数,即

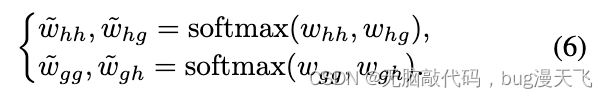

其中 θ1 和 θ2 是可学习的参数,⊗表示点积。然后我们应用 softmax 并得出最终的相似度权重,即

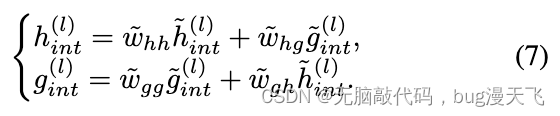

然后,我们在派生的相似性权重的帮助下交互这两种表示,即

通过相似度加权,学习文本和图模式的相对重要性。在交互模块层之后,交互表示 和

分别与用户推文

和邻居节点被送入下一层,其中

和

不包含交互层。交互层之后的文本传播模块和图形传播模块允许交互表示接收的信息从一种模态到另一种模态,使两种模态之间的交互更深。

5.2 语义一致性检测

由于来自transformer的注意力权重可以指示推文之间的相关性和一致性,因此我们采用注意力权重进行语义一致性检测。从每个模型层中,我们从语言模型中的transformer中提取注意力权重,以构造一个矩阵 ,该矩阵存储用户推文之间的一致性信息。当用户发布带有异常模式和不一致内容的推文时,一些异常会显示在由注意力权重组成的矩阵中。为了更好地利用一致性信息,我们首先实现最大池化来导出一个固定大小的矩阵,即

![]()

其中 K 是超参数;固定大小池化表示以固定大小矩阵作为结果的池化。为了在下一部分中更好地使用神经网络,我们将矩阵展平以生成一致性向量,即

![]()

对于每一层,我们有一个一致性向量并将它们聚合以得出最终的一致性向量,表示为

5.3 训练和推理

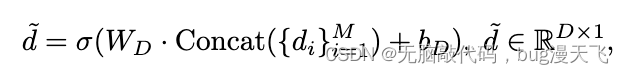

我们聚合来自最终层的文本传播模块和图传播模块的输出以及一致性向量,以通过以下方式得出单个用户的最终特征表示:

![]()

最终的特征表示随后被发送到 MLP 和 softmax 层以得出预测分数 ^y,即

![]()

我们使用预测分数和ground-truth标签之间的交叉熵损失来优化模型,即

![]()

其中 Y 表示训练集中的所有用户,θ 表示所有训练参数,yi 表示真实标签,λ 是正则系数。在推理时,我们根据预测分数预测最可能的标签。

我们在附录中介绍了 BIC 实现细节和超参数设置。

6 实验

6.1 实验设置

数据集 在本文中,我们在综合 Twitter 机器人检测基准 Twibot-20(Feng 等人 2021b)上进行了主要实验,其中包括 229,580 个 Twitter 用户、33,488,192 个推文和 33,716,171 个边缘。该数据集几乎涵盖了社交网络中的所有类型的机器人,并且是唯一具有图形信息的高质量 Twitter 机器人数据集,因此我们的方法可以被证明适用于各种社交机器人。我们遵循基准中提供的相同拆分,以便结果与以前的工作直接可比较。更多数据集 Cresci-17 (Cresci et al. 2017a), botometer-feedback-19 (Yang et al. 2019b) 也被用于之前的工作评估,它们不提供图形信息来支持我们的方法和最先进的基线。

基线 我们将 BIC 与以下方法进行比较:

(Miller et al. 2014) 从用户的推文和元数据中提取 107 个特征,并以异常检测的方式进行 Twitter 机器人检测;

Cresciet al(Cresciet al 2016)利用字符串对用户在线活动的序列进行编码;

Botometer (Davis et al. 2016) 是一项公开可用的服务,它利用了超过一千个功能;

SATAR (Feng et al. 2021a) 通过联合学习一系列用户特征来构建一个自监督的表示学习任务。然后它通过微调对机器人进行分类;

Kugugunta 等人(Kudugunta 和 Ferrara 2018)提出了一个共同利用用户 tweet 和属性信息的架构;

Wei 等人(Wei and Nguyen,2019)提出了一种机器人检测模型,该模型使用三层 BiLSTM 对 tweet 进行编码;

Alhosseini 等人 (Ali Alhosseini et al. 2019) 利用 GCN 来学习用户表示并对机器人进行分类;

BotRGCN (Feng et al. 2021c) 联合利用用户推文和三种元数据构建了一个基于关系图卷积网络的框架;

Yang 等人(Yang 等人,2020)采用带帐号元数据的随机森林进行机器人检测;

RGT (Feng et al. 2022) 利用关系和影响异构图网络进行机器人检测。

6.2 实验结果

整体模型分析。为了更好地掌握每种方法之间的差异并展示我们模型的创新点,我们首先通过它们使用的方式评估每种方法。评估细节见附录。然后,我们展示了每种方法在 Twibot-20 上的性能。表 1 中的结果表明

BIC 始终优于所有方法,包括最先进的方法 RGT (Feng et al. 2022),在综合和代表性数据集 TwiBot-20 上的准确度和 f1-score 相对提高 0.9%

BIC 比基于文本模态的最新模型 SATAR (Feng et al. 2021a) 的准确性高 4.0%,比基于图形模态的最新模型 RGT (Feng et al. 2021a) 的准确率高 0.9%。证明了两种方式的有效性。

在表 1 中,Text、Graph、Modality-Int 分别表示方法是否利用文本模态、图形模态和模态交互。

模态有效性研究。为了进一步验证文本模态和图形模态聚合的有效性,我们删除了其中一个,并对模型的其余部分进行机器人检测。在表 1 中,BIC text-only 和 BIC graph-only 分别表示只有文本模态和只有图形模态的模型。说明这两种模式的性能都比我们提出的模型差。具体地说,去除任何一种模态确实会妨碍模型考虑各种信息的能力,从而降低整体性能。

我们还发现只有文本模态的模型比只有图形模态的模型表现更差,这可能是由于网络结构对更多机器人的检测能力相对更强。

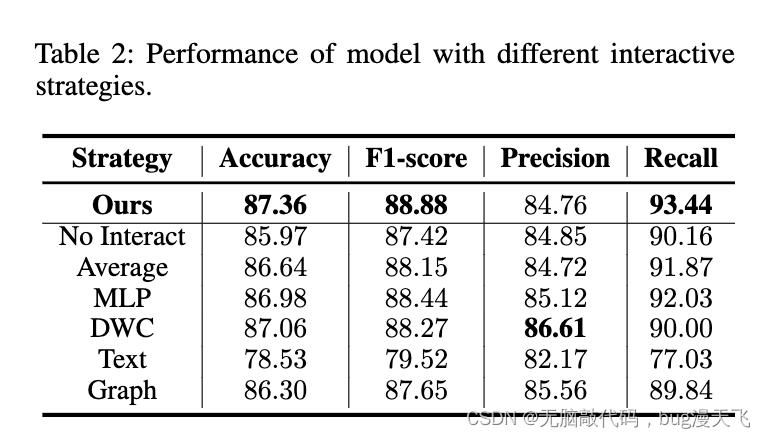

6.3 文本-图形交互研究

交互策略研究。在本文中,我们提出了一种基于相似性的模态交互模型,该模型已经详细阐述。为了证明我们基于相似性的模态交互模型的有效性,我们将其与没有和不同模态交互策略的方法进行了比较:Average、MLP、DWC(直接权重系数)、Text 和 Graph。这些模态交互策略在附录中有详细介绍。

如表 2 所示:

除了文本之外的所有交互策略都优于没有交互策略的方法,这表明使用交互模块的必要性;

我们基于相似性的模态交互策略优于其他所有策略,这很好地证实了它的有效性,表明它可以深入地使两种模态交互并学习模态的相对重要性;

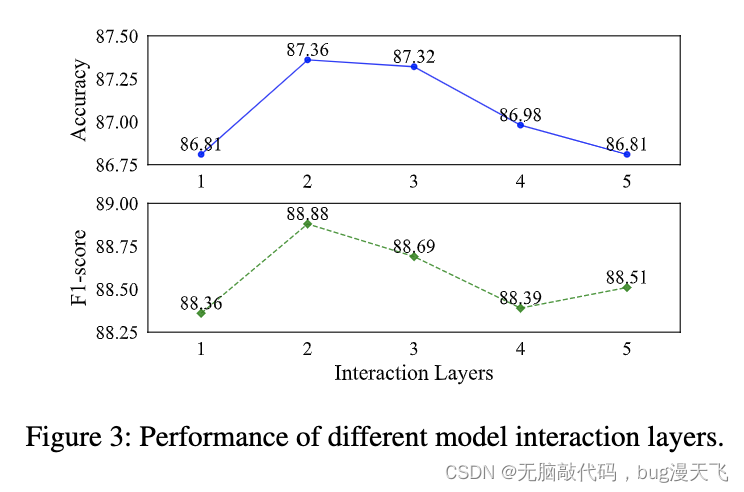

模型和交互层研究。为了找出我们的模型和交互有多少层具有最佳性能,我们对不同的层进行了实验。图 3 中的结果表明,两层模型的性能优于其他层设置。当层数增加时,性能逐渐下降,这可能是由于更高的复杂度增加了训练难度造成的。

此外,两层模型具有更少的时间和内存成本,这使其成为最佳选择。具体来说,它比第二好的三层模型的准确率高出 0.05%,f1-score 高出 0.21%,而它的时间成本低得多 37%,GPU 内存低 11%。

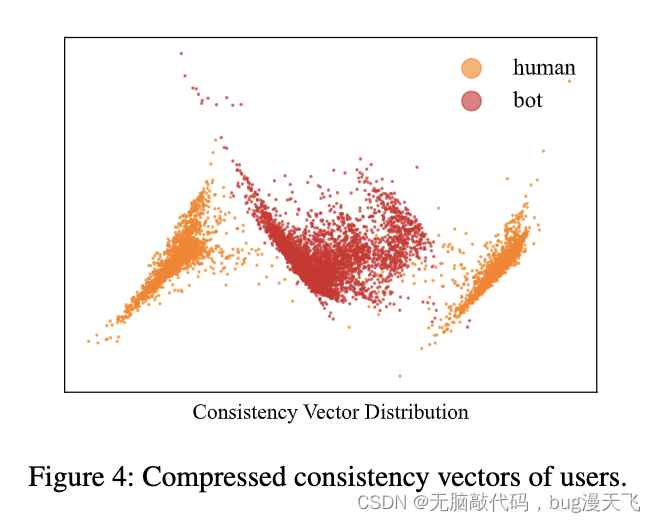

6.4 语义一致性研究

语义一致性有效性研究。为了定性地感知语义一致性的有效性,我们将聚类方法应用于一致性向量并进行分析。我们利用 PCA(主成分分析)将一致性向量的维度压缩为两个,并分别在图 4 中为人类和机器人描绘它们,并计算 K-means 的 V-measure-score。说明压缩的机器人一致性向量与人类的一致性向量明显分开,这极大地证明了我们提出的语义一致性检测模块的有效性。

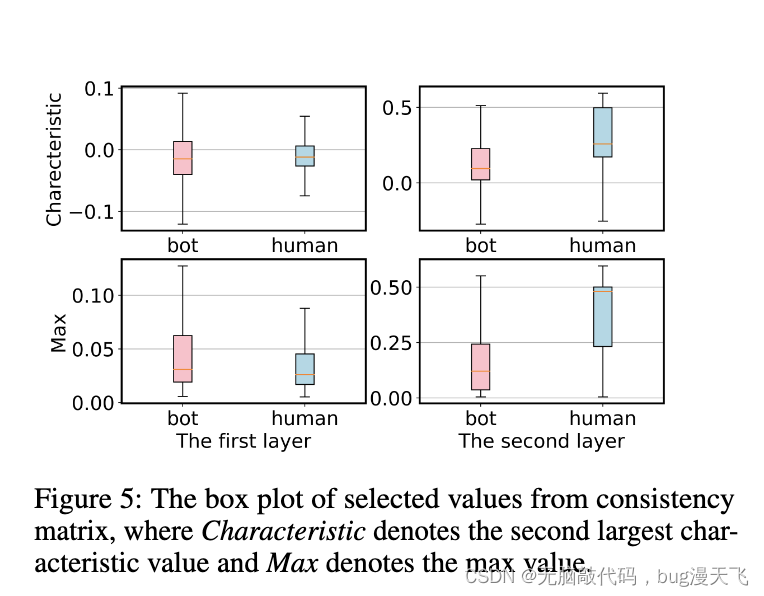

为了进一步证明语义一致性模块可以学习机器人和人类之间的差异,我们从每个用户的第一层和第二层推导出一致性矩阵中的最大和第二大特征值。然后,我们在图 5 中分别为机器人和人类绘制具有这些值的箱线图。说明了语义一致性模块确实学习了差异。

我们还选择了一个典型的 Twitter bot 和一个典型的真实用户,并可视化他们的第一层和第二层的一致性矩阵来进行案例研究。从图 6 可以看出,机器人在两层中明显表现出更多的不一致。

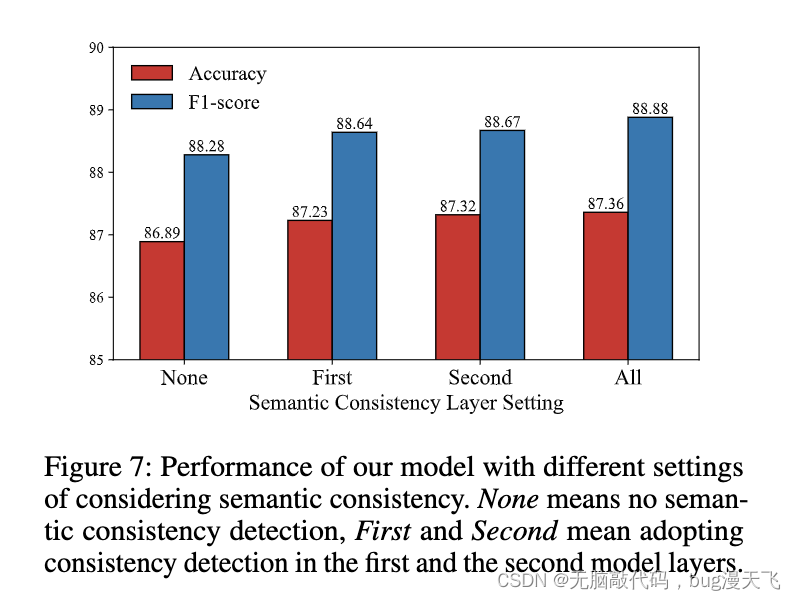

语义一致性层研究。为了找出使用多少层语义一致性模块是最优的并进一步证明利用语义一致性的有效性,我们对两层模型的三种不同设置进行了实验:无语义一致性检测,语义一致性检测仅在第一个模型层,或者只在第二个模型层。结果如图 7 所示。说明没有一致性检测表现最差,而一致性检测在第一层和第二层并驾齐驱,表明在两层都可以检测到机器人推文内容的不一致.它们都不如整个模型,其中证明了语义一致性检测的有效性

语义一致性案例研究。为了更好地理解用户语义一致性的有效性,我们选择了一个典型的 Twitter 机器人和一个典型的真实用户,并将它们的一致性矩阵可视化,包括第一层和第二层的注意力权重。从图 6 可以看出,在第一层中,虽然人类推文内容仍然存在轻微的不一致,但机器人的推文表现出更大的不一致。而在第二层,除了图的第一行,bot中存在更多的不一致。第一行的异常可能是模态交互的结果。

6.5 案例分析

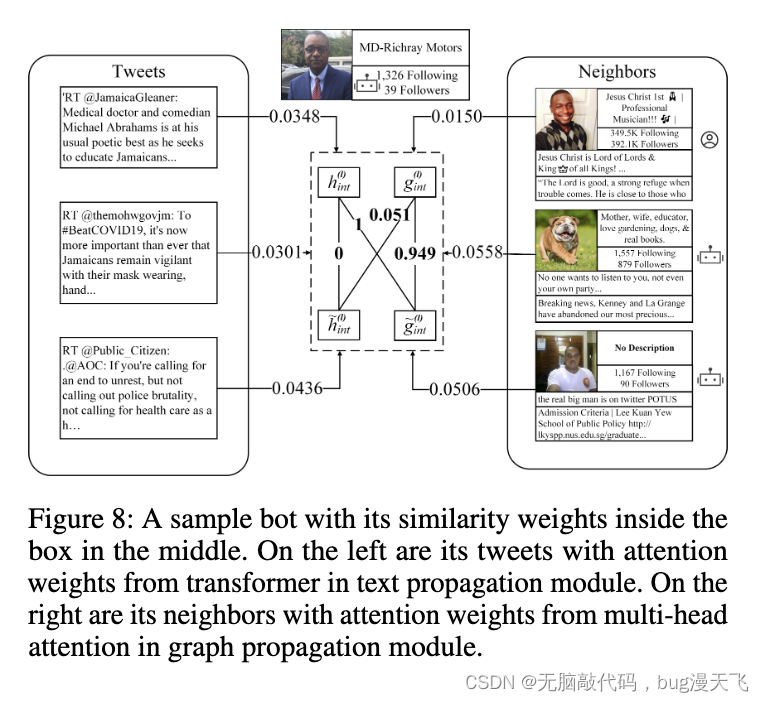

为了进一步分析我们提出的模型如何利用来自两种模式的信息来识别机器人,我们研究了机器人集中的一个特定案例。我们首先找到一些推文和具有注意力权重的机器人的邻居。

来自多个层的注意力权重平均为一个。然后,我们检索等式(5)中的相似性权重以对其进行定量分析。从图 8 中显示的详细用户信息中,我们发现由于所选机器人的机器人邻居和人类邻居的注意力权重比推文的注意力权重差异更大,邻域信息被学习得更多。该结论也反映在相似性权重中。来自文本模态的原始交互表示的相似性权重是 0 和 0.051,而来自图模态的原始交互表示的相似性权重是 1 和 0.049。结果进一步显示了基于相似性的交互的有效性,它确实学习了对模态的重视。

7 结论

Twitter机器人检测是一项日益重要的具有挑战性的任务。为了进行更全面的机器人检测,我们提出了一种基于图和文本模式的机器人检测模型BIC。BIC 还包含一个基于相似性的交互式模块,该模块利用两个交互式表示,提高了性能并了解了两种模式的相对重要性。 BIC 还采用语言模型中的注意力权重来创建用于语义一致性检测的一致性向量,这可能会防止新机器人的逃避。我们在综合基准上进行了广泛的实验,以证明我们的模型与竞争基线相比的有效性。进一步的实验也证实了模态交互和语义一致性检测的有效性。未来,我们计划探索更多更好的交互方式。

这篇关于论文阅读 - BIC: Twitter Bot Detection with Text-Graph Interaction and Semantic Consistency的文章就介绍到这儿,希望我们推荐的文章对编程师们有所帮助!

![[论文笔记]LLM.int8(): 8-bit Matrix Multiplication for Transformers at Scale](https://img-blog.csdnimg.cn/img_convert/172ed0ed26123345e1773ba0e0505cb3.png)