本文主要是介绍回归和尺度不变性,希望对大家解决编程问题提供一定的参考价值,需要的开发者们随着小编来一起学习吧!

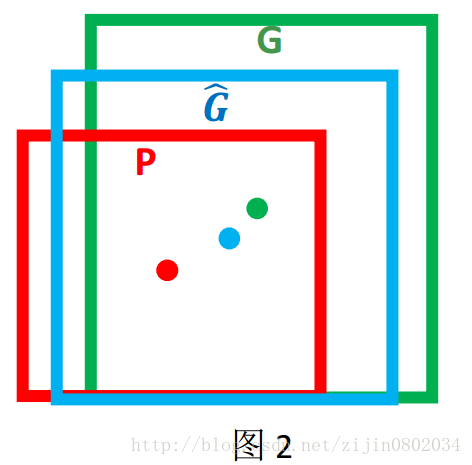

边框回归:我们的目标是寻找一种关系使得输入原始的窗口 P 经过映射得到一个跟真实窗口 G 更接近的回归窗口G(即使得默认框逼近真实框的平移和缩放比例,从而在预测中使得默认框趋近于预测框)

即给定(Px,Py,Pw,Ph)寻找一种映射ff, 使得f(Px,Py,Pw,Ph)=(Gx^,Gy^,Gw^,Gh^),并且(Gx^,Gy^,Gw^,Gh^)≈(Gx,Gy,Gw,Gh))

原理:平移+尺度放缩:

平移量(tx,ty) 和尺度缩放(tw,th)如下:

tx=(Gx−Px)/Pw

ty=(Gy−Py)/Ph

tw=log(Gw/Pw)

th=log(Gh/Ph)

边框回归的目的

如何做边框回归

输入

输出

学习的目的以及损失函数

疑问1

解答疑问

当边框相差过大的时候就不是线性模型能够解决的了,所以边框回归只能用于进行“微调”

为什么边框回归只能用于进行微调

尺度不变形:(仅关注只提取关键点点附近矩形区域的sample,即无论多大像素的同一张图片,其在关键点一定区域内都会出现极值(即,关注梯度的变化,边缘的变化))

总结:无论尺度变化,关键点附近一定会出现极值

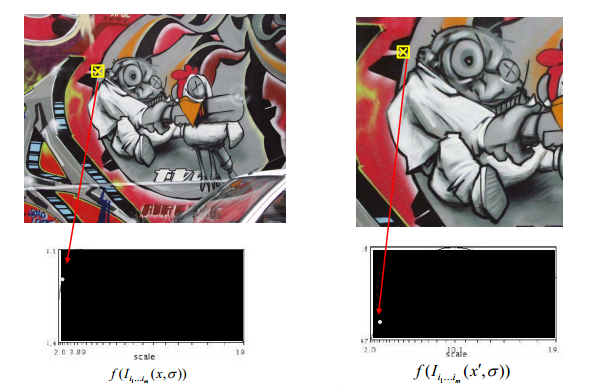

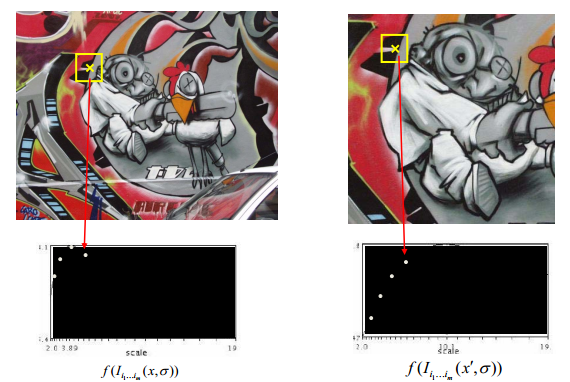

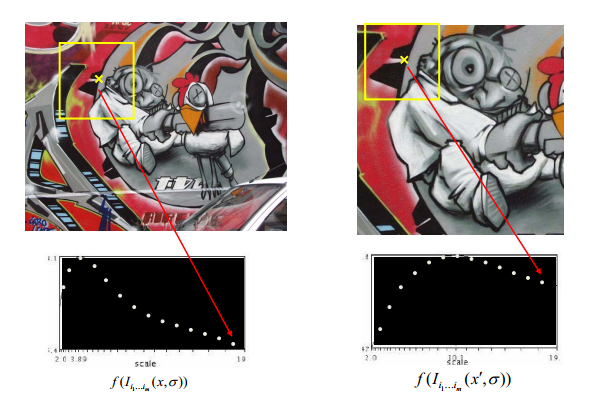

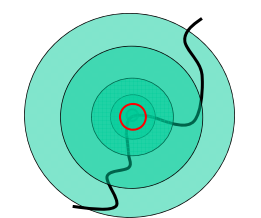

下面直观的看一系列不同scale的LoG作用在图像上一个角点会出现什么情况:

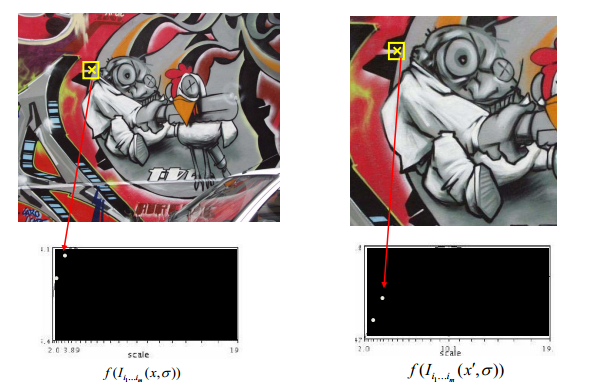

随着作用的scale增大,这一点的灰度值都出现了一个峰值。这就是尺度函数的精华所在,我们称之为scale signature。虽然这两张图样,初始尺度不一但是它们都在某个scale下出现了极值。那么被不同scale 的 LoG选出来的点有什么特性呢?

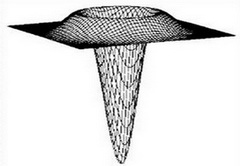

LoG长这个样子:

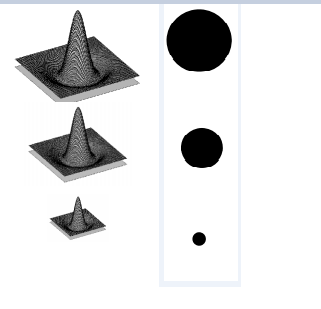

中间凸起的区域真是被LoG选中起作用的点,当scale变化时,被选中的范围是这么变的:

举个例子,有一条边缘曲线,全局看过去的时候是这样的:

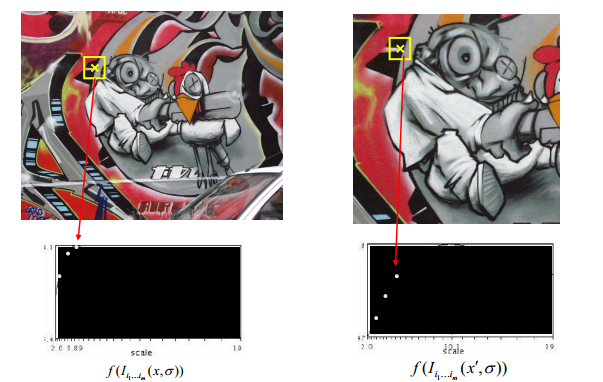

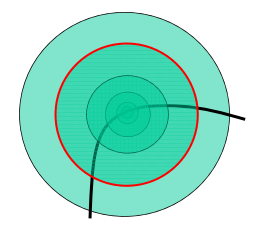

我们用不同的圈去框那个角点,也就是不同尺度作用在图像上,在红色框时灰度值达到最大值。现在我们将图像放大,继续用不同的圈去框那个角点:

这样在红色大框下达到最大值,最重要的一点是:这两个框框出来的图像信息其实是一样的,只是原图尺寸不一样,导致达到极值时需要的框不一样大!

比如说一张美女图片,想要框出帽子的信息,图像尺寸小时框要这么大:

图像尺寸大时,框也要相应调大:

这篇关于回归和尺度不变性的文章就介绍到这儿,希望我们推荐的文章对编程师们有所帮助!