本文主要是介绍Baichuan2开源聊天框架,使用Baichuan2-7B-Chat-4bits模型运行成功,硬件16G内存/GTX1070显卡,希望对大家解决编程问题提供一定的参考价值,需要的开发者们随着小编来一起学习吧!

前提摘要:

一.这几天一直在找开源的chatgpt框架,运行成功的有llama.cpp、chatgml2和baichuan2框架,先说说llama.cpp框架,使用的是cpu运行的框架,也成功了,但是我16g的cpu差点给我干烧了,太慢了,完全没法使用,相当累赘。

二.再说说chatgml2框架,这个框架该说不说,非常棒,gpu运行成功了,cpu运行也成功了,就是我的硬件是16G内存/GTX1070显卡,cpu运行非常慢但是比llama.cpp框架快一些,但是也不建议使用cpu运行,生成一个字要五分钟,实在太慢了,gpu运行速度是快了很多,大概一秒2个字的速度,当然是以我的显卡条件来评判的。

三.最后说说baichuan2框架,cpu运行不了,应该是16g的内存不够用,一运行直接卡死,gpu可以运行,运行成功后速度非常之快,大概是一秒钟10个字,同等硬件条件下比chatgml2框架运行速度快了五倍,真的牛逼!

四.下面我们来一步步的教大家使用Baichuan2-7B-Chat-4bits模型运行baichuan2框架,为什么不使用13B模型?那是因为13B模型跑不出来,一跑就卡死机,估计要32Gcpu内存以上,而且显卡要好!话不多说,开干!

1.安装cuda11.7版本的软件,找不到的使用我的网盘下载,如下

链接:https://pan.baidu.com/s/1ganjCJ2DLsCbw6D-lqsshA

提取码:p1hj

2.下载baichuan2框架,从我网盘里下载,里面有2个必须要的库包

链接:https://pan.baidu.com/s/15tDYWmXQRgQdf21mq3BwgQ

提取码:xfsl

3.安装pycharm软件和anaconda3软件,anaconda3里面创建一个3.10的python编译器

4.下载Baichuan2-7B-Chat-4bits模型地址如下,下载完成后放入自己的文件夹内

https://aliendao.cn/models/baichuan-inc/Baichuan2-7B-Chat-4bits

5.安装库包triton,使用命令

pip install .\triton-2.0.0-cp310-cp310-win_amd64.whl

6.安装库包bitsandbytes,使用命令

pip install .\bitsandbytes-0.41.1-py3-none-win_amd64.whl

7.安装其他库包,使用命令

pip install -r .\requirements.txt

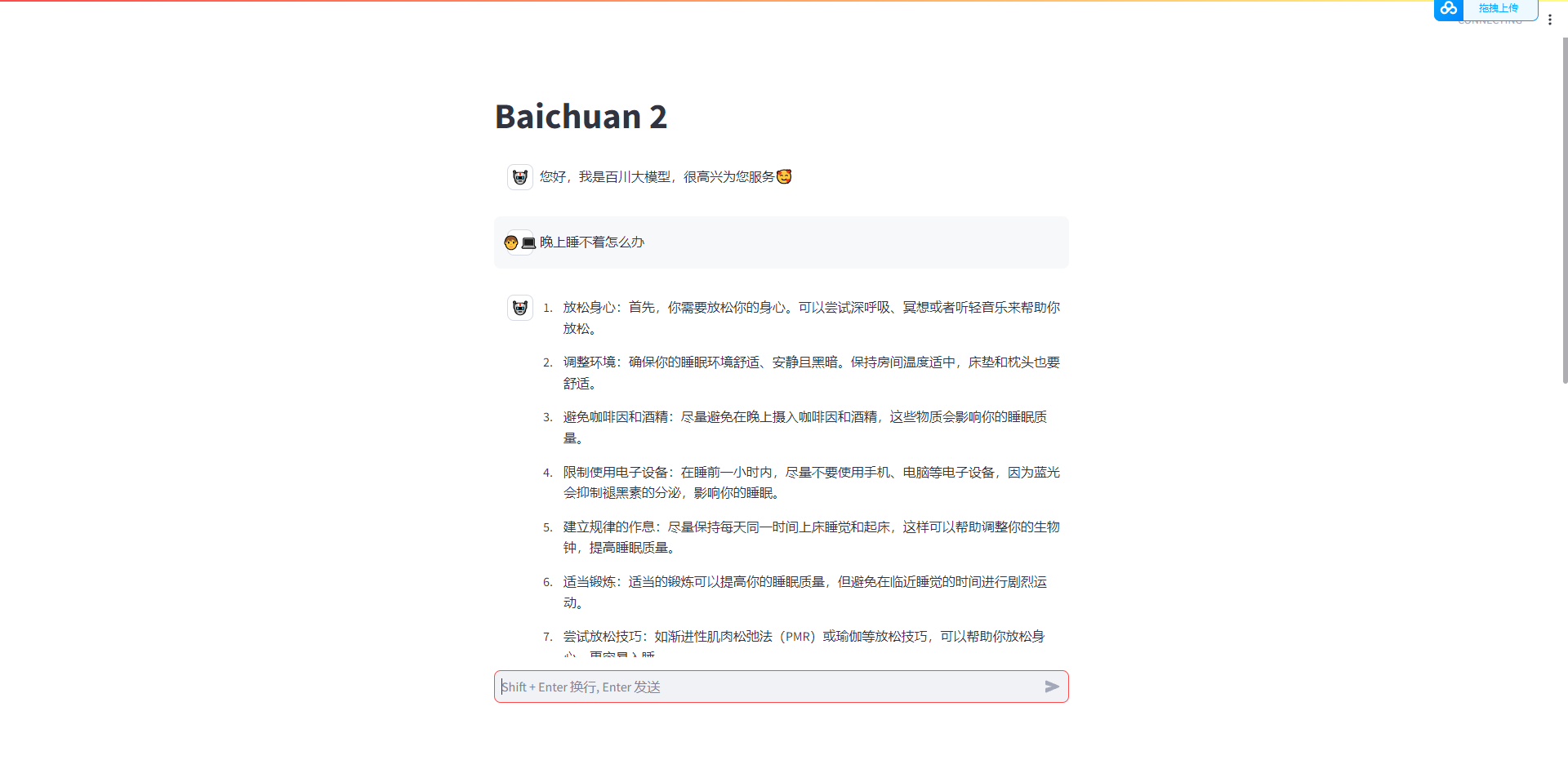

8.运行成功图

这篇关于Baichuan2开源聊天框架,使用Baichuan2-7B-Chat-4bits模型运行成功,硬件16G内存/GTX1070显卡的文章就介绍到这儿,希望我们推荐的文章对编程师们有所帮助!