本文主要是介绍TOF摄像机视频中的运动分割(MOTION SEGMENTATION IN VIDEOS FROM TIME OF FLIGHT CAMERAS),希望对大家解决编程问题提供一定的参考价值,需要的开发者们随着小编来一起学习吧!

摘要:

本文研究了深度摄像机视频序列中独立运动物体的运动估计和分割问题。具体地,我们提出了一种基于距离流和光流约束方程融合的运动估计算法。流场用于推导长期点轨迹。分割技术根据运动和深度相似性将轨迹分组为时空对象。我们展示了用飞行时间摄影机拍摄的真实场景的结果。

1.介绍:

本文分析了飞行时间(TOF)摄像机拍摄的视频序列中的短期和长期运动。我们通过综合距离流和光流来估计视频中两帧之间的运动。我们利用这些运动信息推导出稠密点轨迹,并将其分为时空段。导出的轨迹可以为更高层次的场景解释提供重要线索。此外,该信息还可以通过评估不同段之间的运动一致性来进行图像配准。 TOF摄像机实时提供直接距离(深度)和同步强度信息。然而,最先进的TOF相机空间分辨率有限,精度低。此外,距离相机的测量也会受到诸如物体反射率、物体距离[1]和内部光散射[2]等因素的影响。因此,有必要专门研究TOF摄像机测量中的运动估计。

1.1 目前技术水平

与描述两幅强度图像之间运动的光流类似,距离流[3]是指从一系列距离图像中导出的运动矢量。关于可变形表面上的距离流估计的初步工作,可在[4]中找到。Spies等人[3]给出不同类型三维结构情况下的距离流解决方案。Barron和Spies[5]在最小二乘框架中整合了距离流和光流。使用距离和强度信息可以导致更密集的流场。但是,不能保证每个像素都计算出了流向量。为了解决这个问题,[3]使用迭代正则化算法计算稠密流场。Schmidt等人[6]使用针孔相机模型,将TOF相机的传感器观测值直接合并到距离流约束方程中。 共同运动和空间接近是分组的有力线索[7]。这些知识在不同的分割方法中有不同的融合,根据结果的性质,这些方法可以分为两组。导致密集分割的方法通常基于局部运动提示(例如,光流[8])。然而,由于两个物体的运动可以在局部相似,这些方法可以从其他信息中获益,例如长期运动提示[9]、颜色[8]或深度。第二类分割方法对问题有更全局的看法。他们使用跟踪来导出稀疏点轨迹,这些轨迹根据全局运动相似性进行分组(例如[9])。然而,由于轨迹是稀疏的,分割的结果也是如此。为了将剩余的点分配给段,必须包含附加信息(例如,颜色[9])。因此,各种分段方法[9,10]利用更密集的点轨迹[11,12]。这些轨迹是精确的,但不能保证每个像素将被分配到一个轨迹(或随后的一个段)。 在本文中,我们的目标是将一段距离视频中的所有点组合成相干运动段。除了深度(由TOF相机获得),我们还结合了长期运动信息。与[12]类似,我们从先前计算的运动矢量中得出轨迹(第2.1节)。与之前的方法不同,我们尝试为距离视频的每个像素导出轨迹(第2.2节)。在第2.3节中,我们使用一种高效的基于图的分割技术[13,8]根据轨迹的空间和运动相似性对轨迹进行分组。第3节展示了我们的算法在实验室记录的视频上的能力,并将结果与最先进的分割方法进行了比较[8]。对不同加工步骤所得结果进行了说明和讨论。

2.算法描述

在我们的工作中,我们使用SR3000 TOF摄像机。它通过发射调幅连续波信号并通过测量发射和接收信号之间的相位差来评估往返时间,从而计算距离。除了距离值外,SR3000还提供返回信号的振幅。原始振幅图像受平方反比和光照衰减的影响。由于光流约束方程是基于亮度恒定性假设,因此我们对原始振幅图像进行了校正。校正后的图像称为强度图像。我们的距离流计算(第2.1节)结合了光流,基于光强和深度。轨迹生成步骤(第2.2节)将先前估计的流场和强度作为输入。分割算法根据深度和运动相似性对轨迹进行分组(第2.3节)。下面,我们将详细讨论这些步骤。

2.1 距离流(Range Flow)

深度可以看作是空间(x,y)和时间的函数:.对时间求总导数,得出范围流约束方程[3]:

![]() (1)

(1)

其中U,V和W是流速,Zx,Zy和 是距离在空间和时间上的导数。与距离流相似,光流约束方程为:

![]() (2)

(2)

其中,Ix,Iy和 是强度在空间和时间上的导数。具体来说,我们计算距离和强度图像的导数,如[5]所述。由于SR3000中的距离和强度图像取决于场景,因此其中一个或另一个图像(即距离和强度图像之一)可能在最小二乘法解决方案中占主导地位。我们使用平均距离和强度梯度大小对距离和强度进行平均权重[5]。当在n×n邻域中应用上述约束条件时,我们得到2×

方程,其形式为Ax=0。它们的最小二乘解由下列方程给出:

![]() (3)

(3)

其中,![]() 是特征向量,

是特征向量,是

的特征值。 要计算这三个未知数,需要三个约束。对于有足够约束的区域,

矩阵的最小特征值给出了拟合质量,并可计算出全流(full flow)。当只使用深度信息时,线性结构将产生两个约束,平面结构将产生一个约束。在这两种情况下,适当的流向量(flow vector )是使用非零特征值(non-vanishing eigenvalues)的特征向量计算的[3]。

在具有多个运动的像素邻域中,距离流不能用单个值表示。因此,最小特征值不会接近于零。在高噪声环境下也是如此。因此,必须定义一个识别这些区域的度量。我们按照[3]中的描述计算每个流向量的置信值,并设置阈值。当

处的最小特征值超过

时,我们将像素的置信值及其相应的流向量设置为零。此外,我们只计算

处的迹线超过第二个阈值

的流动矢量,并排除梯度不足的区域[3]。

当使用距离和强度以及局部邻域时,不能保证可以在每个像素处计算流量。然而,为了进行运动分割,稠密的流场是必不可少的。因此,我们采用[3]中描述的正则化过程。作为对[3]的贡献,我们使用权重和遮罩来避免在深度不连续处平滑。两者都是根据深度相似性计算得出的。

2.2. 流轨迹(Flow Trajectori)

研究表明,长期运动分析有利于分割[9,10]。与局部运动相反,例如距离流, 轨迹考虑了点的整个运动,并且能够消除局部类似运动的歧义(见图1)。我们通过应用类似于[12]的基于流矢量的跟踪器来获得密集点轨迹。与[12]相反,我们不删除难以跟踪的点,而是尝试覆盖整个视频。

由第一帧开始,我们通过跟踪每一个像素点的的运动向量

找到其在下一帧的新位置

来构建轨迹。当到达没有有效运动信息的像素(离开场景,被遮挡)时,轨迹结束。我们通过流发散[11]和向前流和向后流的容忍一致性检查[12]来检测遮挡。由于这些检查不考虑不匹配或阻挡与背景运动类似的物体,我们还观察到一个点的强度随时间的变化[11]。为了给每个像素分配一条轨迹,每当一个像素没有分配给来自前一帧的轨迹时,我们就开始一条新的轨迹(例如,由于去遮挡,参见图1)。

强度图像(顶部)和水平移动(底部)。局部相似运动(第1、2帧)可以通过长期运动(第1-3帧)消除歧义。轨迹停止在被遮挡处(点),并在无遮挡处(圆)初始化。

2.3 运动分割

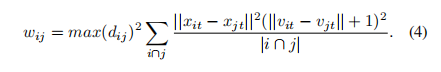

完成轨迹生成步骤后,每个像素都属于各自的单一轨迹,同一轨迹上的所有像素都属于同一目标。我们的目标是将这些轨迹分组到时空片段中,这些时空片段对应于一起移动的对象或对象组。为此,我们定义了一个两两相似度度量,它考虑了共同运动(共同命运定律[7])和空间接近(接近定律[7]):

这里,在两个轨迹都存在的帧中,我们比较两个空间上相邻的轨迹i和j,即i∩j. |i∩j|是轨迹的公共帧数。 乘积,即最大速度的平方与最大空间距离平方的乘积,由时间对应的轨迹i和j的空间位置

与它们速度值

之间的平均 距离加权。因此,只有在每个公共帧中具有相似运动的空间上邻近轨迹才会产生较小的值。注意,所描述的措施与[9,10]中使用 的措施相似。然而,我们的空间差异包括深度成分。与[9,10]相反,我们将速度差增加1。因此,我们不忽略具有相同速度的像素点的空间距离。

在定义了相似性度量之后,下一步就是对轨迹进行相应的分组。为此,我们使用了[13,8]中提出的一种有效的基于图的分割技术。我们将分割算法应用于包含多个像素的轨迹,从而获得有效的运动信息。然后,我们合并短(一个像素)轨迹和小于给定最小段大小[8]的一组轨迹。上述过程导致过度分割(见图2,顶部)。

正如[8]所指出的那样,应用上述分割算法可以得到更为健壮的结果。因此,我们迭代地重新分段先前合并迭代的结果。为此,我们定义了新的边权(edge weights),它表示了两组轨道 i 和 j 在其公共时间窗口中的相似性。这个权重基于每一帧的流直方图的

距离[8]

∈ [0,1]和每一帧平均深度的欧氏距离

∈[0,1]:

重复应用[13]中描述的分段过程[8]直到达到所需的泛化水平(参见图2,底部)。

视频序列的三个示例帧的分割结果。 基于运动和深度相似性的点轨迹过分割(顶层行)及迭代区域合并后的对应帧(底层行)

3.实验结果

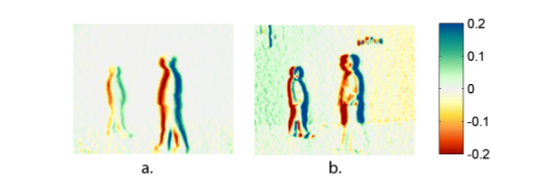

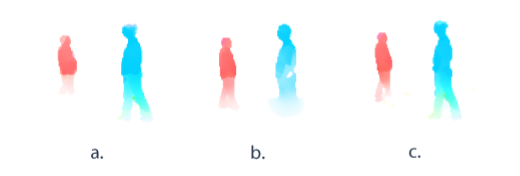

据我们所知,没有公开的具有运动和分割真实性的TOF数据集,因此,我们对我们使用SR3000 TOF摄像机拍摄的视频进行定性分析和比较。图3显示出了视频的九个帧的强度(第一行)、深度(第二行)和估计流矢量(第三行)。 可以看出,这些人的运动是可以很好的由我们的算法捕获。 然而,当距离梯度和强度梯度都减小并且信噪比低时,不能捕获运动。这在图4中身体下部可以看到这种情况。图4显示了水平方向的距离和强度图像的导数,进一步显示了融合深度和强度信息的优势。在前面的人的下部的强度梯度减小。深度梯度朝着背景中人的下方逐渐减小。因此,当仅使用距离流或光学流时,由于流向量的可确定性较低,无法捕捉这些区域的移动(见图5,a.,b)。在这些区域,深度和强度的融合增加了流向量的可确定性,并产生更可靠的流动向量(见图5,c)。

a:深度图像水平方向上的导数(米) 和 b:强度图像强度图像。 强度导数的平均值被缩放以匹配深度导数的平均值。

a:根据深度图像计算的流向量、b:根据强度图像计算的流向量c:根据深度和强度图像计算的流向量 色调编码方向和饱和度大小。

我们的结果表明在流场的静止区域没有噪音(见图3)。其主要原因是两个阈值。更准确地说,仅计算具有有效梯度的区域的流向量(见图6.a)。 阈值 将主要噪声区域排除,否则可能导致错误的流向量。图6.b给出了一个选择了低

值 的示例,这会导致不准确的流场。另一个重要因素是使用基于阈值τ1的置信度值,这决定了最小二乘解的质量。它检测并排除可能导致流向量不准确的多个运动和遮挡。此外,在正规化步骤之前,将中值过滤器应用到流场中可以提高结果质量。我们还注意到,当使用迭代加权的最小二乘法而不是普通最小二乘法解时,结果有所改善(方程(3))。基于残差的迭代重新加权观测值可减少异常值的影响。该解决方案增加了运动估计的鲁棒性,并产生更平滑的流向量。

图2和图3表明获得的分割是暂时一致的。对象遵循先前估计的流向量(例如图3第三行)。事实上,导出的轨迹以及分割强烈依赖于流向量和遮挡检测。图3给出了后一种情况的示例。在第15帧中,未正确检测到的遮挡物会导致不正确的轨迹,这些轨迹在人体附近作为孤立点可见(浅灰色)。作为额外的实验和比较,图7显示了将最先进的分割方法[8]应用于我们的测试视频得到的结果(见图3)。这种分割技术最初是为分割传统视频而开发的。它是基于局部颜色和局部运动的相似性,导致密集的分割。在本实验中,我们使用[8]来分割深度(见图7,a)和强度(见图7,b)。可以看出(图7)TOF测量中的畸变会影响分割结果。这在强度分割中尤其明显,在强度分割中,像素由于噪声而被错误分组。这种效果在分割结果中不可见(见图3)。主要原因是我们的算法与[8]的概念差异。与[8]相比,我们的算法在算法的早期阶段集成了长期运动信息,即根据共同运动和空间邻近度对轨迹进行分组。这些额外的运动信息可以补偿距离视频中的噪声。

4.结论

本文提出了一种基于TOF摄像机的视频序列运动分割框架。我们利用距离流和光学流的融合提取运动信息。我们表明,距离流估计的置信度测量有助于区分可靠的流向量和噪声。这在信噪比较低的区域尤其有利。作为第二个贡献,我们推导了相干运动的长期点轨迹和群轨迹。未来的工作将集中在更先进的技术融合范围和强度数据,基于因素,如纹理,几何和噪音水平。

5.参考文献:

这篇关于TOF摄像机视频中的运动分割(MOTION SEGMENTATION IN VIDEOS FROM TIME OF FLIGHT CAMERAS)的文章就介绍到这儿,希望我们推荐的文章对编程师们有所帮助!