本文主要是介绍2022最新版-李宏毅机器学习深度学习课程-P26 Recurrent Neural Network,希望对大家解决编程问题提供一定的参考价值,需要的开发者们随着小编来一起学习吧!

RNN

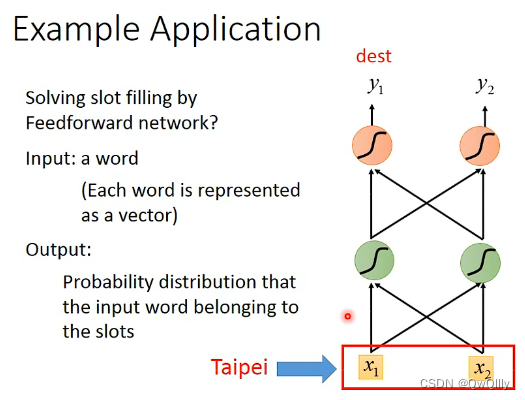

应用场景:填满信息

把每个单词表示成一个向量的方法:独热向量

还有其他方法,比如:Word hashing 单词哈希

- 输入:单词

- 输出:该单词属于哪一类的概率分布

由于输入是文字序列,这就产生了一个问题:

是到达还是离开?

隐藏层的输出会被存储在内存中,内存能被视为另一个输入。

改变序列的顺序会改变输出。

RNN的网络结构

目前已提出的两个网络及区别

双向RNN

它与传统的循环神经网络(RNN)相比有一个重要的区别:它在每个时间步上包含两个方向的循环连接,一个从过去到未来(正向),另一个从未来到过去(逆向)。

在双向RNN中,每个时间步的隐藏状态是由两部分组成,一部分来自正向传播,另一部分来自逆向传播。这使得双向RNN能够捕捉到序列中的上下文信息,不仅考虑了过去的信息还考虑了未来的信息。这对于很多自然语言处理任务,如情感分析、命名实体识别、语言建模等非常有用,因为理解一个词语或标记通常需要考虑它周围的上下文。

在训练双向RNN时,通常会使用标准的反向传播算法,但是需要在正向和逆向传播中分别计算梯度,然后将它们合并以更新网络参数。这使得双向RNN的训练稍微复杂一些,但在实际应用中,往往能够提供更好的性能。

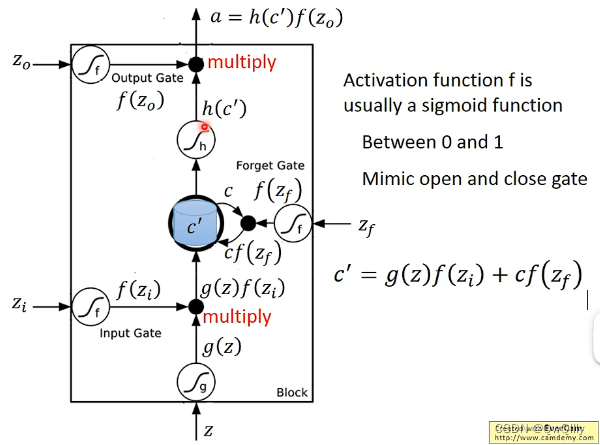

RNN的经典变形:LSTM

四个输入,1个输出,三个门

网络结构

三个门都是1:打开,0:关闭

注意这与遗忘门的名字是反着的,但就是这么奇怪~

操作例子

原本的网络结构

参数是原本的四倍

结构简图

一个单元

多个单元

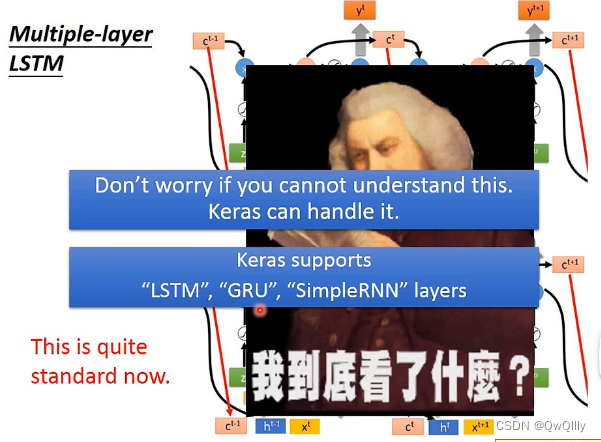

多层的LSTM

Keras支持三个RNN:LSTM GRU SimpleRNN

这篇关于2022最新版-李宏毅机器学习深度学习课程-P26 Recurrent Neural Network的文章就介绍到这儿,希望我们推荐的文章对编程师们有所帮助!