本文主要是介绍Open X-Embodiment Robotic Learning Datasets and RT-X Models,希望对大家解决编程问题提供一定的参考价值,需要的开发者们随着小编来一起学习吧!

文章目录

- 简介

- 论文链接

- 项目链接

- Reference

简介

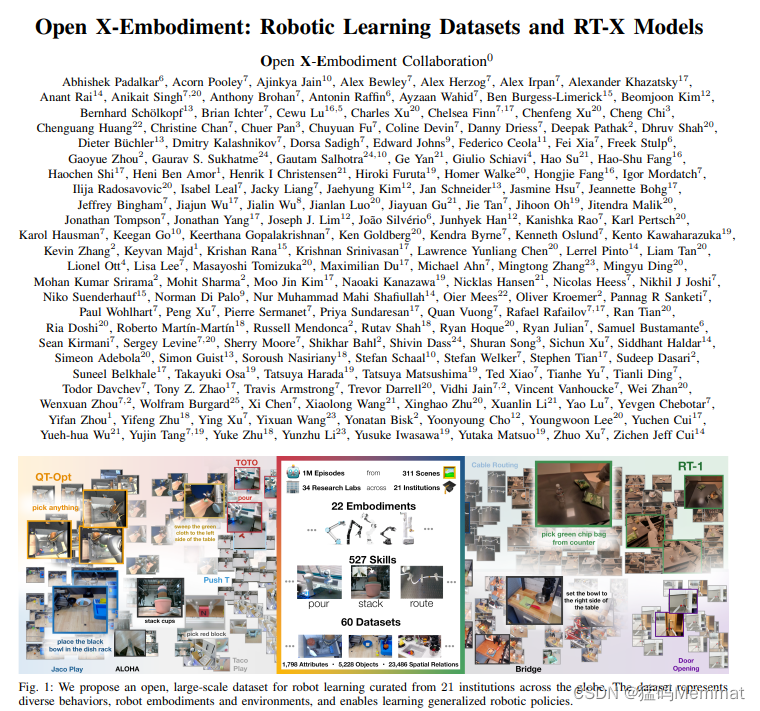

为什么机器人技术远远落后于 NLP、视觉和其他 AI 领域?除其他困难外,数据短缺是罪魁祸首。谷歌 DeepMind 联合其他机构推出了 Open X-Embodiment 数据集,并训练出了能力更强的 RT-X 模型。

DeepMind 在过去一段时间汇集了来自 22 种不同机器人类型的数据,以创建 Open X-Embodiment 数据集,然后在之前的模型(RT-1 和 RT-2)的基础上,训练出了能力更强的 RT-X(分别为 RT-1-X 和 RT-2-X)。

他们在五个不同的研究实验室测试了 RT-1-X 模型,结果显示,与针对每个机器人独立开发的方法相比,新方法在五种不同的常用机器人中平均成功率提高了 50%。他们还表明,在上述数据集上训练的 RT-2-X 在现实世界机器人技能上的表现提高了 2 倍,而且,通过学习新数据,RT-2-X 掌握了很多新技能。这项工作表明,在来自多个机器人类型数据上训练的单个模型比在来自单个机器人类型数据上训练的模型在多个机器人上的性能要好得多。

目前,Open X-Embodiment 数据集和 RT-1-X 模型检查点已经对广泛的研究社区开放。

论文链接

https://robotics-transformer-x.github.io/paper.pdf

项目链接

https://robotics-transformer-x.github.io/

Reference

https://www.deepmind.com/blog/scaling-up-learning-across-many-different-robot-types

这篇关于Open X-Embodiment Robotic Learning Datasets and RT-X Models的文章就介绍到这儿,希望我们推荐的文章对编程师们有所帮助!