本文主要是介绍ICCV2017《Deep Direct Regression for Multi-Oriented Scene Text Detection》阅读笔记,希望对大家解决编程问题提供一定的参考价值,需要的开发者们随着小编来一起学习吧!

前言

本文是对《Deep Direct Regression for Multi-Oriented Scene Text Detection》论文的简要介绍和细节分析,由于作者没有放出源码,所以本文没有源码解读的部分,有关的复现工作将在下篇博客介绍。

注:编者水平有限,如有谬误,欢迎指正。若要转载,请注明出处,谢谢。

联系方式:

邮箱:yue_zhan@yahoo.com

QQ:1156356625

Definition

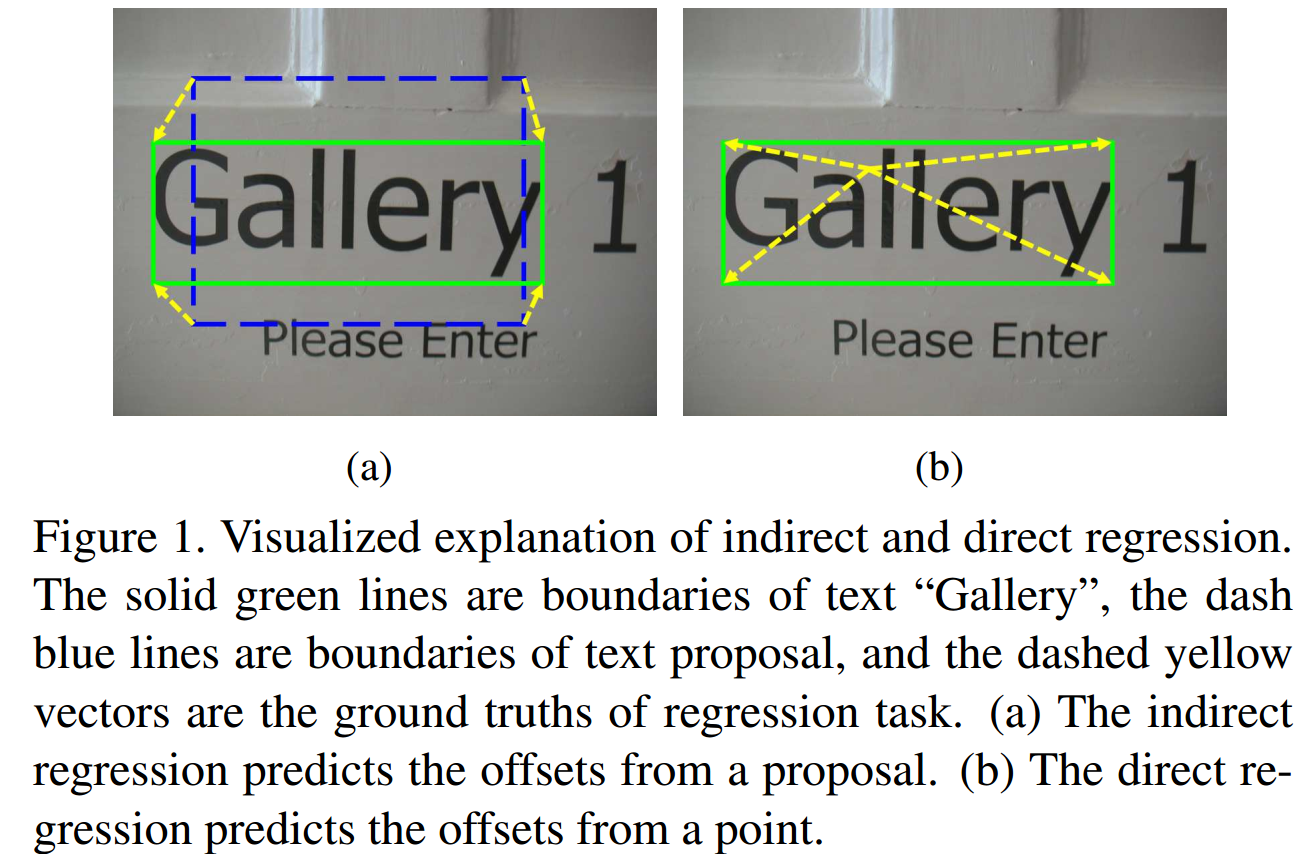

在论文的摘要和介绍部分,作者重点对现有的目标检测网络进行了定义。这个定义是文章的核心内容,也是后续模型设计的背景。作者认为,对于现有的目标检测网络,可以分为间接回归(Indirect Regression)和直接回归(Direct Regression)两种类型。

间接回归:大多数基于CNN的目标检测模型像RCNN系列、SSD、Multi-Box等,模型的回归任务通过预测proposal和ground truth的偏置完成。

直接回归:跳过proposal部分,直接对某点输出对目标坐标或形状的预测,可以以相对该点的偏置形式输出。

基于间接回归的目标检测模型,即使是Faster-RCNN和SSD这样表现很好的网络,在多角度(Multi-oriented)文本检测任务中也表现得很差。 作者认为,主要原因有如下几点:

- 缺少鲁棒性好的方法生成词级或者行级的proposal,大部分方法都只能生成字符级别的。

- 所有类似anchor的结构,在文本倾斜、过长、间隔不定等场景下,都无法得到一个合适的anchor覆盖目标。

- 自适应的anchor生成方法效率低,速度慢。

至于直接回归,本论文是首个基于此提出文本检测领域本文的模型,从实验结果看在当时该论文确实贡献很大。下图为两种回归的比较示意图:

Proposed Methodology

- 模型结构

论文中,目标检测被分解成分类任务和回归任务,二者构成一个多任务模型。模型设计中参考了FPN的思想,对不同深度的feature map进行跨层连接,以提高模型对不同大小物体的检测效果。在模型尾端的卷积层后通过两个分支:分类和定位,得到两类任务的loss,二者加权作为模型总loss。模型细节在模型分析与代码复现部分阐述,这里只作简要说明。详情结构:

- Classification task

本文的模型其实并没有做文本分类部分,所谓的分类其实是指分割。分类任务的output是 S 4 × S 4 \frac{S}{4} \times \frac{S}{4} 4S×4S,可以等价为对原图的降采样。损失函数的设计为

L c l s = 1 S 2 ∑ i ∈ L c l s m a x ( 0 , s i g n ( 0.5 − y i ∗ ) ⋅ ( y ^ i − y i ∗ ) ) 2 (1) L_{cls} =\frac{1}{S^2}\sum_{i\in{L_{cls}}}max(0,sign(0.5-y_{i}^{*})\cdot(\hat y_i-y_{i}^{*}))^2\tag{1} Lcls=

这篇关于ICCV2017《Deep Direct Regression for Multi-Oriented Scene Text Detection》阅读笔记的文章就介绍到这儿,希望我们推荐的文章对编程师们有所帮助!