本文主要是介绍【YOLO 系列】基于YOLO V8的学生上课行为检测系统【python源码+Pyqt5界面+数据集+训练代码】,希望对大家解决编程问题提供一定的参考价值,需要的开发者们随着小编来一起学习吧!

前言

在现代教育环境中,学生上课行为的监测对于提升教学质量和学生学习效率具有重要意义。然而,传统的人工观察方法不仅效率低下,而且难以保证客观性和准确性。为了解决这一问题,我们启动了这个项目,目的是利用YOLOV8这一先进的深度学习技术,开发一个自动化的学生上课行为检测系统。

通过对上课行为数据集进行深入分析和标注,我们训练了YOLOV8模型,使其能够精确识别学生在课堂上的各种行为状态。这一系统能够实时监控并分析学生的行为,为教师提供即时反馈,帮助他们优化教学方法,提高课堂互动质量。

基于此项目,设计了一个使用Pyqt5库来搭建页面展示系统。本系统支持的功能包括训练模型的导入、初始化;置信度与IOU阈值的调节、图像上传、检测、可视化结果展示、结果导出与结束检测;视频的上传、检测、可视化结果展示、结果导出与结束检测;摄像头的上传、检测、可视化结果展示与结束检测;已检测目标信息列表、位置信息;以及推理用时。本博文提供了完整的Python代码和使用教程,适合新入门的朋友参考,完整代码资源文件请转至文末的下载链接。

优势

-

高效率:自动化的监测系统大大减少了人工观察的时间和劳动成本,提高了监测效率。

-

高准确性:YOLOV8模型在目标检测领域的先进性确保了行为识别的高准确度。

-

实时反馈:系统能够提供实时的学生行为反馈,使教师能够及时调整教学策略。

-

多场景适用:无论是传统教室还是在线教学环境,该系统都能够灵活应用。

-

数据驱动:系统收集的数据可以用于进一步分析,为教育决策提供科学依据。

应用场景

-

课堂教学:教师可以利用该系统实时监控学生上课状态,及时调整教学方法,提高课堂参与度。

-

学生评估:系统可以作为一个评估工具,帮助教师客观评价学生的课堂表现和学习态度。

-

教育研究:研究人员可以利用系统收集的数据,进行教育心理学、教学方法等方面的研究。

-

个性化教学:根据学生的上课行为数据,教师可以为学生提供更加个性化的教学内容和辅导。

-

远程教学:在远程教学中,该系统可以帮助教师远程监控学生的上课状态,确保教学质量。

-

行为矫正:系统可以辅助教师识别需要特别关注的学生,制定相应的行为矫正计划。

一、软件核心功能介绍及效果演示

软件主要功能

-

支持

图片、图片批量、视频及摄像头进行检测,同时摄像头可支持内置摄像头和外设摄像头; -

可对

检测结果进行单独分析,并且显示单个检测物体的坐标、置信度等; -

界面可实时显示

目标位置、检测结果、检测时间、置信度、检测结果回滚等信息; -

支持

图片、视频及摄像头的结果保存,将检测结果保持为excel文件;

界面参数设置说明

-

标签4 摄像头源/相机/网络源; -

标签5 交并比阈值:目标检测时的iou参数,只有目标检测框的交并比大于该值,结果才会显示; -

标签6 置信度阈值:目标检测时的conf参数,只有检测出的目标置信度大于该值,结果才会显示; -

标签7 显卡选择:在进行推理时是否使用显卡,默认勾选(使用显卡); -

标签8 半精度选择:启用半精度(FP16)推理,可加快支持的 GPU 上的模型推理速度,同时将对精度的影响降至最低,默认不勾选(不适应半精度); -

标签9 图片推理尺寸: 在推理时将推理图片固定的尺寸; -

标签10 数据集的配置文件:数据集在训练时的配置文件(.yaml); -

标签11 训练好的模型:最终要进行推理的模型,一般选择最优的一个模型; -

标签12 类别名:该项目的所有类别,可以方便在后续查看某一个类别。

视频演示

StudentClassroomBehavior Detection_哔哩哔哩_bilibili

图片检测演示

-

点击

打开图片按钮,选择需要检测的图片,或者点击打开文件夹按钮,选择需要批量检测图片所在的文件夹,操作演示如下: -

点击表格中的指定行,界面会显示该行表格所写的信息内容。

视频检测演示

-

点击

视频按钮图标,打开选择需要检测的视频,在点击开始运行会自动显示检测结果。再次点击停止按钮,会停止检测视频。 -

点击表格中的指定行,界面会显示该行表格所写的信息内容。

摄像头检测演示

-

在

选择相机源中输入需要检测的摄像头(可以是电脑自带摄像头,也可以是外接摄像头,视频流等方式),然后点击摄像头图标来固定选择的推理流方式,最后在点击开始运行即可开始检测,当点击停止运行时则关闭摄像头检测。 -

点击表格中的指定行,界面会显示该行表格所写的信息内容。

检测结果保存

点击导出数据按钮后,会将当前选择的图片【含批量图片】、视频或者摄像头的检测结果进行保存为excel文档,结果会存储在output目录下。

二、环境搭建

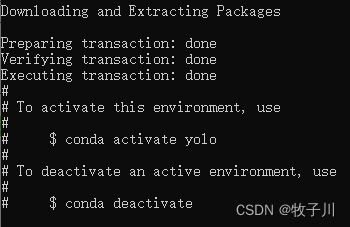

创建专属环境

conda create -n yolo python==3.8

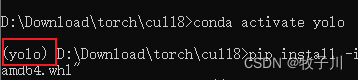

激活专属环境

conda activate yolo

安装torch-GPU库

pip install -i https://pypi.tuna.tsinghua.edu.cn/simple "torch-2.0.1+cu118-cp38-cp38-win_amd64.whl"

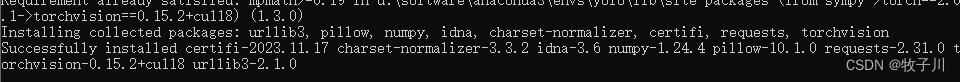

安装torchvision-GPU库

pip install -i https://pypi.tuna.tsinghua.edu.cn/simple "torchvision-0.15.2+cu118-cp38-cp38-win_amd64.whl"

安装ultralytics库

pip install ultralytics -i https://pypi.tuna.tsinghua.edu.cn/simple

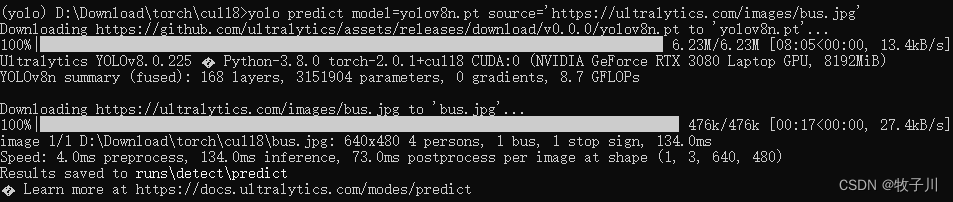

测试环境

yolo predict model=yolov8n.pt source='https://ultralytics.com/images/bus.jpg'

此时就表明环境安装成功!!!

安装图形化界面库 pyqt5

pip install pyqt5 -i https://pypi.tuna.tsinghua.edu.cn/simple

pip install pyqt5-tools -i https://pypi.tuna.tsinghua.edu.cn/simple三、算法原理

YOLOv8是一种前沿的深度学习技术,它基于先前YOLO版本在目标检测任务上的成功,进一步提升了性能和灵活性,在精度和速度方面都具有尖端性能。在之前YOLO 版本的基础上,YOLOv8 引入了新的功能和优化,使其成为广泛应用中各种物体检测任务的理想选择。主要的创新点包括一个新的骨干网络、一个新的 Ancher-Free 检测头和一个新的损失函数,可以在从 CPU 到 GPU 的各种硬件平台上运行。

YOLOv8目标检测算法具有如下的几点优势:

(1)更友好的安装/运行方式;

(2)速度更快、准确率更高;

(3)新的backbone,将YOLOv5中的C3更换为C2F;

(4)YOLO系列第一次使用anchor-free;

(5)新的损失函数。

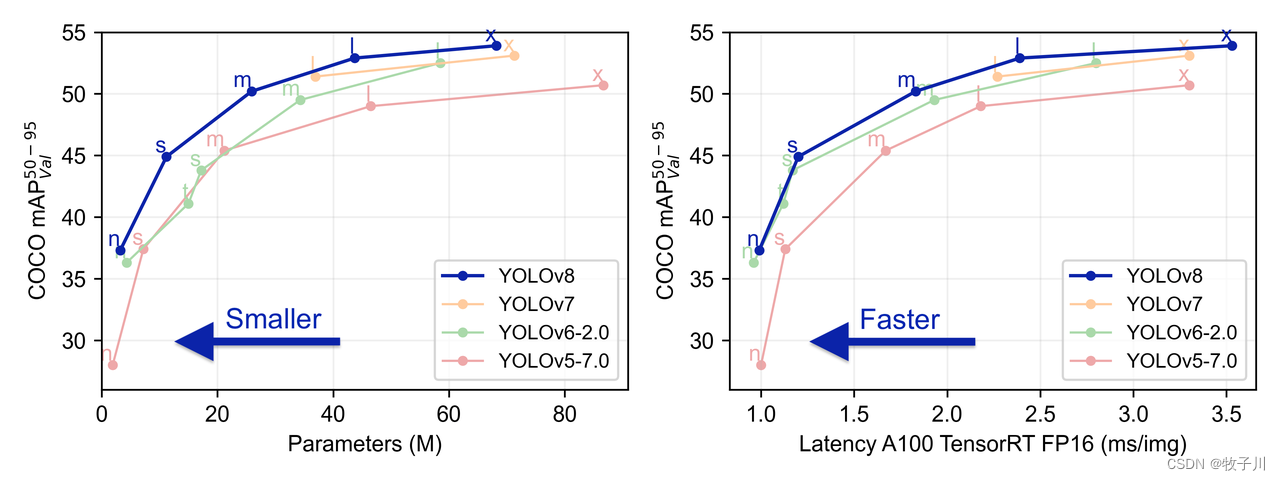

YOLO各版本性能对比

网络结构

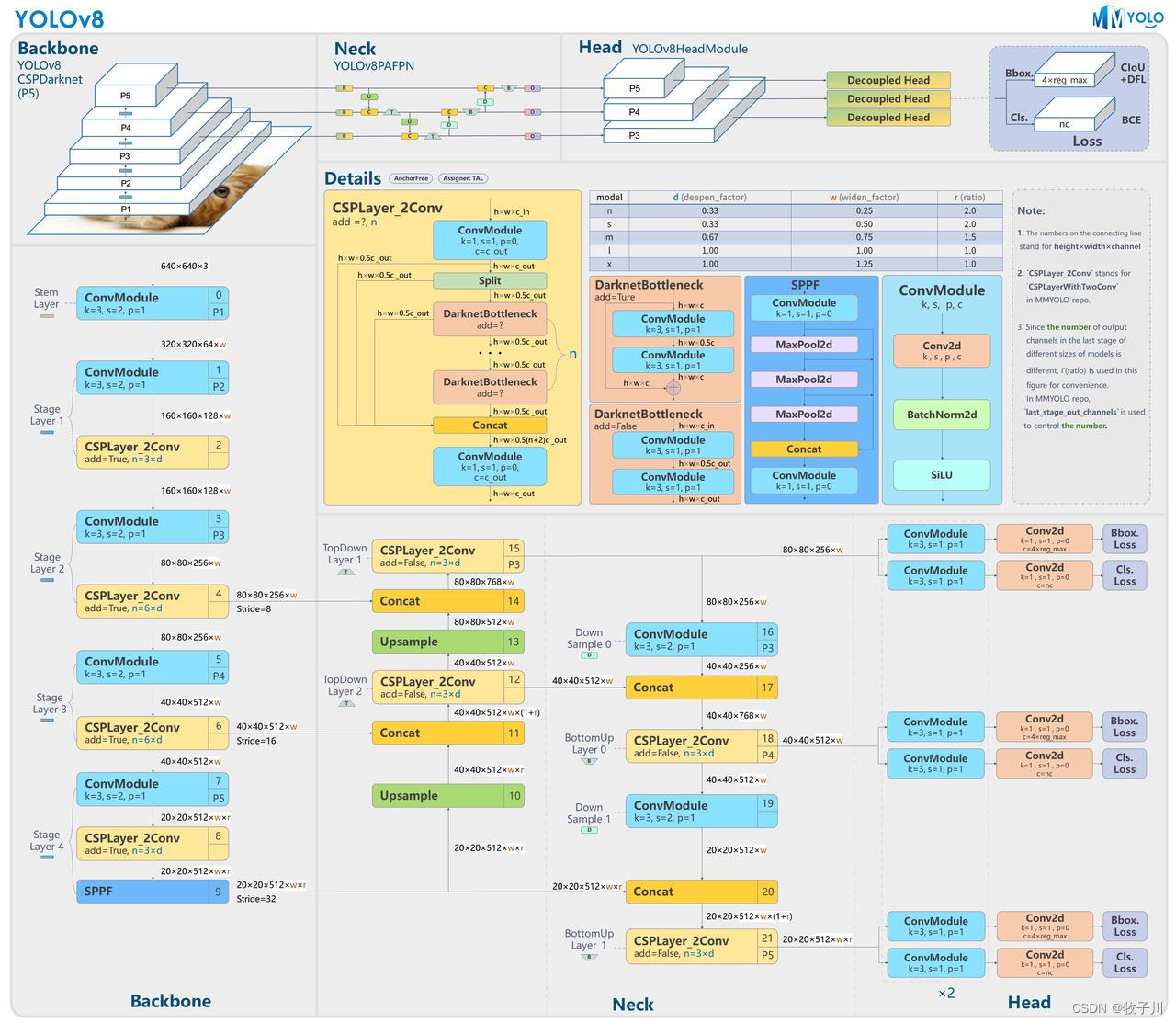

YOLOv8模型的整体结构如下图所示:

YOLOv8与YOLOv5模型最明显的差异是使用C2F模块替换了原来的C3模块;另外Head 部分变化最大,从原先的耦合头变成了解耦头,并且从 YOLOv5 的 Anchor-Based 变成了 Anchor-Free。

YOLOv8的网络架构包含了多个关键组件,这些组件共同工作以实现快速而准确的目标检测。首先是其创新的特征提取网络(Backbone),YOLOv8的Backbone采用了最新的网络设计理念,通过深层次的特征融合和精细的特征提取策略来增强对目标的识别能力。这一策略的成功关键在于其特征提取器能够充分捕获目标的细微特征,同时保持计算效率。

YOLOv8在训练策略上也进行了优化。与YOLOv7相比,YOLOv8采用了SPFF(Spatial Pyramid Fusion Fast)策略,该策略通过高效的多尺度特征融合提高了模型对不同大小目标的检测能力。此外,YOLOv8在训练过程中引入了一种名为Task Aligned Assigner的新技术,这种技术能够更精准地将预测框与真实目标对齐,从而提高检测的准确率。

在损失函数的设计上,YOLOv8进行了创新,采用了JFL(Joint Family Losses),这是一种集成了多个损失函数的复合损失函数,能够同时优化目标检测的多个方面。这些损失函数包括用于提升模型对目标位置和大小预测准确性的CIOU Loss,以及优化分类准确性的分类损失函数。JFL的设计允许YOLOv8更全面地考虑检测任务中的不同需求,通过协调各种损失来提升总体的性能。

YOLOv8的原理不仅在于其创新的技术点,更在于这些技术如何被综合应用于解决实际的目标检测问题。通过其精心设计的网络架构、高效的训练策略以及综合的损失函数设计,YOLOv8实现了在保持实时性的同时,提高了在复杂场景下的检测准确率。这些改进使得YOLOv8成为了一个强大的工具,适用于从自动驾驶到智能视频监控等多种应用场景。

四、模型的训练、评估与推理

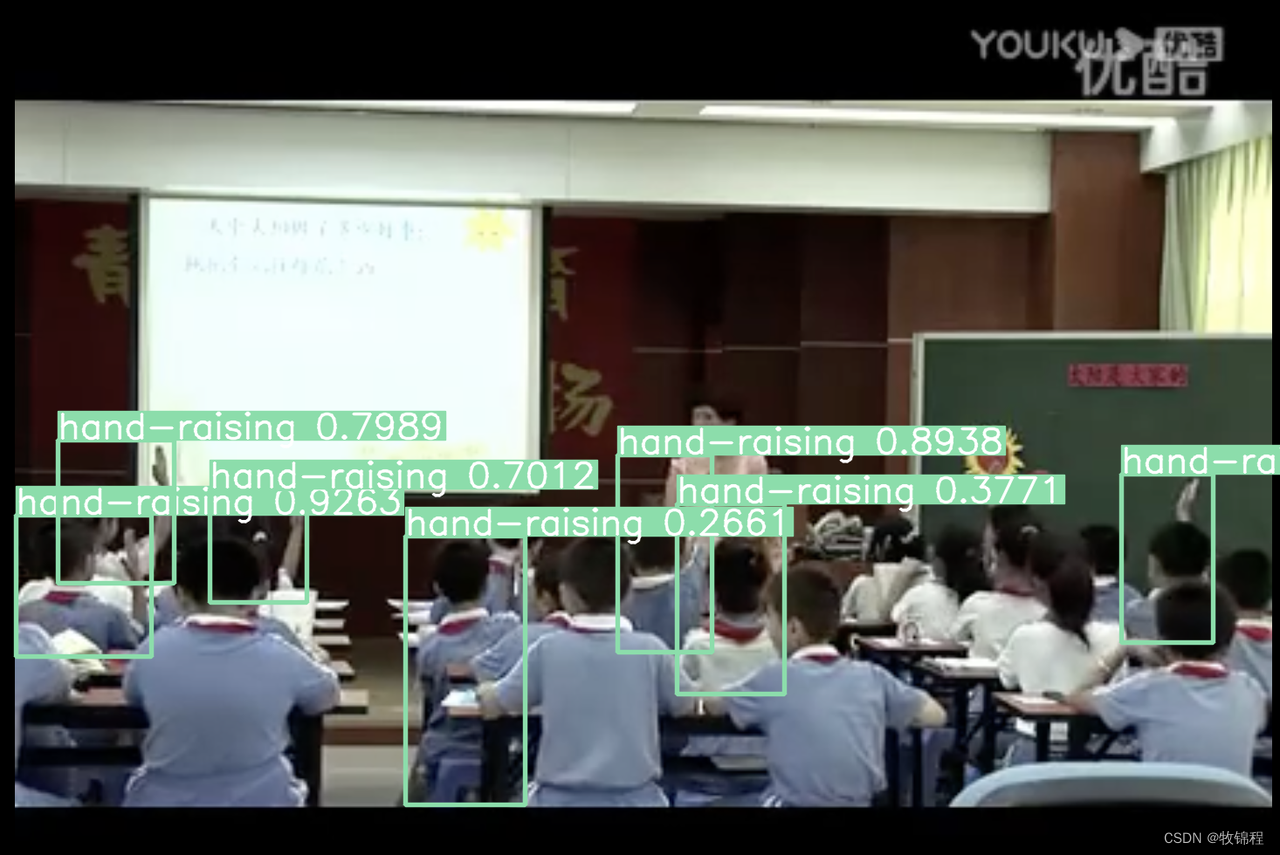

数据集准备

本项目使用的是检测学生课堂行为的数据集,名为 SCB-dataset(Student Classroom Behavior dataset)。

SCB-dataset 的特点和挑战包括:

-

教室是人口密集的环境,多个主题同时进行不同的动作。

-

举手行为与其他行为类别在视觉上有很高的相似性,这给检测任务带来了挑战。

-

数据集中的图像是从不同拍摄角度捕获的,包括正面、侧面和背面视图,这对视觉表现有显著影响。

-

教室环境和座位安排可能因课程而异,增加了检测和识别举手行为的复杂性。

-

学生在不同的学习阶段,举手行为可能有很大差异。

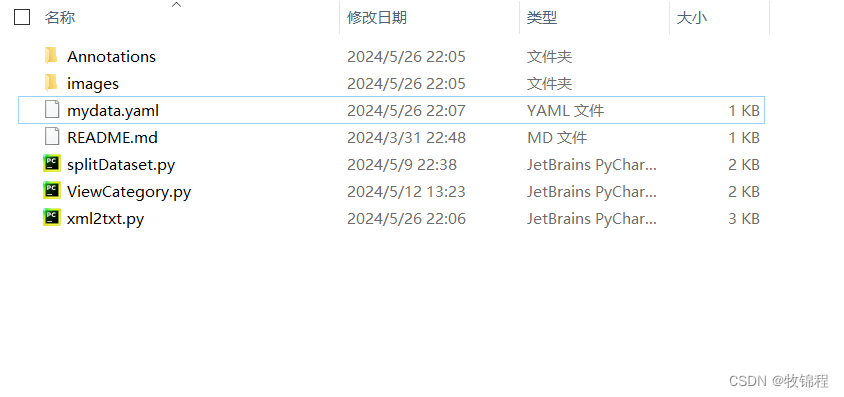

图片数据集的存放格式如下:

下载数据集后,请将图片数据放在images文件夹内,标注数据放在Annotations文件夹内,然后运行下述代码:

-

运行splitDataset.py,用于划分数据集;

-

运行xml2txt.py,用于得到训练标注文件;

-

运行ViewCategory.py,用于查看一共有那些类别;

-

mydata.yaml,用于填写模型训练的数据配置文件。

注意:在xml2txt.py和mydata.yaml中的类别名称的顺序要一致。

模型训练

数据准备完成后,通过调用train.py文件进行模型训练,epochs参数用于调整训练的轮数,代码如下:

yolo detect train data=./VOCData/myvoc.yaml model=yolov8n.yaml pretrained=./weights/yolov8n.pt epochs=100 imgsz=640from ultralytics import YOLO# build from YAML and transfer weights

model = YOLO('yolov8n.yaml').load('./weights/yolov8n.pt')# Train the model

model.train(data='./VOCData/mydata.yaml', epochs=100, imgsz=640)

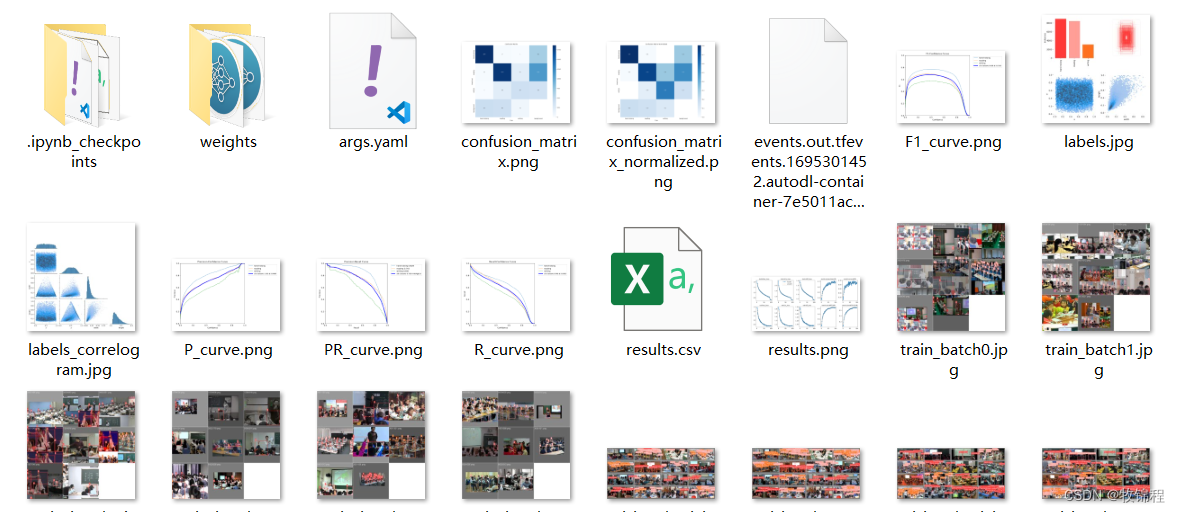

训练结果分析

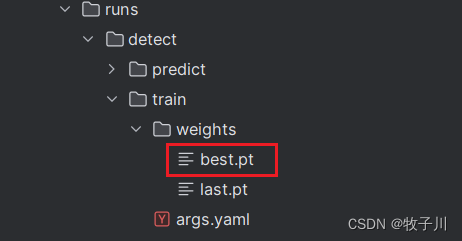

YOLOv8在训练结束后,可以在runs/目录下找到训练过程及结果文件,如下所示:、

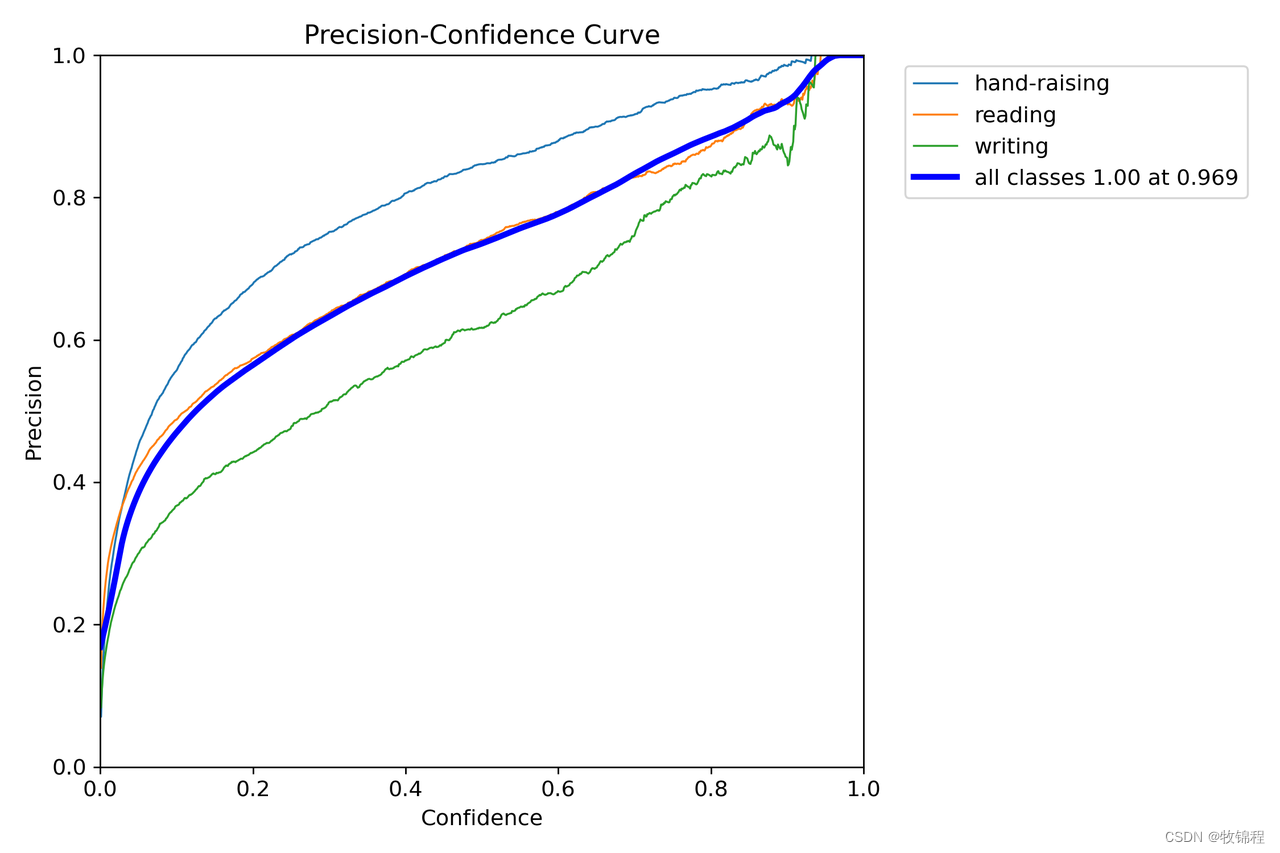

P_curve.png

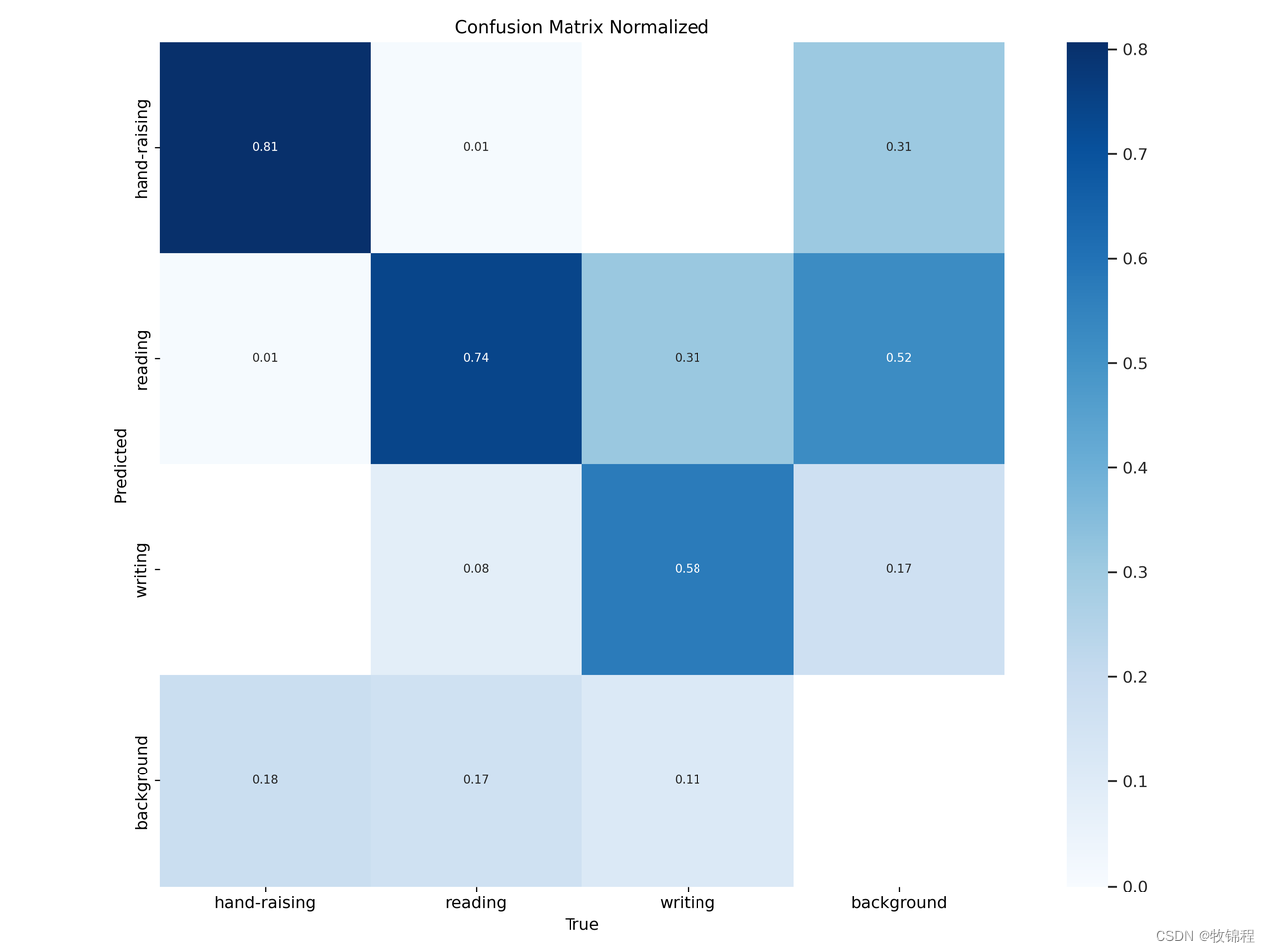

confusion_matrix_normalized.png

训练 batch

验证 batch

模型推理

模型训练完成后,可以得到一个最佳的训练结果模型best.pt文件,在runs/trian/weights目录下。我们通过使用该文件进行后续的推理检测。

图片检测代码如下:

yolo detect predict model=./runs/detect/train/weights/best.pt source=./img save=True device=0from ultralytics import YOLO# Load a model

model = YOLO('./runs/detect/train/weights/best.pt')# Run batched inference on a list of images

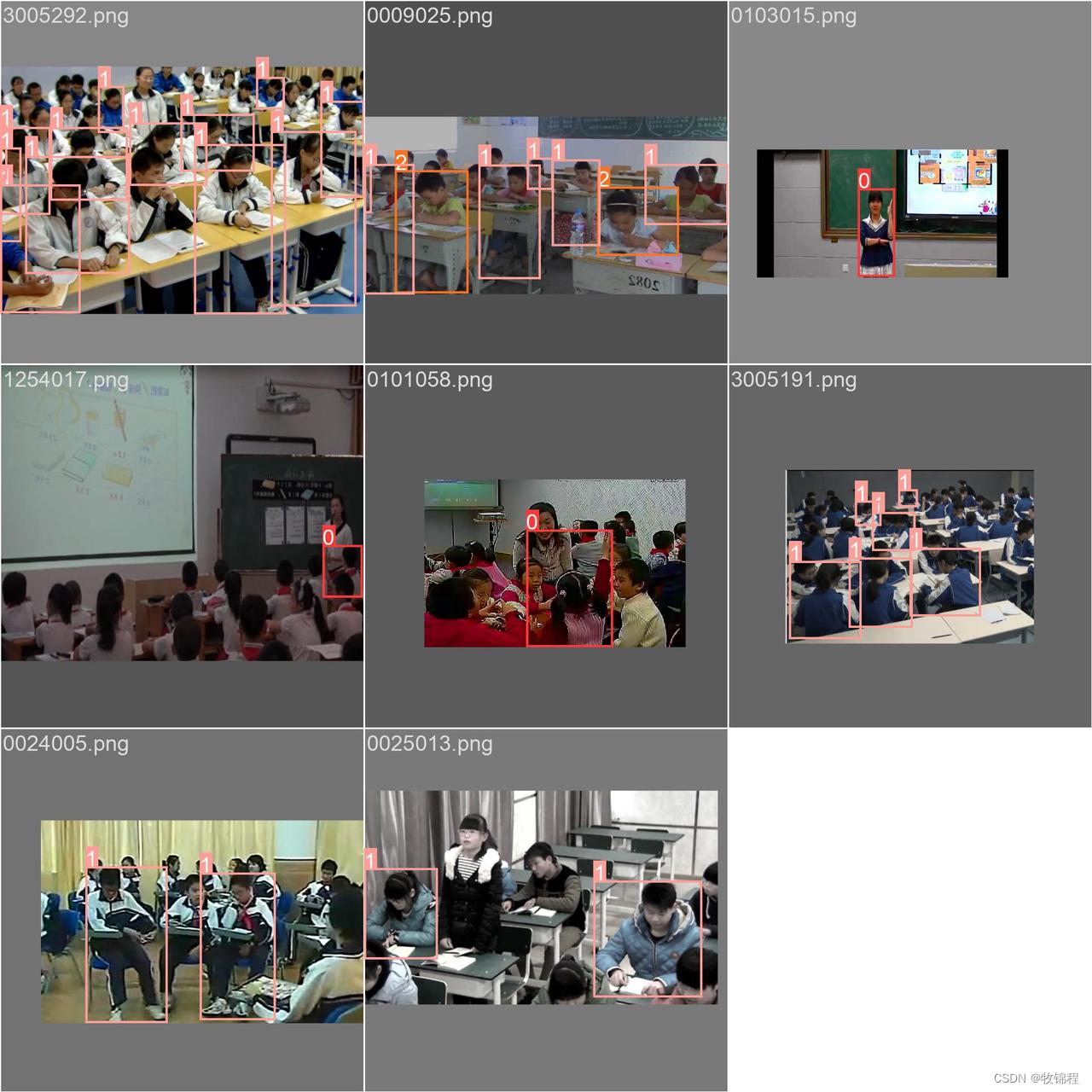

model.predict("./img", imgsz=640, save=True, device=0)执行上述代码后,会将执行的结果直接标注在图片上,结果如下:

关于该系统涉及到的完整源码、UI界面代码、数据集、训练代码、测试图片视频等相关文件,均已打包上传,感兴趣的小伙伴可以通过下载链接自行获取。

五、获取方式

本文涉及到的完整全部程序文件:包括

python源码、数据集、训练好的结果文件、训练代码、UI源码、测试图片视频等(见下图),获取方式见文末:

注意:该代码基于Python3.8开发,运行界面的主程序为

GUI.py,其他测试脚本说明见上图。为确保程序顺利运行,请按照requirements.txt配置软件运行所需环境。

点击链接直接打开:https://m.tb.cn/h.gda39fK?tk=H3OGWFLGArl CA6496

六、链接作者

欢迎关注我的公众号:@AI算法与电子竞赛

硬性的标准其实限制不了无限可能的我们,所以啊!少年们加油吧!

这篇关于【YOLO 系列】基于YOLO V8的学生上课行为检测系统【python源码+Pyqt5界面+数据集+训练代码】的文章就介绍到这儿,希望我们推荐的文章对编程师们有所帮助!