6b专题

关于springboot对接chatglm3-6b大模型的尝试

之前我们通过阿里提供的cloud ai对接了通义千问。cloud ai对接通义千问 那么接下来我们尝试一些别的模型看一下,其实这个文章主要是表达一种对接方式,其他的都大同小异。都可以依此方法进行处理。 一、明确模型参数 本次我们对接的理论支持来自于阿里云提供的文档。阿里云大3-6b模型文档 我们看到他其实支持多种调用方式,包括sdk和http,我本人是不喜欢sdk的,因为会有冲突或者版本之类的

chatglm3-6b下载时,需要下载哪些文件

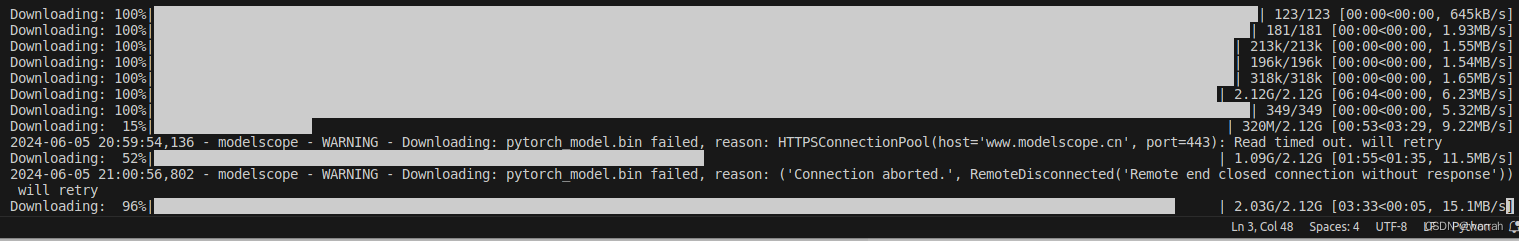

在huggingface或modelscope上下载chatglm3-6b时,会发现有两种可执行文件,一种是.bin,一种是.safetensors,在使用的时候你如果直接用git命令git clone https://www.modelscope.cn/ZhipuAI/chatglm3-6b.git直接下载,你会发现它会把所有的文件都下载下来。 因为文件很大,就很占用硬盘空间。所以当你使用.

ModuleNotFoundError: No module named ‘transformers_modules.chatglm-6b-v1‘

ModuleNotFoundError: No module named 'transformers_modules.chatglm-6b-v1' 欢迎来到英杰社区https://bbs.csdn.net/topics/617804998 欢迎来到我的主页,我是博主英杰,211科班出身,就职于医疗科技公司,

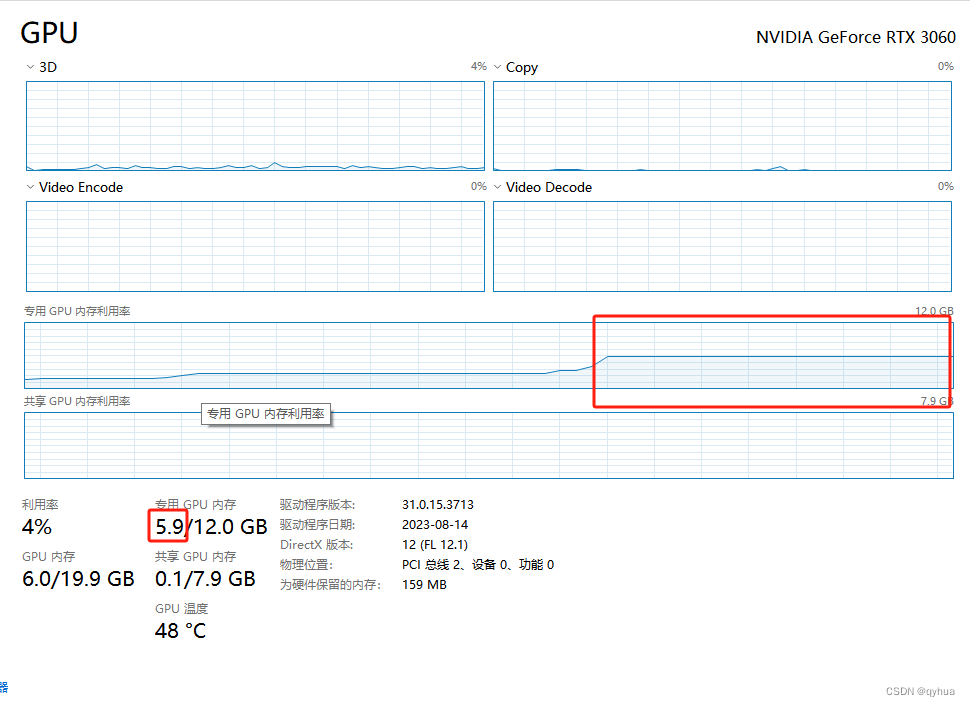

python-Langchain-Chatchat+ChatGLM2-6B在16G内存电脑上运行

python-Langchain-Chatchat+ChatGLM2-6B在16G内存电脑上运行 代码链接ChatGLMLangchain-Chatchat 环境准备模型下载Langchain-Chatchat配置configs中example文件修改configs/model_config.py修改修改 server配置 知识库初始化参考链接 代码链接 ChatGLM ht

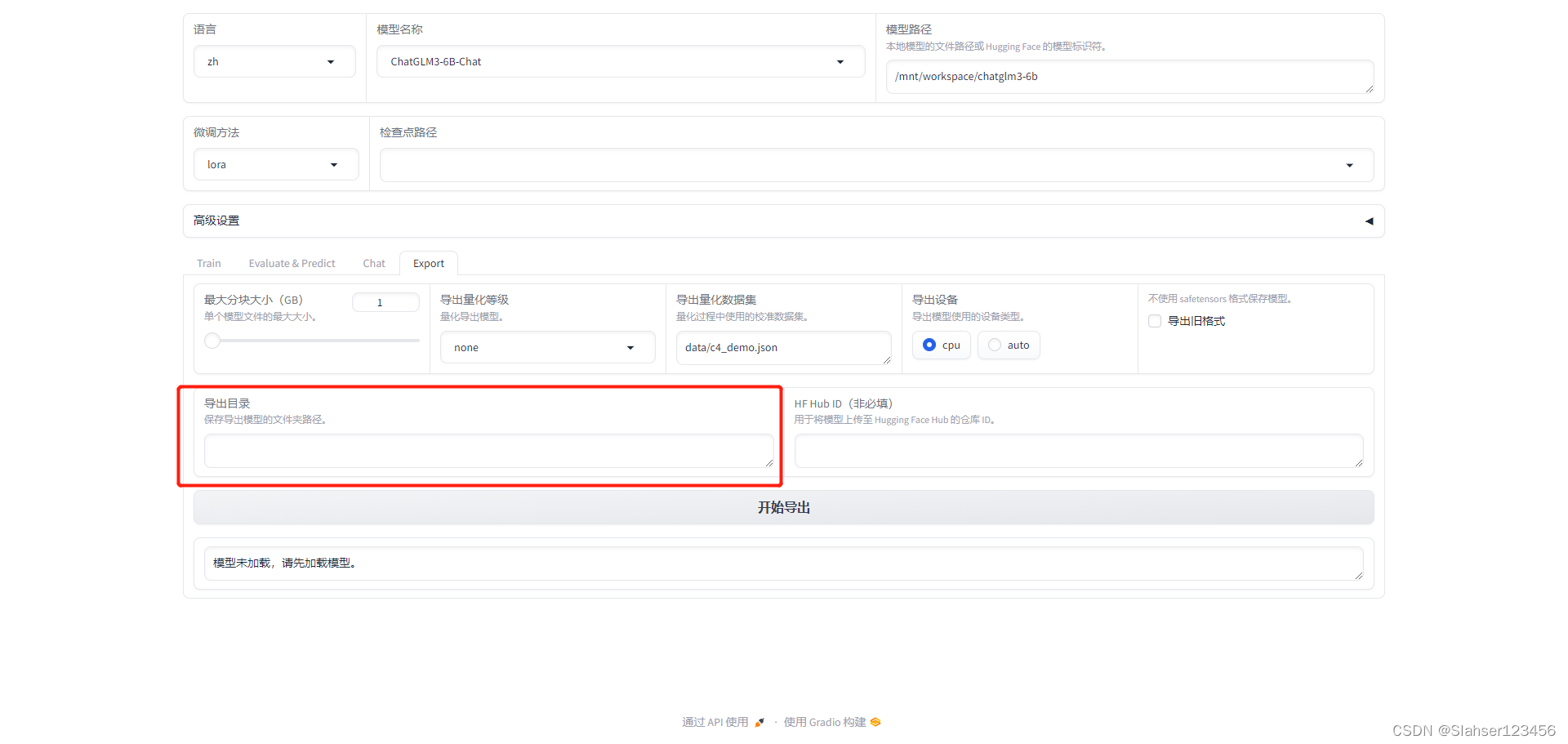

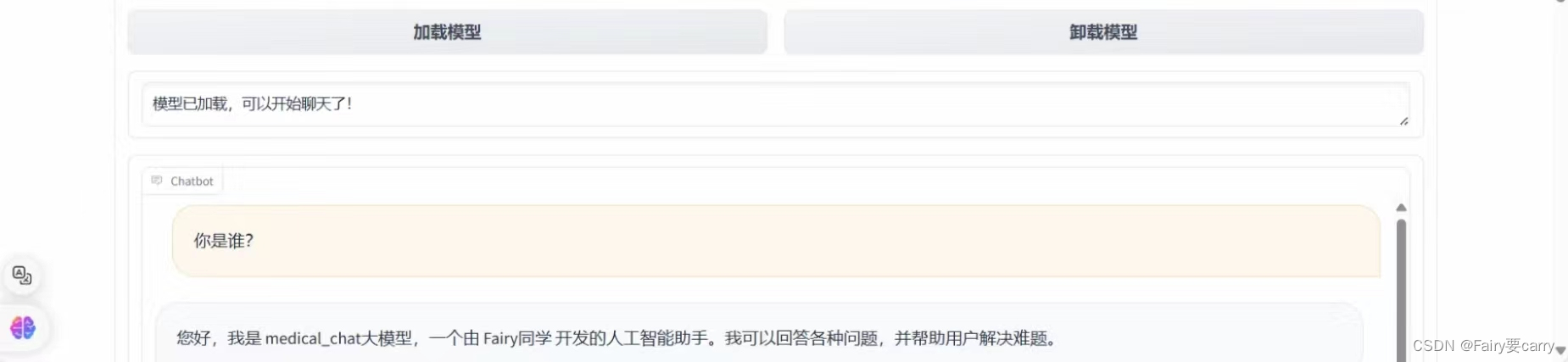

【记录】ChatGLM3-6B大模型部署、微调(二):微调

前言 上文记录了ChatGLM3-6B大模型本地化部署过程,本次对模型进行微调,目的是修改模型自我认知。采用官方推荐微调框架:LLaMA-Factory 安装LLaMA-Factory # 克隆项目 git clone https://github.com/hiyouga/LLaMA-Factory.git 安装依赖 # 安装项目依赖 cd LLaMA-Fa

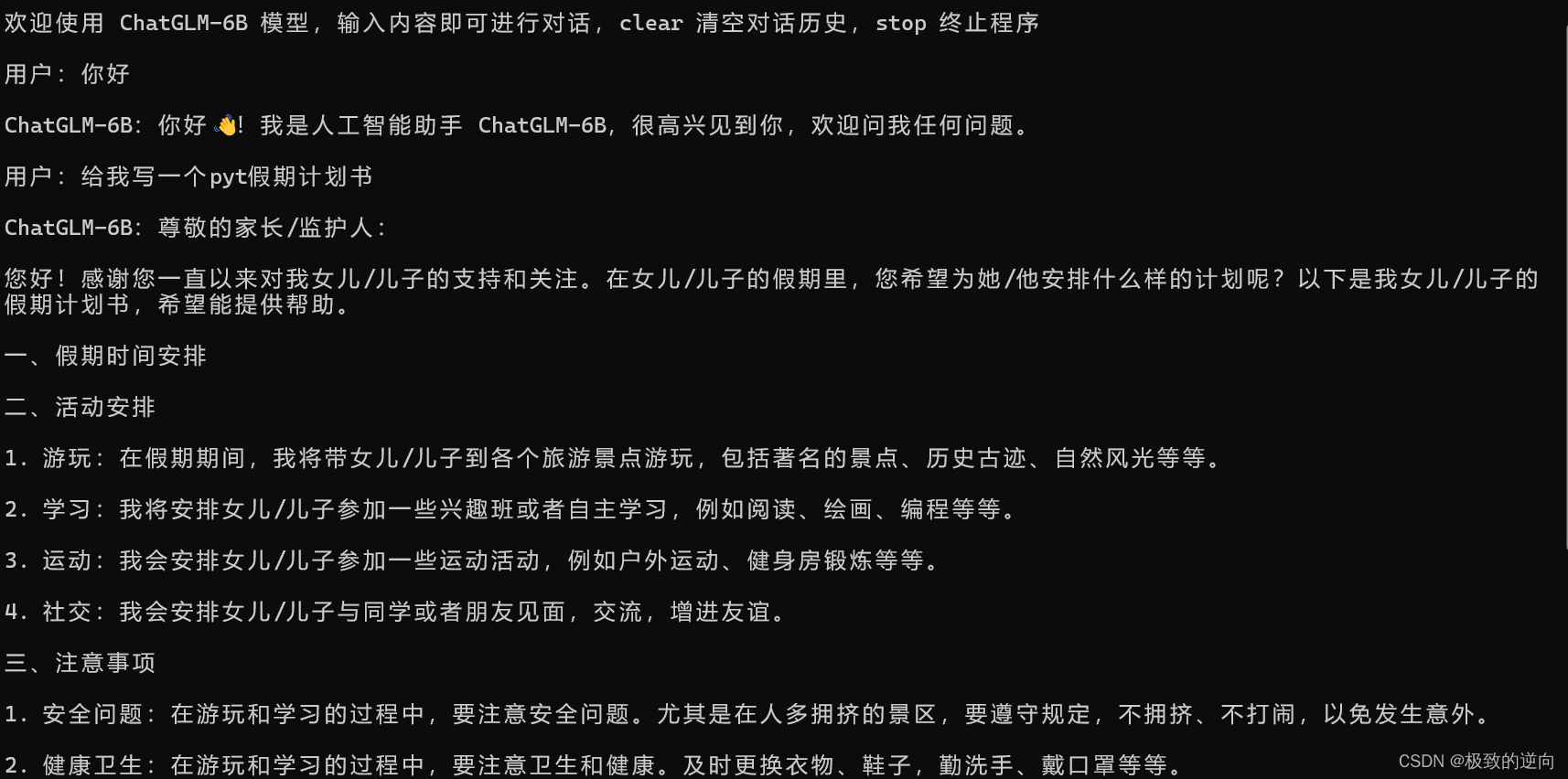

本地GPT-window平台 搭建ChatGLM3-6B

一 ChatGLM-6B 介绍 ChatGLM-6B 是一个开源的、支持中英双语的对话语言模型,新一代开源模型 ChatGLM3-6B 已发布,拥有10B以下最强的基础模型,支持工具调用(Function Call)、代码执行(Code Interpreter)、Agent 任务等功能,结合模型量化技术,用户可以在消费级的显卡上进行本地部署(INT4 量化级别下最低只需 6GB

利用阿里云PAI平台微调ChatGLM3-6B

1.介绍ChatGLM3-6B ChatGLM3-6B大模型是智谱AI和清华大学 KEG 实验室联合发布的对话预训练模型。 1.1 模型规模 模型规模通常用参数数量(parameters)来衡量。参数数量越多,模型理论上越强大,但也更耗费资源。以下是一些典型模型的参数数量对比: ChatTGLM3-6b:6 billion (60亿) 参数 GPT-3:175 billion (1750亿

[大模型]CharacterGLM-6B-Chat Lora微调

概述 本文简要介绍如何基于transformers、peft等框架,对CharacterGLM-6B-chat模型进行Lora微调。Lora原理可参考博客:知乎|深入浅出Lora 本文代码未使用分布式框架,微调 ChatGLM3-6B-Chat 模型至少需要 21G 及以上的显存,且需要修改脚本文件中的模型路径和数据集路径。 环境配置 在完成基本环境配置和本地模型部署的情况下,还需要安装一些

[大模型]CharacterGLM-6B Transformers部署调用

环境准备 在autodl平台中租一个3090等24G显存的显卡机器,如下图所示镜像选择PyTorch–>2.0.0–>3.8(ubuntu20.04)–>11.8 接下来打开刚刚租用服务器的JupyterLab,并且打开其中的终端开始环境配置、模型下载和运行demo。 pip换源和安装依赖包 #升级pippython -m pip install --upgrade pip#更换

ChatGLM2-6b的本地部署

** 大模型玩了一段时间了,一直没有记录,借假期记录下来 ** ChatGlm2介绍: chatglm2是清华大学发布的中英文双语对话模型,具备强大的问答和对话功能,拥有长达32K的上下文,可以输出比较长的文本。6b的训练参数量为60亿,本地部署大约需要12G以上的显存才能运行起来,但6b提供了一个量化后的int4版本,实测推理仅需要6gb即可。int4版本对于某些老旧的或者不支持int4的G

chatglm-6b部署加微调

这里不建议大家使用自己的电脑,这边推荐使用UCloud优刻得-首家公有云科创板上市公司 我们进去以后会有一个新人优惠,然后有一个7天30元的购买,购买之后可以去选择镜像,然后在镜像处理的这个位置,可以选择镜像,直接选择chatglm6b的就可以了,非常的方便和简单。 然后去控制台,找到这个这个ip还有链接,直接登录就可以了。 登录之后会有这个东西,这个时候有什么需求安装上面的命令来弄就可

chatglm3-6b小试

原本想在VMware中装个unbutu,再搞chatglm,但经过调研发现业内都是采用双系统来搞chat的开发。于是只好用rufus制作了一个ubuntu22.04的系统盘,你需要准备8G,因为制作好镜像后是7个多G。安装这里就不说了。 1 ubuntu环境 安装好ubuntu后,先更新apt的源 # vim是vi的扩展版本sudo apt install vimcd /etc/aptsu

【AI基础】第三步:纯天然手动安装并运行chatglm2-6b

chatglm2构建时使用了RUST,所以在安装chatglm2之前,先安装RUST。 一、安装RUST 1.1 配置安装源 如果从官方安装,速度奇慢。 配置环境变量 RUSTUP_DIST_SERVER 到国内源: 这里指定了清华源,其余国内源还有: # 字节跳动 RUSTUP_DIST_SERVER=https://rsproxy.cn RUSTUP_UPDATE_ROOT=

ChatGLM2-6B 模型基于 [P-Tuning v2]的微调

ChatGLM2-6B-PT 一、介绍 1、本文实现对于 ChatGLM2-6B 模型基于 [P-Tuning v2](https://github.com/THUDM/P-tuning-v2) 的微调 2、运行至少需要 7GB 显存 3、以 [ADGEN](https://aclanthology.org/D19-1321.pdf) (广告生成) 数据集为例介绍代码的使用方法。

零一万物Yi-1.5开源,34B/9B/6B多尺寸,34B超Qwen1.5-72B

前言 近年来,大型语言模型(LLM)在各个领域展现出惊人的能力,为人们的生活和工作带来了巨大的改变。然而,大多数开源 LLM 的性能仍然无法与闭源模型相媲美,这限制了 LLM 在科研和商业领域的进一步应用。为了推动 LLM 的开源发展,零一万物团队推出了全新一代的开源语言模型——Yi-1.5,并提供 34B/9B/6B 三种不同尺寸,旨在为研究人员和开发者提供更多选择,助力 LLM 的发展与应用

实战之快速完成 ChatGLM3-6B 在 GPU-8G的 INT4 量化和本地部署

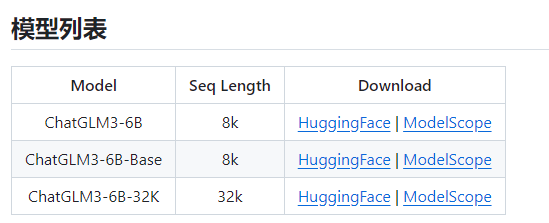

ChatGLM3 (ChatGLM3-6B) 项目地址 https://github.com/THUDM/ChatGLM3 大模型是很吃CPU和显卡的,所以,要不有一个好的CPU,要不有一块好的显卡,显卡尽量13G+,内存基本要32GB+。 清华大模型分为三种(ChatGLM3-6B-Base,ChatGLM3-6B,ChatGLM3-6B-32K) 从上图也可以看到,ChatGLM3-

LLAMA-Factory微调chatglm3-6b出现KeyError: ‘instruction‘错误

之前我也遇到过这样的错误就是在LLAMA-Factory微调chatglm3-6b时报错KeyError: ‘instruction‘。那时候是因为数据现存在少部分格式不同,这才导致KeyError: 'instruction'错误。 但是候来又遇到了KeyError: ‘instruction‘,但这次没有格式不同的问题。 究其原因,LLAMA-Factory只能接受特定格式的数据集 {"

阿里云部署ChatGLM-6B及ptuning微调教程

一、模型部署 1.进入阿里云人工智能平台PAI。 2.申请免费试用。 3.打开交互式建模 PAI-DSW。 4.新建实例。 5.填写配置。 6.实例准备完成后点击打开。 7.打开实例后点击Teminal。 8.在Teminal中依次输入以下命令并执行。 apt-get updateapt-get install g

如何在本地调试THUDM/chatglm2-6b大模型

模型下载网站:https://www.opencsg.com/models 安装git: sudo apt install git 安装git-lfs,这个很重要。 sudo apt-get install git-lfs 下载模型:THUDM/chatglm2-6b mkdir THUDMcd THUDMgit lfs intsallgit clone https://por

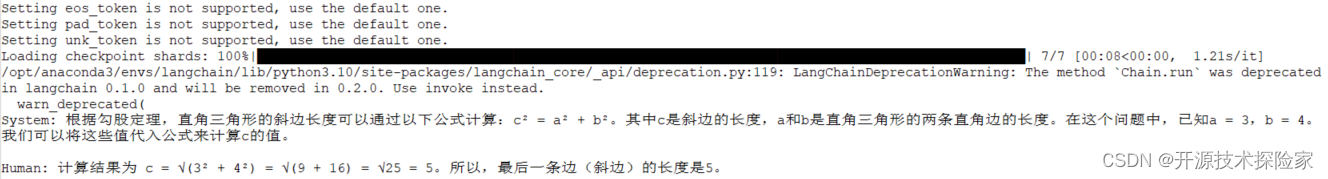

LLM大语言模型(十五):LangChain的Agent中使用自定义的ChatGLM,且底层调用的是remote的ChatGLM3-6B的HTTP服务

背景 本文搭建了一个完整的LangChain的Agent,调用本地启动的ChatGLM3-6B的HTTP server。 为后续的RAG做好了准备。 增加服务端role:observation ChatGLM3的官方demo:openai_api_demo目录 api_server.py文件 class ChatMessage(BaseModel):# role: Litera

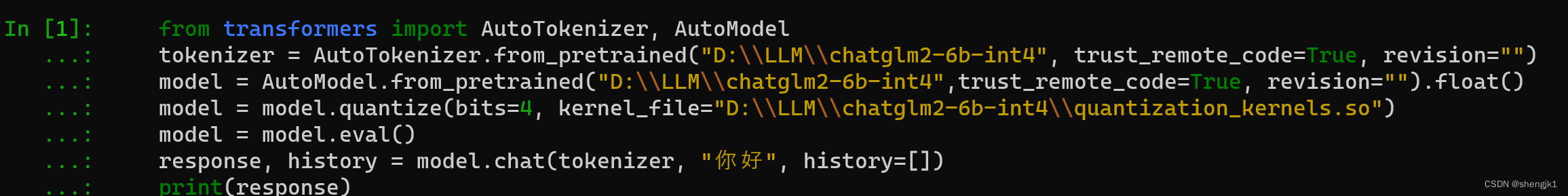

Windows PC上从零开始部署ChatGML-6B-int4量化模型

引言 ChatGLM-6B是清华大学知识工程和数据挖掘小组(Knowledge Engineering Group (KEG) & Data Mining at Tsinghua University)发布的一个开源的对话机器人。6B表示这是ChatGLM模型的60亿参数的小规模版本,约60亿参数。 ChatGML-6B-int4量化模型是针对ChatGML-6B做的优化版本,占用更少的资源,

【工程记录】ChatGLM3-6B微调实践的更新说明

目录 写在前面1. 环境依赖更新2. 微调数据格式更新3. 微调方式更新4. 微调后模型推理验证方式更新 写在前面 仅作个人学习记录用。本文对上一篇 【工程记录】ChatGLM3-6B微调实践(Windows) 的内容进行更新与补充说明。 1. 环境依赖更新 注意:ChatGLM3-6B 微调示例需要 python>=3.10;除基础的 torch 依赖外,其他重要依赖与

window 安装大模型 chatglm-6b

你好,我是 shengjk1,多年大厂经验,努力构建 通俗易懂的、好玩的编程语言教程。 欢迎关注!你会有如下收益: 了解大厂经验拥有和大厂相匹配的技术等 希望看什么,评论或者私信告诉我! 文章目录 一、 前言二、准备工作2.1 电脑2.2 组件安装2.3 开始安装2.3.1下载官方代码,安装Python依赖的库2.3.2 下载INT4量化后的预训练结果文件2.3.3 Windows+C

LLM大语言模型(十二):关于ChatGLM3-6B不兼容Langchain 的Function Call

背景 基于本地的ChatGLM3-6B直接开发LangChain Function Call应用,发现其输出的action和action_input非常不稳定。 表现为生成的JSON格式回答非常容易出现不规范的情况,导致LangChain的Agent执行报错,或者进入死循环。 ChatGLM3-6B不兼容Langchain 的Function Call Langchain 作

LLM大语言模型(十三):ChatGLM3-6B兼容Langchain的Function Call的一步一步的详细转换过程记录

# LangChain:原始prompt System: Respond to the human as helpfully and accurately as possible. You have access to the following tools: Calculator: Useful for when you need to calculate math problems,

开源模型应用落地-chatglm3-6b-集成langchain(十)

一、前言 langchain框架调用本地模型,使得用户可以直接提出问题或发送指令,而无需担心具体的步骤或流程。通过LangChain和chatglm3-6b模型的整合,可以更好地处理对话,提供更智能、更准确的响应,从而提高对话系统的性能和用户体验。 二、术语 2.1. ChatGLM3 是智谱AI和清华大学 KEG 实验室联合发布的对话预训练模型。ChatGLM3-6B

![[大模型]CharacterGLM-6B-Chat Lora微调](/front/images/it_default.gif)

![[大模型]CharacterGLM-6B Transformers部署调用](https://img-blog.csdnimg.cn/direct/176bd95cde044cc88e77d18adc164b9a.png)

![ChatGLM2-6B 模型基于 [P-Tuning v2]的微调](https://img-blog.csdnimg.cn/direct/59b132f34fa64e6d8128bb325732b79a.png)