降维专题

保研 比赛 利器: 用AI比赛助手降维打击数学建模

数学建模作为一个热门但又具有挑战性的赛道,在保研、学分加分、简历增色等方面具有独特优势。近年来,随着AI技术的发展,特别是像GPT-4模型的应用,数学建模的比赛变得不再那么“艰深”。通过利用AI比赛助手,不仅可以大大提升团队效率,还能有效提高比赛获奖几率。本文将详细介绍如何通过AI比赛助手完成数学建模比赛,并结合实例展示其强大功能。 一、AI比赛助手的引入 1. 什么是AI比赛助手? AI比

《机器学习》PCA数据降维 推导、参数讲解、代码演示及分析

目录 一、主成分分析 1、什么是主成分分析? 2、什么是降维? 3、如何进行主成分分析 1)数据标准化 2)计算协方差矩阵 3)计算特征值和特征向量 4)选择主成分 5)构建投影矩阵 6)数据降维 4、为什么要进行主成分分析 1)数据可视化 2)

《机器学习》—— PCA降维

文章目录 一、PCA降维简单介绍二、python中实现PCA降维函数的介绍三、代码实现四、PCA降维的优缺点 一、PCA降维简单介绍 PCA(主成分分析,Principal Component Analysis)是一种常用的数据降维技术。它通过线性变换将原始数据转换到新的坐标系统中,使得任何投影的第一大方差在第一个坐标(称为第一主成分)上,第二大方差在第二个坐标(第二主成分)上,

PCA降维奇异值分解SVD

PCA降维 涉及高维数据的问题容易陷入维数灾难,随着数据集维数的增加,算法学习所需的样本数量呈指数级增加,且需要更多的内存和处理能力,消耗资源。主成分分析也称为K-L变换,常用于高位数据预处理和可视化。PCA可以把可能具有相关性的高维变量合成线性无关的低维变量,称为主成分。原理就是PCA将高维具有相关性的数据进行线性变换映射到一个低维子空间,尽可能多的保留更多变量(代表原特征),降维成一个线性无

数据降维技术——PCA(主成分分析)

为什么要对数据进行降维? 在机器学习或者数据挖掘中,我们往往会get到大量的数据源,这些数据源往往有很多维度来表示它的属性,但是我们在实际处理中只需要其中的几个主要的属性,而其他的属性或被当成噪声处理掉。比如,13*11的源数据经过将为后变成了13*4的优化数据,那么,中间就减去了7个不必要的属性,选取了4个主要属性成分,简化了计算。 常用的数据降维方法有:主成分分析

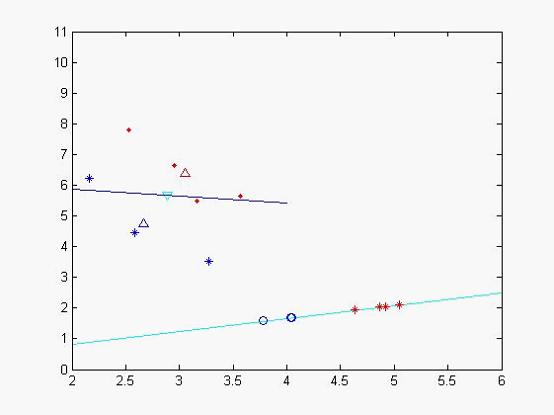

各种数据降维方法ICA、 ISOMAP、 LDA、LE、 LLE、MDS、 PCA、 KPCA、SPCA、SVD、 JADE

独立分量分析 ICA 等度量映射 ISOMAP 线性判别分析 LDA (拉普拉斯)数据降维方法 LE 局部线性嵌入 LLE 多维尺度变换MDS 主成分分析 PCA 核主成分分析 KPCA 稀疏主成分分析SPCA 奇异值分解SVD 特征矩阵的联合近似对角化 JADE 各种数据降维方法(matlab代码)代码获取戳此处代码获取戳此处 降维目的:克服维数灾难,获取本质特征,节省存储空

numpy 中的降维与升维

升维(Dimensionality Augmentation):增加数据的维度,通常用于提供更多信息或从不同的角度看待数据。 降维(Dimensionality Reduction):减少数据的维度,通常用于简化数据或去除无关紧要的特征。 降维 最近在飞桨学习机器学习的时候发现一个概念让人摸不清头脑,计算梯度的时候使用了 np.mean 来进行降维。 z = net.forward(x)

Tensorflow中的降维函数总结:tf.reduce_*

在使用tensorflow时常常会使用到tf.reduce_*这类的函数,在此对一些常见的函数进行汇总 1.tf.reduce_sum tf.reduce_sum(input_tensor , axis = None , keep_dims = False , name = None , reduction_indices = None) 参数: input_tensor:要减少的张量。应

python实现线性判别分析 (LDA) 降维算法

目录 1.线性判别分析 (LDA) 降维算法的Python实现2.LDA算法的基本思想2.1类间方差矩阵 S B S_B SB2.2类内方差矩阵 S W S_W SW2.3优化目标 3.LDA的Python实现4.代码解析5.实际应用场景:手写数字识别5.1数据准备5.2使用LDA降维5.3分类效果 6.总结 1.线性判别分析 (LDA) 降维算法的Python实现

Kylin源码解析——Cube构建过程中如何实现降维

-维度简述 Kylin中Cube的描述类CubeDesc有两个字段,rowkey和aggregationGroups。 @JsonProperty("rowkey")private RowKeyDesc rowkey;@JsonProperty("aggregation_groups")private List<AggregationGroup> aggregationGroups; 其

机器学习 | 基于wine数据集的KMeans聚类和PCA降维案例

KMeans聚类:K均值聚类是一种无监督的学习算法,它试图根据数据的相似性对数据进行聚类。无监督学习意味着不需要预测结果,算法只是试图在数据中找到模式。在k均值聚类中,我们指定希望将数据分组到的聚类数。该算法将每个观察随机分配到一个集合,并找到每个集合的质心。然后,该算法通过两个步骤进行迭代:将数据点重新分配到质心最近的聚类。计算每个簇的新质心。重复这两个步骤,直到集群内的变化不能进一步减少。聚类

如何确定PCA降维的维度

主要是对西瓜书里面的一个思路的实现,并不涉及PCA原理和公式推导,用一句话总结PCA,在 R d R^{d} Rd中的m个点经过矩阵变换(压缩)映射到 R d ′ R^{d'} Rd′空间中,并且保证 d ′ < d d'<d d′<d,其中 d ′ d' d′是新维度。 用矩阵表示: Z d ′ ∗ m = W d ′ ∗ d T ∗ X d ∗ m Z_{d'*m}=W^{T}_{d'*d}

【机器学习】特征提取 特征降维

特征工程 特征工程是将原始数据转化为可以用于机器学习的数字特征,比如字典的特征提取,文档的特征提取等。 字典特征提取 把字典的每个唯一的键作为数据集特征的一个维度,有这个维度的就为1,没有就是0。其他相同的键,该维度的值就是其键值。 这样的操作把字典样本的每一条数据转化为了矩阵,但是矩阵中含有大量的0(因为数据中的键和值有很多不同),所以称之为稀疏矩阵 为了保存数据的高效,一般使用三元组

Python——常用数据降维算法应用

随着数据的积累,数据的维度越来越高,高维的数据在带来更多信息的同时,也带来了信息冗余、计算困难等问题,所以对数据进行合理的降维,并保留主要信息非常重要。这些问题主要可以通过主成分分析及相关的降维算法来解决。 一些经典的降维算法有:主成分分析、MSD降维、t-SNE降维等。 1: 数据准备 将会使用手写体数字数据,该数据一共有1797个样本,每个图像包含64个像素值,数据导入后的情

文本挖掘之降维技术之特征提取之因子分析(FA)

因子分析法(FA) 因子分析法是通过将原有变量内部的相互依赖关系进行数据化,把大量复杂关系归为少量的几个综合因子的统计方法。它的基本思想是通过分析各变量之间的方差贡献效果,将大的即相关性高的联系比较紧密的分在同一个类别中,而不同类的则相关性是比较低的,这其中一个类别描述了一种独立结构,这个结构在因子分析法中叫做公共因子。这个方法的研究目的就是尝试使用少数几个不可测的通过协方差矩阵计算得来

文本挖掘之降维技术之特征抽取之非负矩阵分解(NMF)

通常的矩阵分解会把一个大的矩阵分解为多个小的矩阵,但是这些矩阵的元素有正有负。而在现实世界中,比如图像,文本等形成的矩阵中负数的存在是没有意义的,所以如果能把一个矩阵分解成全是非负元素是很有意义的。在NMF中要求原始的矩阵的所有元素的均是非负的,那么矩阵可以分解为两个更小的非负矩阵的乘积,这个矩阵 有且仅有一个这样的分解,即满足存在性和唯一性。 Contents

文本分类之降维技术之特征抽取之SVD矩阵的分解的原理的介绍

http://www.cnblogs.com/LeftNotEasy/archive/2011/01/19/svd-and-applications.html 一、奇异值与特征值基础知识: 特征值分解和奇异值分解在机器学习领域都是属于满地可见的方法。两者有着很紧密的关系,我在接下来会谈到,特征值分解和奇异值分解的目的都是一样,就是提取出一个矩阵最重要的特征。先谈谈特征值分解吧:

文本挖掘之降维之特征抽取之主成分分析(PCA)

PCA(主成分分析) 作用: 1、减少变量的的个数 2、降低变量之间的相关性,从而降低多重共线性。 3、新合成的变量更好的解释多个变量组合之后的意义 PCA的原理: 样本X和样本Y的协方差(Covariance): 协方差为正时说明X和Y是正相关关系,协方差为负时X和Y是负相关关系,协方差为0时X和Y相互独立。 Cov(X,X)就是X的方差(Variance).

文本分类之降维技术之特征抽取之LDA线性判别分析

背景:为什么需要特征抽取? 基于的向量空间模型有个缺点,即向量空间中的每个关键词唯一地代表一个概念或语义单词,也就是说它不能处理同义词和多义词,然而实际情况是:一个词往往有多个不同的含义,多个不同的词可以代表一个概念。在这种情况下,基于的向量空间模型不能很好的解决这种问题。 特征抽取方法则可以看作从测量空间到特征空间的一种映射或变换,一般是通过构造一个特征评分函数,把测量空间的

大规模数据的PCA降维

20200810 - 0. 引言 最近在做的文本可视化的内容,文本处理的方法是利用sklearn的CountVer+Tf-idf,这样处理数据之后,一方面数据的维度比较高,另一方面呢,本身这部分数据量也比较大。如果直接使用sklearn的pca进行降维,会很慢,而且pca也没有n_jobs来支持多线程工作。不过,我看到spark中已经支持的pca了,所以希望通过spark来实现这部分内容。

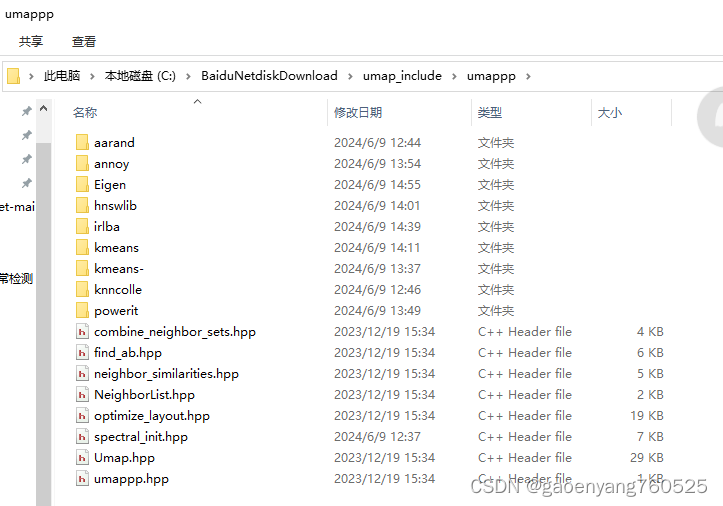

umap降维,c++用法纪实

全是血泪,可惜对于大量数据,速度还是太慢。 一、代码 // ConsoleApplication2.cpp : 此文件包含 "main" 函数。程序执行将在此处开始并结束。//#include <iostream>#include "knncolle/knncolle.hpp"#include "Umap.hpp"#include <iostream>#include <vector>i